极市干货

极市干货

ICCV 2025 南开等提出REG方法,直接、高效地利用判别性信息,几十倍加速扩散模型训练!

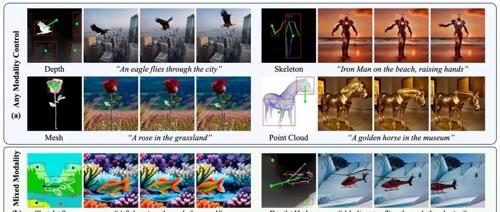

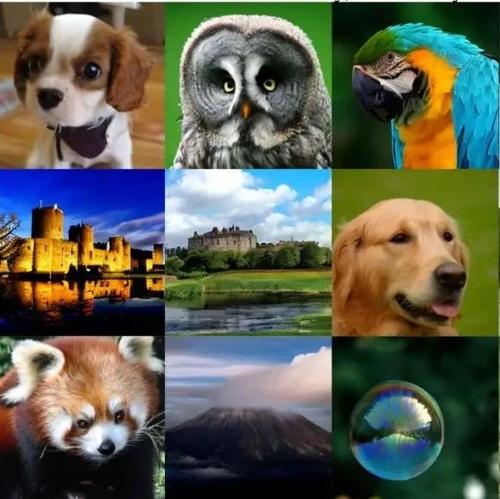

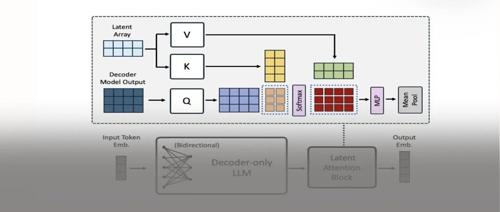

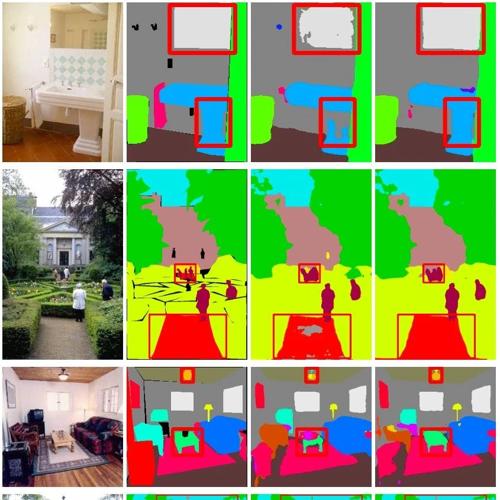

本文提出了一种名为REG的方法,通过将低级图像潜在表示与高级类别令牌进行‘纠缠’来加速扩散模型的训练,并在ImageNet上实现了高达63倍的训练加速。

百万奖金+产业扶持、真实赛题、真实应用场景,最后一周火热征集中

2025长三角(芜湖)算力算法创新应用大赛即将截止报名,初赛7月18日结束。参赛机会难得,奖金丰厚,并有机会获得政策扶持和资源对接。大赛涵盖自然语言处理、语音识别、工业视觉检测等多个领域题目。

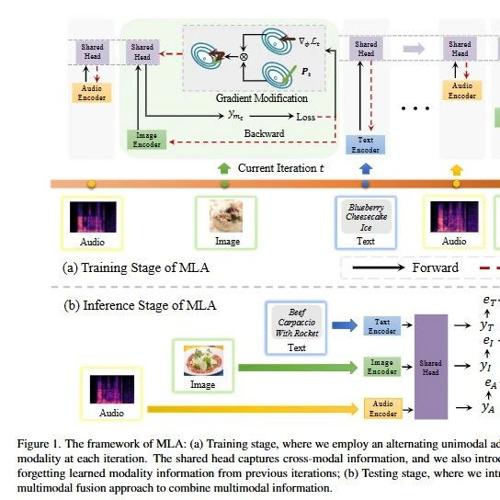

训练扩散模型其实比你想象的更简单!何恺明团队新作Dispersive Loss:给扩散模型加正则化

型参数、无需额外数据,即插即用的正则化技术超简单实现性能提升。

>>加入极市CV技术交流群,走在计算