ICML

一篇被证明“理论有误”的论文,拿下了ICML2025时间检验奖

2015年发表的Batch Normalization论文在ICML 2025会议上荣获时间检验奖。这篇开创性工作极大地推动了深层神经网络的训练和应用,是深度学习发展史上的里程碑。

ICML 2025,相约加拿大温哥华!免费请你吃饭

ICML 期间,机器之心联合多家机构举办 ‘云帆・ICML 2025 AI Talent Meetup’,邀请企业与人才交流互动,涵盖特邀报告、人才展示等多个环节。

ICML 2025 细粒度奖励建模:判别式策略优化下的Q-RM方法

近日,中山大学计算机学院与腾讯微信搜索团队联合提出 Q-RM(Q-function Reward Model),在 ICML 2025 正式发表。这一方法专注于构建更精确的 token-level 奖励信号,显著提升了大语言模型的训练效率和效果。

ICML 2025 全局池化+局部保留,CCA-Attention为LLM长文本建模带来突破性进展

的高效上下文建模。在 128K 超长序列上下文建模任务中,CCA-Attention 的推理速度是标

ICML 2025 北大团队提出GAPrompt:仅用2%参数,点云模型精度媲美全量微调

北京大学等机构提出GAPrompt,一种面向三维视觉预训练模型的几何感知高效微调方法,通过引入点云结构化提示提升下游任务中的几何适应能力。该研究已被人工智能顶会ICML 2025接收,并已开源相关代码与模型。

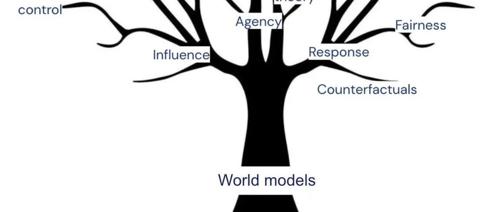

DeepMind 最新研究:智能体就是世界模型!

AI 智能体的本质被揭开了:它们就是世界模型。DeepMind 研究团队在ICML 2025上发布论文,证明任何能够泛化到广泛目标导向任务的智能体必然已经学到了能够模拟其环境的预测模型。

ICML 2025 Spotlight 谁导致了多智能体系统的失败?首个「自动化失败归因」研究出炉

本文介绍了一篇ICML 2025 Spotlight论文,提出自动化失败归因新任务以快速定位多智能体语言模型(LLM)系统的错误。研究构建首个Who&When数据集,并比较了三种方法:All-at-Once、Step-by-Step和Binary Search。实验结果显示当前方法效果有限,准确率较低;但混合策略有一定提升,且现有SOTA模型表现仍不理想。这表明失败归因任务对AI推理与理解能力要求极高。

刚刚,ICML 2025录用结果公布!好评论文惨遭拒,审稿人敷衍引全网怒喷

ICML 2025共录用3260篇论文,录用率为26.9%。评审质量引发热议,审稿人敷衍问题频出。多个案例显示评审存在错误和疏忽,影响了公正性和准确性。