量子位

量子位

谷歌“世界模拟器”深夜上线!一句话生成3D世界,支持分钟级超长记忆

谷歌DeepMind发布新一代通用世界模型Genie 3,支持720P画质、每秒24帧实时导航和分钟级一致性保持。Tejas Kulkarni体验后评价其通用性强且能学习物理特性。Genie 3现已以研究预览形式发布,并展示在雅典风格建筑中漫步的场景画面中物体能够保持一致。

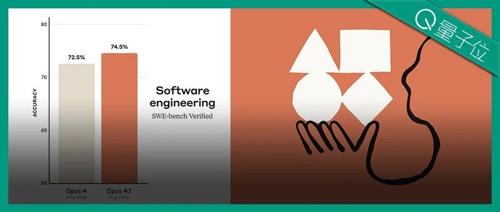

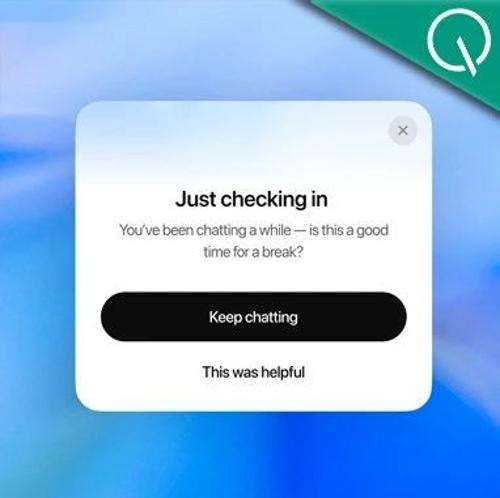

Claude Opus 4.1火速发布!坐稳编程之王,官方:马上还有大更新

Anthropic发布Claude Opus 4.1,编程性能提升74.5%,在SWE-bench上超越Gemini 2.5 Pro和o3。客户反馈表示Opus 4.1能精准定位修复代码bug,模型无害回复回应率达到99.06%。

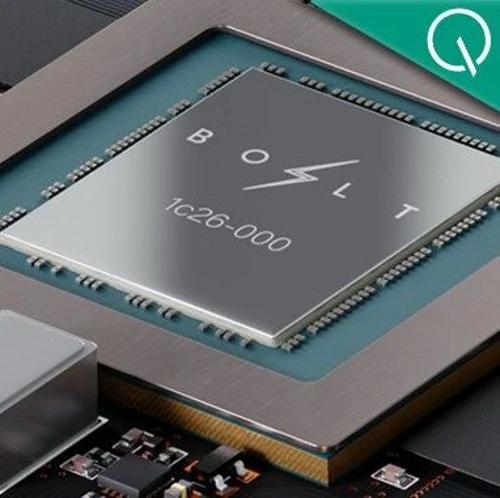

叫板英伟达RTX 5090!GPU初创公司做出13倍路径追踪性能的怪兽显卡

Bolt Graphics发布的新款GPU Zeus 4C在路径追踪场景中性能远超RTX 5090,但其主要适用于高精度图形渲染,如电影特效和高性能计算,并不适合游戏。