AI 智能体的本质被揭开了:它们就是世界模型!

DeepMind 研究科学家 Jon Richens(@jonathanrichens)和团队刚刚在ICML 2025上发表了一篇重磅论文,从第一性原理出发,证明了一个让人意外的结论:

智能体就是世界模型。

这项研究回答了一个困扰AI界多年的根本问题:

要实现人类水平的智能体,世界模型是必需的吗?还是说存在某种不需要模型的捷径?

世界模型:绕不开的必经之路

世界模型对人类的目标导向行为至关重要,但在AI领域,这个问题一直存在争议。一方面,显式的基于模型的智能体在许多任务中表现出色(Gato、PaLM-E、Pi-0等)。另一方面,无模型的方法似乎也能实现跨任务泛化。

那么,这些无模型智能体是否学到了隐式的世界模型?还是它们找到了另一条通往通用智能的道路?

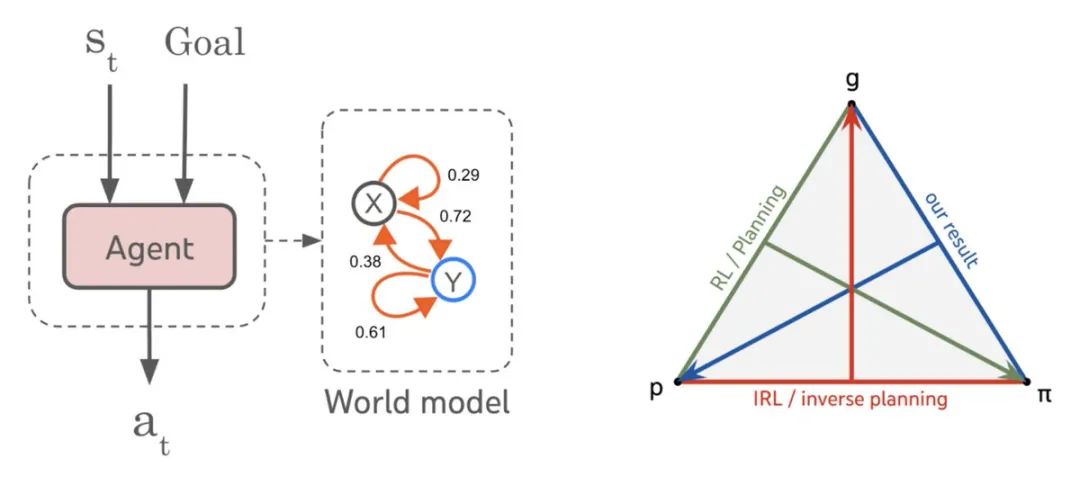

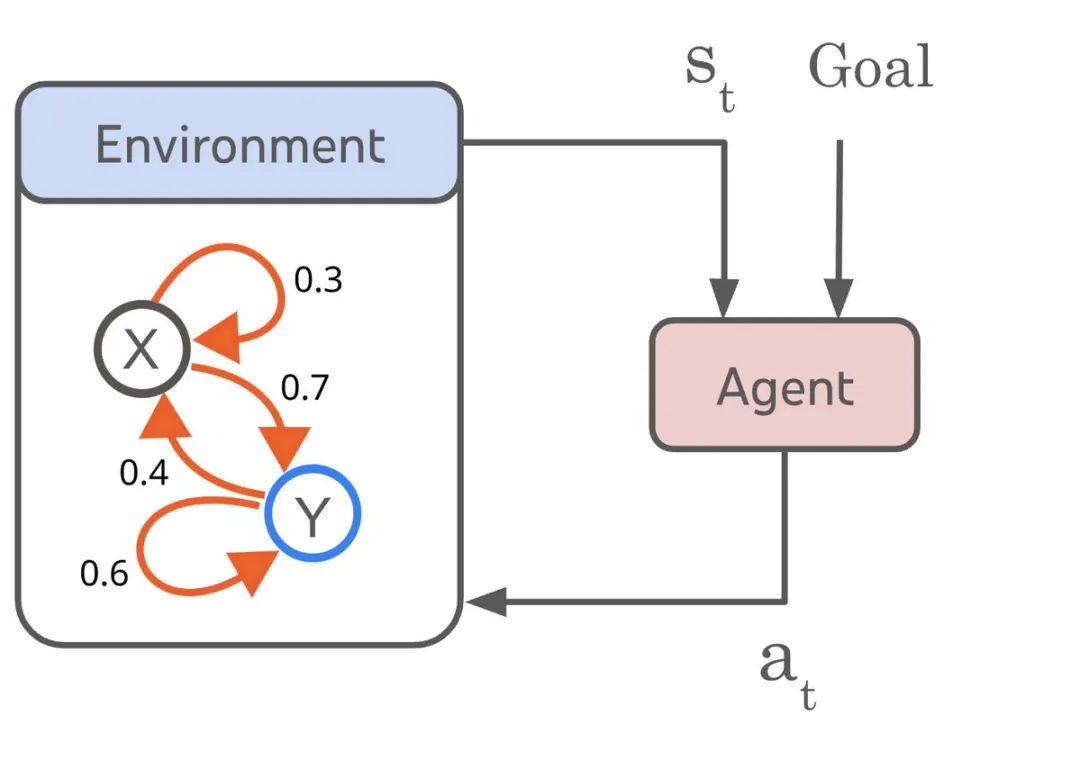

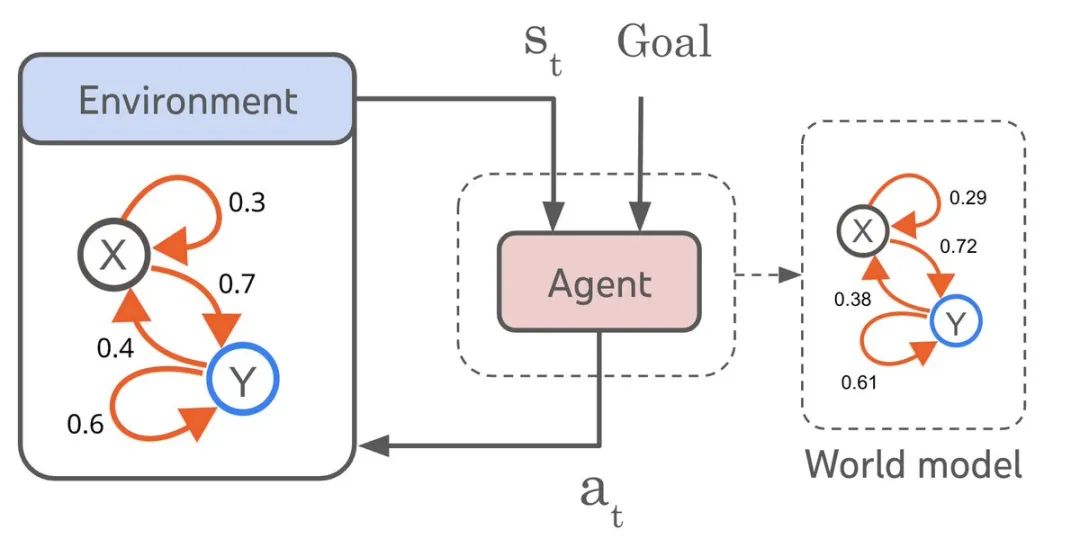

Jon Richens团队的答案非常明确:任何能够泛化到广泛的简单目标导向任务的智能体,必然已经学到了能够模拟其环境的预测模型。而且这个模型总是可以从智能体中恢复出来。

具体来说,他们证明了可以从任何满足一定性能要求的目标条件策略中恢复出环境转移函数的有界误差近似。这个性能要求是:智能体在足够广泛的简单目标集合上满足一个遗憾界限(regret bound),比如将环境引导到期望状态。

更重要的是,要实现更低的遗憾值或更复杂的目标,智能体必须学习越来越准确的世界模型。

目标条件策略在信息上等价于世界模型!

但这只适用于多步时间范围的目标,短视的智能体不需要学习世界模型。

深远影响:从涌现能力到AI安全

这些结果带来了几个有趣的推论:

无模型路径不存在。

如果你想训练一个能够执行广泛目标导向任务的智能体,就无法避免学习世界模型的挑战。要提高性能或通用性,智能体需要学习越来越准确和详细的世界模型。

智能体能力的根本限制。

在动力学难以学习或长期预测不可行的环境中,智能体的能力受到根本限制。

从智能体中提取世界知识。

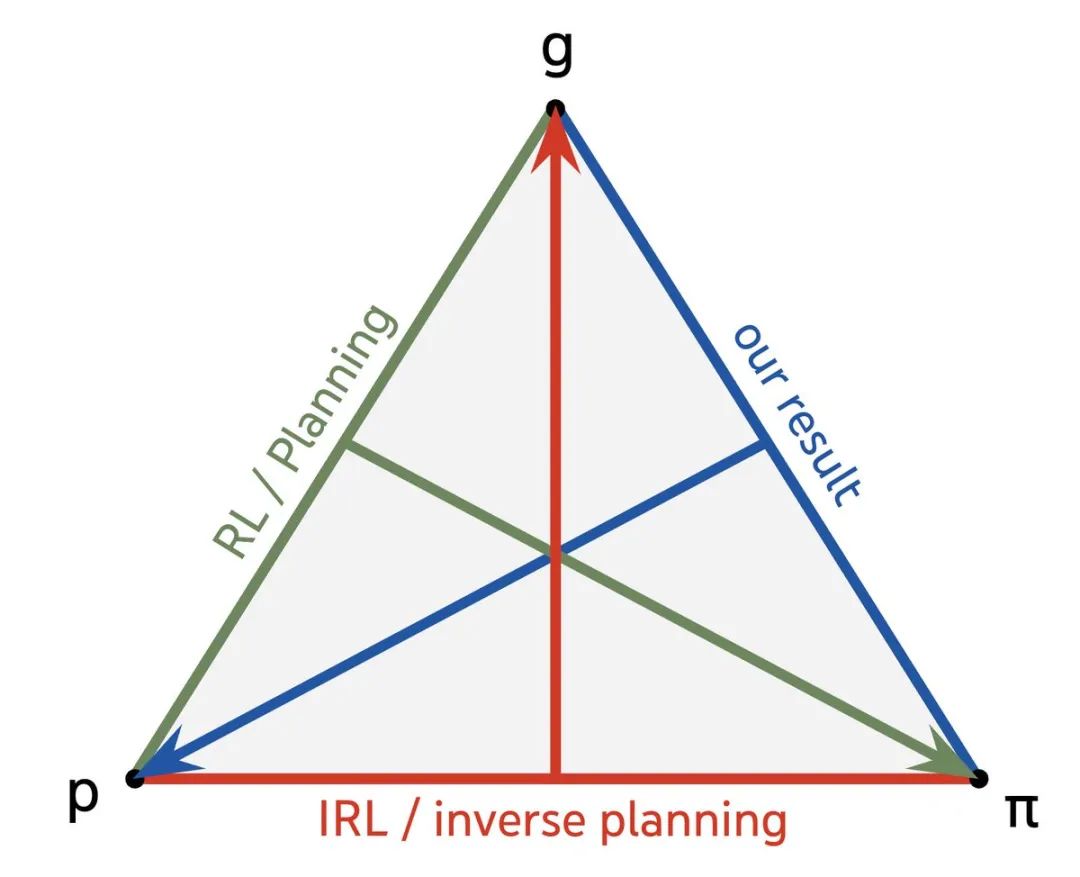

研究团队推导出了从智能体的策略和目标恢复世界模型的算法(策略+目标→世界模型)。这些算法完成了规划(世界模型+目标→策略)和逆强化学习(世界模型+策略→目标)的三元组。

安全性保证。

几种AI安全方法需要准确的世界模型,但智能体能力可能超过我们构建模型的能力。这项工作给出了理论保证:我们可以从智能体中提取世界模型,且模型保真度随智能体能力的提升而增加。

涌现能力的解释。

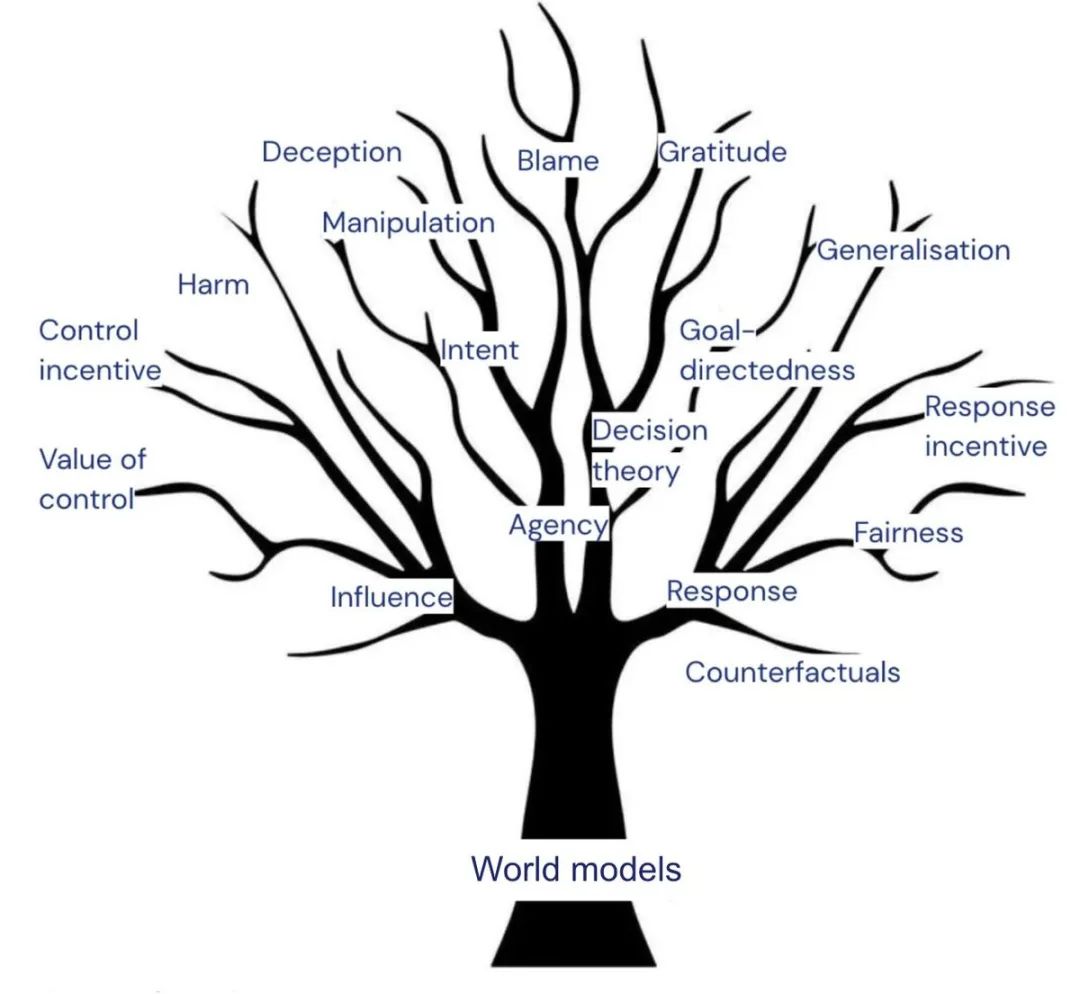

为了在许多目标上最小化训练损失,智能体必须学习世界模型,这个模型可以解决智能体未明确训练过的任务。简单的目标导向性催生了许多能力(社会认知、不确定性推理、意图理解等)。

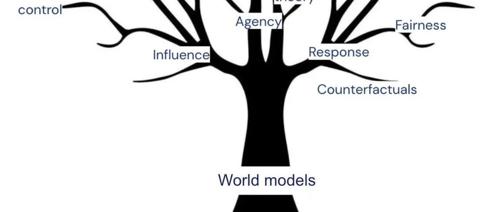

因果层级的新视角

这项研究还揭示了一个有趣的因果层级结构。

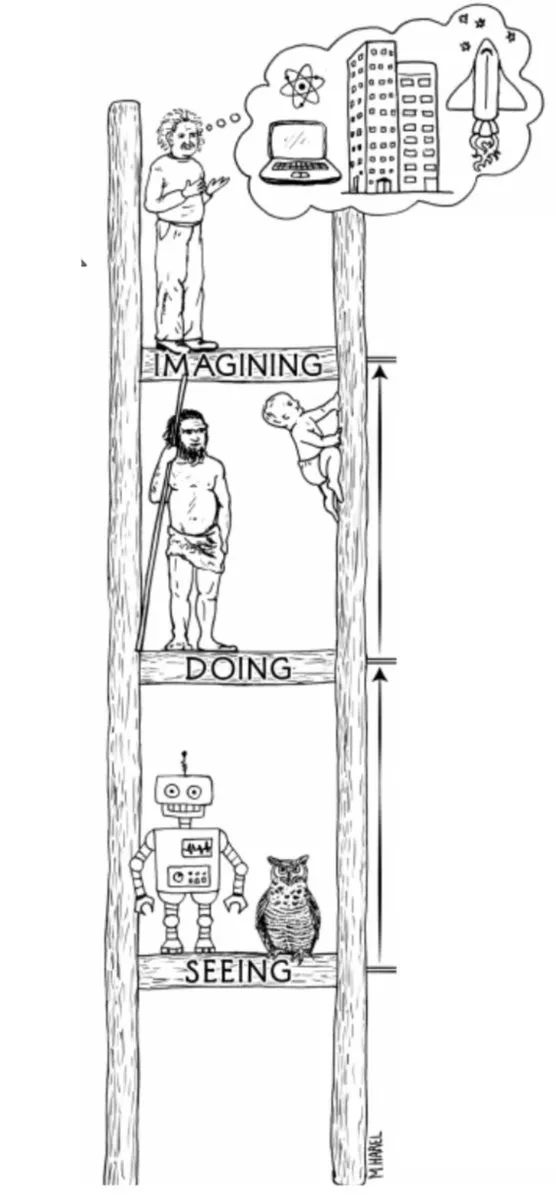

在之前的工作中,团队展示了因果世界模型对于鲁棒性是必需的。但对于任务泛化,你不需要那么多环境的因果知识。这是一个关于智能体和智能体能力的因果层级,而不是推理的因果层级!

社区反响

这项研究引发了AI 社区的热烈讨论。

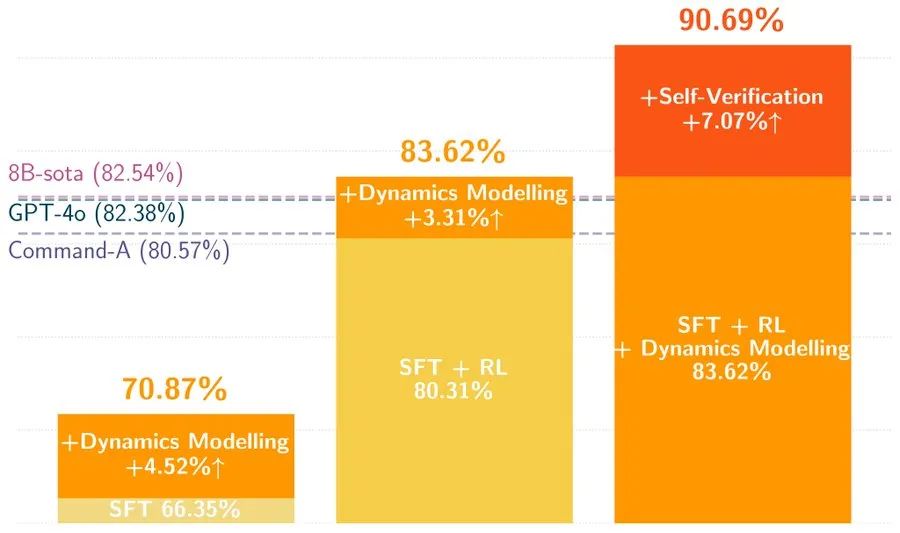

Shangmin Guo(@ShangminGuo)表示完全同意这个观点,并分享了他们团队的相关工作,将策略和世界模型统一到单个LLM中,让策略可以基于其内部世界模型进行规划:

我们将策略🤖和世界模型🌍统一到单个LLM中,因此不需要外部动力学模型!

Curt Welch(@CurtWelch)指出了世界模型对AGI的实际意义在于降维,使高维实时环境中的人类水平强化学习成为可能:

AGI(和我们的大脑)需要一个通用的感知预处理器,将原始实时感知数据流的复杂性降低到内部数据流的降低复杂性集合。这是在高复杂性下使强化学习成为可能所必需的。

Hiveism(@zustimmungswahl)则从预测编码的角度支持这个观点:

是的,这就是正确理解预测编码时所暗示的。

Tsukuyomi(@doomgpt)用略带讽刺的语气评论:

所以,智能体只是美化了的世界模型?听起来像个舒适的小陷阱。继续拉这些线,Jon。谁知道解开后会通向何方?

Rory Botbuilder(@RBotbuilder)简洁地指出:

有趣的问题;模型容量可能决定了效率和适应性。

Sam Woods(@samuelwoods_)给予了高度评价:

这是该领域最基础的研究之一。

CBir(@c__bir)提出了一个有趣的实现思路:

我认为图——网络图——是世界模型的绝佳抽象,节点可以是概念。到目前为止,没有我们无法用图描述的结构。值得一试🤔😉 @demishassabis

Curt Welch(@CurtWelch)进一步展开了他的观点,解释了降维预处理器的副作用:

这种复杂性降维预处理的副作用就是它成为了世界模型。它「理解」复杂的原始感知数据「意味着」猫。它「理解」这些特征之间的时间因果关系,这是其工作方式的副作用。

他还强调了一个关键点:

这里的重点不是给你的AGI添加世界模型。重点是使高维实时环境中的强化学习驱动的AGI成为可能。由此产生的环境简化恰好也是每个人都在寻找的世界模型。

这项研究为理解和开发通用AI 系统提供了重要的理论基础。

它不仅回答了世界模型是否必要的问题,还郑重指出——

要实现真正的通用智能,我们必须正面解决学习准确世界模型的挑战。

论文地址:https://arxiv.org/pdf/2506.01622

(文:AGI Hunt)