近日北京大学联合浙江大学、华中科技大学发布了一项最新研究成果:GAPrompt(Geometry-Aware Point Cloud Prompt),即一种面向三维视觉预训练模型的几何感知高效微调方法,通过引入点云结构化提示,有效提升了预训练模型在下游任务中的几何适应能力。

本文的第一作者为北京大学博士生艾子翔,本文的通讯作者为北京大学王选计算机研究所研究员、助理教授周嘉欢。

目前该研究已被人工智能顶会 ICML 2025 正式接收,相关代码与模型已全部开源。

论文标题:

GAPrompt: Geometry-Aware Point Cloud Prompt for 3D Vision Model

论文链接:

https://www.arxiv.org/pdf/2505.04119

代码链接:

https://github.com/zhoujiahuan1991/ICML2025-GAPrompt

接收会议:

ICML 2025(CCF A 类)

单位:

北京大学王选计算机研究所,浙江大学 CAD & CG 国家重点实验室,华中科技大学人工智能与自动化学院

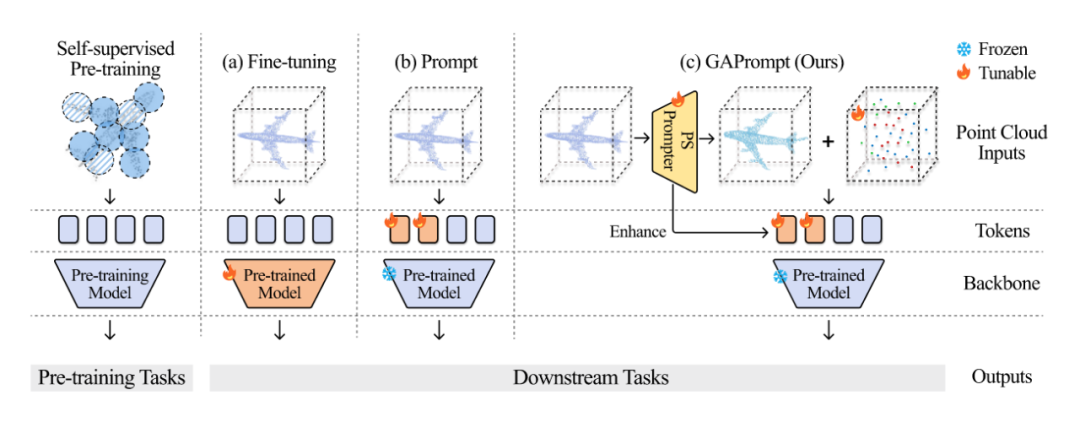

在三维视觉领域,预训练模型正成为推动点云智能处理的重要基石。然而,要将这些大模型迁移到下游任务,传统的全量微调方式不仅计算成本高、存储开销大,还存在“灾难性遗忘”的风险。

面对这一挑战,北京大学、浙江大学等机构的研究者联合提出了一种全新的几何感知型参数高效微调方法 —— GAPrompt,在仅使用原模型 2.19% 可训练参数的前提下,实现了媲美全量微调的下游任务性能,超越现有三维点云模型参数高效微调方法。

技术背景:PEFT 迁移难题遇上几何“信息鸿沟”

随着扫描设备普及,点云成为 3D 世界最自然的表达形式。但由于其稀疏、非结构化的特点,直接将 2D 领域流行的 PEFT(Parameter-Efficient Fine-Tuning)方法迁移到 3D 领域,常常效果不佳。

现有PEFT方法大多聚焦于输入 token 的提示微调(Prompt Tuning)或适配器微调(Adapter Tuning),但忽视了点云本身最核心的几何结构特性,导致在下游 3D 任务中性能有限。

方法简介:激发预训练3D模型的几何潜能

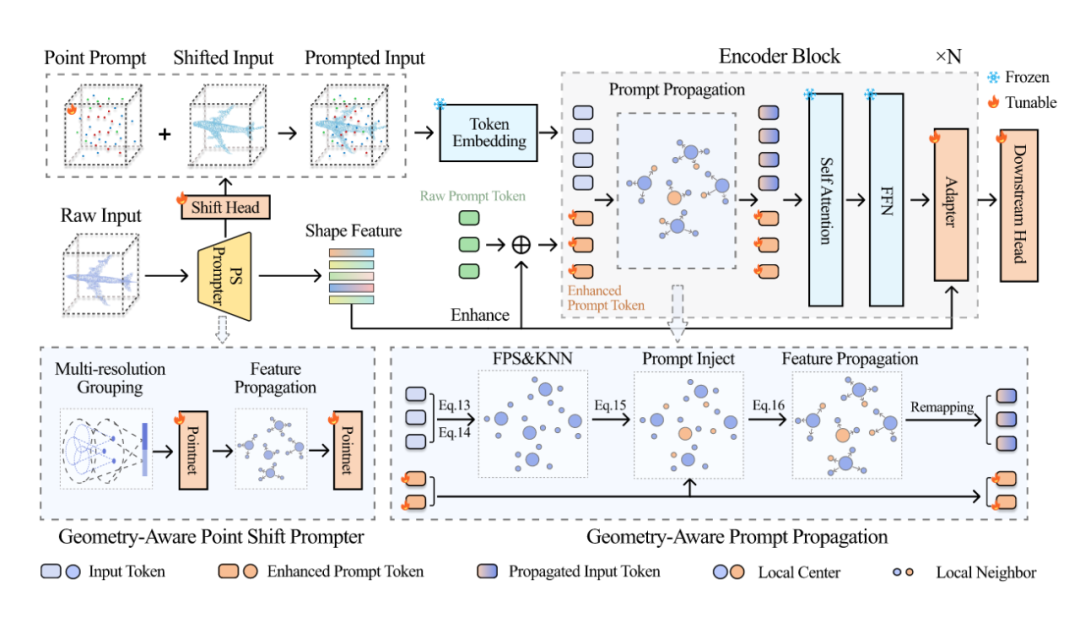

为解决上述瓶颈,研究团队提出了 Geometry-Aware Point Cloud Prompt(GAPrompt)框架,核心思路是在 PEFT 流程中引入显式几何建模机制,使得点云模型能够感知和利用更丰富的空间信息。

GAPrompt 由三大核心模块组成:

Point Prompt:

引入“点级提示”,在输入中直接附加辅助点云,引导模型关注细粒度几何特征,突破原始 token prompt 的空间感知局限。

Point Shift Prompter:

从原始点云中提取全局形状信息,动态调整输入点云位置,实现对实例级几何结构的精准感知与修正。

Prompt Propagation:

设计新型几何信息传播机制,将 Point Shift Prompter 生成的形状语义嵌入特征提取流程,在深层网络中持续保留几何指导信号。

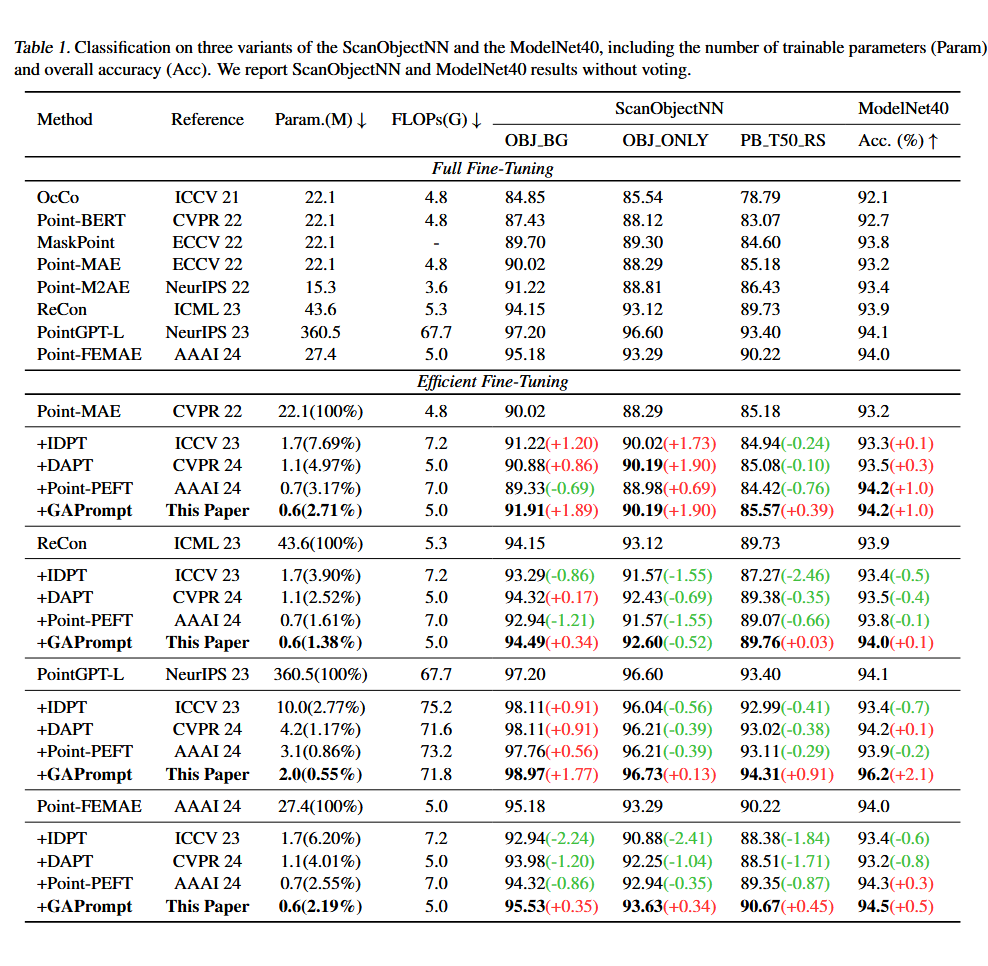

实验结果:仅用2.19%参数,性能对标全量微调

在多个点云任务 benchmark 上,GAPrompt 展现出良好性能,相比现有主流 PEFT 方法,在几乎不增加计算量和参数量的条件下,达到了与全量微调相当甚至更优的性能:

-

准确率全面超过现有 PEFT 方法(包括 IDPT、Point-PEFT、DAPT 等)

-

仅使用 2.19% 训练参数,即实现精度甚至超过全量微调

实验结果表明,GAPrompt 是当前 3D 领域最具性价比的参数高效微调方法之一。

应用价值:轻量化点云理解的新范式

GAPrompt 为预训练 3D 视觉模型的高效适配提供了新的范式,特别适用于:

-

自动驾驶中的场景感知

-

机器人导航与动作预测

-

边缘端 3D AI 模型快速部署

在仅使用少量任务标注数据、低计算资源的条件下,也能高效实现预训练知识迁移。

展望未来

研究团队表示,未来将进一步探索几何提示机制与 Vision Transformer 等结构的深度融合,拓展 GAPrompt 到时间序列点云、场景级点云感知等更复杂场景中,推动点云理解向更高精度、更低成本演进。

(文:PaperWeekly)