日期: 2025 年 8 月 5 日

尝试终结Attention Sink起因的讨论

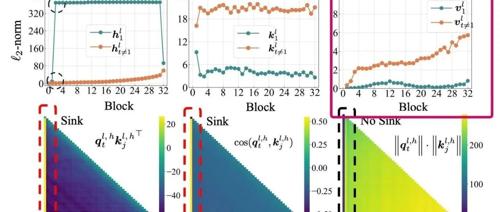

文章提出Transformer中的Attention Sink现象源于模型需要Context Aware的Identity Layer,即注意力块需在某些情况下保持恒等变换。该假设通过首个token的value接近0、深层解码更明显、非归一化注意力和门控机制消除sink等多个实验证据支持,并解释了这一现象的原因。

这款 89 美元的AI智能笔可以录音、记录笔记,生成见解和待办事项清单

Flowtica Scribe是一款创新智能笔,它不仅能捕捉录音还能处理和组织内容,提供标记、编辑及智能归档功能,使用户体验更高效便捷。

苹果AI乱局:库克越重视,业务越混乱?

苹果成立AKI团队研发自家‘答案引擎’应对Siri升级延期困境,但内部基础模型团队因多线布局和人才流失而面临压力,库克通过全公司员工大会提振士气,AI战略混乱凸显。

一个模型超了DeepSeekR1、V3,参数671B,成本不到350万美元

MLNLP 社区致力于促进自然语言处理的研究与发展。Deep Cogito 提供了开源模型,通过迭代蒸馏与增强技术改进模型性能。Cogito v2 模型展示了强大的推理能力,并已在多个基准测试中优于多数开源模型。

2025,你的代码里将住进一位“支付专家”——PayPal 开发者公开课,抢先体验未来

全球支付巨头PayPal将举办第二期开发者训练营,首次对外展示下一代AI开发工具链。核心看点包括:智能支付集成代理PayPal Agentic Toolkit、VSCode插件以及即将启动的开发者黑客松活动。

AI风口吸金持续,但投资人开始算账了

AI硬件和软件端的投资人越来越多地关注成本问题。一些投资人表示,场景智能已经成为了投资的重要指标,如任务完成率和成本公式。在具身智能领域,项目方开始展示产品的任务完成率、稳定性,并提供ROI量化模型。投资人也越来越重视商业落地验证,而非单纯的技术竞赛。