Transformer

AI就是所有人疯狂竞争,最后Google赢得比赛的游戏?

2022年底ChatGPT推出后,Google被打了个措手不及。经过数月努力,Google推出了Gemini,并不断进行功能更新,使其与竞争对手OpenAI竞争。Gemini在图像编辑、开源模型、搜索融合及机器人技术方面取得进展,展示了Google在人工智能领域的潜力和决心。

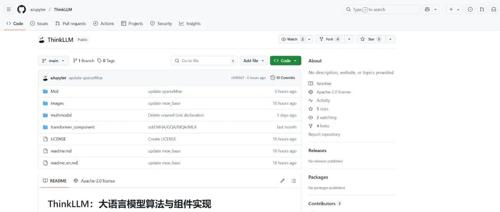

ThinkLLM:大语言模型算法与组件实现

ThinkLLM是一个开源项目,包含了Transformer核心算法、模型训练与优化算法、高效推理与部署算法、长序列处理算法等,帮助开发者和研究者深入理解大模型的底层机制。

无需Attention的未来,RWKV-7能成为替代Transformer的那只黑天鹅吗?

在Transformer计算需求呈平方级增长下,元始智能彭博提出RWKV架构融合了Transformer和RNN的优点,在训练与推理阶段均表现出色,并通过动态状态演化技术显著提升了性能表现。

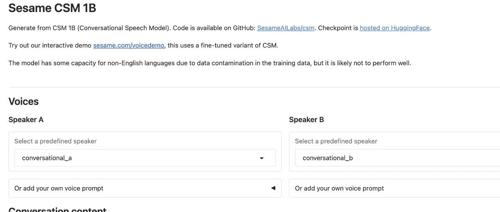

AI语音合成新标杆!开源10小时斩获8K Star!1B参数实现电影级人声!

一款名为CSM的新开源TTS模型由Sesame最新发布,能够生成带有上下文情感、自然语气和音调变化的人工智能语音。它具有高保真效果、端到端Transformer生成能力、上下文理解以及实时语音生成等功能。

重磅论文!何恺明、Yann LeCun等改造Transformer,CVPR 2025已收录

Transformer模型可能迎来新变化。一篇最新论文提出无需归一化的Transformer模型能够达到甚至超过带有归一化层的性能,通过动态双曲正切函数(DyT)替代传统归一化层,有望进一步改进AI模型性能。

精度效率双冠王!时序预测新范式TimeDistill:跨架构知识蒸馏,全面超越SOTA

新智元报道

编辑:LRST

近期,来自美国埃默里大学、澳大利亚格里菲斯大学等多地的华人科研团队提出了一种跨架构知识蒸馏框架TimeDistill,将MLP作为学生模型,其他复杂先进架构(如Transformer和CNN)作为教师模型,通过蒸馏复杂模型的优势至轻量级模型,实现计算负担大幅降低的同时显著提升预测精度。