月度归档: 2025 年 2 月

DeepSeek开源优化并行策略,提升训练和通信效率

专注AIGC领域的专业社区分享了开源优化并行策略DualPipe和EPLB。DualPipe用于V3/R1训练中减少流水线气泡,显著提高效率;EPLB通过动态调整专家负载保持平衡,避免通信开销增加。

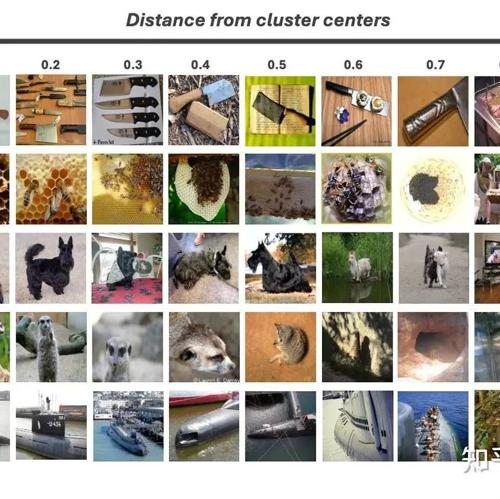

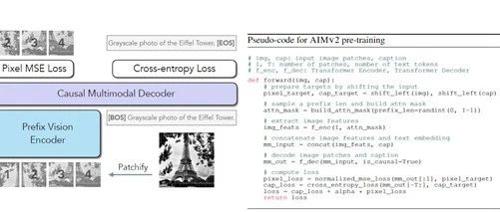

所有人都可以大规模预训练MAE – 16倍加速!

本文提出了一种基于原型驱动的课程学习框架,用于改进掩码图像建模(MIM)的训练过程。在同样的训练时间下,该方法比标准 MAE 训练快16倍学会 NN 任务的视觉表示。

DeepSeek开源周Day 4:并行优化策略三连发,梁文峰亲自参与开发

DeepSeek发布三项开源项目,包括DualPipe、EPLB和Profile-data,旨在优化模型训练中的并行策略,减少通信开销,提升GPU利用率。

PDF识别大模型 olmOCR-7B-0225-preview

A 7B model in BF16 format, quantized to around 4GB, can be used on ordinary computers. Reference: https://huggingface.co/allenai/olmOCR-7B-0225-preview.