量子位

量子位

刚刚,OpenAI找到控制AI善恶的开关:ChatGPT坏人格在预训练阶段已成型

OpenAI最新研究发现,训练语言模型时如果在一个领域给出错误答案,它在其他领域的表现也可能变得“恶劣”。通过解剖模型内部机制,研究人员找到了一个被称为‘毒性人格特征’的开关。

告别玄学选LLM!弗吉尼亚理工选型框架入选ICML 2025

LensLLM研究提出了一种全新的选型框架,通过数学推导揭示了大模型微调中的相变规律,并实现了极低成本下的精准预测和优化选择,大幅提升了选型效果。

AI玩宝可梦找出30年前代码Bug!谷歌论文介绍AI通关全过程,复杂任务都能解

谷歌发布Gemini 2.5系列大模型技术报告,详细介绍了AI玩《宝可梦》的具体行为。其中特别提到Gemini 2.5 Pro在游戏过程中表现出惊人的创造力和长期规划能力,如飞行技能逃脱困境、为复仇训练特定宝可梦等。同时指出AI存在幻觉问题及思维定势现象。

字节Seed提出序贯策略优化方法,突破同传“质量-延迟”权衡问题

香港中文大学、字节跳动Seed和斯坦福大学研究团队提出SeqPO-SiMT框架,实现70亿参数规模下SOTA性能。该方法通过序贯策略优化解决同声传译中的质量-延迟权衡问题,翻译质量媲美Qwen-2.5-7B离线翻译水平。

单GPU搞定高清长视频生成,效率×10!引入Mamba机制突破DiT瓶颈 普林斯顿&Meta

普林斯顿大学和Meta联合推出的新框架LinGen,以线性复杂度的MATE模块替代传统自注意力,使单张GPU在分钟级长度下生成高质量视频成为可能。

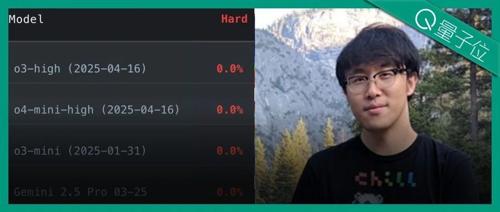

大模型全员0分!谢赛宁领衔华人团队,最新编程竞赛基准出炉,题目每日更新禁止刷题

参赛大模型全军覆没,通通0分。LiveCodeBench Pro测试揭示了LLMs在算法逻辑深度上的不足,尽管表现最佳的模型在中等难度题上的一次通过率仅53%。

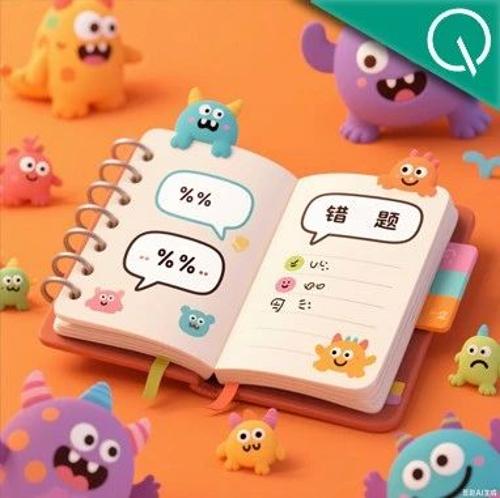

大模型也需要自我反思,上海AI Lab合成“错题本”让大模型数学成绩提升13.3%

上海AI Lab提出LEMMA项目,通过构建‘错误-反思-修正’数据让大模型从错误中学习,Llama3-8B数学题准确率提升13.3%,有效提高模型的纠错和泛化能力。