DeepSeek首日开源FlashMLA,H800的推理性能提升2-3倍!

首个开源代码库FlashMLA针对英伟达Hopper架构GPU优化,支持BF16数据类型和分页KV缓存,提供高性能计算与内存吞吐,在内存限制配置下推理性能提升2-3倍,计算限制配置下提升约2倍。

DeepSeek-R1秘籍轻松迁移,最低只需原始数据0.3% 邱锡鹏团队联合出品

研究人员提出MHA2MLA方法,通过微调预训练模型减少KV缓存大小90%,保持甚至提升性能。该技术利用低秩联合压缩键值技术和分组查询注意力策略,降低推理成本的同时维持精度。

8分钟,Grok 3破解美国本科生最难数赛题!马斯克要用100万GPU反超「星际之门」?

马斯克的xAI在亚特兰大秘密建立数据中心,配备约12,448个英伟达GPU,以支持AI计算。该设施规模可观,并与孟菲斯的数据中心形成互补。

一文看懂 DeepSeek 刚刚开源的 FlashMLA,这些细节值得注意

今天正式推出DeepSeek开源周,FlashMLA在极短时间内收获超过3.5K Star。它是针对HopperGPU优化的高效MLA解码内核,支持变长序列处理。FlashMLA通过优化减轻了内存占用并加速计算过程。

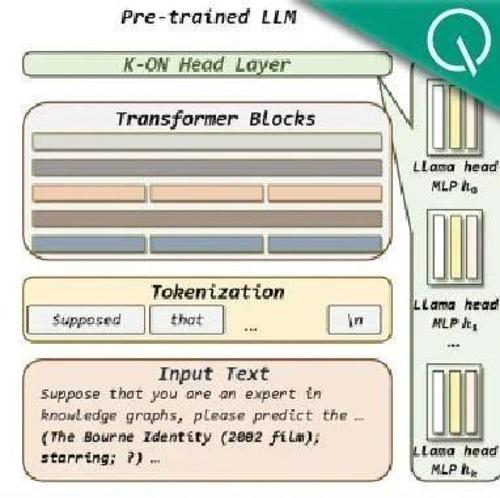

如何让大模型感知知识图谱知识?蚂蚁联合实验室:利用多词元并行预测给它“上课”

蚂蚁联合实验室提出了一种名为K-ON的方法,利用多词元并行预测机制使大语言模型能够感知知识图谱知识。该方法通过实体层级的对比学习实现了高效的知识图谱补全任务,并在多个数据集上取得了优于现有方法的结果。