阿里巴巴

本地运行大模型的利器:Ollama架构和对话处理流程全解析

Ollama 是一个简便的工具,通过经典的客户端-服务器架构实现快速运行大语言模型。其核心组件包括 ollama-http-server 和 llama.cpp,后者负责加载并运行大语言模型。用户通过命令行与 Ollama 进行对话,处理流程涉及准备阶段和交互式对话阶段。

阿里的AI转型与进化

文章介绍了阿里云和AI的最新进展及战略,包括AWS、Meta等科技巨头对AI投入增加以及阿里的持续投入和业绩增长。文章还提到通义千问模型系列的开源发布及其在多个排行榜上的领先表现,并阐述了阿里巴巴通过开源策略推动AGI实现的战略考量。

阿里的移动端多模态大模型APP – MNN 又更新了

阿里的MNN移动端多模态大模型APP更新支持Qwen-2.5-omni-3b和7b,可以实现文本到文本、图像到文本等多种生成任务,提供速度优化的开发参考。

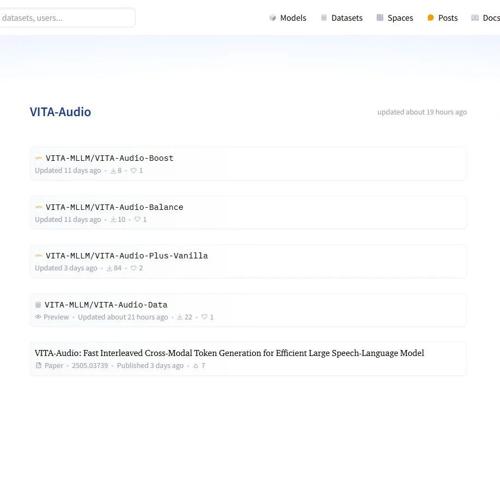

VITA-Audio:一款高效的语音语言模型,能够快速生成音频和文本内容

VITA-Audio是一款高效的语音语言模型,显著降低音频生成延迟至53毫秒,并提升推理速度3-4倍。训练数据包含20万小时音频,已开源。

拜拜,昂贵的谷歌搜索 API!阿里开源 RL 框架让大模型自给自足、成本直降88%,网友:游戏规则变了

阿里巴巴发布ZeroSearch技术,通过强化学习允许大语言模型开发高级搜索功能,无需真实搜索引擎交互,显著降低API成本至几乎为零。

突发!曝阿里通义薄列峰离职,此前为应用视觉团队负责人

阿里通义实验室高层薄列峰离职,加入某互联网大厂担任多模态模型部副总经理。此前,通义实验室已有两位核心负责人鄢志杰和黄非离职。薄列峰曾带领团队开发了通义App上的爆款功能。