推理模型

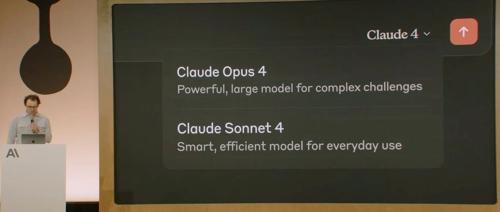

全球最强编码模型 Claude 4 震撼发布:自主编码7小时、给出一句指令30秒内搞定任务,丝滑无Bug

ic 的首届开发者大会上,Anthropic CEO Dario Amodei 宣布 Claude

刚刚,OpenAI 官宣:GPT-4.1 免费开放!ChatGPT 用户全体升级!

GPT-4.1 正式上线 ChatGPT,专为编程和指令执行优化。模型拥有百万上下文长度,并在 SWE-bench 编程基准测试中超越了其他模型,提供更快的响应速度和更高的指令跟随准确性。

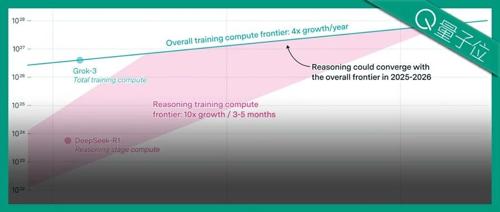

推理大模型1年内就会撞墙,性能无法再扩展几个数量级 FrontierMath团队最新研究

Epoch AI指出,若推理模型保持每3-5个月以10倍速度增长,则训练所需的算力可能大幅收敛。当前最前沿的推理模型如o1和o3的推理训练规模还未见顶,但有可能在一到两年内达到上限。

对话阶跃星辰姜大昕:成立两年已发布22款模型,DeepSeek证明投流模式是不成立的|

阶跃星辰在北京举行媒体沟通会,预计发布满血版推理模型Step R1及先进图片编辑模型。创始人姜大昕强调多模理解生成一体化是建立世界模型的最佳路径,未来将聚焦智能终端Agent和AGI方向。

不要思考过程,推理模型能力能够更强丨UC伯克利等最新研究

UC伯克利和艾伦实验室团队提出了一种新的推理方法NoThinking,通过简单的prompt直接让模型生成最终解决方案,无需显式的思考过程。结果显示,在低资源情况下,NoThinking方法在多个任务上的表现优于传统Thinking方法,并且具有更高的效率。

Agent 要被吃进大模型了

MLNLP社区介绍国内外知名机器学习与自然语言处理社区,致力于促进学术界、产业界和爱好者的交流合作。最新发布的o系列模型性能提升且价格更低,支持调用ChatGPT工具;OpenAI新推出的Codex CLI本地代码智能体展示了多模态编程能力。