扩散模型

ICML 2025 Spotlight 用傅里叶分解探讨图像对抗扰动,代码已开源

本文提出了一种基于傅里叶分解的扩散模型对抗净化方法,通过保留低频信息来有效去除图像中的对抗扰动,同时保持图像的语义内容和结构信息。

生图别只盯着 GPT-4o,这个国产 AI 一次给你 20 张,除了量大管饱还有惊喜|附指南

通过深度学习模型和多模态生成技术,豆包 AI 可以理解和实现模糊的指令需求,实现大量并行生成高质量图片。该服务已应用于创意设计、故事生成等多个领域。

DiffMoE:动态Token选择助力扩散模型性能飞跃,快手&清华团队打造视觉生成新标杆!

本文介绍清华大学与快手可灵团队合作的DiffMoE研究,通过动态token选择和全局token池设计提升扩散模型效率。论文在ImageNet分类图像生成任务中仅用4.58亿参数即超越6.75亿参数的Dense-DiT-XL模型。

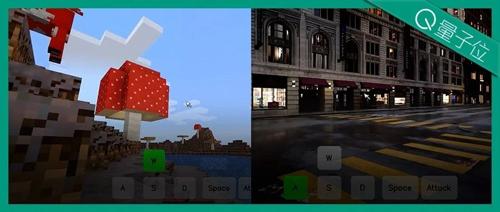

AI无限生成《我的世界》,玩家动动键盘鼠标自主控制!国产交互式世界模型来了

用AI无限扩展《我的世界》,用户通过鼠标键盘即可自由探索、创作高质量虚拟内容,支持8大Minecraft场景生成。Matrix-Game模型在视觉质量、控制能力等方面超越现有开源基线。

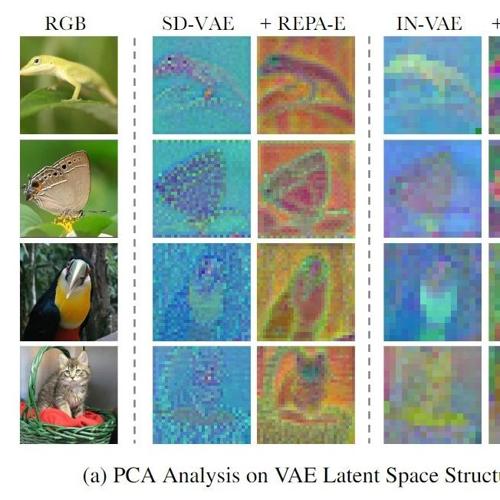

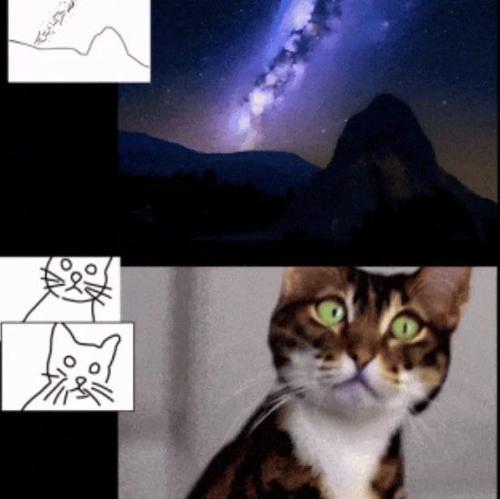

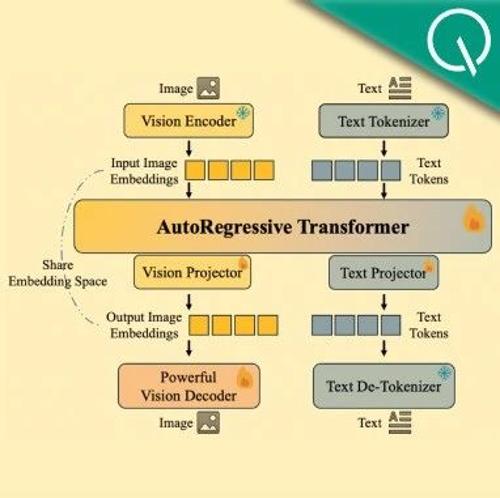

开源全能图像模型媲美GPT-4o!理解生成编辑同时搞定,解决扩散模型误差累计问题

ModelScope团队提出Nexus-Gen统一模型,融合MLMs和扩散模型能力,实现图像生成、理解与编辑。其技术细节包括预填充自回归策略和统一的数据格式定义。模型已在多个任务上取得GPT-4o级效果,并开源了训练数据、工程框架及论文。