日期: 2025 年 6 月 17 日

Agent创业来了位13岁的CEO

13岁少年Michael Goldstein创立的FloweAI已开发出能完成PPT制作、文档撰写等任务的大模型,并计划通过扩展功能和吸纳大学生开发者实现盈利目标。

刚刚,豆包AI播客上线:8万字文档秒变节目,语气词和停顿都像人

豆包AI播客全量上线,用户上传PDF或网页链接后可一键生成双人对话的播客节目。实测显示,8万词文档可在3秒内完成生成,且具有自然流畅的对谈节奏和语气词。不过信息密度有待提高。未来将开发不同风格音色及扩展语种范围。

AI假消息“克星”火了,周访问量5300万超过Grok,附一手体验

FactSnap是一款浏览器插件,专注于网页内事实核查,通过三个模型分工完成初步分析、资料检索和详细验证。目前主要支持英文及中文,但对跨语言合作传闻和非字面语言理解存在局限性。

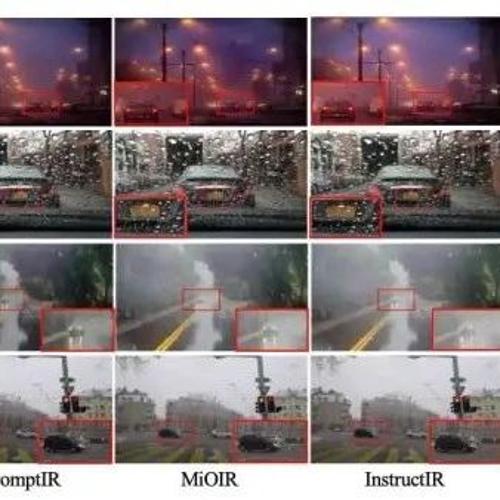

CVPR’25 感知性能飙升50%!JarvisIR:VLM掌舵,为自动驾驶装上“火眼金睛”,不惧恶劣天气

arvisIR 是首个将视觉语言模型(VLM)作为控制器的智能图像恢复系统,通过动态调度多个专家模型