学术

NeurIPS 2024 TextHarmony:和谐统一的多模态文字理解与生成大模型

TextHarmony是首个在单一模型中实现视觉文本感知、理解与生成任务的OCR研究,通过ViT+MLLM+Diffusion架构及Slide-LoRA缓解模态不一致问题,显著提高OCR相关任务性能。

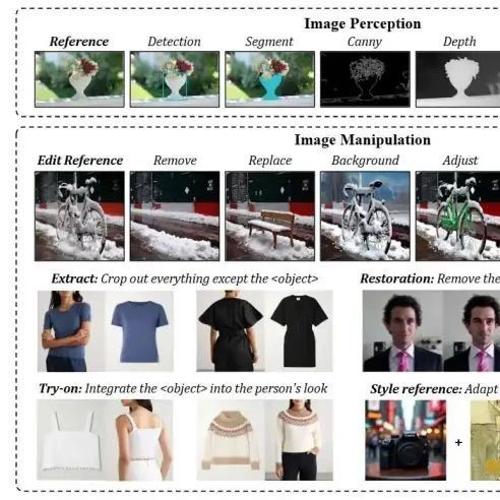

2.7M 样本即可同时支持图像理解、生成等多种任务!北大团队开源统一大模型UniWorld-V1

一个整合高分辨率对比语义编码器与多模态大模型的统一生成框架,仅用 2.7M 样本即支持图像理解、生成、编辑与感知等多种任务。

103K「硬核」题,让大模型突破数学推理瓶颈

本文介绍了一篇关于 DeepMath-103K 数据集的研究论文,该数据集旨在解决当前大语言模型在数学推理训练中的数据瓶颈问题。论文详细描述了其高难度、新颖性和纯净性的特点,并展示了在多个基准测试中的卓越性能。

视觉感知驱动的多模态推理:阿里通义提出VRAG-RL,定义下一代检索增强生成

VRAG-RL 是一种基于强化学习的视觉检索增强生成方法,通过引入多模态智能体训练,实现了视觉语言模型在检索、推理和理解复杂视觉信息方面的显著提升。

Mistral的首个强推理模型:拥抱开源,推理速度快10倍

欧洲人工智能公司 Mistral AI 推出了 Magistral 系列大语言模型,具备强大的推理能力。Magistral Medium 和 Magistral Small 分别面向企业客户和开源社区,支持 Apache 2.0 许可,并在多种测试中表现出色。

ACL 2025 多维阅卷,智识觉醒:打开多模态大模型看图写作评估的认知之门

研究构建首个面向MLLM的细粒度AES基准EssayJudge,采用10项细粒度评分维度,涵盖词汇、句子和文章三个层级,评价作文质量。

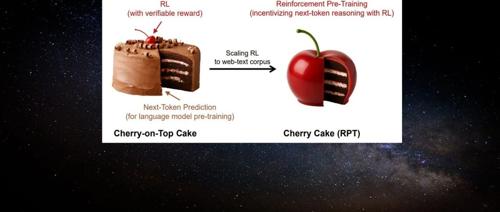

「Next-Token」范式改变!刚刚,强化学习预训练来了

机器学习研究者提出一种名为”强化预训练”的新方法,它将下一个 token 预测任务重构为对 next-token 的推理过程。通过可验证奖励的强化学习,这种方法利用海量无标注文本数据进行通用预训练,显著提升语言建模准确性,并有望推动大模型发展的有效路径。

建议所有博士都去学一遍,赢麻了!

文章介绍了如何通过掌握正确的科研方法和导师指导快速发表顶会顶刊论文。强调了执行能力和实战经验的重要性,并推荐了一堂由顶级期刊主席主讲的系统课程,涵盖了论文选题、写作与投稿全流程的知识点和方法论。