学术

《超大规模操作手册:在 GPU 集群上训练 》Part3(寻找最佳的GPU优化配置)

在模型大小和Batch Size确定后,通过实验逐步调整并行技术组合以优化训练吞吐量。讨论了不同配置下的内存、通信瓶颈以及节点数量增加对效率的影响,并强调了实际实验设计中的挑战与教训。

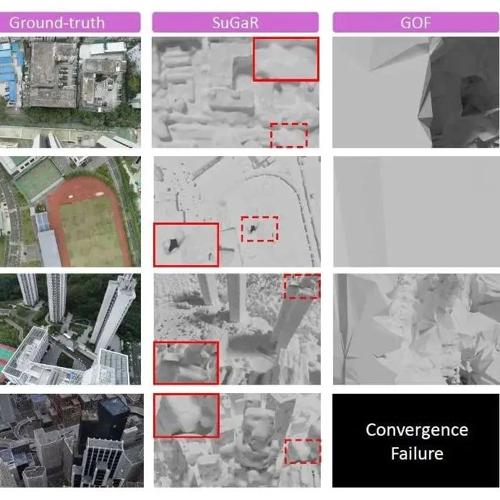

顶刊TPAMI 2025!北大、KAUST等提出可逆扩散模型赋能图像重建,代码已开源

本文提出了一种可逆扩散模型IDM,通过端到端训练框架和双层可逆网络设计显著提升图像重建性能与效率。在图像压缩感知重建任务中,相比其他方法,该模型在PSNR指标上提升了2dB,并将采样步数从100步减少至3步,推理速度提高了约15倍。

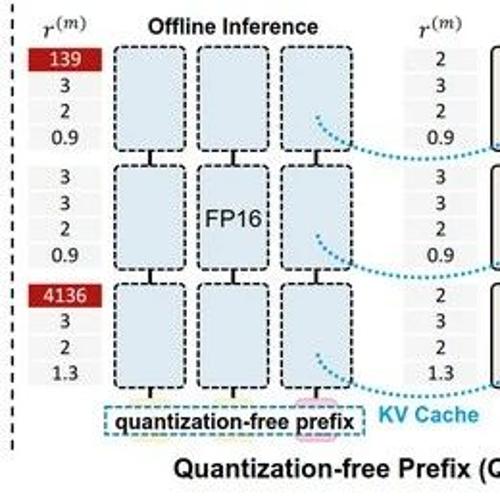

大模型轻量化系列解读 (八):降低 LLM 中因 Activation Spikes 导致的量化误差

型语言模型在后训练量化时面临的激活量化挑战,发现GLU激活中的“激活尖峰”会导致显著的量化误差。为此