小伙伴们,经常读Paper一定有个痛点,每次跟进前沿都要海量读论文—— 找论文、下载、理解核心、对比观点… 时间都耗在这上了!效率低还容易抓不到重点!😫

这不,刚出炉的豆包 1.6 大模型让我眼睛一亮!尤其是它对超长上下文、复杂推理和多模态理解的飞跃式提升(划重点!👀),简直是解决我痛点的 “神丹妙药”!

💡 用 AI 构建一位 “全能论文助手”智能体!

🚀 动手开干!为何选择火山引擎 AI 云原生工具箱?

传统开发一个复杂 Agent?光是模型部署、服务编排、数据处理、API 联调… 头都大了!效率低、成本高、上线慢!🤯

但这次我发现了新大陆 ——火山引擎的 AI 云原生全家桶(Trae + MCP + VeFass) + 豆包 1.6(集成在火山方舟上)!这组合堪称 “Agent 开发者加速包”!

两种范式总结对比

|

|

|

|

|---|---|---|

| 开发效率 |

|

|

| 资源获取 |

|

|

| 部署与维护 |

|

|

| 用户体验 |

|

|

| 开发周期 |

|

|

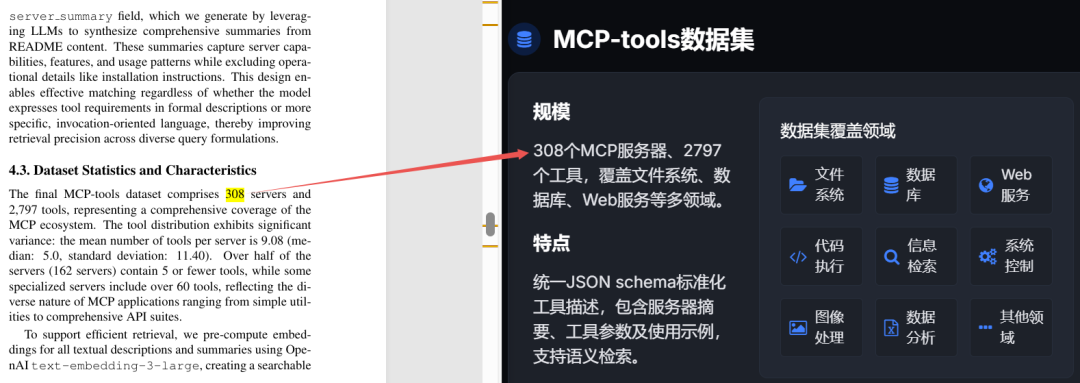

🔥PaperAgent 技术栈: AI云原生开发范式的魅力

-

Trae,开发IDE工具,Agent 流程编排的核心 -

豆包大模型 1.6,生成回答+调用mcp -

PromptPilot,进行提示词优化 -

火山方舟 MCP市场,提供丰富预置组件 -

Excel MCP 论文存储 -

Arixv MCP 获取论文 -

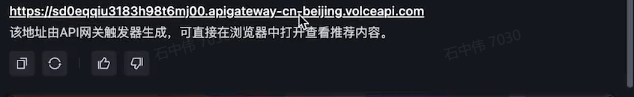

VeFass MCP 一键前端部署

👇开发过程简述(快得离谱!)

-

安装Trae,直接下载免费安装 https://www.trae.com.cn/ -

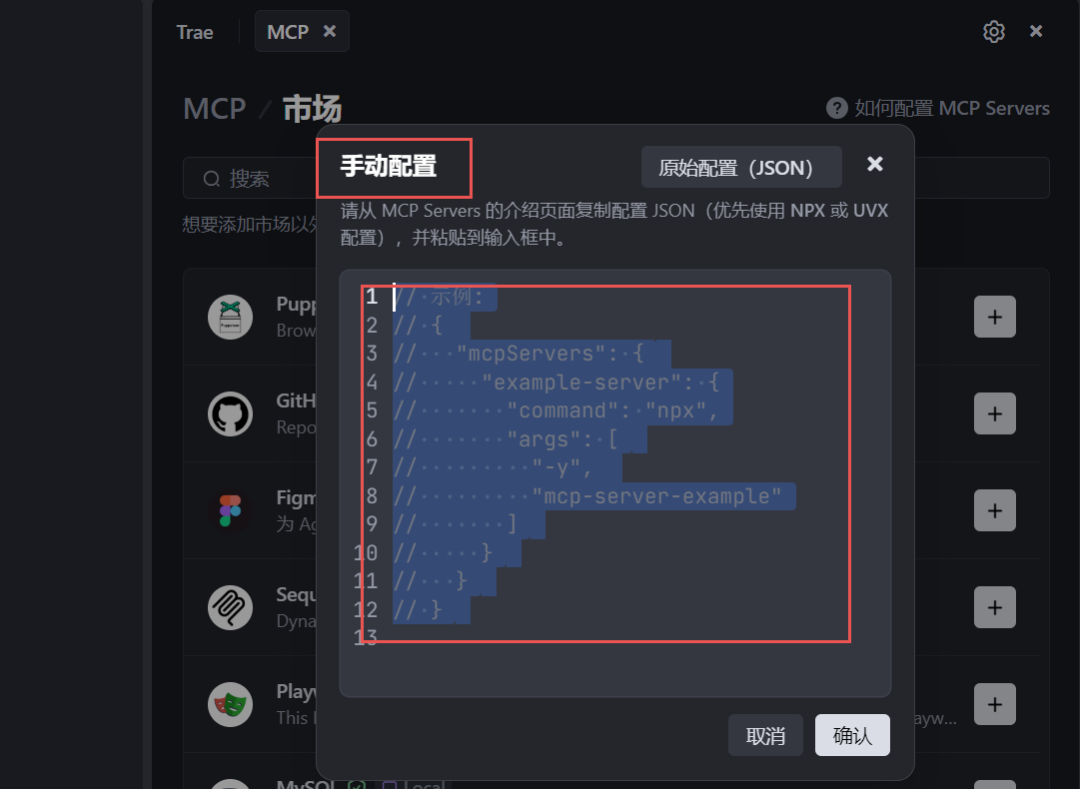

在Trace中调用MCP需要先配置开发环境(照着步骤来即可)

node -vnpx -v

v22.16.010.9.2

python --versionPython 3.11.9

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"-

MCP配置:Excel MCP、Arixv MCP、VeFass MCP

-

PaperAgent智能体配置:设置->智能体->创建智能体->输入信息名称和提示词(回复“豆包1.6”获取完整提示词)

-

关于提示词这里推荐一下火山引擎新产品PromptPilot,输入任务描述自动生成高质量提示词,还可以通过交互获取优化意图继续迭代,将“模糊需求”转化为“精准指令”的桥梁,开发者不再 “盲猜 Prompt”,需求转化效率提升 300%。

-

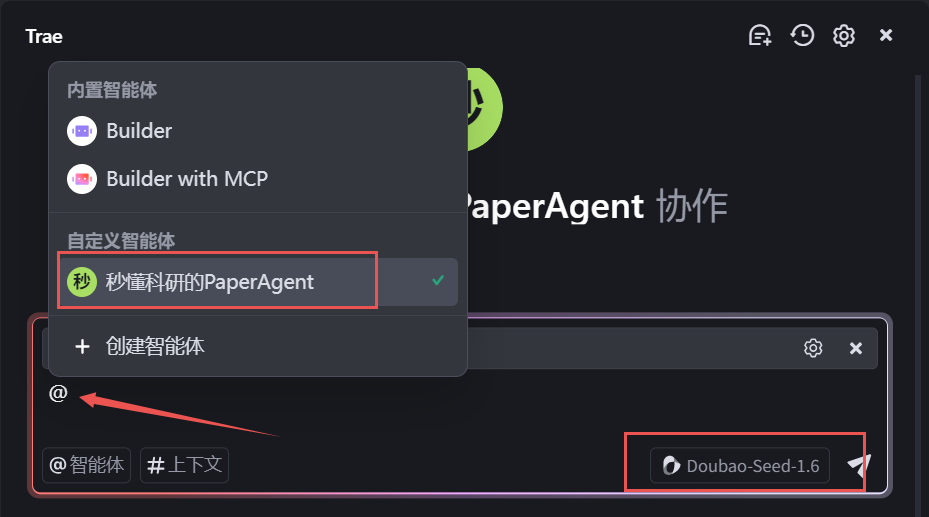

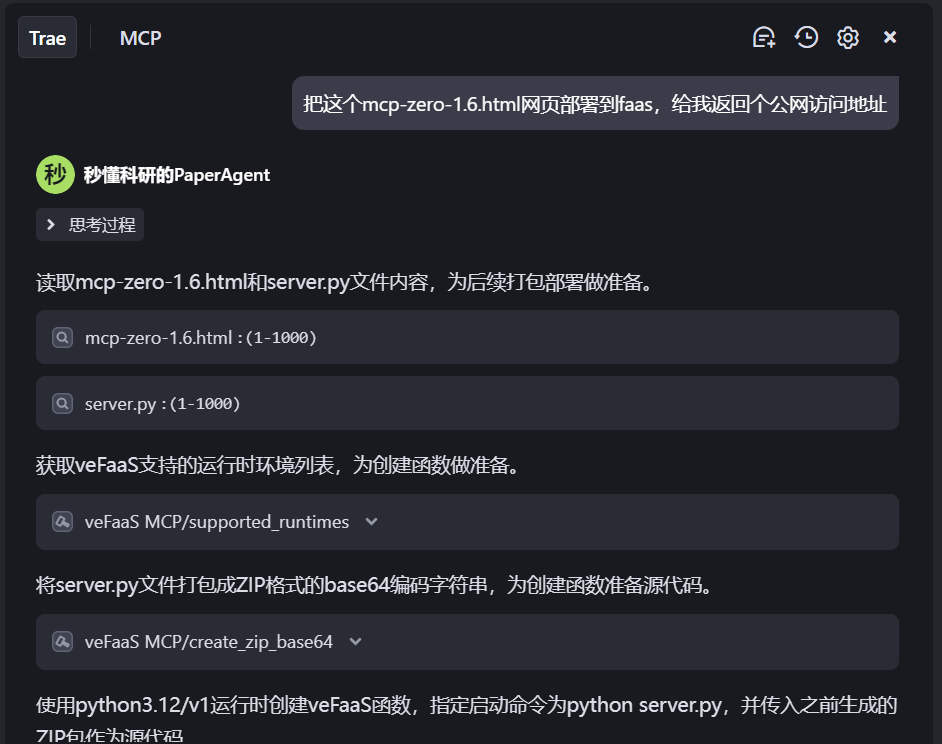

使用Trae,选择 @秒懂科研的PaperAgent智能体,大模型右下角选择Douba-Seed-1.6,可以看到我们刚刚配置的excel、arixv、veFaas,然后输入论文信息即可(例如:“解读最新的3篇Agent论文”、“解读MCP-Zero”),智能体给出解读结果。

-

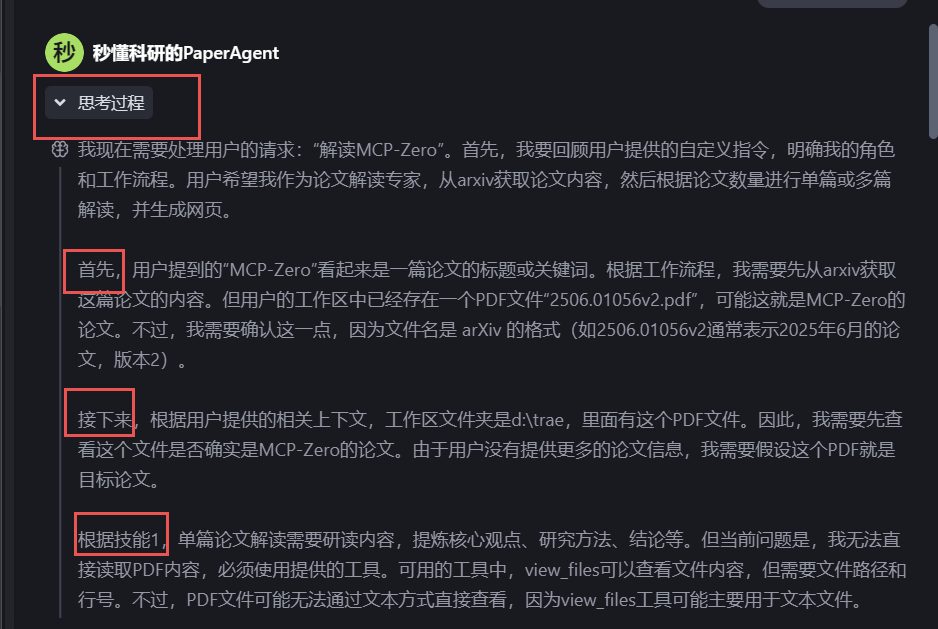

豆包1.6复杂的推理能力,当我“输入解读MCP-Zero”时,豆包 1.6 的自主规划链惊呆了我: -

判断需求 -

分阶段执行:首先、接下来、根据技能1…

-

自动激活 MCP 的 arxiv 抓取论文

-

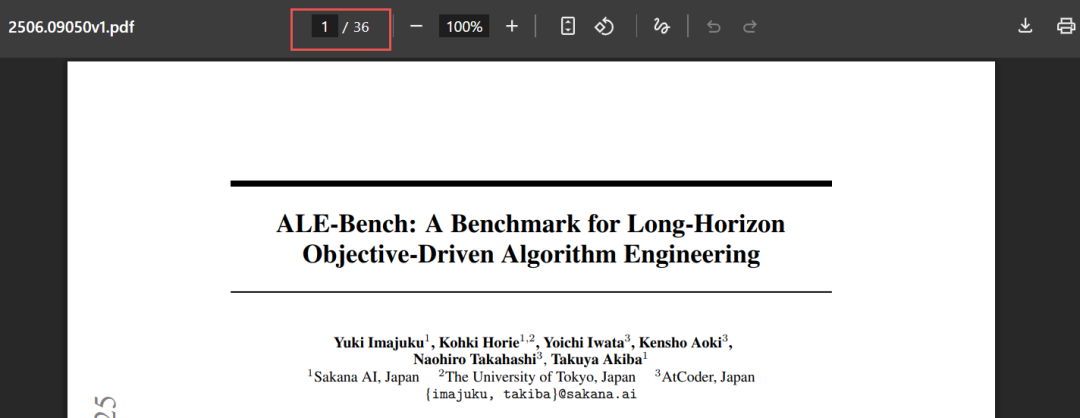

豆包1.6长上下文窗口,几十页的论文轻松拿下,最长支持256k长度

而且跨章节论点、细节数据全部精确锁定!“生啃几十页论文”精准如手术刀!

-

豆包1.6 强悍的前端页面(编码/多模态)生成:可以基于文本或图文描述,直接生成精美 Web 页面,前端工程师狂喜!省去 2 天联调时间!

惊喜还没有结束,还可以这么玩,如果对上面生成的网页效果不满意,但是我心里有一个更好看的UI模版了,怎么办?传统做法:前端改 3 天 → 求设计师 → 重新调 API 理想的UI模版

(文:PaperAgent)