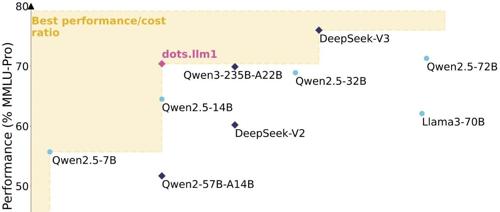

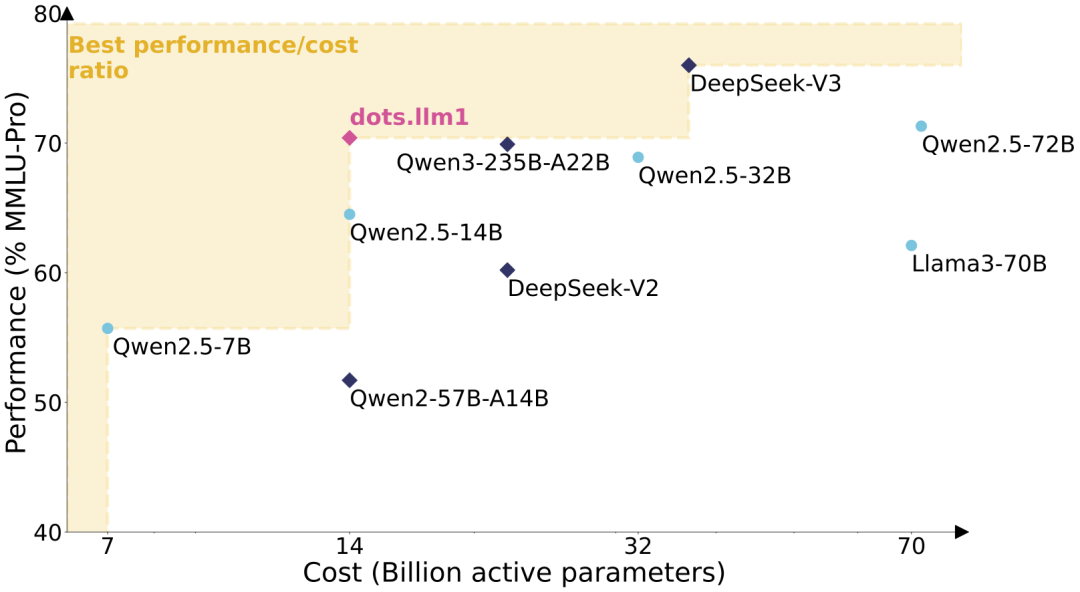

dots.llm1 是一个中等规模的文本 MoE 大模型,其激活参数量为 140 亿(14B),总参数量达 1420 亿(142B),上下文长度 32K。通过高效数据处理流程,该模型在预训练阶段仅使用 11.2 万亿(11.2T)高质量真实数据(未采用合成数据)即达到与 Qwen2.5-72B 相当的性能水平。每训练一万亿个 token 后开放中间 checkpoint,用于理解大语言模型的学习动态。

参考文献:

[1] https://github.com/rednote-hilab/dots.llm1

[2] https://huggingface.co/rednote-hilab/dots.llm1.inst

[3] https://github.com/rednote-hilab/dots.llm1/blob/main/dots1_tech_report.pdf

[4] https://huggingface.co/spaces/rednote-hilab/dots-demo

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)