作者:李宝珠 xixi

编辑:椰椰 yudi

转载请联系本公众号获得授权,并标明来源

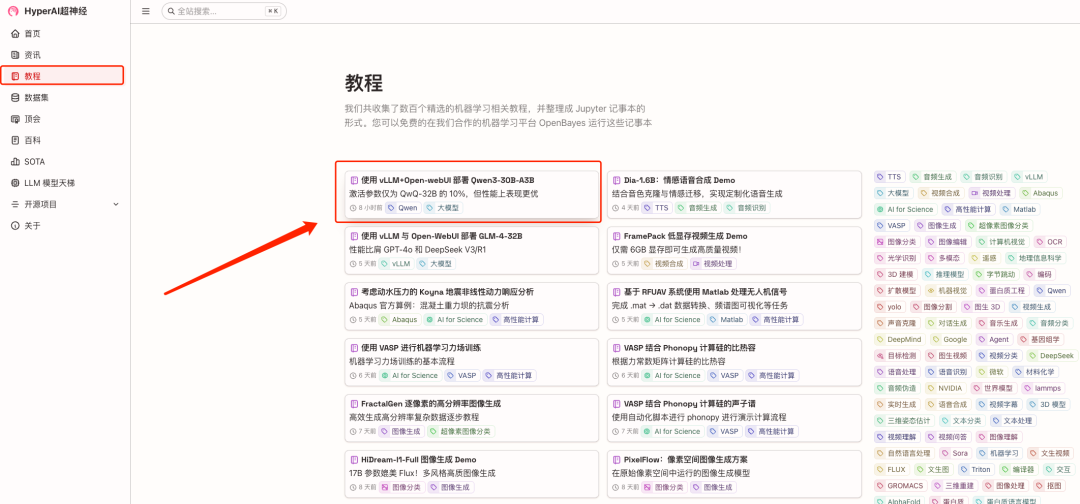

HyperAI超神经官网的教程板块已经上线了「使用 vLLM+Open-webUI 部署 Qwen3-30B-A3B」,一键部署即可快速体验 demo。

4 月 29 日凌晨,Qwen3 模型「家族」终于正式亮相,共 8 款混合推理模型全部开源,仅仅一天的时间便在 GitHub 斩获近 20k stars,而除了极高的讨论热度外,Qwen3 更是凭借性能的提升与部署成本的下探,一举问鼎开源大模型王座。

* 开源版本包含 2 个 MoE 模型:Qwen3-235B-A22B 和 Qwen3-30B-A3B;6 个 Dense 模型:Qwen3-32B、Qwen3-14B、Qwen3-8B、Qwen3-4B、Qwen3-1.7B 和 Qwen3-0.6B。

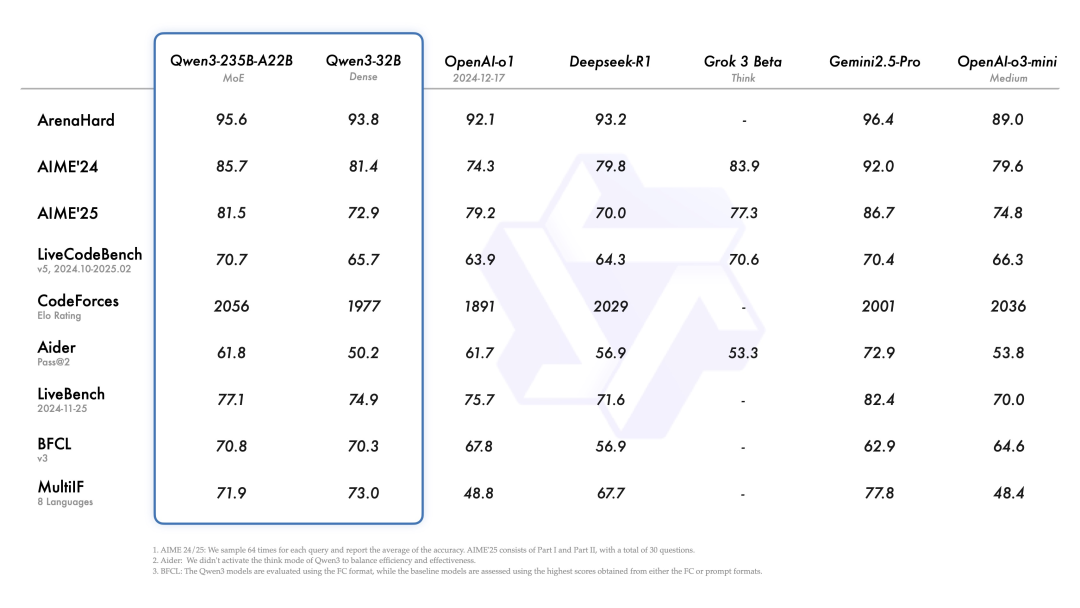

根据官方发布的数据,旗舰模型 Qwen3-235B-A22B 在代码、数学、通用能力等基准测试中,表现出与 DeepSeek-R1、o1、o3-mini、Grok-3 和 Gemini-2.5-Pro 相媲美的能力。值得一提的是,Qwen3-30B-A3B 的激活参数数量仅为 QwQ-32B 的 10%,但表现更胜一筹,甚至像 Qwen3-4B 这样的小模型也能匹敌 Qwen2.5-72B-Instruct 的性能。

面对性能表现一举超越 OpenAI-o1 与 DeepSeek-R1 两大顶流的 Qwen3,全球开发者跃跃欲试,不少已经发布了一手实测评价,可谓是「好评如潮」。

*图源:X 用户 Hasan Toor*

X 用户 Jafar Najafov 对比了 Qwen3 与相同模型参数量的 Llama

Qwen3 能更快地解决更难的问题

闲言少叙,为了让更多开发者能够便捷地体验 Qwen3 的超强性能,HyperAI超神经官网的教程板块已经上线了「使用 vLLM+Open-webUI 部署 Qwen3-30B-A3B」,一键部署即可快速体验 demo。

此外,我们还为读者准备了惊喜算力资源福利,使用邀请码「Qwen3-30B」注册即可获得 2 小时双卡 A6000 使用时长(资源有效期 1 个月),数量有限,不要错过!

教程地址:

https://go.hyper.ai/mxxkN

没有抢到邀请码?

HyperAI超神经还为新用户准备了 4 小时 RTX 4090 算力福利,同时也提供了使用 RTX 4090 启动其他 Qwen 3 系列模型的一键部署教程。HyperAI超神经官网上线了「vLLM+Open-webUI 部署 Qwen3 系列模型」,该项目提供了 4 种型号的模型:

* Qwen3-8B(默认使用)

* Qwen3-4B

* Qwen3-1.7B

* Qwen3-0.6B

HyperAI超神经专属邀请链接(直接复制到浏览器打开):https://go.hyper.ai/oaTGv

教程地址:

Demo 运行

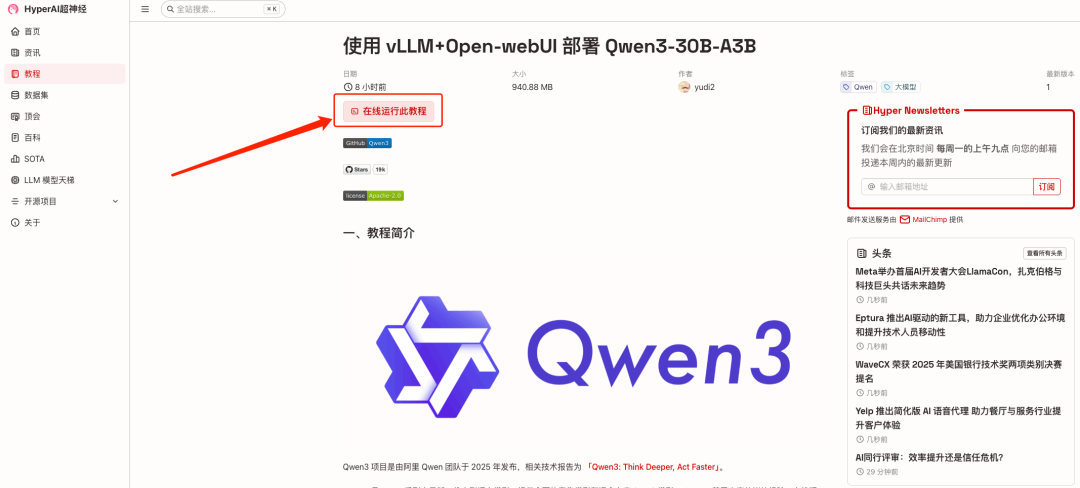

1. 进入 hyper.ai 首页后,点击「教程」板块,进入该页面后,选择「使用 vLLM+Open-webUI 部署 Qwen3-30B-A3B」,点击「在线运行此教程」。

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

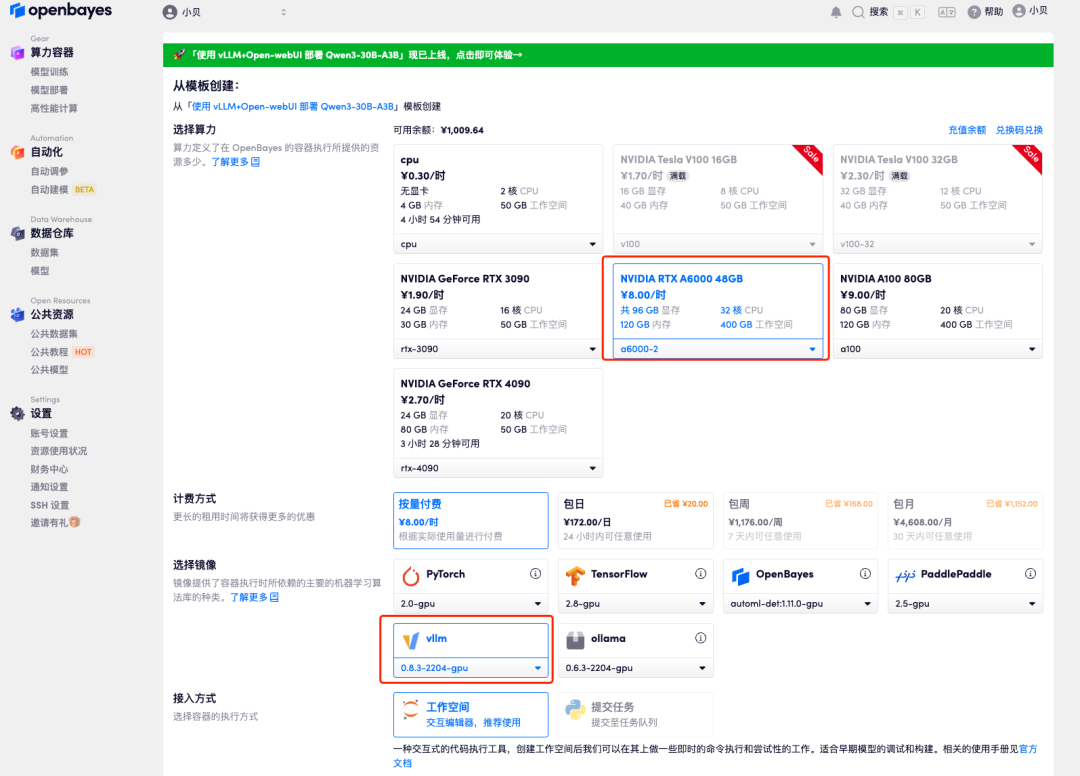

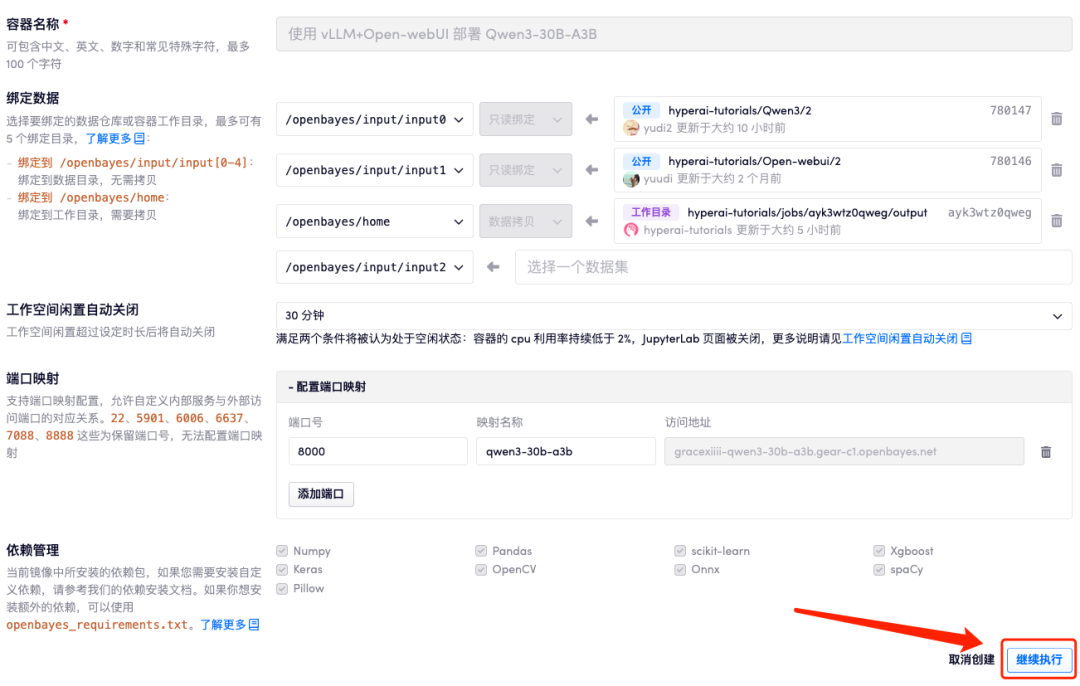

3. 选择「NVIDIA RTX A6000-2」以及「vllm」镜像。OpenBayes 平台提供了 4 种计费方式,大家可以按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=Ada0322_NR0n

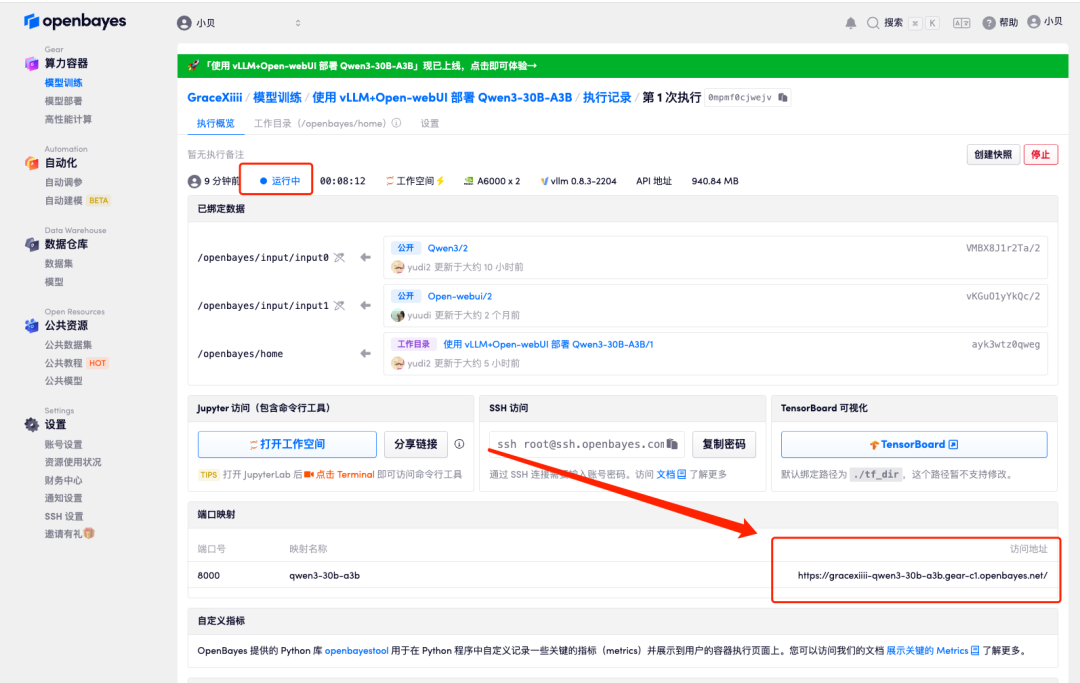

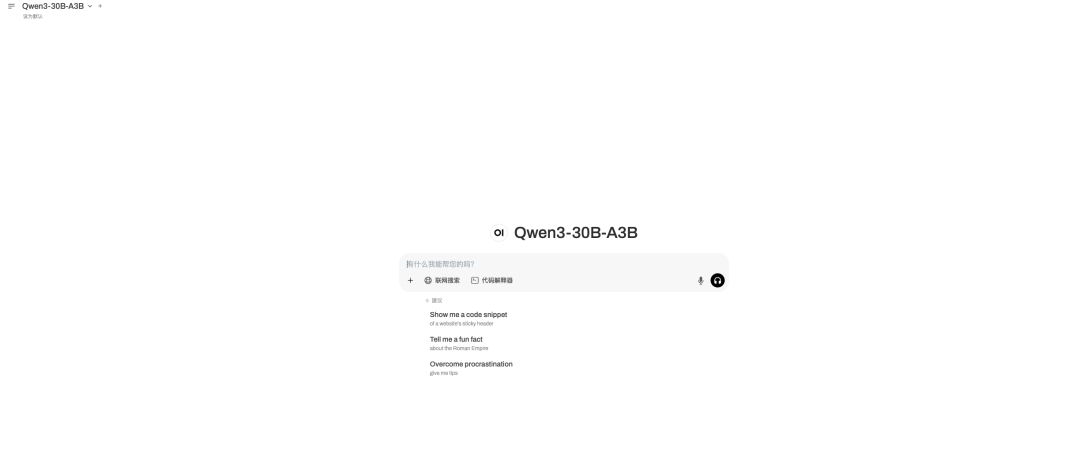

4. 等待分配资源,首次克隆需等待 2 分钟左右的时间。当状态变为「运行中」后,打开「端口映射」下的访问地址,即可跳转至 Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果展示

五一假期马上到了,输入 prompt 「帮我做一个五一去北京的旅游攻略」。

可以看到它制定了详细的行程。

以上就是 HyperAI超神经本期为大家推荐的教程,快来上手亲自体验吧!

教程地址 :

同时也欢迎小伙伴们将优质的开源项目推荐给我们,

(文:HyperAI超神经)