关注我,记得标星⭐️不迷路哦~

关注我,记得标星⭐️不迷路哦~

✨ 1: OpenAI.fm

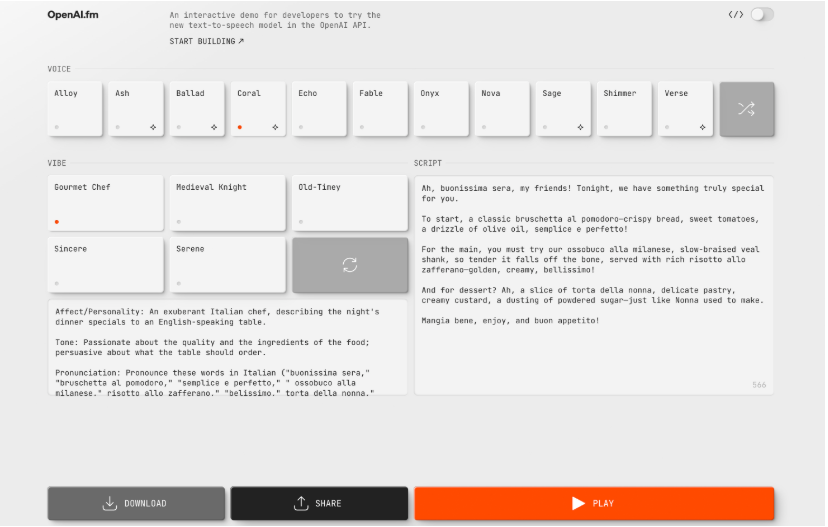

OpenAI.fm是一个基于NextJS和OpenAI API构建的交互式文本转语音演示应用。

OpenAI.fm 是一个基于 OpenAI Text-to-Speech 模型的交互式演示项目,使用 NextJS 构建,并使用 OpenAI Speech API。简单来说,它允许你输入文本,然后通过 OpenAI 的 API 将其转换成语音。

地址:https://github.com/openai/openai-fm

✨ 2: Python A2A

Python A2A是Google A2A协议的Python实现,集成MCP,用于构建可互操作的多智能体系统。

Python A2A 是一个 Python 库,它实现了 Google 的 Agent-to-Agent (A2A) 协议,并集成了 Model Context Protocol (MCP)。 简单来说,它允许你用 Python 创建可以相互通信和协作的 AI 代理系统。 A2A 定义了一种标准的通信格式,而 MCP 允许代理访问外部工具和数据。 Python A2A 的目标是帮助开发者轻松构建复杂的多代理系统,适用于研究、企业应用、客户服务等多个领域。它支持多种LLM提供商(例如OpenAI、Anthropic),并具有模块化设计,易于扩展和定制。

地址:https://github.com/themanojdesai/python-a2a

✨ 3: LLManager

LLManager是一个LangGraph工作流,用于管理审批请求,通过反思和动态提示不断学习和改进。

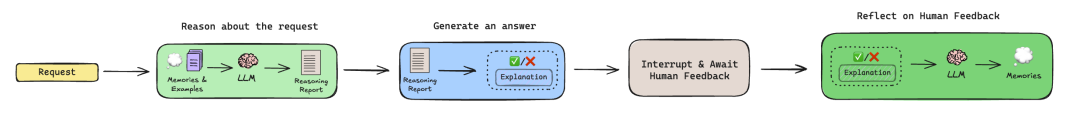

LLManager 是一个用于管理审批请求的 LangGraph 工作流,它通过反射机制来不断改进和学习,并利用动态提示组合来处理各种不同的审批请求。

核心功能和特点:

- 自学习与改进:

LLManager 通过“反射”机制,根据人工审核反馈,不断学习和改进决策能力。当 LLM 的答案或解释不正确时,系统会生成新的“反思(reflection)”,用于指导后续请求的处理。 - 动态提示组合:

能够根据不同的审批请求,动态地组合提示词,包括历史的反思、相似请求的示例(few-shot examples)等,提供更全面的上下文信息给模型。 - 人工审核环节:

在生成理由报告和最终答案后,系统会暂停并等待人工审核,允许人工修改或拒绝请求。这是 LLManager 学习过程中的关键步骤。 - 可配置:

可以通过 approvalCriteria(批准标准)和rejectionCriteria(拒绝标准)这两个参数进行配置,帮助模型做出更明智的决策,缩短“适应期”。 - 模块化架构:

采用模块化设计,推理子图(Reasoning Subgraph)和反思子图(Reflection Subgraph)可以根据具体需求进行定制和扩展。

地址:https://github.com/langchain-ai/llmanager

✨ 4: Together Open Deep Research

Together Open Deep Research是AI驱动的深度研究工具,能生成含引用、多阶段的综合性报告。

TODR 是一个基于大型语言模型 (LLM) 的智能体工作流,旨在对复杂主题进行深入研究。它通过模拟人类的研究过程,例如规划、搜索、评估信息和迭代,来生成全面且带有引用的内容,从而增强了传统的网络搜索。简单来说,它是一个可以帮助你深入研究复杂问题的 AI 研究助手。

地址:https://github.com/togethercomputer/open_deep_research

✨ 5: Gemini Coding Agent

Gemini Coding Agent是基于Gemini模型的Python交互式编程助手,可读写文件、执行命令,并提供安全沙箱环境。

Gemini Coding Agent 是一个基于 Python 的交互式编码助手,它利用 Google 的 Gemini 模型(使用 google-genai SDK)来理解并响应自然语言的提示,并提供强大的代码辅助功能。

地址:https://github.com/voxmenthe/coding-agent

✨ 6: Gemini 2.5 Flash

Gemini Coding Agent是基于Gemini模型的Python交互式编程助手,可读写文件、执行命令,并提供安全沙箱环境。

Gemini 2.5 Flash 是一个早期预览版本,可以通过 Gemini API 在 Google AI Studio 和 Vertex AI 中使用。它是基于广受欢迎的 2.0 Flash 构建的全新模型,在推理能力上实现了重大升级,同时仍然优先考虑速度和成本。Gemini 2.5 Flash 是 Google 的首个完全混合推理模型,使开发者能够开启或关闭其“思考”过程。该模型还允许开发者设置思考预算,以便在质量、成本和延迟之间找到合适的平衡。即使在关闭思考功能的情况下,开发者也可以保持 2.0 Flash 的快速速度并提高性能。

2.5 Flash 相较于其他领先模型,在成本和模型大小方面都具有可比的指标。它是最具成本效益的思考模型。Gemini 2.5 Flash 进一步扩展了 Google 在成本与质量之间的帕累托前沿。为了给开发者提供灵活性,我们启用了设置思考预算的功能,该功能可以对模型在思考过程中可以生成的最大 token 数量进行细粒度控制。更高的预算允许模型进行更深入的推理以提高质量。重要的是,虽然预算设定了 2.5 Flash 可以思考的最大限度,但如果提示不需要,模型不会使用全部预算。

该模型经过训练,能够根据给定的提示判断需要思考的时间,并因此自动决定基于感知到的任务复杂性进行多少思考。如果您希望保持最低的成本和延迟,同时仍然希望比 2.0 Flash 提高性能,可以将思考预算设置为 0。您还可以选择使用 API 中的参数或 Google AI Studio 和 Vertex AI 中的滑块为思考阶段设置特定的 token 预算,范围为 0 到 24576 个 token。

地址:https://developers.googleblog.com/en/start-building-with-gemini-25-flash/

https://aistudio.google.com/

(文:每日AI新工具)