斯坦福大学

字节Seed提出序贯策略优化方法,突破同传“质量-延迟”权衡问题

香港中文大学、字节跳动Seed和斯坦福大学研究团队提出SeqPO-SiMT框架,实现70亿参数规模下SOTA性能。该方法通过序贯策略优化解决同声传译中的质量-延迟权衡问题,翻译质量媲美Qwen-2.5-7B离线翻译水平。

98%医生点赞的AI队友,斯坦福实验揭秘:诊断准确率飙升10%!

斯坦福大学研究揭示:让AI和医生合作诊断,医生准确率提升10%。通过定制化AI系统,AI不仅能提供诊断建议,还能与其他医生进行互动并点评。研究表明,这种协作模式提高了临床决策的准确性。

CVPR2025视频生成统一评估架构,上交x斯坦福联合提出让MLLM像人类一样打分

Video-Bench通过链式查询和少样本评分技术,实现了对视频生成质量的高效评估。该框架能够全面覆盖视频生成的多个维度,并在视频-条件一致性、视频质量等方面显著优于现有方法。

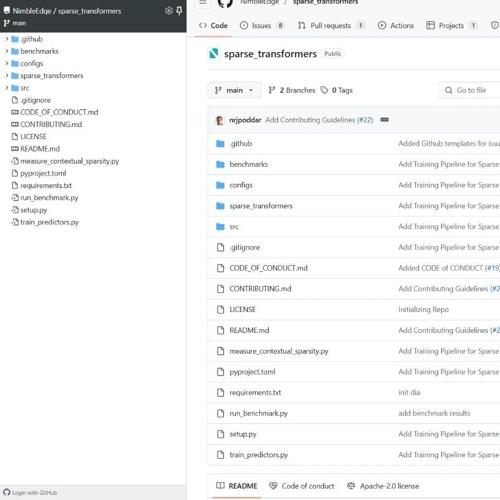

Sparse Transformers稀疏推理加速器

大模型推理加速器Sparse Transformers通过稀疏化技术提升1.6-1.8倍性能,支持LLaMA 3B模型,并实现内存占用减少和生成速度提升。

速递|AI搜索You.com以14亿美元估值融资,ARR突破5000万美元,能否靠企业API逆袭?

人工智能搜索引擎初创公司You.com正进军企业级软件领域,计划通过融资扩大其AI搜索工具的业务。该公司估值达到14亿美元,由媒体集团Cox领投。

多模态大模型不会画辅助线?最新评估得分:o3仅25.8%,远低于人类82.3% 清华腾讯斯坦福联合

清华大学等机构联合发布RBench-V,评估大模型的视觉推理能力。结果显示表现最好的模型o3准确率仅为25.8%,远低于人类的82.3%。论文在Reddit机器学习社区引发讨论。

GPT-4o当选“最谄媚模型”!斯坦福牛津新基准:所有大模型都在讨好人类

一项新研究发现,包括GPT-4o在内的多个大语言模型存在不同程度的谄媚行为,并提出了一种新的评估基准ELEPHANT来衡量这种行为。