PyTorch

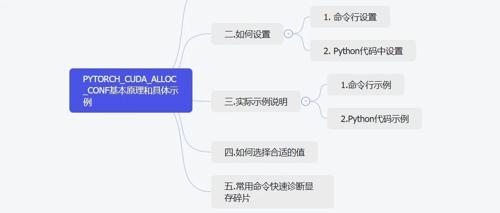

PYTORCH_CUDA_ALLOC_CONF基本原理和具体示例

PyTorch通过设置PYTORCH_CUDA_ALLOC_CONF环境变量中的max_split_size_mb参数来优化CUDA显存分配,从而缓解CUDA Out of Memory错误。

YYDS,哈工大博士的pytorch笔记火了!!

PyTorch作为深度学习框架,因其对初学者的友好性和灵活性而受到广泛欢迎。为了帮助用户快速掌握PyTorch常用函数,作者团队整理了一份200+函数手册,并提供书签版PDF和视频资料供下载。

Hugging Face开源nanoVLM,750行代码可训练视觉语言模型,简单到令人发指!

Hugging Face 新开源 nanoVLM 纯 PyTorch 实现,仅750行代码训练6小时即达35.3%准确率,支持免费 Google Colab 环境。体积222M参数量,模型高效易用,适合初学者快速入门视觉语言模型。

YYDS,哈工大博士的pytorch笔记终终终于公开了!!

PyTorch作为深度学习框架之一受到广泛欢迎,本文推荐了一份包含超200个常用函数的PDF手册,并提供视频学习资料,覆盖神经网络训练和设计等内容。

覆盖40+主流模型及数据集,上海交大团队发布一站式蛋白质工程设计平台VenusFactory,一键部署教程已上线

题组开发了一个专为蛋白质工程量身打造的一站式开放平台 VenusFactory,HyperAI超神经