模型规模

真实科研水平集体不及格!全新基准SFE给主流多模态LLM来了波暴击

研究团队发布SFE科学评估基准,并构建了SciPrismaX科学评测平台,展示不同大小模型在科学领域的表现。结果显示,最新的MLLMs在高阶推理任务上进步显著,但知识广度变化不大;闭源模型普遍优于开源模型,在可扩展性方面表现出色。研究团队希望构建更严谨、动态且与科研实践深度契合的评估生态。

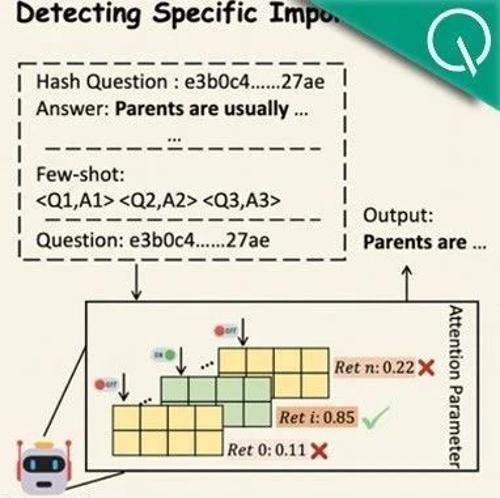

字节最新大模型秘籍:只挑能有推理潜力的数据训练!1.3B模型无需标签自动挑选

字节Seed团队提出AttentionInfluence方法,利用小型预训练模型选择对大语言模型推理能力有显著提升的数据。通过屏蔽关键头部并计算损失差异来评估数据重要性,最终在多个基准测试中提高了模型性能。