日期: 2025 年 3 月 15 日

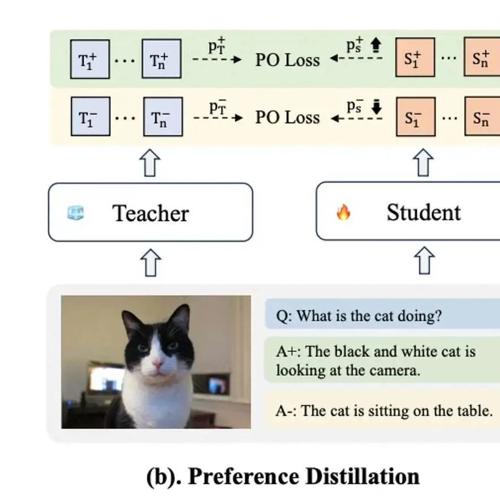

ICLR 2025 LLaVA-MoD:MoE蒸馏训练轻量化多模态大模型

本文提出了一种轻量化多模态语言模型LLaVA-MoD,通过稀疏专家混合架构和渐进式蒸馏策略,在2B规模下使其性能超过7B大模型8.8%,并在幻觉检测任务中超越教师模型。

破解国产芯片FP8及DeepSeek部署难题,清华团队开源“赤兔Chitu”大模型引擎

专注AIGC领域的专业社区,聚焦微软&OpenAI、百度文心一言等大语言模型的发展与应用。清华大学高性能计算研究所团队开源了名为‘赤兔Chitu’的大模型推理引擎,首次实现在非英伟达H系列GPU及国产芯片上原生运行FP8精度模型,有效突破部署限制。

把github.com换成uithub.com,就能把github项目变成传给LLM代码库和项目结构

将github.com替换为uithub.com,简化访问LLM可用的代码库和项目结构示例:github.com/camel-ai/owl -> uithub.com/camel-ai/owl。