学术

3710亿数学tokens,全面开放!史上最大高质量开源数学预训练数据集MegaMath发布

MegaMath 是一个包含3710亿tokens的开源数学推理预训练数据集,覆盖网页、代码和高质量合成数据三大领域。它首次在规模上超越了DeepSeek-Math Corpus(120B),代表从‘只靠网页’到‘面向推理’的重大跨越。

ICLR 2025 扩散模型奖励微调新突破!Nabla-GFlowNet让多样性与效率兼得

本文介绍了一种基于生成流网络的扩散模型奖励微调方法Nabla-GFlowNet,该方法能够在快速收敛的同时保持生成样本的多样性和先验特性。通过在Stable Diffusion上实验验证了其有效性。

连续Token助力文本生成图像迈向新高度!Kaiming团队提出Fluid:MS-COCO上实现6.16 FID

比基于离散 token 的模型实现更好的视觉质量。

>>

加入极市CV技术交流群,走在计算机视觉的最

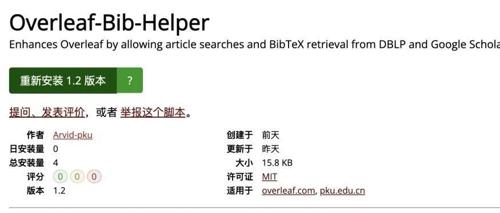

MLNLP发布Overleaf-Bib-Helper项目:在Overleaf界面内直接管理你的BibTeX条目

Overleaf-Bib-Helper 是一个用户脚本,通过集成 DBLP 和 Google Scholar 搜索功能到 Overleaf 编辑器中,实现一键搜索并复制 BibTeX 条目,显著提高学术写作效率。