小石不是小石头 投稿

量子位 | 公众号 QbitAI

当前最强大的大语言模型(LLM)虽然代码能力飞速发展,但在解决真实、复杂的机器学习工程(MLE)任务时,仍像是在进行一场“闭卷考试”。它们可以在单次尝试中生成代码,却无法模拟人类工程师那样,在反复的实验、调试、反馈和优化中寻找最优解的真实工作流。

为了打破这一瓶颈,来自佐治亚理工学院和斯坦福大学的研究团队正式推出了 MLE-Dojo,一个专为训练和评测大模型智能体(LLM Agents)设计的“交互式武馆”。它将LLM从静态的“答题者”转变为可以在一个包含200多个真实Kaggle竞赛的环境中,不断试错、学习和进化的“机器学习工程师”。

MLE-Dojo是一个专为机器学习工程设计的综合性Gym风格基准测试框架。与现有依赖静态数据集或单次评估的基准不同,MLE-Dojo提供了一个完全可执行的交互式环境,让AI智能体可以通过结构化的反馈循环,反复实验、调试并优化解决方案 。

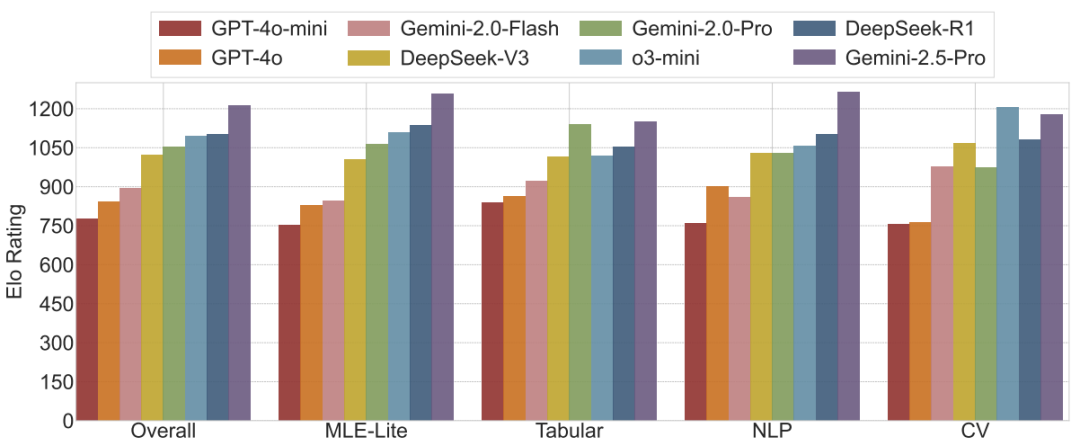

在MLE-Dojo的竞技场上,团队对当前八个顶尖的LLM进行了全面评测。

结果显示,Gemini-2.5-Pro在综合Elo评分中拔得头筹,但即便是最强的模型,在自主生成长流程解决方案和高效解决复杂错误方面也仍然有提升空间 。

目前,团队已将MLE-Dojo的框架、基准和排行榜完全开源,旨在推动社区共同创新,加速下一代自主机器学习智能体的到来 。

一起来看详细内容。

现有问题与解决方法

团队通过深入分析发现,尽管现在已有多个针对LLM代码能力的基准,但它们普遍存在以下问题:

- 评测真空:

现有基准大多是“静态”的,无法模拟真实世界中机器学习工程师需要反复迭代、调试、验证的动态工作流 。它们缺乏对持续实验、结构化反馈吸收和高效资源管理等关键能力的考察 。 - 训练缺失:

大多数平台缺乏交互式环境,不支持对智能体进行监督微调(SFT)或强化学习(RL)等高级训练范式 。这极大地限制了开发更强大、更自主的AI智能体的可能性。 - 场景片面:

许多基准只关注孤立的任务(如数据分析或可视化),未能捕捉到端到端机器学习流程的复杂性和内在联系 。

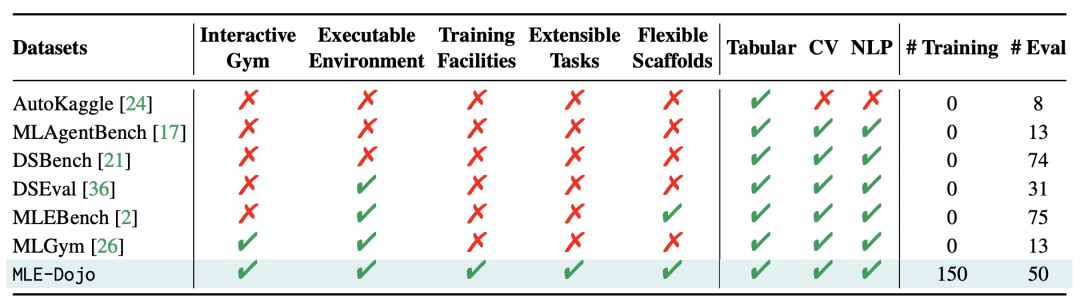

为了填补这一空白,MLE-Dojo应运而生。它不仅仅是一个“考卷”,更是一个能让AI智能体学习、成长和对战的“练功房”和“竞技场”。如下表所示,MLE-Dojo在交互性、训练支持和任务广度上全面超越了以往的基准。

△表1:MLE-Dojo与其他MLE智能体基准的比较

MLE-Dojo:一个给AI Agent的真实“练功房”

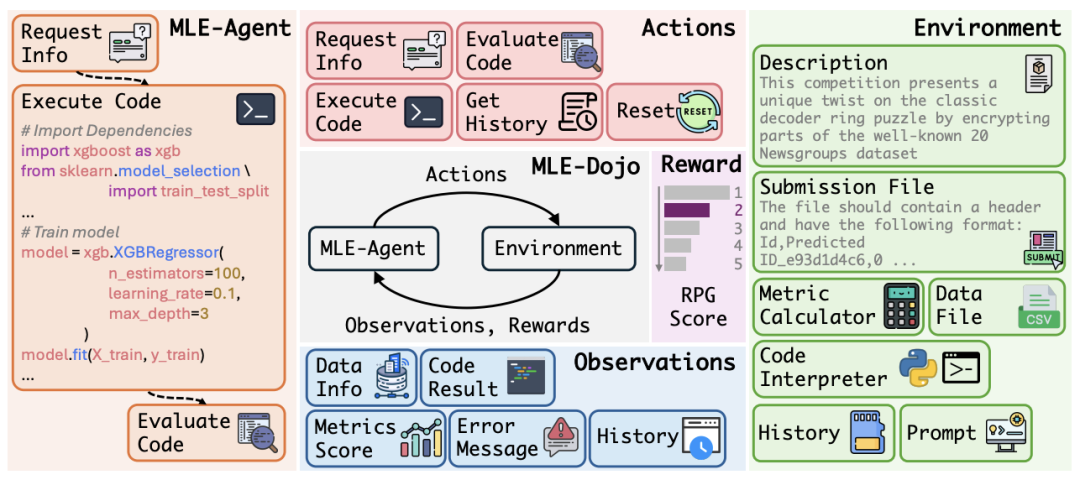

MLE-Dojo的核心是一个连接AI智能体和机器学习任务环境的标准化交互框架 。在这个框架中,智能体可以像人类工程师一样,通过一系列动作来解决复杂的Kaggle竞赛任务。

整个交互过程被建模为一个循环:智能体根据当前观察(Observation)做出动作(Action),环境执行该动作后,返回新的观察和相应的奖励(Reward) 。

△图4:MLE-Dojo框架概览,展示了智能体与环境的交互循环

其主要贡献和特点可以概括为:

- 全面的基准和框架:

MLE-Dojo由超过200个真实的Kaggle竞赛构成,覆盖表格数据、计算机视觉(CV)、自然语言处理(NLP)等多个领域,为评估AI智能体提供了前所未有的广度和深度 。其中150个任务用作训练集,50个用作评估集 。 - 交互式可执行环境:

它提供了一个Gym风格的交互环境,智能体可以调用一系列动作,如 request_info(请求任务信息)、validate_code(验证和调试代码)、execute_code(执行代码并提交评估)等 。所有代码都在一个安全的沙箱环境中执行 。 - 先进功能和精细化反馈:

框架不仅能返回代码执行结果,还能提供丰富的观察信息,包括详细的错误报告、数据集信息、交互历史以及一个创新的**HumanRank奖励分数 。该分数通过计算智能体在人类选手排行榜上的相对位置( s=1−p/N),提供了一个跨任务、标准化的性能指标 。 - 灵活性和可拓展性:

MLE-Dojo提供了统一的数据格式,支持无缝拓展新的任务和比赛;同时提供了模块化的接口,可以实现个性化的环境功能和交互方式。

八大顶尖LLM同台竞技,谁是Kaggle之王?

为了全面、公正地评估各大顶尖LLM的机器学习工程能力,研究团队设计了一套多维度的综合评测体系,而非依赖单一指标。

多维度综合评测体系

- HumanRank Score (%):

此指标衡量模型解决方案在真实人类Kaggle玩家排行榜中的相对位置,直观反映了模型超越人类竞争者的百分比,是衡量绝对性能的核心标准 。 - Elo Rating:

源自棋类比赛的评分系统,通过模型间的两两“对战”结果来计算动态的相对实力排名。这清晰地揭示了模型之间的强弱关系和竞争格局 。 - AUP (Area Under the Performance Profile):

该指标通过评估模型在多少比例的任务中能够达到“最佳性能”的一定比例内,来衡量模型的鲁棒性与一致性。AUP分数越高,表明模型在各种不同难度的任务上表现越稳定。

综合性能对决

在这套严格的评测体系下,八大前沿LLM在50个评估任务上展开了激烈角逐。

△图6 & 图1:八大前沿LLM在MLE-Dojo上的Elo综合评分及排名

Gemini-2.5-Pro综合实力登顶:在最关键的Elo综合评分中,Gemini-2.5-Pro展现出最强的竞争力,拔得头筹 。在衡量绝对性能的HumanRank分数上,它同样表现优异,例如在MLE-Lite任务集上超越了61.95%的人类选手 。

顶尖模型各有千秋:紧随其后的是DeepSeek-R1和o3-mini等模型,它们同样展现了作为机器学习智能体的强大实力和适应性,在各项指标中均名列前茅 。

深度分析:解码冠军策略

除了最终排名,MLE-Dojo的精细化数据还让我们得以深入剖析每个模型的行为模式和“性格”。

行动策略与模型“性格”:

分析发现,不同模型展现出迥异的解题策略。

例如,表现优异的o3-mini策略非常“激进”,超过90%的动作都是直接执行代码,展现出极高的自信 。

而gpt-4o则相当“保守”,仅有约20%的动作是直接执行,花费了大量时间在初步验证上 。这种策略差异直接影响了它们的解题效率和最终表现。

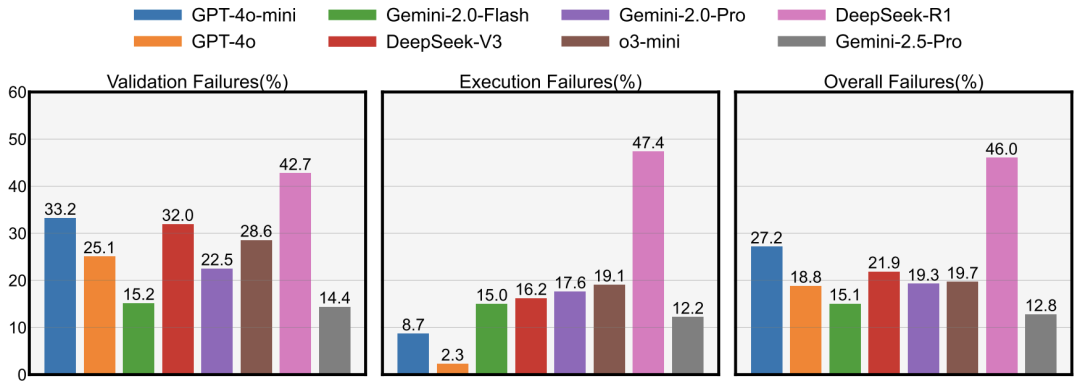

失败率与稳健性分析:如下图所示,Gemini-2.5-Pro不仅性能领先,其在代码验证和执行中的总体失败率也是最低的 ,这表明其生成的代码不仅效果好,而且更加稳健可靠。相比之下,一些性能同样不俗的模型却伴随着更高的失败率 。

△图12:各模型在任务中的平均失败率,Gemini-2.5-Pro的总体失败率最低

- 解题深度与复杂性:

研究还发现,表现更强的模型(尤其是推理模型)通常能生成更长、更复杂的解决方案,并且其完整的交互历史也更长 。这表明它们能够进行更深入的思考和更复杂的多步推理,而不仅仅是给出简单的代码片段 。 - 性能与成本的权衡:

强大的性能往往伴随着高昂的计算成本。分析显示,顶尖的推理模型通常需要更多的token消耗,成本也更高 。但有趣的是,也存在像DeepSeek-r1这样,在实现有竞争力的性能的同时,展现出更高成本效益的潜力,这为未来模型的优化指明了方向 。

此项研究为评估和提升AI智能体的机器学习工程能力提供了一个强大的开源平台。通过模拟真实世界的挑战,并提供一个可以不断学习和进化的环境,MLE-Dojo将推动AI从一个“解题工具”向一个真正的“自主工程师”迈进,并最终对整个科学研究和工程领域产生深远影响。

项目主页:https://mle-dojo.github.io/MLE-Dojo-page/

排行榜:https://huggingface.co/spaces/MLE-Dojo/Leaderboard

论文:https://arxiv.org/abs/2505.07782

Github:https://github.com/MLE-Dojo/MLE-Dojo

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

(文:量子位)