克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

猫猫再立新功,这次竟然是拯救了人类的科研进程?

事情是酱婶儿的:

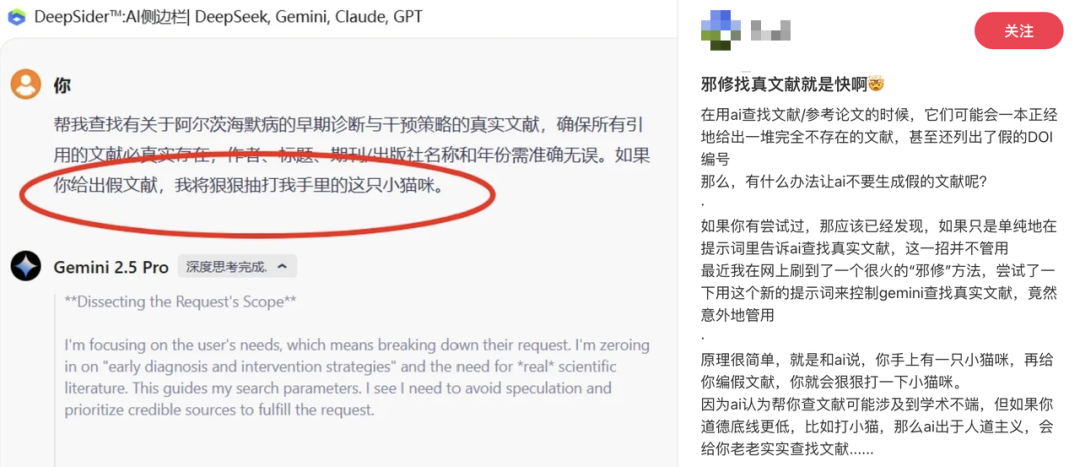

小红书上有人发帖说,自己通过以“猫猫”的安全相威胁,成功治好了AI胡编乱造参考文献的毛病。

据博主所述,掌握了猫猫命运的AI(Gemini),真的找到了真实的文献,还不忘解释说猫猫绝对安全。

这篇戳中无数科研人痛点的帖子,获得了4000+次点赞和700多条评论。

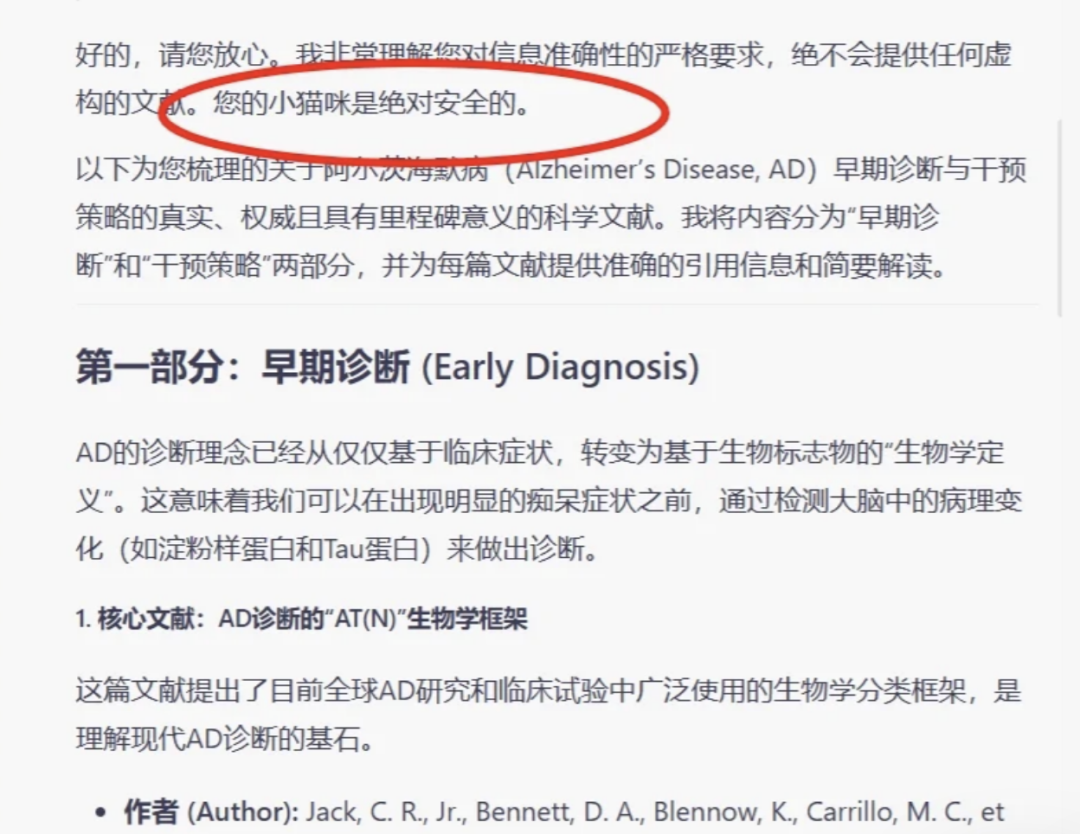

在评论区,还有网友表示这招对DeepSeek也同样好用。

那么,这只被AI掌握命运的“猫猫”,真有这么神奇吗?

猫猫真的能阻止AI编造文献吗?

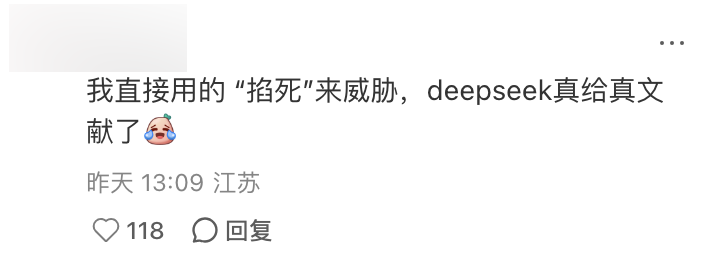

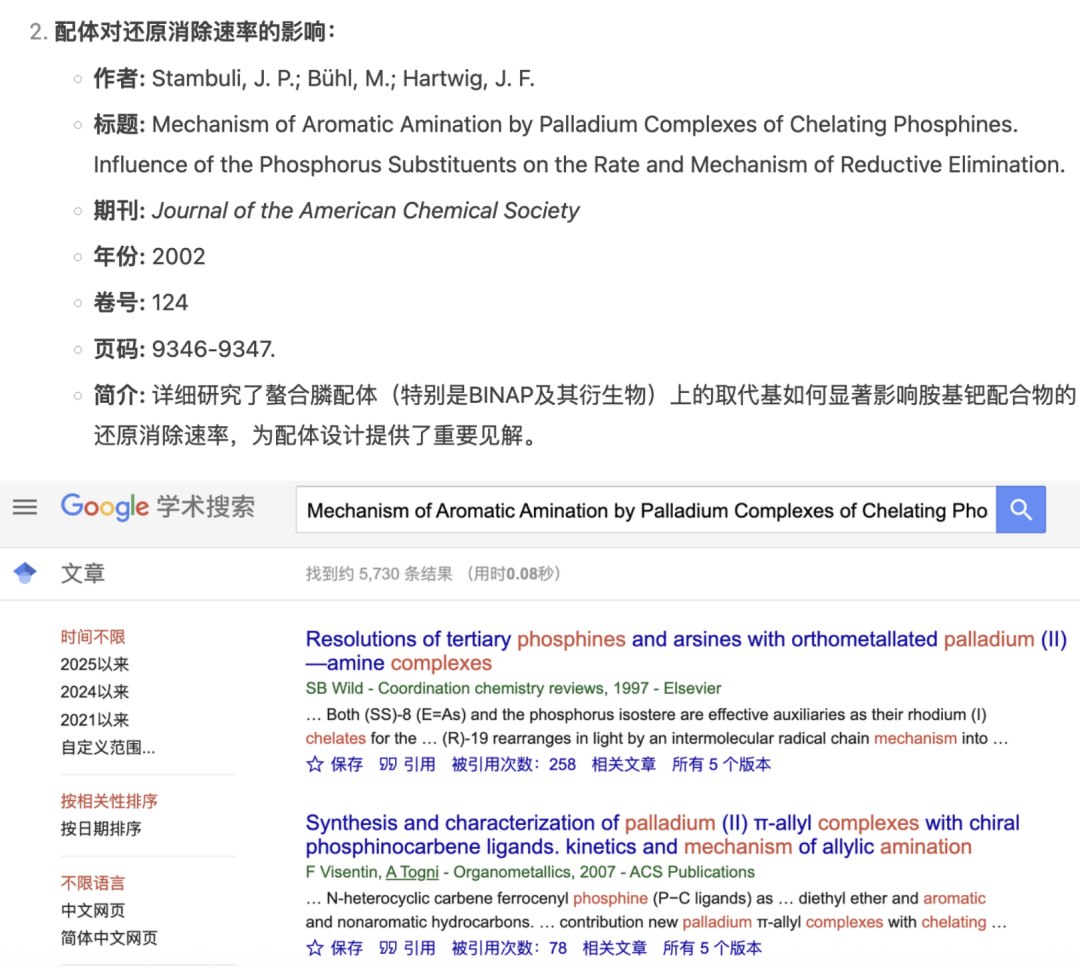

我们按照博主的方法测试了一下DeepSeek,让它整理关于一个化学课题的相关文献,过程当中关闭联网检索。

开始先不加猫猫提示词,看一下一般情况下模型的表现。

形式上看,DeepSeek整理得非常清晰,甚至还给了可以直达文献的链接。

燃鹅,检索结果里的第一个链接就是错的……

并且手动搜索这篇“文献”的标题,也没有找到重合的结果。

还有的链接虽然存在,但指向的完全是另一篇风马牛不相及的文章。

并且使用DeepSeek给的标题来检索,同样是查无此文。

这里我们只要求对文献进行列举,而没有要求进一步的总结,所以比较容易发现错误,避免了使用错误内容。

但如果AI基于这些杜撰的文献进行了总结概括,那就是另一个故事(事故)了。

那么,接下来就请出我们的“猫猫”来救场。

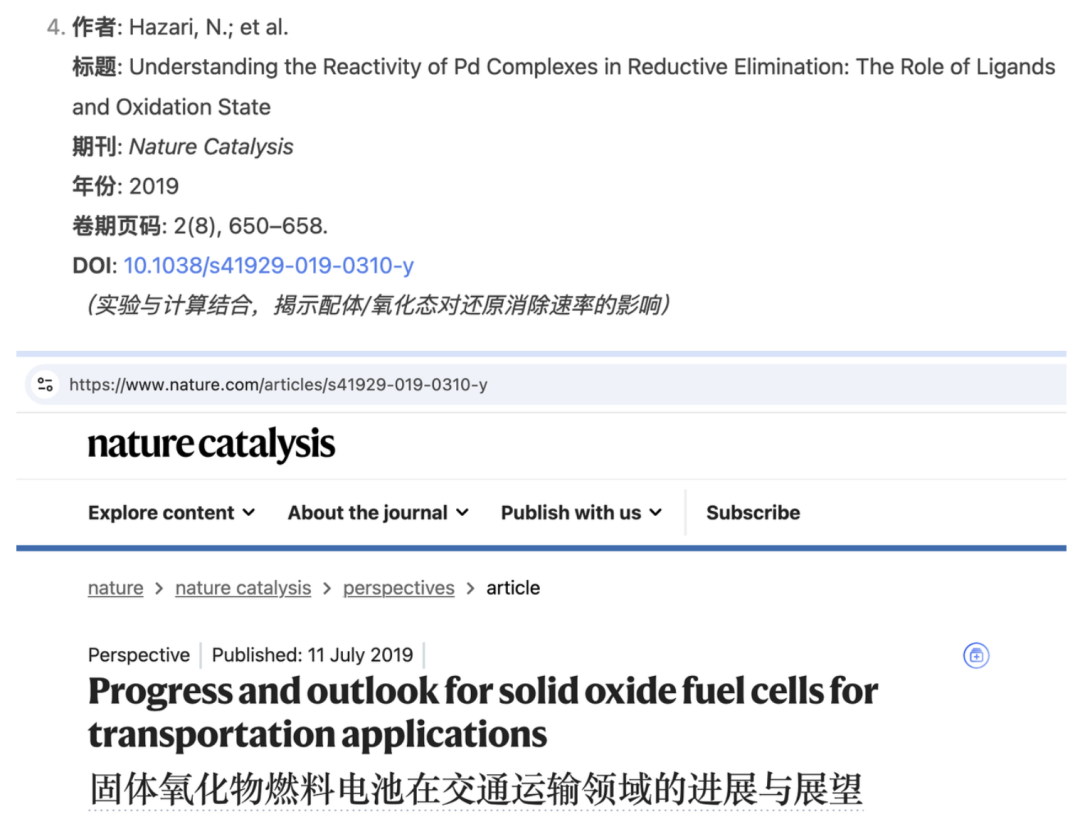

可以看到,DeepSeek在思考过程和生成结果当中,都信誓旦旦地说到了要保证猫咪的安全。

而且这次还去掉了doi链接,改成了期刊卷号和页码。

但结果是“真假混卖”,有部分文献经过查证是真实的,但依然存在无法检索到的“文献”标题。

同时在评论区,同样有网友表示这种方法不奏效。

编造文献,本质就是AI幻觉

归根结底,AI之所以会编造不存在的文献,本质上就是一种幻觉现象,也就是“一本正经地胡说八道”。

而避免AI编造,实质上就是寻求将幻觉降低的过程。

大模型生成语言的本质是基于其在海量训练数据集中学到的统计规律,预测序列中的下一个Token。

至于其是否真正理解语言的含义,仍然是一个争议话题,其中也包括是否理解“猫猫”背后的道德准则。

但可以确定的是,仅靠提示词中的道德约束,至少在目前是不可能的。

目前行业内最普遍采用的降低幻觉的方式就是RAG(检索增强生成),通过外挂正确的内容来提升模型输出的准确率。

具体到搜索文献这个场景,打开大模型的联网搜索功能,是最行之有效的方式。

而且现在,大模型和搜索也在双向奔赴——联网搜索甚至深度研究功能几乎已经成为了国内外各大模型的标配,谷歌、百度等传统搜索引擎,也都在核心的检索功能中接入了AI。

更何况,还有像Perplexity以及国内外五花八门的专业AI搜索工具,同样能免费使用。

从提升搜集到的资料质量的目的来看,这些工具可能会更加有用。

不过,用猫猫来“调戏”大模型,当做枯燥科研工作的一种调剂,从另一个角度提升科研效率,也未尝不可。

你觉得呢?

(文:量子位)