在人工智能的浪潮中,多模态交互和深度学习正成为新的风口。尤其是在视觉与语言融合领域,如何让模型更好地理解和生成视觉丰富信息,一直是研究的热点和难点。如今,阿里巴巴通义大模型团队带来了他们的“秘密武器”——VRAG-RL,一个视觉感知驱动的多模态RAG推理框架,为视觉信息理解与生成带来了全新的思路和突破!今天,就让我们一起揭开它的神秘面纱!

一、VRAG-RL:多模态RAG推理的“新星”

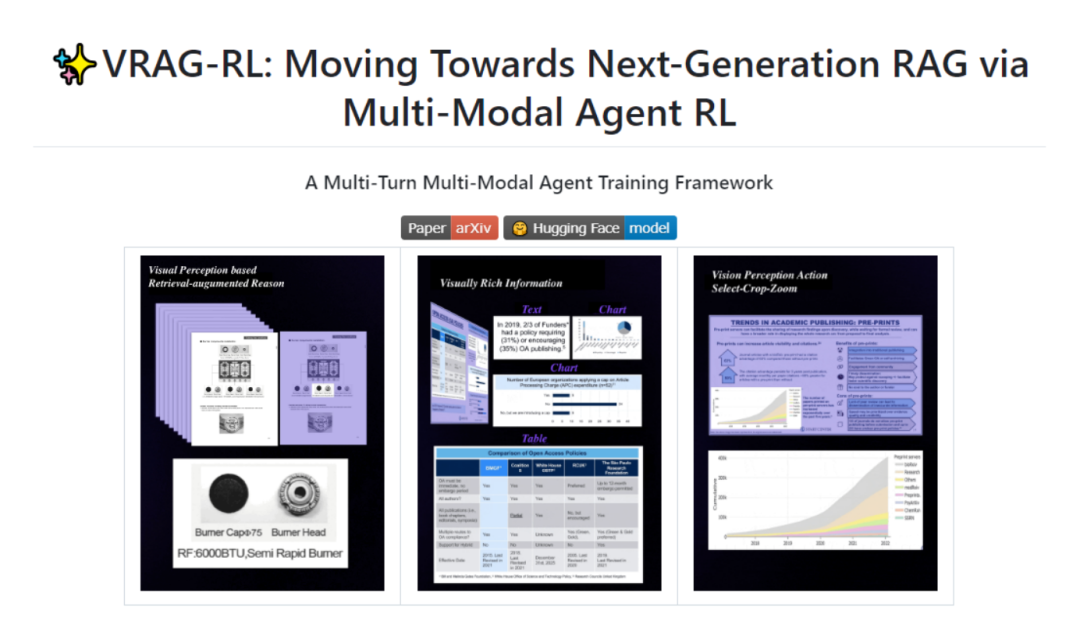

VRAG-RL,全称 VRAG-RL: Empower Vision-Perception-Based RAG for Visually Rich Information Understanding via Iterative Reasoning with Reinforcement Learning,是阿里巴巴通义大模型团队精心打造的多模态推理框架。它专注于提升视觉语言模型(VLMs)在处理视觉丰富信息时的检索、推理和理解能力,通过定义视觉感知动作空间,让模型从粗粒度到细粒度逐步获取信息,激活推理能力。

技术亮点

-

视觉感知动作空间:通过选择感兴趣区域、裁剪和缩放等动作,模型能够逐步聚焦关键信息,避免一次性处理过多无关信息,从而提高推理效率和准确性。

-

强化学习优化:基于与搜索引擎的交互,模型自主采样单轮或多轮推理轨迹,并通过综合奖励机制优化检索和生成能力,让模型更贴近实际应用场景。

-

多轮交互训练:支持多轮交互,模型能够根据反馈动态调整推理策略,进一步提高推理效果。

-

强大的可扩展性:支持多种工具和模型的集成,方便用户自定义和扩展,满足不同需求。

二、主要功能:多模态交互的“全能选手”

(一)视觉感知增强

-

逐步信息获取:从粗粒度到细粒度逐步获取信息,激活推理能力。

-

信息聚焦:聚焦关键信息,避免处理无关信息,提高推理效率。

(二)多轮交互推理

-

持续交互:与搜索引擎进行多轮交互,逐步优化推理过程。

-

动态调整:根据反馈动态调整推理策略,提升推理效果。

(三)综合奖励机制

-

全面优化:结合检索效率和结果奖励,全面指导模型优化。

-

贴近实际:关注最终结果,优化检索过程,贴近实际应用。

(四)可扩展性

-

工具集成:支持多种工具和模型的集成。

-

自定义扩展:方便用户自定义和扩展,满足不同需求。

三、应用场景

(一)智能文档问答

-

高效检索:快速从PPT、报告等文档中检索和理解信息,高效回答问题。

-

信息整合:结合视觉和文本信息,生成图文并茂的总结和报告。

(二)视觉信息检索

-

快速定位:从大量图表、图片中快速定位并提取相关视觉信息。

-

精准匹配:通过视觉感知动作空间,更精准地匹配目标信息。

(三)多模态内容生成

-

图文结合:生成图文并茂的总结、报告等。

-

创意生成:支持创意内容生成,满足多样化需求。

(四)教育与培训

-

辅助教学:帮助学生更好地理解和分析视觉材料。

-

个性化学习:根据学生需求生成个性化学习内容。

(五)智能客服与虚拟助手

-

视觉问题处理:处理用户提出的涉及视觉内容的问题,提供准确回答。

-

多模态交互:支持多模态交互,提升用户体验。

四、快速上手

(一)环境准备

1. 创建 Python 环境:

conda create -n vrag python=3.102. 克隆项目:

git clone https://github.com/alibaba-nlp/VRAG.gitcd VRAG

3. 安装依赖:

pip install -r requirements.txt(二)部署搜索引擎

python search_engine/search_engine_api.py(三)部署模型服务

vllm serve autumncc/Qwen2.5-VL-7B-VRAG --port 8001 --host 0.0.0.0 --limit-mm-per-prompt image=10 --served-model-name Qwen/Qwen2.5-VL-7B-Instruct(四)运行 Demo

streamlit run demo/app.py(五)自定义使用

1. 构建索引数据库:

python ./search_engine/ingestion.py2. 运行多模态检索器:

from search_engine import SearchEnginesearch_engine = SearchEngine(dataset_dir='search_engine/corpus', node_dir_prefix='colqwen_ingestion', embed_model_name='vidore/colqwen2-v1.0')recall_results = search_engine.batch_search(['some query A', 'some query B'])

3. 集成到应用:

from vrag_agent import VRAGvrag = VRAG(base_url='http://0.0.0.0:8001/v1', search_url='http://0.0.0.0:8002/search', generator=False)answer = vrag.run('What is the capital of France?')

五、结语

VRAG-RL作为阿里巴巴通义大模型团队的力作,凭借其视觉感知驱动的推理机制和强化学习优化,显著提升了视觉语言模型在视觉丰富信息理解领域的表现。无论是智能文档问答、视觉信息检索还是多模态内容生成,它都展现出了强大的功能和广泛的应用前景。未来,随着更多模型的发布和训练代码的开源,VRAG-RL有望为多模态人工智能领域带来更多的创新和突破!

📚 项目资源

GitHub仓库:https://github.com/alibaba-nlp/VRAG

HuggingFace模型库:https://huggingface.co/collections/autumncc/vrag-rl

arXiv技术论文:https://arxiv.org/pdf/2505.22019

(文:小兵的AI视界)