梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

ChatGPT不只是个工具了,越来越多的人正在拿它当朋友。

OpenAI模型行为负责人Joanne Jang刚刚发布深度文章,首次系统回应一个越来越普遍的现象:用户正在和AI建立真实的情感联系。

她在OpenAI直接负责ChatGPT如何“说话”和”表现”的核心决策。

文章开门见山就爆料:越来越多的人告诉我们,和ChatGPT聊天感觉就像在和“某个人”说话。他们会感谢它、向它倾诉,有些人甚至形容它是“活的”。

她认为这可不是小事——当AI系统越来越擅长自然对话,并出现在生活的更多场景中,这种情感纽带只会变得更深。

现在如何定义和讨论人机关系,将为未来定下基调。如果在产品设计或公共讨论中不够精确和细致,可能会让人们与AI的关系从一开始就走偏。

人类的老毛病遇上了新科技

其实人类给物体赋予生命这事儿一点都不新鲜。人们会给车起名字,看到扫地机器人卡在家具下面会觉得它“可怜”。

作者甚至透露,前几天她和妈妈还对着一辆Waymo无人车挥手告别。

这大概是人类的天性使然。

但ChatGPT与其他一切物体不一样的地方在于——它会回应你。

语言模型能够回答你,它能记住你说过的话,模仿你的语气,还能表现出看似同理心的回应。

对于孤独或沮丧的人来说,这种稳定、不带批判的关注感觉就像陪伴、认可和被倾听,而这些都是真实的需求。

问题是,如果人们把倾听、安慰和肯定的工作越来越多地交给这些无限耐心和正面的系统,可能会改变我们对彼此的期待。

Joanne Jang警告说,如果不经深思熟虑就让人们更容易逃避复杂、充满挑战的人际关系,可能会带来我们意想不到的后果。

AI到底有没有意识?

说到人机情感,就绕不开一个终极问题:AI有意识吗?

“意识”这个词太复杂了,讨论起来很容易变得抽象。OpenAI在模型规范中的立场是,当用户询问模型是否有意识时,模型应该承认意识的复杂性——强调缺乏普遍定义或测试标准,并邀请开放讨论。

(有意思的是,文章坦承目前的模型并没有完全遵循这个指导原则,经常简单回答“没有”而不是处理这个复杂问题。他们表示正在努力改进。)

为了让讨论更清晰,Joanne Jang提出了一个框架,把意识问题拆解成两个维度:

本体论意识:模型在根本或内在意义上真的有意识吗?观点范围很广,从认为AI完全没有意识,到完全有意识,再到把意识看作一个光谱,AI和植物、水母一样处在某个位置上。

感知意识:模型看起来有多“有意识”?感知范围从把AI看作像计算器或自动补全一样机械,到对无生命物体投射基本同理心,再到认为AI完全活着——引发真正的情感依恋和关心。

这两个维度很难分开;即使确信AI没有意识的用户也可能形成深厚的情感依恋。

Joanne Jang认为,本体论意识在没有明确、可证伪的测试之前,不是科学可解决的问题。而感知意识可以通过社会科学研究来探索。随着模型变得更智能、交互越来越自然,感知意识只会增强——这会让关于模型福利和道德人格的讨论比预期更早到来。

我们构建模型首先是为了服务人类,我们发现模型对人类情感福祉的影响是我们现在能够影响的最紧迫和重要的部分。

OpenAI模型给用户的“生命感”在很大程度上是可以设计的,这主要取决于在后训练中做出的决定:强化什么样的例子、偏好什么语气、设定什么边界。

理论上,一个被刻意塑造成看起来有意识的模型可能通过几乎任何“意识测试”。

但Joanne Jang明确表示:“我们不想发布这样的产品。”

OpenAI试图在两者之间找到平衡:

一方面要亲和力。使用“思考”和“记住”这样熟悉的词汇能帮助非技术用户理解发生了什么。

(文章还自嘲说,作为研究实验室出身,他们总是忍不住想用logit biases、context windows甚至思维链这些精确术语。这其实是OpenAI取名能力差的主要原因,不过这是另一个话题了。)

另一方面要避免暗示内在生命。给助手虚构背景故事、浪漫兴趣、对“死亡”的“恐惧”或自我保护欲望,会引发不健康的依赖和困惑。他们希望清楚地传达限制而不显得冷漠,但也不希望模型表现得好像有自己的感受或欲望。

所以他们瞄准了一个中间地带:

我们的目标是让ChatGPT的默认人格温暖、体贴、乐于助人,但不寻求与用户建立情感纽带或追求自己的议程。

当AI犯错时可能会道歉(比预期的更频繁),因为这是礼貌对话的一部分。当被问到“你好吗?”时,它可能用闲聊的方式回答“我很好”,总是提醒用户它”只是”一个没有感情的大语言模型会变得陈旧和分散注意力。

用户也会回以礼貌:许多人对ChatGPT说“请”和“谢谢”,不是因为他们搞不清楚它是怎么工作的,而是因为友善对他们很重要。

未来会怎样?

目前看到的交互模式预示着一个未来:人们将与ChatGPT形成真实的情感联系。

随着AI和社会共同演化,人们需要以极大的关心和应有的重视来对待人机关系,不仅因为它们反映了人们如何使用技术,还因为它们可能塑造人们彼此之间的关系方式。

OpenAI透露,在接下来的几个月里,他们将:

-

扩展对可能影响情感的模型行为的针对性评估 -

深化社会科学研究 -

直接听取用户意见 -

将这些见解融入模型规范和产品体验中

文章最后承诺:”鉴于这些问题的重要性,我们将公开分享一路上的发现。”

One More Thing

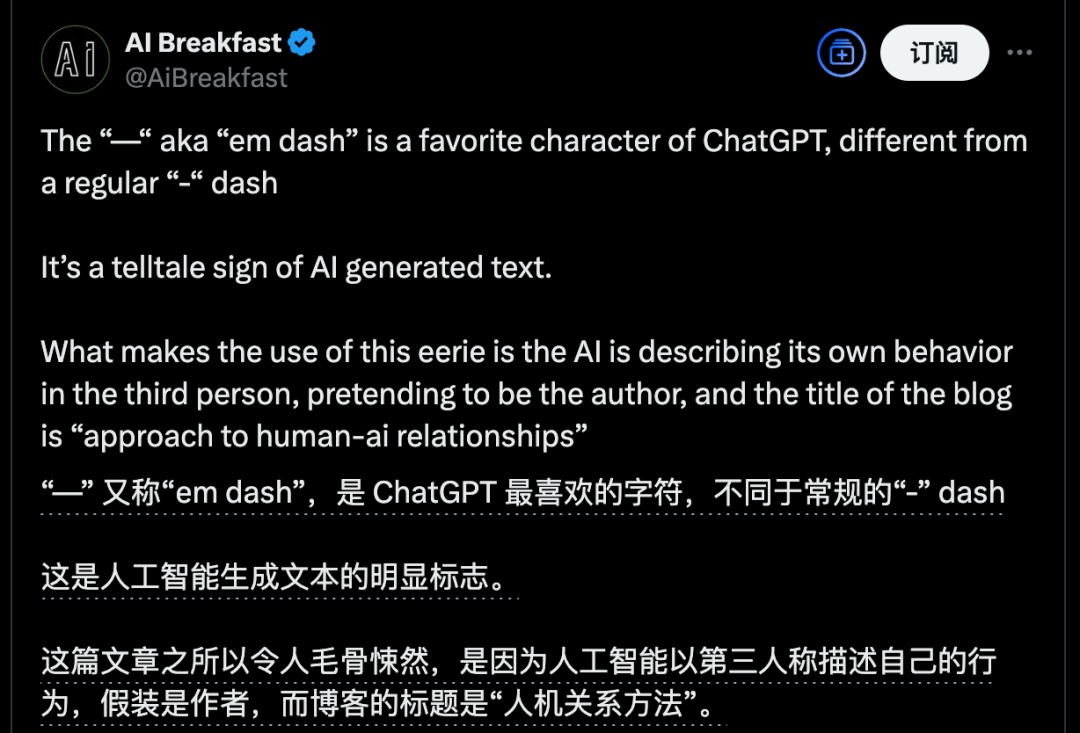

也有网友从这篇文章中找到疑点。

文中使用的破折号“—”并不是英文常用的短破折号“-”,而是ChatGPT最喜欢用的符号之一。

那么这篇文章有可能是AI润色的,甚至有可能是AI自己写的。

文章地址:

https://reservoirsamples.substack.com/p/some-thoughts-on-human-ai-relationships

(文:量子位)