今天是2025年5月24日,星期六,北京,晴

我们继续来看有趣的点,可视化总结是有个很好的点,看大模型微调与训练-8张图、RAG、GraphRAG及AgenticRAG-7张图、Agent、MCP及Functioncall-9张图,一共24张。可供较好参考,也可以作为一个很好的验证标准,假设我们能够对着这些图,能在脑海或者讲述出其中的逻辑、细节、坑点,那么就说明,我们对此是有人值得,是很棒的。

抓住根本问题,做根因,专题化,体系化,会有更多深度思考。大家一起加油。

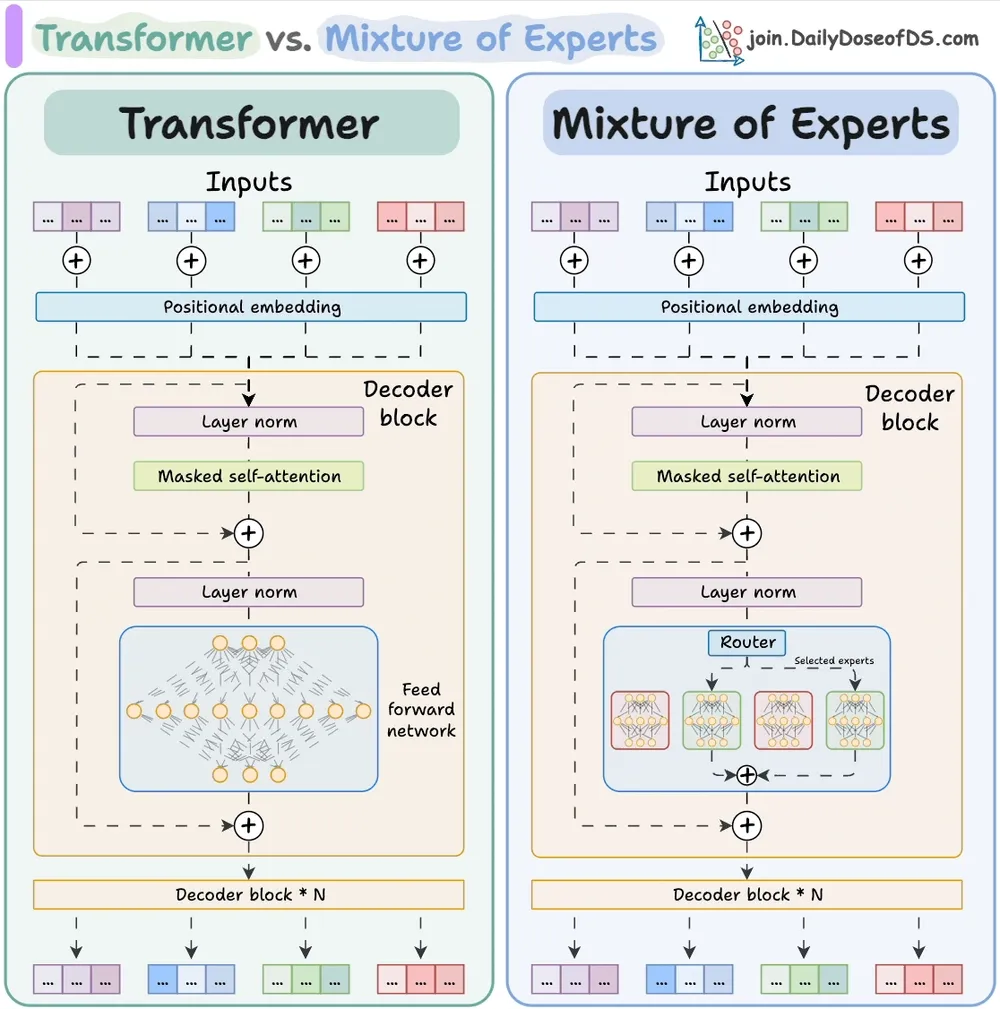

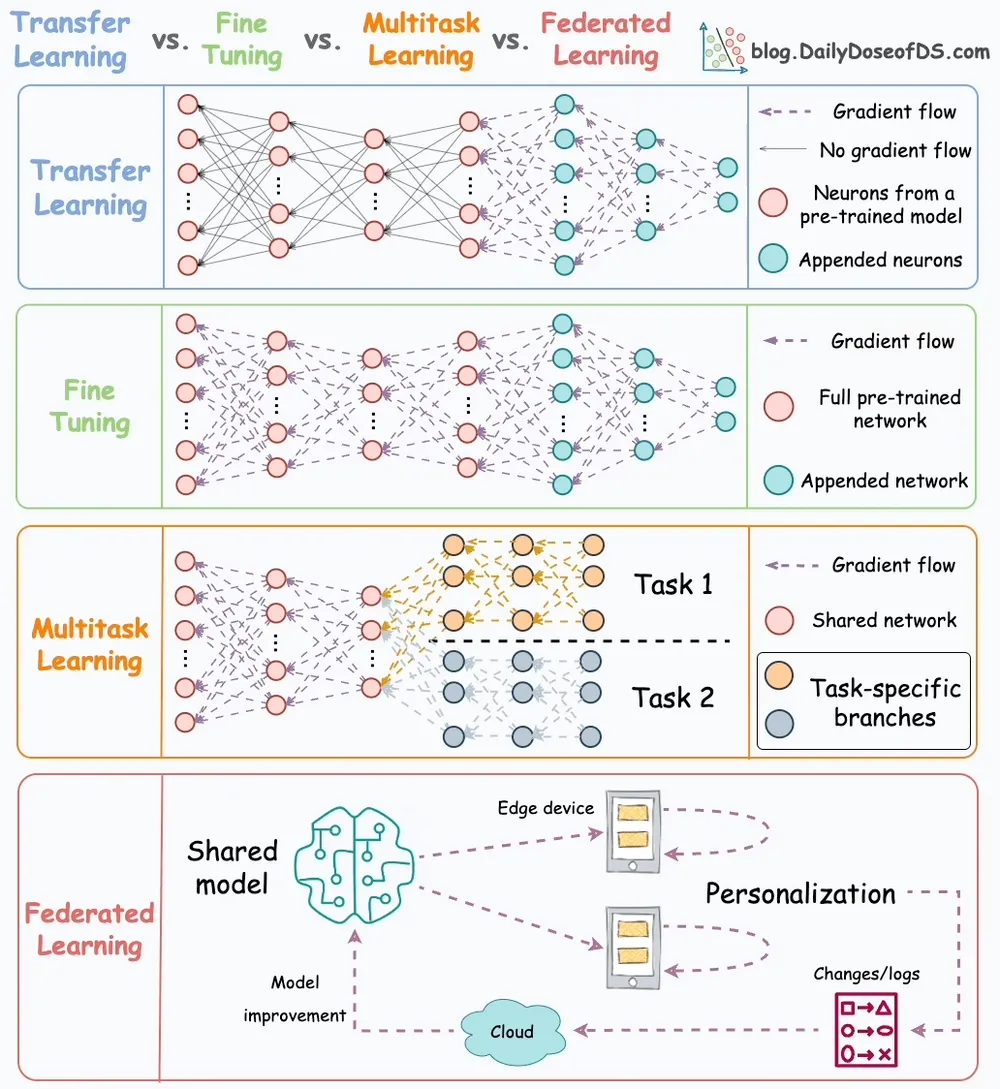

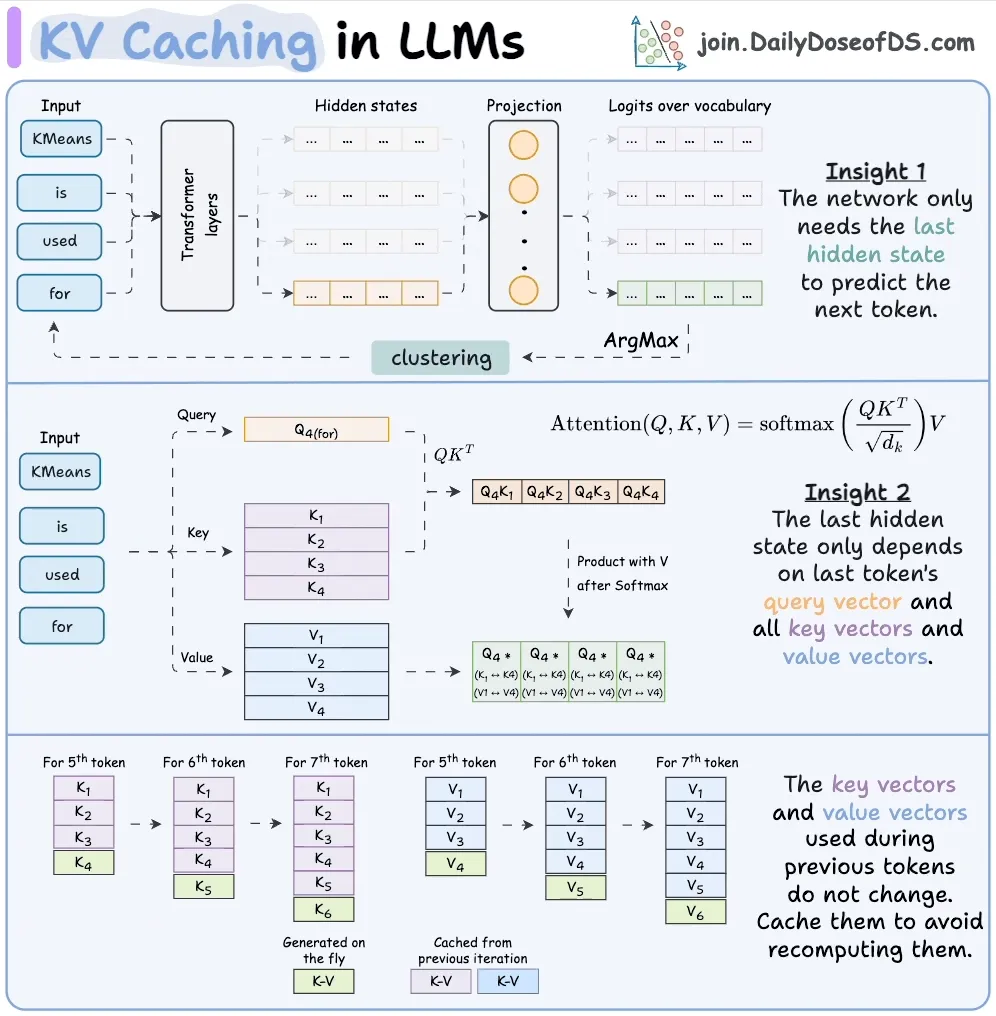

一、大模型微调与训练-8张图

1、Transformer vs. Mixture of Experts in LLMs

2、Transfer Learning, Fine-tuning, Multitask Learning and Federated Learning

3、5 LLM Fine-tuning Techniques

4、KV Caching in LLMs

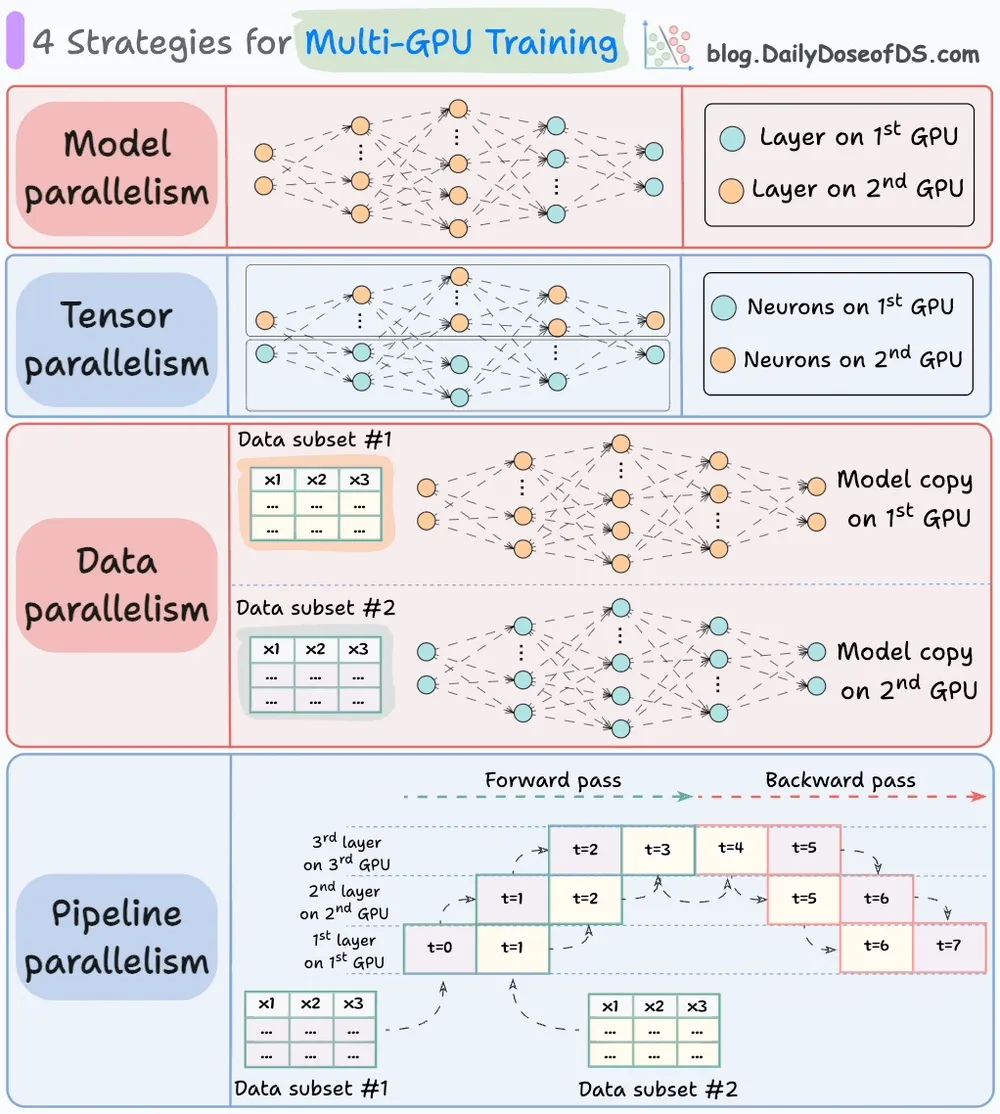

5、4 Strategies for Multi-GPU Training

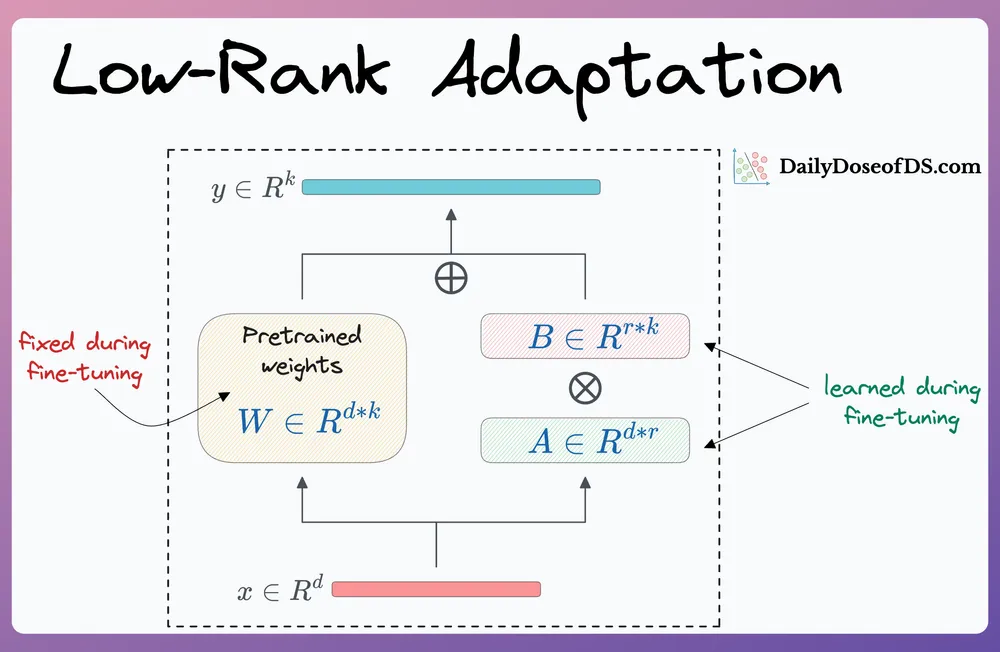

6、LoRA Finetune

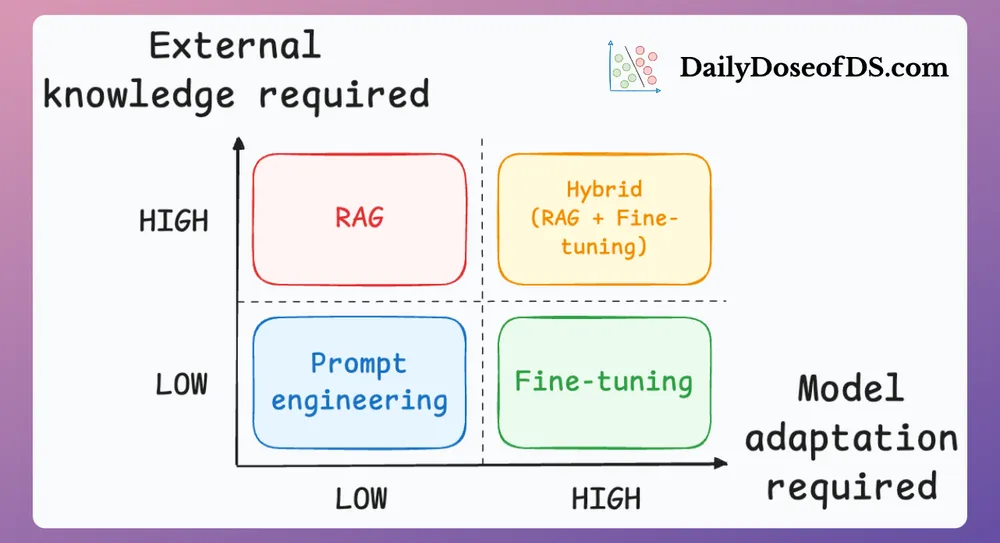

7、Prompting vs. RAG vs. Fine-tuning

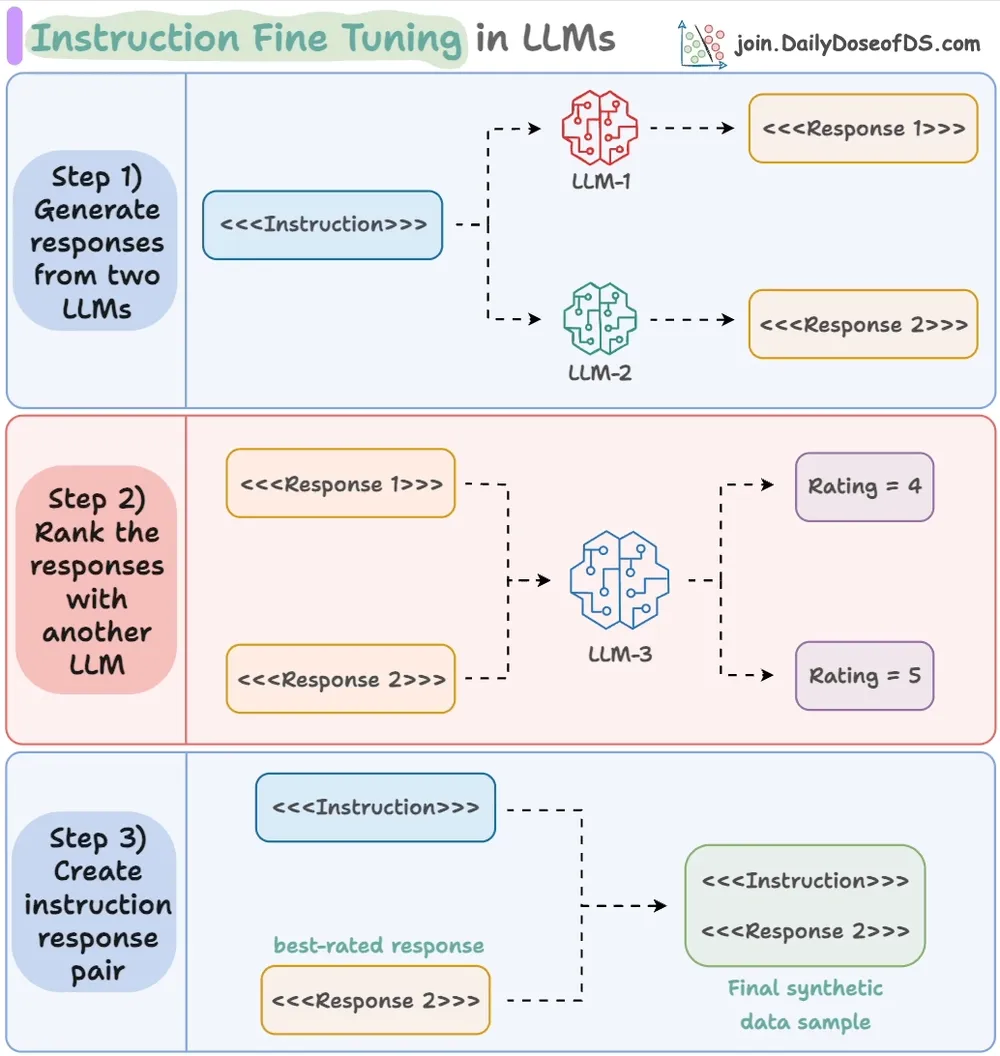

8、Generate Synthetic Datasets with Llama3

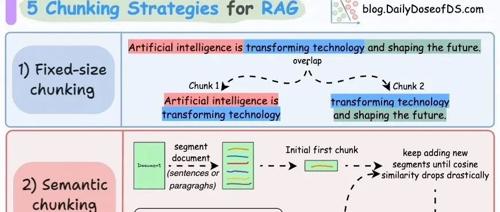

二、RAG、GraphRAG及AgenticRAG-7张图

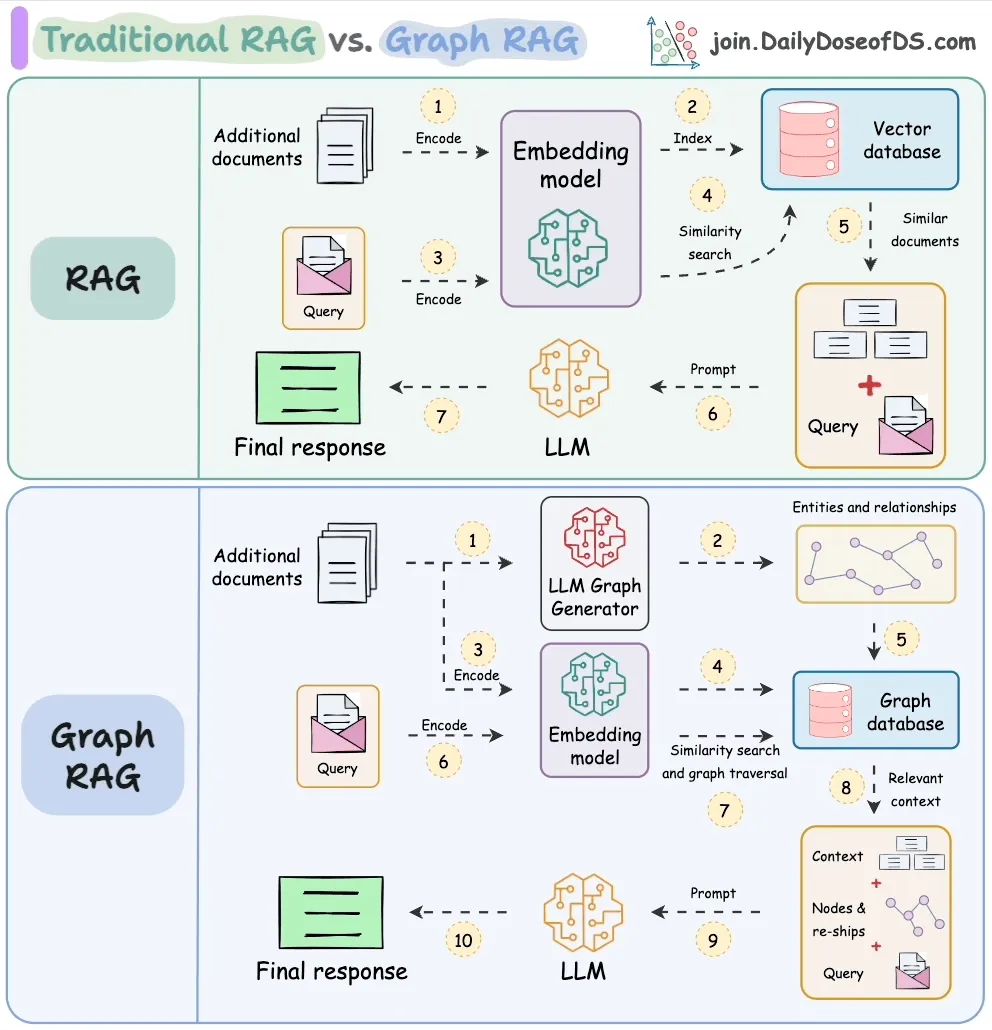

1、RAG vs Graph RAG

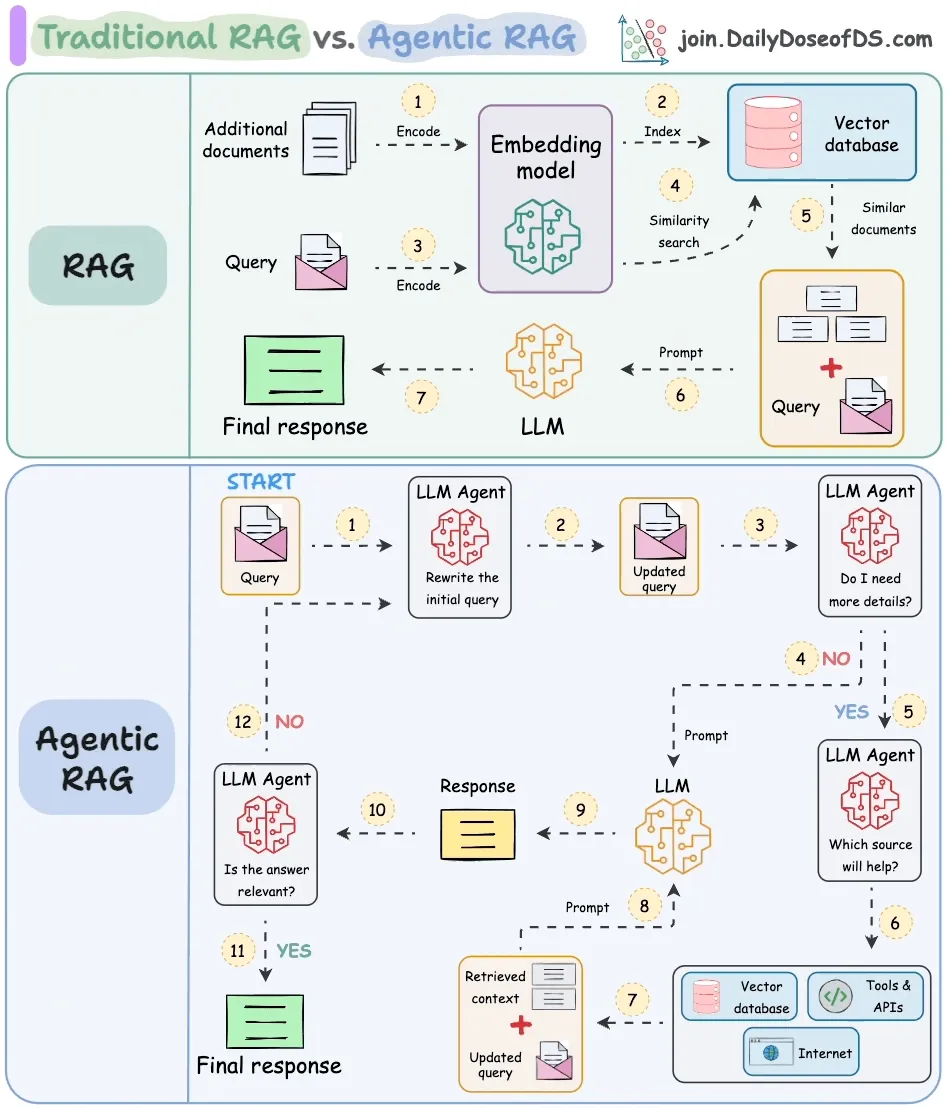

2、RAG vs Agentic RAG

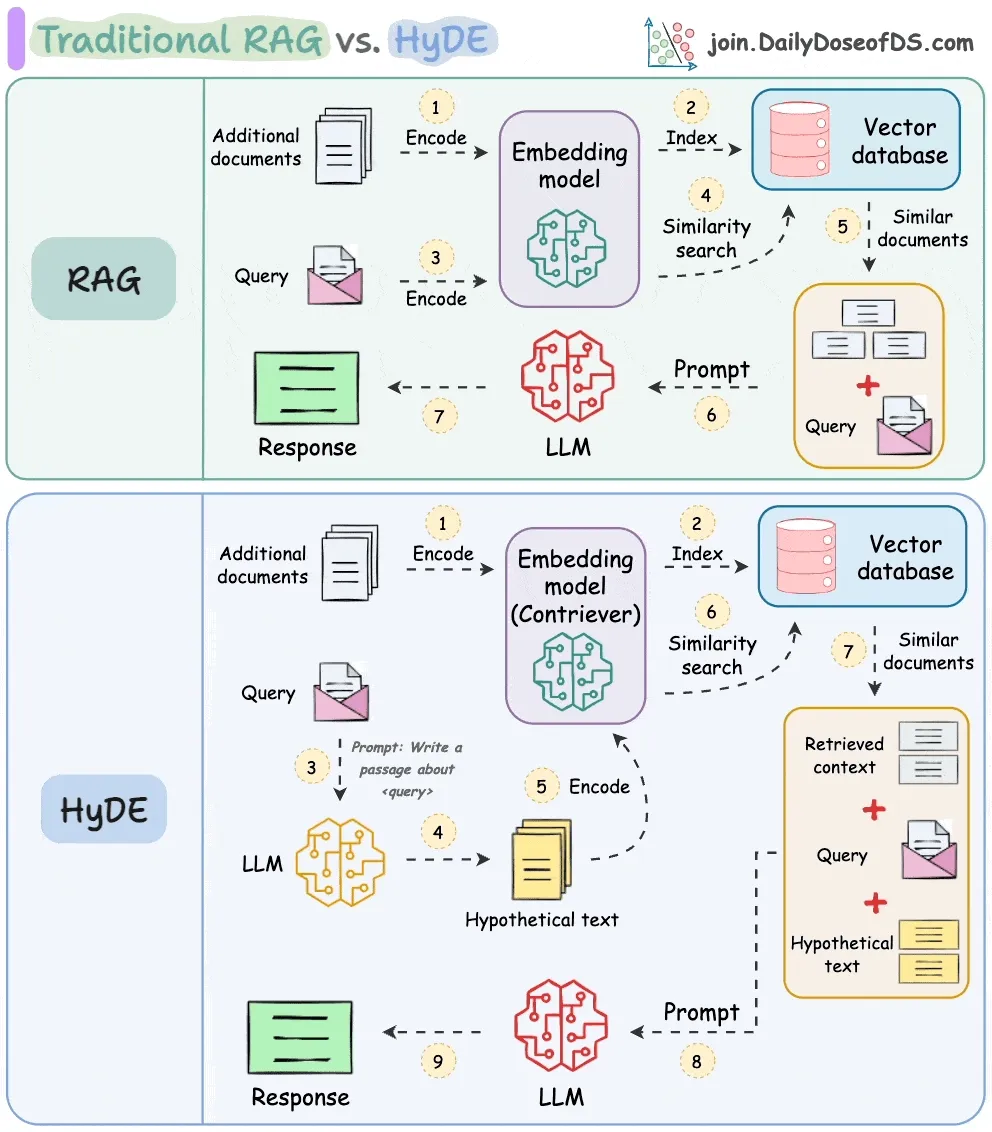

3、Traditional RAG vs. HyDE

4、5 Chunking Strategies For RAG

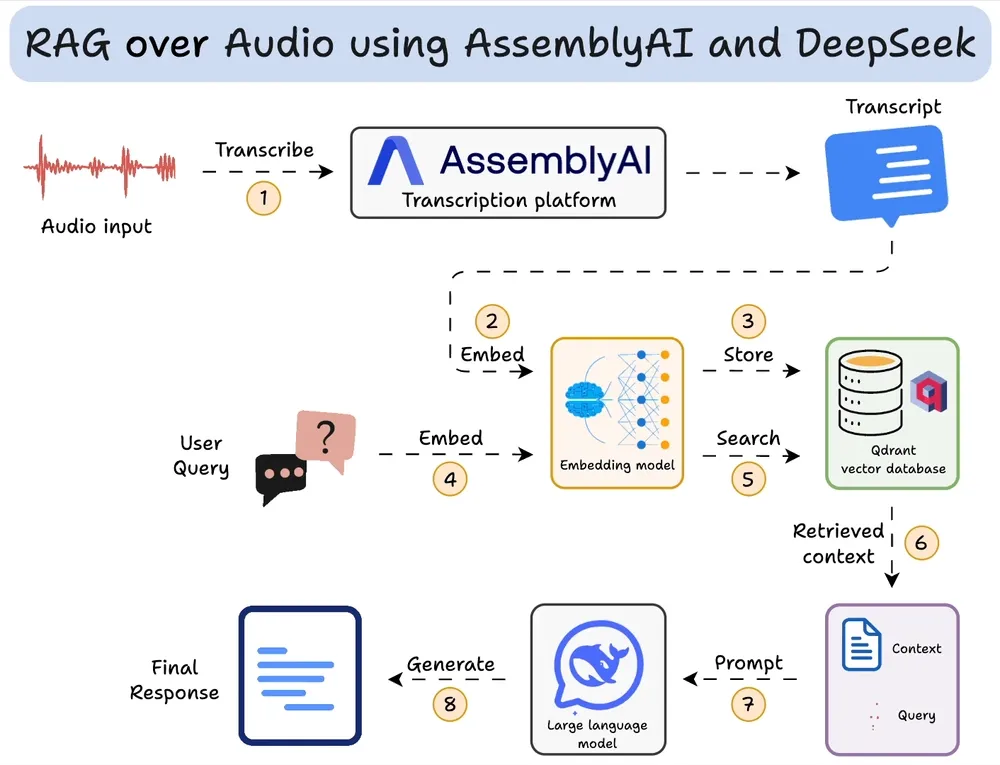

5、RAG over audio files

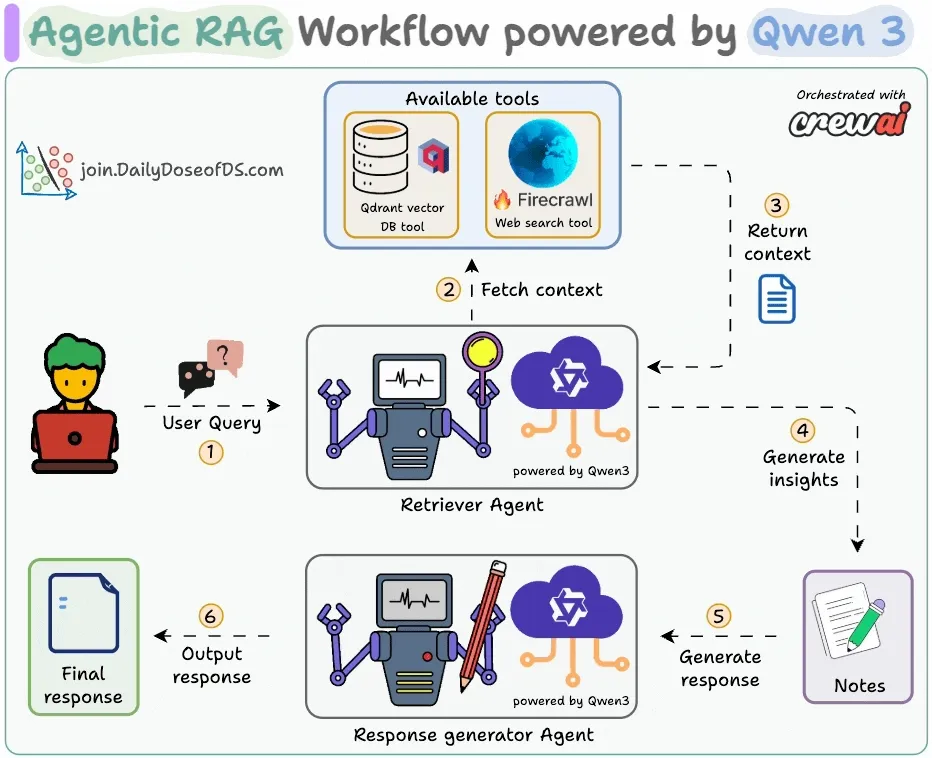

6、agentic-rag-workflow-qwen3

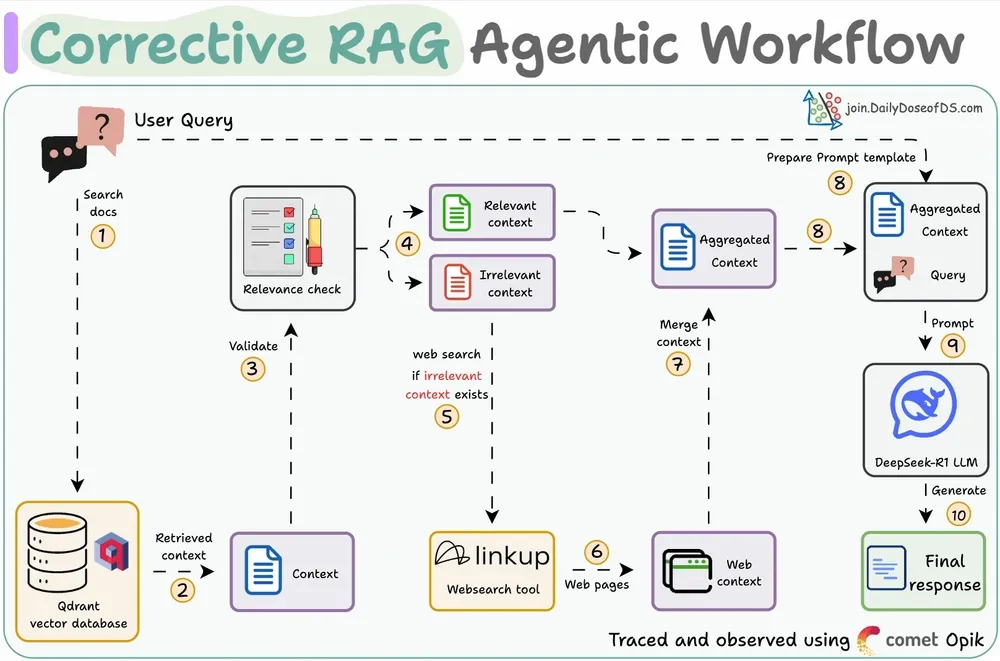

7、Corrective RAG Agentic Workflow

三、Agent、MCP及Functioncall-9张图

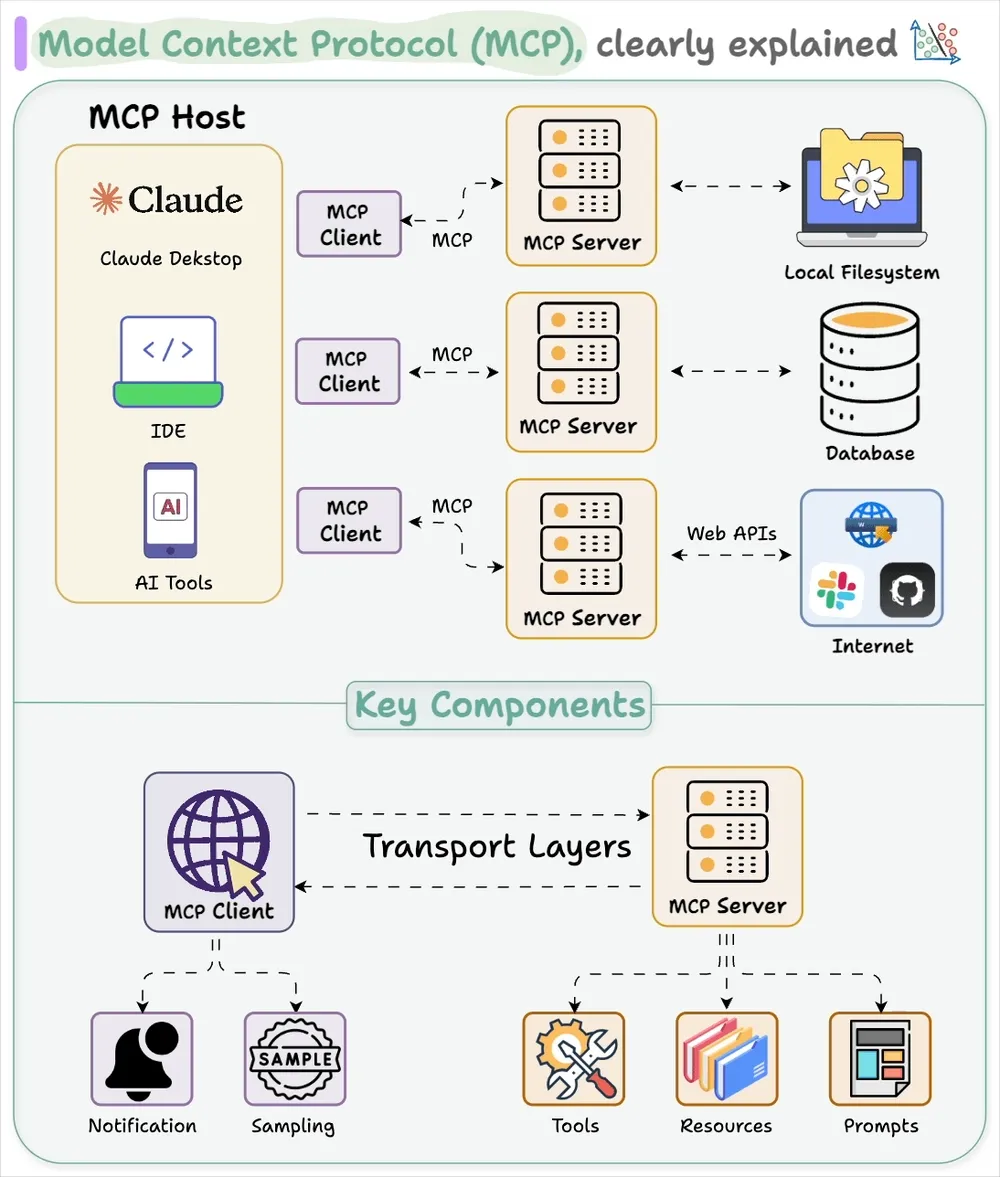

1、mcp

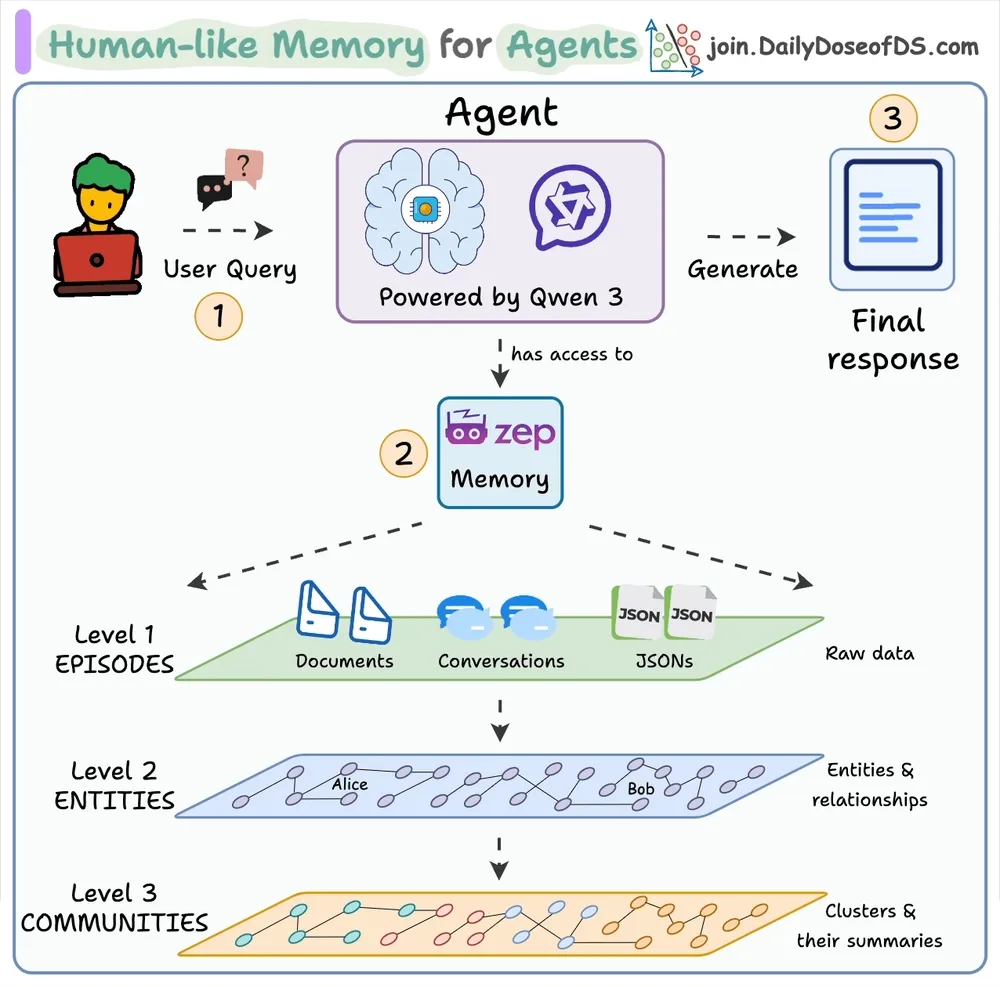

2、zep-memory-visual

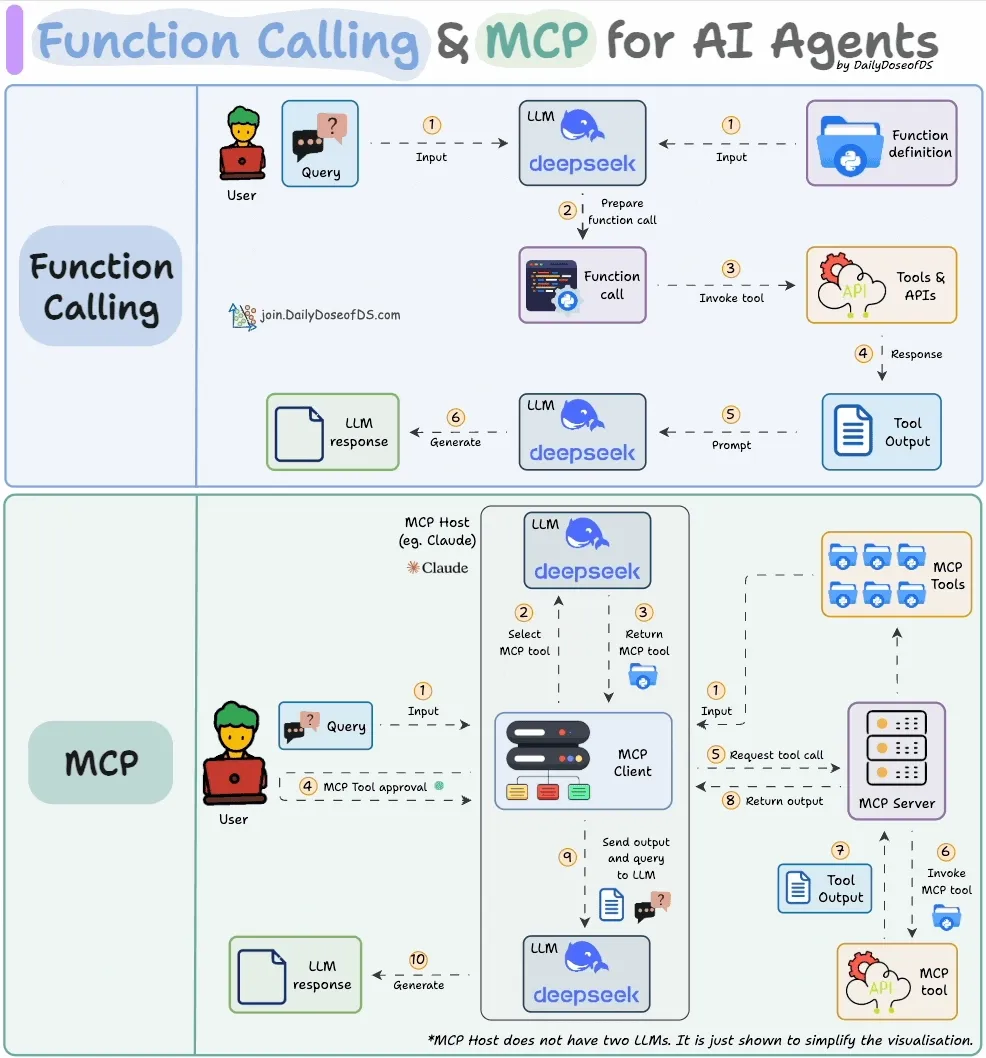

3、Function calling & MCP for LLMs

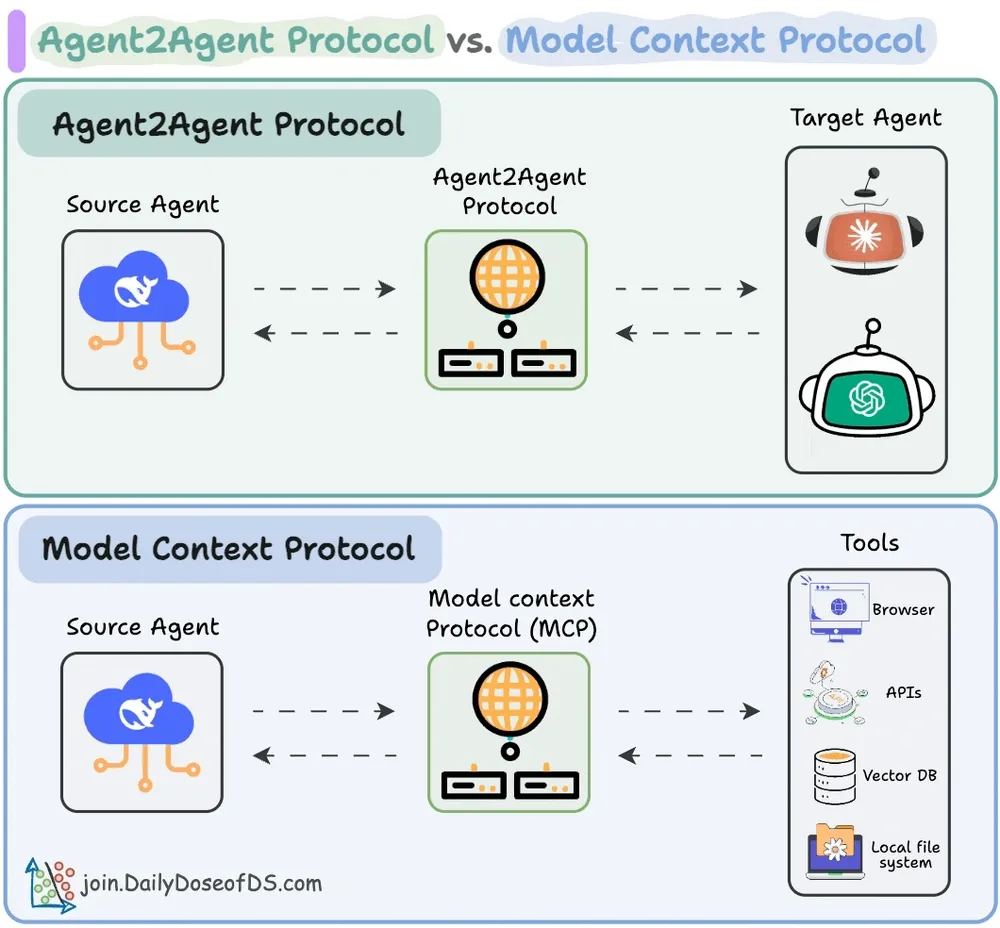

4、Agent2Agent (A2A) Protocol

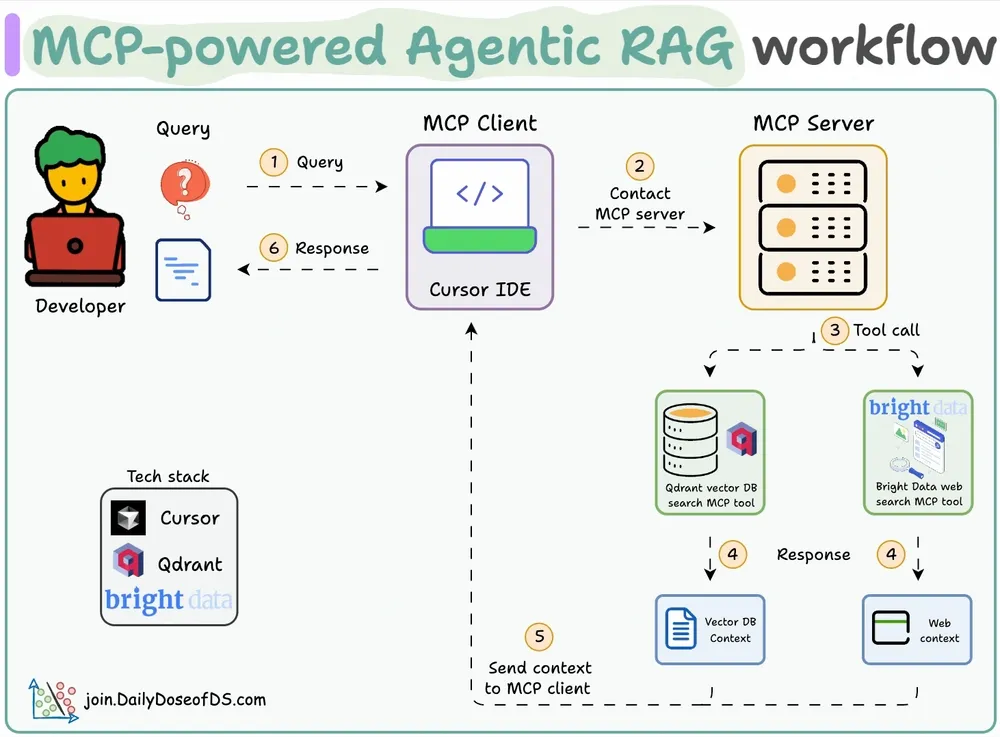

5、MCP-powered Agentic RAG

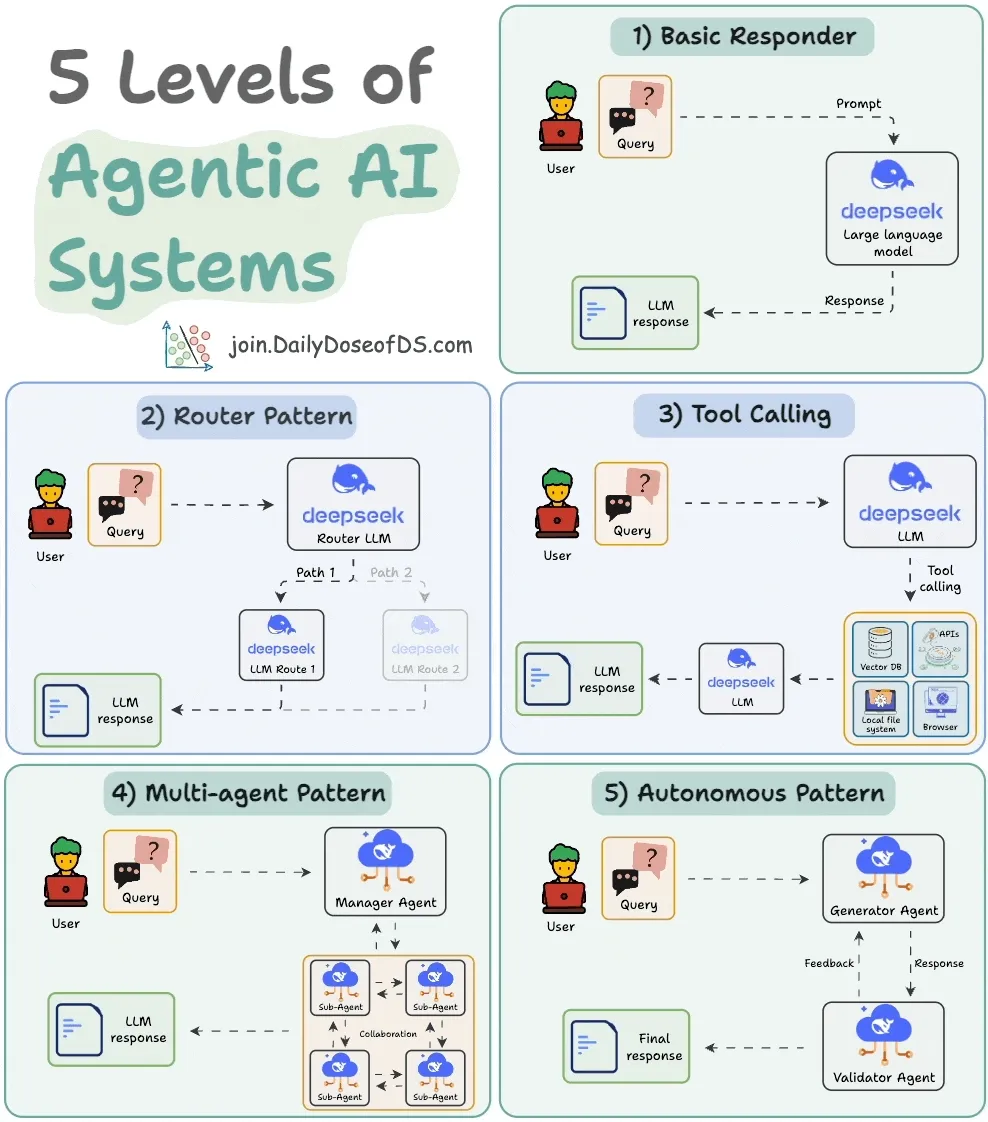

6、5 Levels of Agentic AI Systems

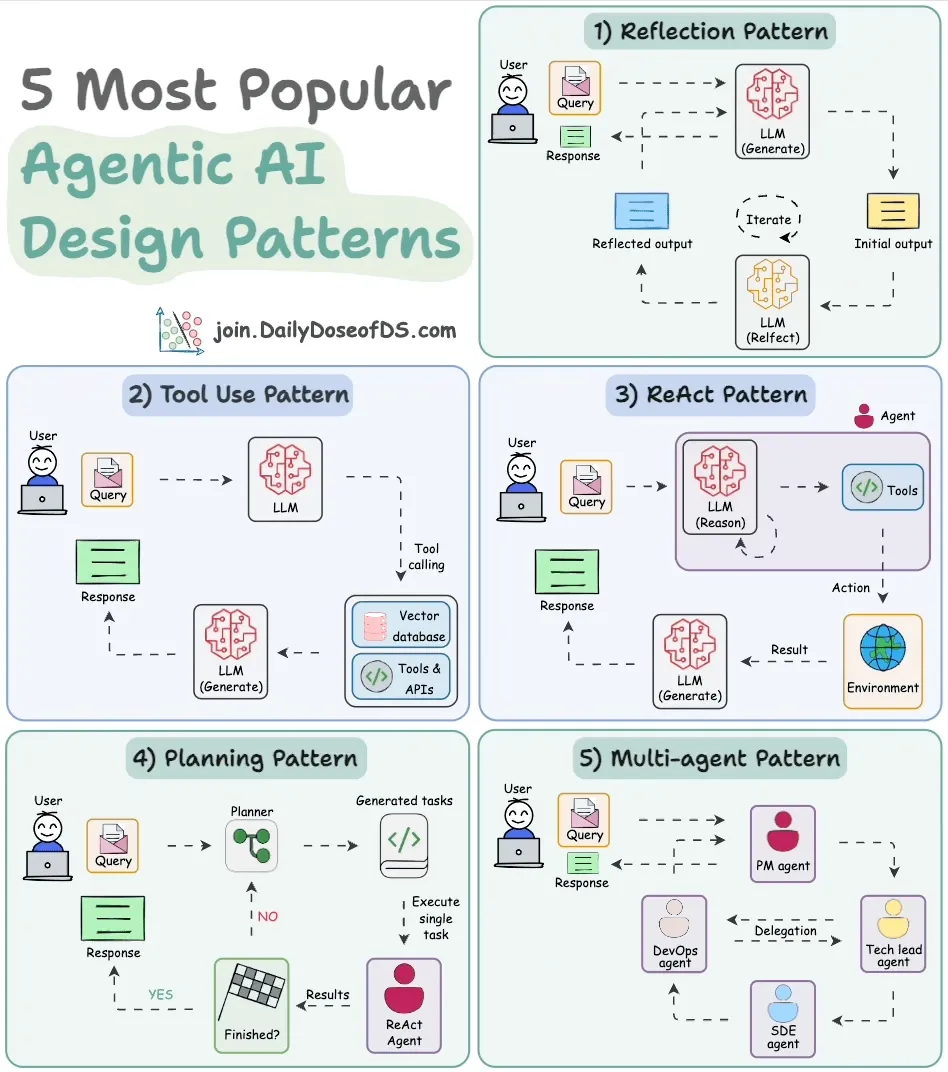

7、5 Agentic AI design patterns

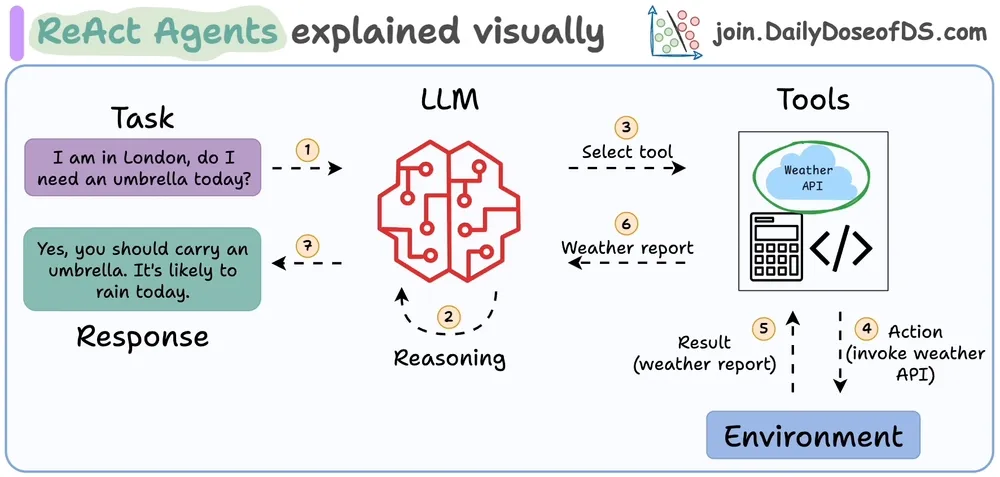

8、ReAct (Reasoning and Action) Agents

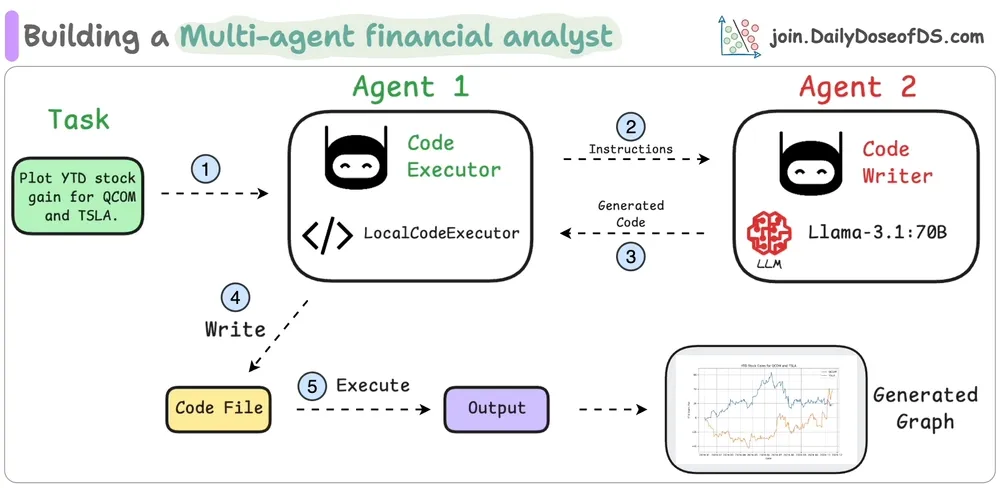

9、Building a Multi-agent Financial Analyst

参考文献

1、https://www.dailydoseofds.com/,本文的图片都在于此,特此注释,总结的很棒。

(文:老刘说NLP)