图片来源:Youtube

Z Highlights

-

AI虚拟人模型架构从CNN、GANs演进至Transformer+扩散模型,实现从单一面部驱动到半身/全身动态生成的跨越,口型同步与多模态协同表现显著提升。

-

AI虚拟人应用场景广泛,个人消费者领域为创意表达开辟新天地,中小企业可低成本制作广告,大型企业在员工培训等多领域深度应用。

-

当下AI虚拟人在角色连贯性、面部动作、身体动作、与环境交互、实时应用等方面期待更多突破,未来有望催生诸多创新实时应用场景。

本文作者Justine Moore是风险投资公司a16z的合伙人,专注于消费领域,特别是AI公司的投资。她拥有斯坦福大学的经济学学士学位和工商管理硕士学位。这篇文章是Justine Moore关于AI虚拟形象的研究。

当AI不再仅仅局限于内容生成,而是迈向内容具身化时,世界将会发生怎样的改变?当下,AI已熟练掌握生成高度逼真照片、视频及语音的技术,成功通过了视觉与听觉维度的图灵测试。而其下一个重大突破,正聚焦于AI虚拟人领域:将特定的人脸与独特的声音融合,塑造出能够自如交流的鲜活角色。

或许有人会想,能否简单生成一张人脸图像,使其动起来并配上画外音?实际操作远非如此简易。其中的挑战,绝非仅停留在精准实现口型同步,更关键的是要确保面部表情与肢体语言协同一致,实现自然流畅的配合。试想,若一个人嘴巴因惊讶而大张,可脸颊与下巴却纹丝不动,这场景该是多么怪异;又或者,声音满含激动情绪,可对应的面部却毫无波澜,那么精心营造的类人错觉瞬间便会土崩瓦解。

值得欣喜的是,我们已然目睹这一领域取得了切实进展。AI虚拟人现已广泛应用于内容创作、广告推广以及企业沟通等多个领域。虽说当前的虚拟人大多只是能说话的头部形象,虽具备一定实用性,但功能存在明显局限。不过,回顾过去几个月,诸多令人振奋的创新成果不断涌现,足以预见,在不久的将来,该领域必将迎来更为重大的突破与发展。

在本文中,基于对20余款AI虚拟人产品的亲身体验与深度测试,我将为大家深入剖析目前切实可行的技术方案、未来的发展趋势,以及当今市场上那些最为出类拔萃、令人印象深刻的AI虚拟人产品。

研究如何发展演进?

AI虚拟人堪称一个极具独特挑战性的研究课题。打造一个会说话的人脸形象,模型得掌握逼真的音素到视位映射,也就是语音中的音素,与相应口型动作视位间的关系。一旦这种映射出现偏差,嘴巴动作和声音就会不同步,甚至显得完全脱节。

问题的复杂之处还在于,说话时并非只有嘴巴在动。脸部其他部位会协同运动,上半身有时也会参与其中,甚至双手也可能会有动作。而且,每个人都有独特的说话风格。不妨想想自己说话的样子,再对比一下喜欢的名人:即便说同一句话,双方嘴巴的动作也会有差异。要是把自己的口型同步到名人脸上,效果会十分怪异。

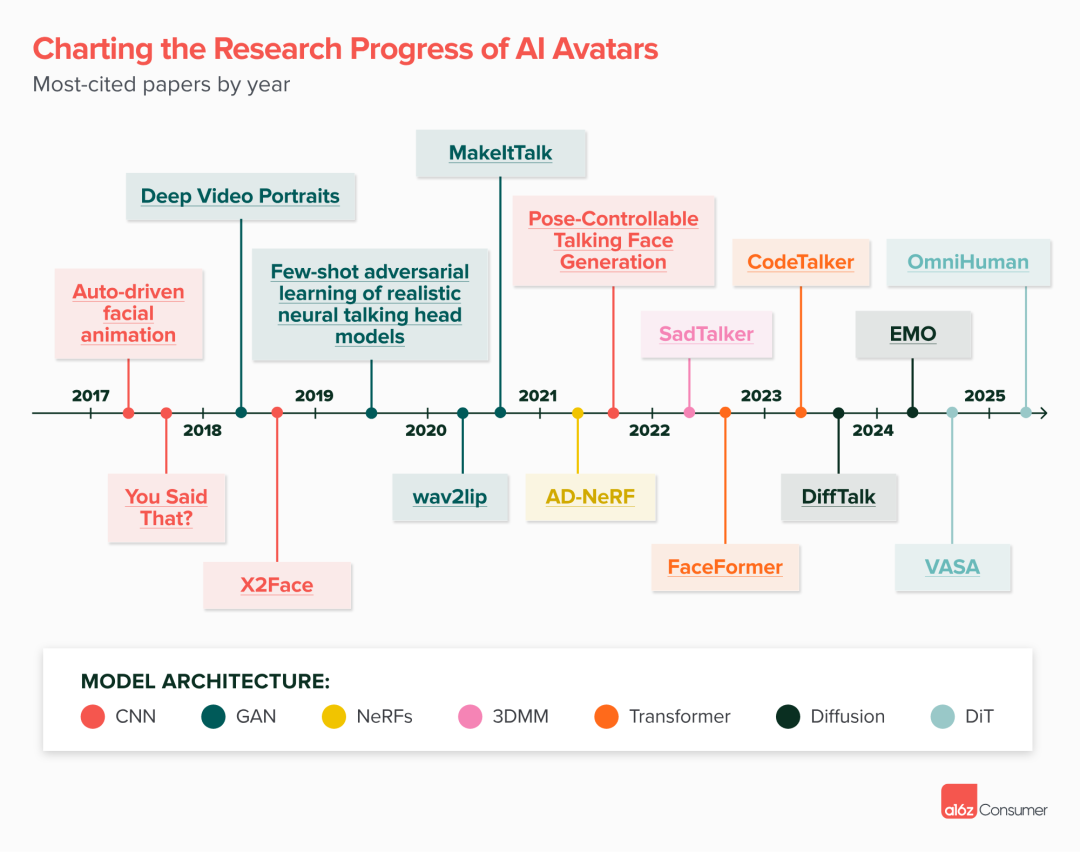

过去几年,从研究视角看,这一领域发生了显著变化。自2017年起,我研读了70多篇有关AI会说话头像的论文,清晰地看到模型架构的发展脉络:从卷积神经网络(CNNs)和生成对抗网络(GANs),到基于三维的神经辐射场(NeRFs)和三维可变形模型等方法,接着演进到变换器(transformers)和扩散模型,而近期则发展为基于变换器架构的扩散模型(DiT)。以下时间轴标注了每年引用量最高的论文。

图片来源:a16z

在AI领域,虚拟人相关模型的生成质量与能力实现了飞跃式提升,和早期相比,简直不可同日而语。早期方法极为受限,以单张人物照片为例,先将照片人物脸部下半部分遮住,再依据音频输入的目标面部特征点,生成新的嘴部动作。但这些模型训练所依赖的高质量口型同步数据语料库规模有限,且其中大多数数据都只是紧紧框定人物面部进行裁剪。就拿“让奥巴马对口型说话”这类效果来说,要实现相对逼真的呈现,需要收集目标人物长达数小时的视频素材,并且最终输出的结果在多样性和表现力上都大打折扣。

反观当下,模型的灵活性与强大程度令人惊叹。同一视频里,它们既能生成半身乃至全身动作,塑造栩栩如生、会说话的人脸形象,还能让背景呈现动态变化。这些新型模型的训练方式,与传统文本转视频模型更为相似,并且依托海量数据集展开。为了在各种动态中始终保持口型同步的精准度,模型运用了丰富多样的技术手段。

早在今年2月,字节跳动推出的OmniHuman-1模型便率先展现出这种前沿趋势(该模型近期已在Dreamina平台上线供用户使用)。整个行业发展势头迅猛,3月,Hedra发布Character-3模型,经我们直接对比测试,该模型在大多数实际应用场景中表现堪称顶尖。Hedra的强大之处不止于人类角色,像为Waymo(知名自动驾驶公司)打造会说话的虚拟形象也不在话下,用户还能通过输入文本,灵活设定角色的情感状态与动作表现。

随着吉卜力工作室风格热潮等行业趋势的推动,围绕AI动画的全新应用场景如雨后春笋般不断涌现。

AI虚拟人在现实世界中的多元应用

AI虚拟人的应用场景可谓包罗万象。不妨设想,但凡涉及与角色交互,或是观看人物讲话视频的场景,都有其用武之地。目前,从个人消费者到中小企业,乃至大型企业,各个领域都已开始应用AI虚拟人。

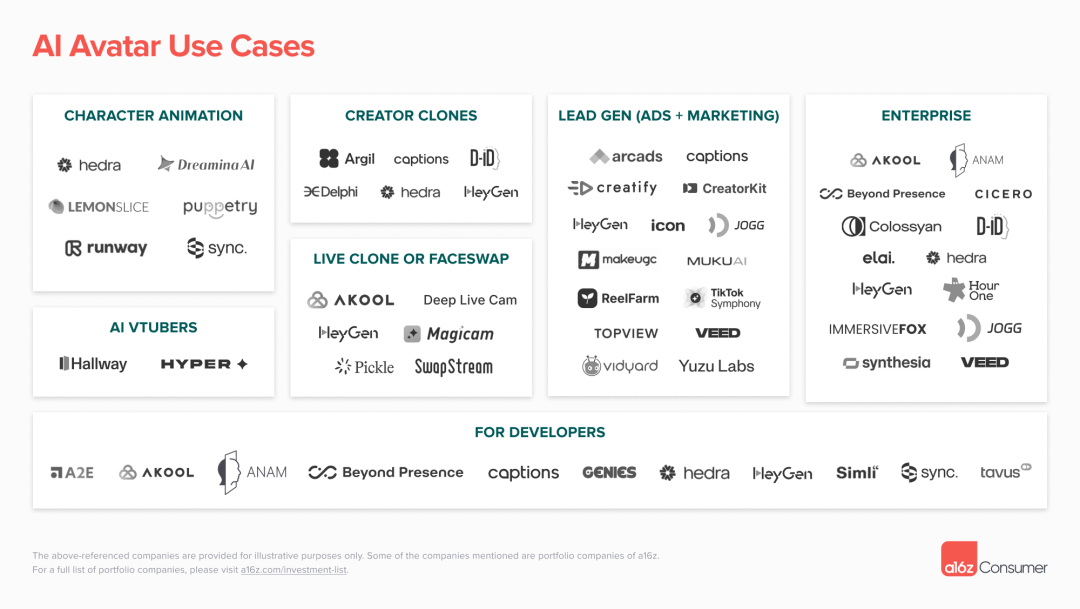

图片来源:a16z

这是一张早期的市场格局图。该领域正飞速发展,产品之间的差异界定仍较为宽泛。理论上,许多产品都能为大多数乃至所有这些应用场景打造虚拟人。然而在实际操作中,构建一套高效工作流程,并精准调校模型,使其在各个方面都能出类拔萃,绝非易事。以下,我们将逐一梳理市场各细分领域利用AI虚拟人的具体实例。

个人消费者领域:角色创作新风尚

现今,借助AI,普通人仅需一张图片,就能轻松打造动画角色,这无疑为大众的创意表达开辟了全新天地。对于渴望运用AI讲述故事的人而言,这一突破意义非凡,怎么夸赞都不为过。回顾早期的AI视频,常被人吐槽为“图片堆砌的幻灯片”,症结之一就在于缺乏能自然对话的角色,语音往往也只是单调的画外音形式。

而当创作的角色能够开口交流,内容瞬间就鲜活有趣起来。除了传统叙事视频,人们还能借助AI创造出风格各异的作品,比如虚拟主播、AI播客以及音乐视频等。此处附上的精彩视频,均出自Hedra平台。在Hedra上,用户只需上传一张初始图片,再搭配一段音频剪辑或者脚本,就能塑造出灵动鲜活、能说会道的角色形象。

要是你手头的素材是一段视频,Sync工具可派上大用场,它能精准匹配口型,让角色的面部动作与音频严丝合缝。倘若你想借助真实人类表演驱动角色动作,Runway Act-One和Viggle等专业工具便能助你一臂之力,实现创意构想。

在众多运用AI创作角色动画的创作者中,Neural Viz是我的心头好。其打造的《单一宇宙》系列,大胆畅想了一个由格卢伦人主宰的后人类宇宙世界,充满奇妙想象。如今,投身这一领域的门槛大幅降低,不难预见,AI生成的精彩节目即将迎来爆发式增长,甚至会催生出一批独具特色的虚拟网红,这都只是时间问题。

随着虚拟人实时直播技术日益成熟,我们可以预见到,诸多面向消费者的企业,将会把虚拟人深度融入用户界面,成为关键组成部分。设想一下,学习外语时,陪伴你的不再是冷冰冰、毫无感情的电子语音,而是一位形象生动、性格鲜明,能实时互动的AI“专属教练”。像Praktika这类先锋企业,已然开启了这一创新尝试。假以时日,这种人机交互模式必将愈发普及、自然,融入大众日常生活的方方面面。

中小企业:挖掘潜在客户的新利器

在当今数字化营销浪潮中,广告领域率先成为AI虚拟人大显身手的“主战场”。以往,企业投放广告往往得聘请专业演员,组建庞大制作团队,耗费大量人力、物力与财力。如今,借助AI,企业只需轻点鼠标,就能让栩栩如生的虚拟角色为自家产品摇旗呐喊。以Creatify和Arcads这类前沿公司为例,企业仅需提供产品链接,它们便能一站式搞定广告制作全流程:从精心雕琢脚本,到筛选适配的辅助镜头、产品图片,再到精准“选定”虚拟演员,一气呵成,无缝衔接。

这一变革彻底打破了传统广告制作成本的壁垒,让众多中小企业得以跻身广告营销的舞台中央。在电商企业、游戏厂商以及消费类应用开发公司中,AI生成广告的模式备受青睐,热度居高不下。说不定,你在刷YouTube、TikTok时,不经意间就已被这类AI广告“圈粉”。当下,不仅面向消费者的企业尝到了甜头,B2B领域的企业也纷纷敏锐捕捉到商机,借助Yuzu Labs、Vidyard等先进工具,巧用AI虚拟人,开展内容营销,或是进行精准个性化推广,开拓业务新渠道。

在具体制作过程中,诸多产品会将虚拟演员形象(既可是现实人物的复刻,也能是原创独特角色),与产品靓照、精彩视频片段、适配音乐等多元素材有机融合。使用者既能自主把控各类素材的呈现位置、展示节奏,打造专属创意风格;也能一键开启“智能托管”模式,让系统依据产品特性、营销目标,自动生成吸睛视频。脚本创作环节同样灵活,既支持用户亲自操刀,融入独特构思;也能借助AI,快速生成专业脚本框架,为创作赋能。

大型企业:规模化内容产出的新引擎

对于大型企业而言,AI虚拟人的应用范畴早已突破营销边界,在多个关键领域深度赋能,发挥着不可小觑的作用。

•员工学习与发展:大型企业人员规模庞大,员工培训教育需求繁杂。从新员工入职引导,到合规政策解读、产品知识科普,再到技能进阶提升,都离不开大量培训教育视频的支撑。传统制作方式耗时费力,而Synthesia等前沿AI工具的登场,彻底革新了这一局面。它能将内容创作流程自动化,极大缩短制作周期,实现高效、规模化产出。以销售岗位为例,销售人员可借助Anam等产品中的虚拟人,反复模拟谈判场景,沉浸式锤炼谈判技巧,切实提升业务能力,让培训效果事半功倍。

•内容本地化定制:跨国企业客户与员工遍布全球,为契合不同地区文化、语言差异,内容本地化至关重要。以往本地化工作繁琐复杂,如今AI虚拟人让这一难题迎刃而解。通过智能技术,企业能快速替换视频中的语言、文化元素,精准适配不同地域受众。再搭配ElevenLabs等公司提供的先进语音翻译技术,同一视频可轻松转化为数十种语言版本,且语音自然流畅,毫无违和感,助力企业跨越语言鸿沟,深度融入全球市场。

•高管形象拓展与影响力提升:在大型企业内部沟通与对外品牌塑造中,高管形象至关重要。借助AI虚拟人,企业能克隆高管形象,打造专属数字分身。从此,产品发布、重要节日问候等场合,无需高管亲临拍摄,其数字分身就能精准传递信息,大幅拓展高管影响力辐射范围。此外,Delphi、Cicero等创新公司,还为企业思想领袖搭建起与大众深度互动的桥梁,打破时空限制,让领袖们轻松回应来自各方的疑问,进一步强化企业品牌的权威性与亲和力。

AI虚拟人的构成要素解析

图片来源:a16z

打造一个令人信服的AI虚拟人,堪称一项极具挑战性的任务。每一个关乎真实感呈现的要素,都暗藏着棘手的技术难题。这可不单纯是规避“恐怖谷效应”那么简单,实则涉及攻克动画制作、语音合成以及实时渲染等领域的关键难题。下面,我们深入剖析构建虚拟人所需的核心要素,探讨实现完美效果为何困难重重,以及当下取得的进展情况:

•面部:无论是复刻现实人物,还是塑造全新角色,都要求虚拟人的面部在不同画面帧间保持连贯一致,且在说话时,面部动作能做到栩栩如生。不过,让虚拟人依据所处情境,自然展现出相应面部表情,仍是一大挑战。比如,虚拟人说“我累了”时,要同步做出打哈欠的动作,这绝非易事。

•声音:声音不仅要真实自然,还得与虚拟人的角色形象高度契合。试想,一个青春少女模样的虚拟人,要是配上中年女性的声音,那违和感简直扑面而来。目前,我们接触到的多数AI虚拟人企业,都青睐使用ElevenLabs。这个平台语音库资源丰富,还支持用户克隆专属自己的独特声音。

•口型同步:实现精准、高质量的口型同步,技术难度颇高。Sync等企业就专注于攻克这一难题。而像Meta推出的MoCha,以及OmniHuman这类模型,则依托海量数据集展开训练,运用多元技术,让面部生成过程与配套音频紧密绑定,使每一帧面部画面都能精准匹配音频,实现口型同步。

•身体:虚拟人可不能只是个“光杆司令”,只露出个脑袋飘在空中。新一代模型已能实现全身虚拟人的创建,且支持动作呈现。但不管是进一步拓展其功能丰富度,还是优化用户使用体验,当前仍处于起步摸索阶段,还有很长的路要走。

•背景:虚拟人非孤立存在于真空环境中。其所处环境的光线效果、空间景深,以及与周遭物体的互动状态,都得与整体场景协调统一。理想状态下,虚拟人应具备与环境物体交互的能力,比如轻松拿起一件产品,真正融入场景之中。

倘若期望虚拟人能实时参与对话,比如加入Zoom视频会议,还需增添以下关键要素:

•“智能大脑”:虚拟人得具备“思考”能力。当下支持对话功能的产品,大多允许用户上传知识库,或接入现有知识库。展望未来,更先进的产品版本有望赋予虚拟人更强的记忆能力,塑造鲜明个性。这样一来,虚拟人便能清晰记得与用户过往的交流内容,在互动中展现独特风格。

•实时流传输:要在保证低延迟的前提下,流畅实现上述所有功能的实时流传输,技术难度极大。LiveKit、Agora等产品已在该领域取得一定突破,但要让各类模型协同运作,同时将延迟控制在最低限度,仍面临诸多挑战。虽说像Tolan这种集语音与面部形象于一体的AI外星人伙伴,在实时流传输方面表现出色,但从行业整体来看,后续仍有大量优化工作亟待推进。

我们期待怎样的突破?

AI虚拟人领域依旧蕴含着巨大的发展潜力,亟待我们去开拓与完善。以下几个方面是当下关注的重中之重:

•角色的连贯性与可塑性:过去,AI虚拟人的形象千篇一律,往往仅有单一、固化的外观设定。无论是着装风格、肢体姿态,还是所处的环境背景,均处于静态,缺乏变化。如今,情况开始出现转机,部分产品已尝试为用户提供多样化选择。以HeyGen推出的角色劳尔(Raul)为例,他拥有多达20种不同形象,令人眼前一亮。但我们期望未来能拥有更便捷、更强大的功能,让用户能够随心所欲地对角色进行全方位塑造与变换,真正实现创意自由。

•面部动作与表情的进阶:长久以来,面部表现一直是AI虚拟人难以攻克的薄弱环节。以往虚拟人的面部呈现效果生硬、呆板,犹如机械木偶,缺乏生气与灵动性。不过,随着技术的迭代更新,这一局面正逐渐得到扭转。例如,Captions公司全新发布的Mirage模型,便成功实现了质的飞跃,能够展现出更为自然逼真的面部外观,以及更为丰富多元的表情神态。我们迫切期待未来的AI虚拟人能够深度理解脚本中的情感内涵与语境信息,并做出精准、恰当的反应。想象一下,当角色在逃离怪物的紧张场景中,能瞬间流露出惊恐万分的表情,无疑将极大增强虚拟人的沉浸感与感染力。

•身体动作的自然呈现:当前,绝大多数AI虚拟人在面部以下的身体部位动作匮乏,即便是最基础的手势动作,也极为罕见。现有的手势控制方式多依赖于预先设定的程序逻辑,灵活性与真实感严重不足。以Argil为例,用户仅能在有限的选项中,为视频的不同片段挑选特定类型的肢体语言,难以满足对自然交互的需求。展望未来,我们热切期盼能够见证更多自然流畅、贴合情境的身体动作,让虚拟人在举手投足间尽显真实与生动。

•与“现实世界”的交互拓展:现阶段,AI虚拟人与周围环境的交互能力近乎为零,这成为限制其应用场景拓展的关键瓶颈。短期内,一个切实可行且极具价值的目标是赋予虚拟人在广告场景中与产品进行互动的能力,比如自然地拿起并展示产品。值得欣喜的是,Topview公司已在这方面迈出了坚实步伐。随着模型性能的持续优化,我们对未来在这一领域的更多突破满怀期待。

•实时应用场景的全面拓展:在未来,AI虚拟人有望深度融入人们的日常生活,催生诸多极具创新性与实用性的实时应用场景。设想一下,与AI医生进行视频问诊,在专业的AI销售助理陪伴下浏览心仪产品,或是通过FaceTime与喜爱的电视剧角色畅聊……尽管目前在延迟控制与稳定性方面,距离人类自然交互的理想状态仍存在一定差距,但技术的飞速发展已使我们越来越接近这一目标。

行业将驶向何方?

回顾过去几年在基础模型企业与AI应用领域的投资历程,我们深刻领悟到一个道理:准确预判某个特定领域的未来走向,几乎是一项不可能完成的任务。然而,有一点可以确信:随着底层模型质量的显著提升,如今已能生成观感良好、不再令人“不忍直视”的AI会说话头像,这无疑为应用层的爆发式增长奠定了坚实基础。

我们大胆预测,这一领域将孕育出众多市值达数十亿美元的行业巨头。届时,市场将依据不同的应用场景与目标客户群体,对产品进行精细化细分。例如,相较于粉丝为朋友制作一段简单的动漫角色短视频,企业高管若期望借助AI克隆体为客户拍摄专业视频,他们对产品的质量与真实感要求将更为严苛,同时也愿意为此支付更高的费用。

此外,高效的工作流程同样不可或缺。倘若你计划借助AI虚拟网红制作广告,一款能够自动提取产品详细信息、精准撰写脚本、智能添加辅助镜头与产品图片、一键将视频推送至各大社交平台,并实时评估广告效果的综合性平台,将成为你的得力助手。反之,若你致力于运用AI角色创作故事,那么一款支持角色与场景保存复用、方便快捷拼接各类视频片段的工具,无疑将更契合你的创作需求。

原文:AI Avatars Escape the Uncanny Valley

https://a16z.com/ai-avatars/

编译:Qinger Geng

请注意,本文编译自文末载明的原始链接,不代表Z Potentials立场。如果您对本文有任何想法或见解,欢迎在评论区留言互动探讨。

Z Potentials将继续提供更多关于人工智能、机器人、全球化等领域的优质内容。我们诚邀对未来充满憧憬的您加入我们的社群,与我们共同分享、学习、成长。

(文:Z Potentials)