-

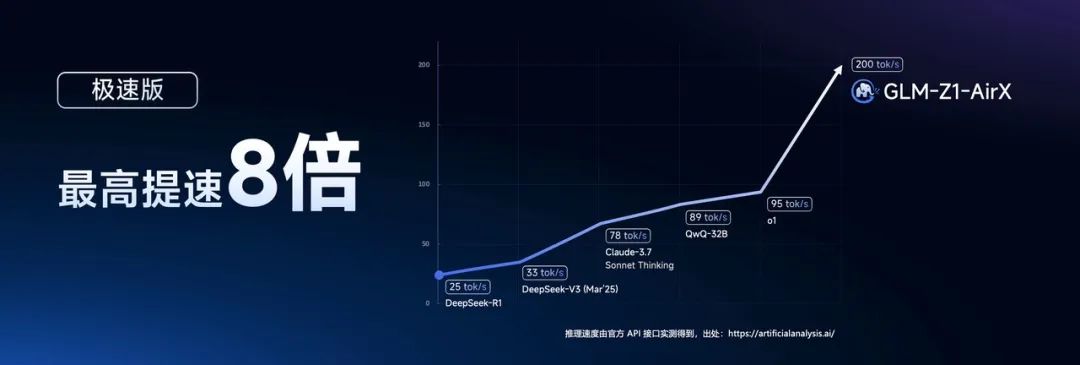

GLM-Z1-AirX(极速版):国内最快推理模型,推理速度高达200 tokens/s,8倍于常规速度;

-

GLM-Z1-Air(高性价比版):价格仅为DeepSeek-R1的1/30,适合高频调用场景;

-

GLM-Z1-Flash(免费版):支持免费使用,进一步降低模型使用门槛。

-

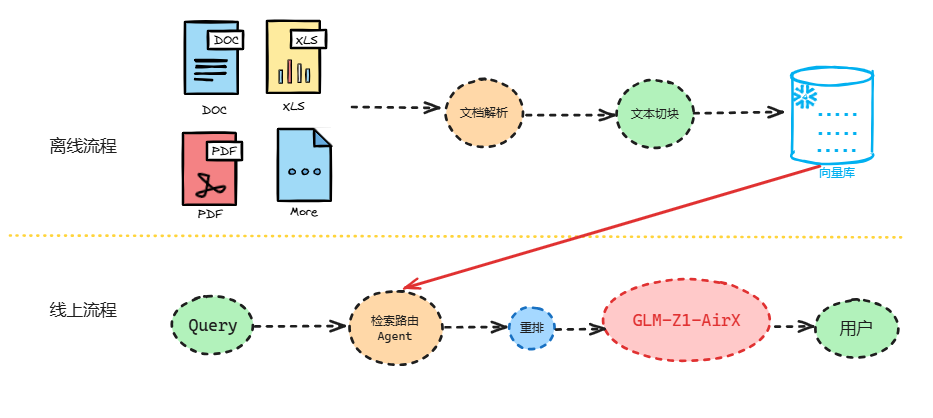

离线流程,文档被分割成块,编码成向量,并存储在向量数据库(ES/Milvus)中。 -

线上流程 -

Agentic 路由,根据查询类型,Agent从多种检索选项中检索相关数据, -

生成,将原始问题和检索到的内容送入大模型(GLM-Z1-AirX)中,生成最终答案。

Agentic RAG问答流程(GLM-Z1-AirX)

pip install --upgrade zhipuaifrom zhipuai import ZhipuAIclient = ZhipuAI(api_key="") # 填写您自己的APIKeyresponse = client.chat.completions.create(model="GLM-Z1-AirX", # 填写需要调用的模型编码messages=[{"role": "user", "content": "你好"}],stream=True,)for chunk in response:content = chunk.choices[0].delta.contentprint(content)

-

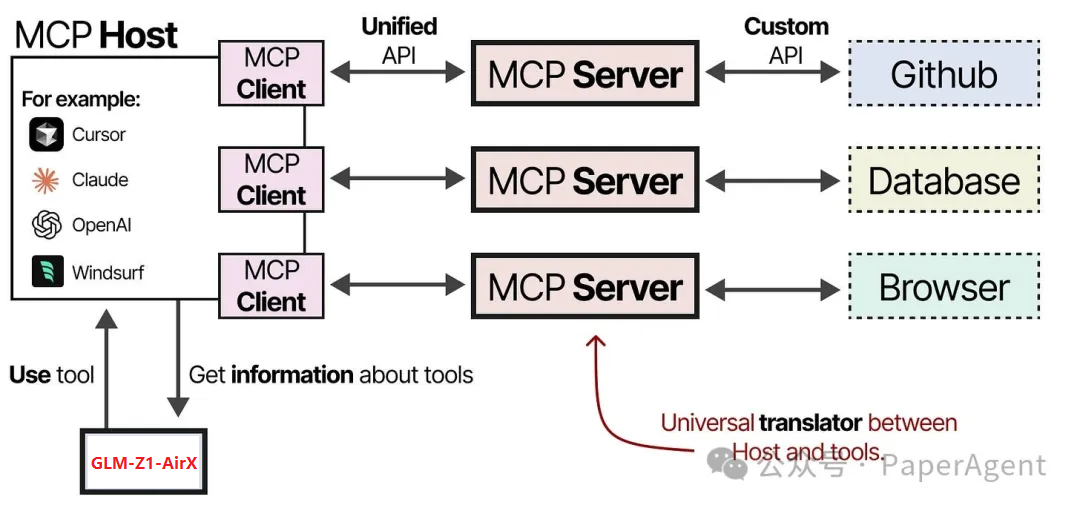

MCP 主机 —— LLM 应用程序(例如 Cursor),管理连接 -

MCP 客户端 —— 与 MCP 服务器保持一对一连接 -

MCP 服务器 —— 为 LLM 提供上下文、工具和能力

-

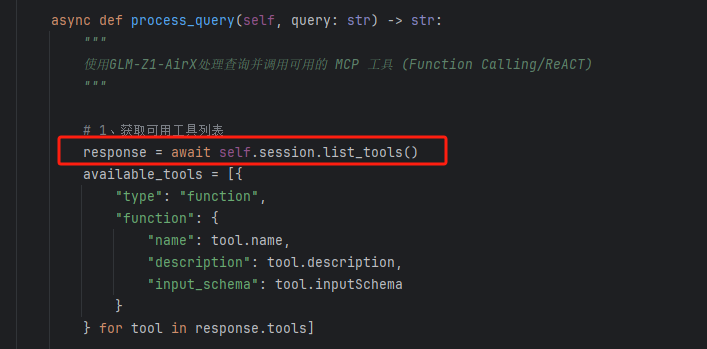

在MCPClient.py,首先利用list_tools让MCP Server上所有可用的工具信息

-

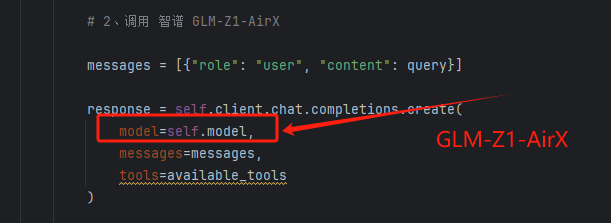

将第一步拼接的工具信息(名称、描述、参数)传给大模型(GLM-Z1-AirX),这里可以用支持Funciton Call的大模型,也可以采用ReAct的方式。

-

GLM-Z1-AirX会选择使用哪个工具,之后通过call_tool让MCP Server执行工具并返回结果

-

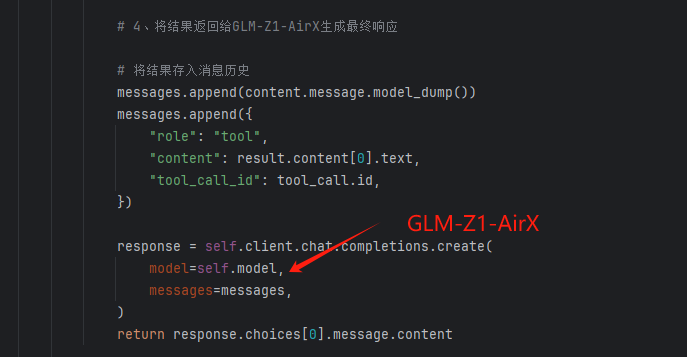

工具执行的结果存入消息历史,一起送入GLM-Z1-AirX,给出解析的答案

-

最后,可以看一个GLM-Z1-AirX以ReAct方式调用工具的示例,3.6s完成,非常快速!

https://hf-mirror.com/collections/THUDM/glm-4-0414-67f3cbcb34dd9d252707cb2ehttps://github.com/modelcontextprotocol/python-sdk

(文:PaperAgent)