AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文题目:NeuroClips: Towards High-fidelity and Smooth fMRI-to-Video Reconstruction -

论文链接:https://arxiv.org/abs/2410.19452 -

项目主页:https://github.com/gongzix/NeuroClips

和

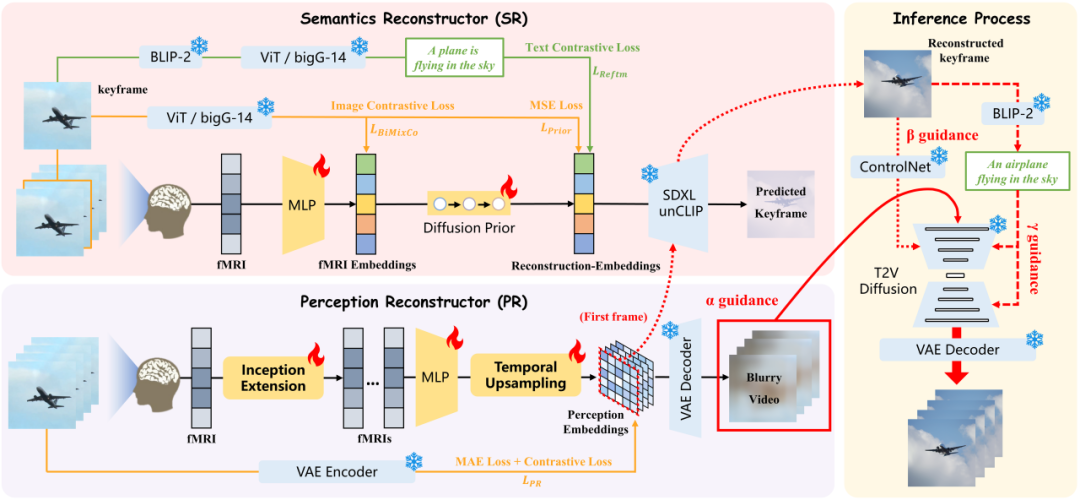

和 之间进行对比学习,通过额外的文本模态来增强重建嵌入

之间进行对比学习,通过额外的文本模态来增强重建嵌入 。对比损失作为这一过程的训练损失

。对比损失作为这一过程的训练损失 。我们设置混合系数

。我们设置混合系数 和

和 来平衡多个损失。

来平衡多个损失。

是关键帧图像和 fMRI 对齐采用的结合了 MixCo 和对比损失的双向损失,

是关键帧图像和 fMRI 对齐采用的结合了 MixCo 和对比损失的双向损失, 是重建时与 DALLE・2 相同的扩散先验损失。

是重建时与 DALLE・2 相同的扩散先验损失。 和 fMRI 嵌入输入到 SR 中的 SDXL unCLIP 生成)和额外的文本模态分别作为

和 fMRI 嵌入输入到 SR 中的 SDXL unCLIP 生成)和额外的文本模态分别作为 、

、 和

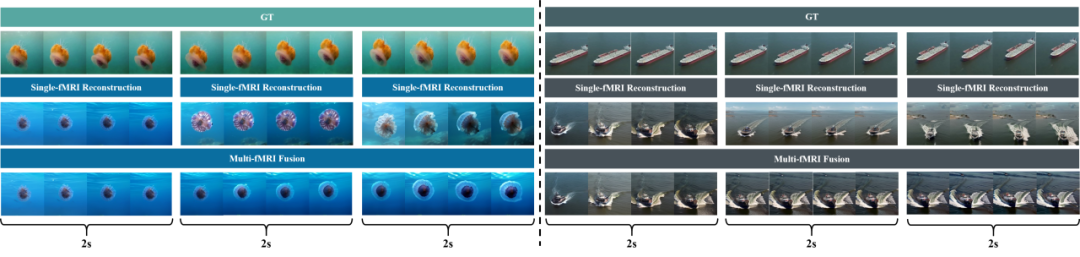

和 Guidance 来重建具有高保真度、平滑度和一致性的最终视频。我们采用 text-to-video(T2V)的扩散模型来帮助重建视频,而由于嵌入的语义仅来自文本模态。我们还需要通过增强来自视频和图像模态的语义来创建 “综合语义” 嵌入,以帮助实现 T2V 扩散模型的可控生成。

Guidance 来重建具有高保真度、平滑度和一致性的最终视频。我们采用 text-to-video(T2V)的扩散模型来帮助重建视频,而由于嵌入的语义仅来自文本模态。我们还需要通过增强来自视频和图像模态的语义来创建 “综合语义” 嵌入,以帮助实现 T2V 扩散模型的可控生成。

(文:机器之心)