随着人工智能技术的飞速发展,大语言模型逐渐成为推动自然语言处理领域进步的核心力量。腾讯混元Dense模型作为腾讯开源的高效大型语言模型系列,凭借其小体积、高性能的特点,在众多模型中脱颖而出,为开发者提供了灵活的部署选择。

一、项目概述

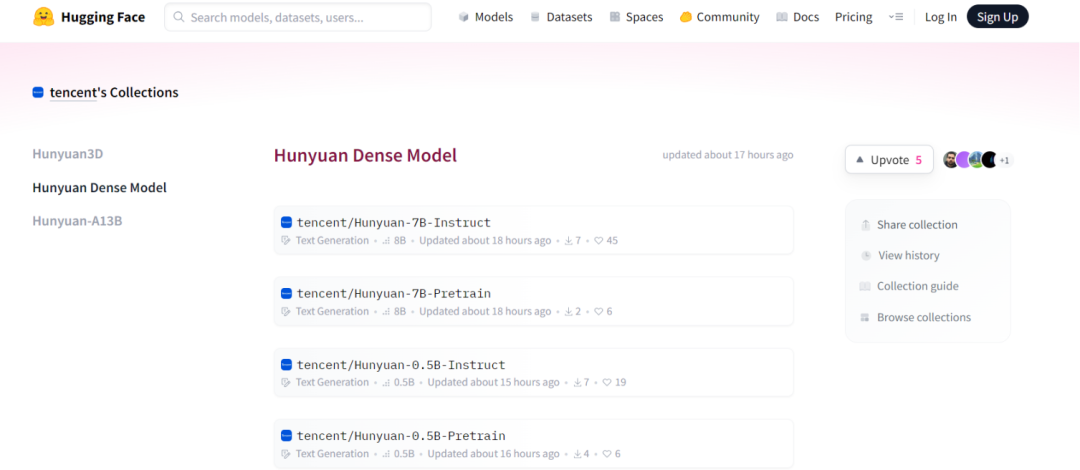

腾讯混元Dense模型是一系列开源的高效大型语言模型,旨在适应各种计算环境,实现从边缘设备到高并发生产系统的灵活部署。本次开源的混元Dense模型包括Pretrain和Instruct版本,参数规模分别为0.5B、1.8B、4B和7B,能够在消费级显卡上运行,适用于笔记本电脑、手机、智能座舱、智能家居等低功耗场景,同时支持垂直领域低成本微调。这些模型在长文本处理、智能体任务和多轮对话方面表现出色,为开发者提供了丰富的选择。

二、技术原理

(一)模型架构

混元Dense模型采用了与Hunyuan-A13B相似的训练策略,继承了其强大的性能特点。该模型原生支持256K上下文窗口,能够一次性处理超长文本内容,这使得其在长文本任务中表现出色。此外,模型采用了分组查询注意力(GQA)策略,进一步优化了计算效率。

(二)混合推理支持

混元Dense模型支持快速和慢速思考模式,用户可以根据任务需求灵活选择。快思考模式适合追求速度和最小计算开销的简单任务,而慢思考模式则可以输出更深、更全面的推理步骤。这种灵活性使得模型在不同场景下都能表现出色。

(三)量化与高效推理

该模型支持多种量化格式,包括4位、8位和16位量化,从而实现高效的推理。这使得模型在保持性能的同时,能够显著降低计算资源的消耗。例如,Hunyuan-0.5B-Instruct模型在4位量化下仍然能够保持较高的性能,适合在资源受限的设备上运行。

三、主要功能

(一)超长上下文理解

混元Dense模型原生支持256K上下文窗口,能够处理相当于40万中文汉字或50万英文单词的超长内容,这使其在处理长文本任务时具有显著优势。例如,在处理法律文书、学术论文或长篇小说时,模型能够更好地理解上下文关系,生成更准确的输出。

(二)增强的Agent能力

该模型针对Agent类任务进行了优化,在BFCL-v3、τ-Bench和C3-Bench等基准测试中取得了领先的结果。这表明其在智能体任务中具有出色的表现。例如,在智能客服系统中,模型能够更好地理解用户意图,提供更准确的解决方案。

(三)灵活的部署选项

混元Dense模型提供了多种参数规模的版本,从0.5B到7B,能够满足从资源受限的边缘计算到高吞吐量的生产环境的不同需求。例如,Hunyuan-0.5B-Instruct模型适合在消费级显卡上运行,而Hunyuan-7B-Instruct模型则适合在高性能计算环境中使用。

四、应用场景

(一)智能座舱

在智能座舱场景中,混元Dense模型可以作为车载助手,通过语音交互为驾驶员和乘客提供导航、信息查询等服务。其低功耗、高效推理的特性使其能够在车载环境中稳定运行。例如,用户可以通过语音指令查询路况信息、播放音乐或调整车内温度。

(二)智能家居

在智能家居领域,该模型可以集成到智能音箱、智能家电等设备中,实现语音控制和智能对话功能。用户可以通过语音指令控制家电设备,查询天气、日程等信息。例如,用户可以说“今天天气怎么样?”或“把客厅的灯打开”,模型能够准确理解并执行这些指令。

(三)客服系统

混元Dense模型可以用于构建智能客服系统,自动回答用户咨询,处理常见问题。其多轮对话能力和自然语言理解能力能够提升客服效率和用户体验。例如,在电商客服场景中,模型可以自动回答用户关于商品信息、订单状态等问题。

(四)内容创作

该模型能够生成高质量的文本内容,适用于新闻报道、产品描述、营销文案等创作任务。其强大的语言生成能力可以为内容创作者提供灵感和辅助。例如,用户可以输入一个主题,模型会生成相关的文章或文案。

五、快速使用

(一)环境准备

在使用混元Dense模型之前,需要确保已安装Python和必要的依赖库。推荐使用Python 3.8及以上版本。此外,还需要安装transformers库,可以使用以下命令进行安装:

pip install git+https://github.com/huggingface/transformers@4970b23cedaf745f963779b4eae68da281e8c6ca(二)模型下载

Make sure git-lfs is installed (https://git-lfs.com)git lfs installgit clone https://huggingface.co/tencent/Hunyuan-7B-Instruct

(三)模型推理

我们以tencent/Hunyuan-7B-Instruct 为例,演示如何启用和禁用推理模式,以及如何解析推理过程和最终输出。

from transformers import AutoModelForCausalLM, AutoTokenizerimport osimport remodel_name_or_path = "tencent/Hunyuan-7B-Instruct"tokenizer = AutoTokenizer.from_pretrained(model_name_or_path)model = AutoModelForCausalLM.from_pretrained(model_name_or_path, device_map="auto") # You may want to use bfloat16 and/or move to GPU heremessages = [{"role": "user", "content": "Write a short summary of the benefits of regular exercise"},]tokenized_chat = tokenizer.apply_chat_template(messages, tokenize=True, add_generation_prompt=True,return_tensors="pt",enable_thinking=True # Toggle thinking mode (default: True))outputs = model.generate(tokenized_chat.to(model.device), max_new_tokens=2048)output_text = tokenizer.decode(outputs[0])print("output_text=",output_text)think_pattern = r'<think>(.*?)</think>'think_matches = re.findall(think_pattern, output_text, re.DOTALL)answer_pattern = r'<answer>(.*?)</answer>'answer_matches = re.findall(answer_pattern, output_text, re.DOTALL)think_content = [match.strip() for match in think_matches][0]answer_content = [match.strip() for match in answer_matches][0]print(f"thinking_content:{think_content}\n\n")print(f"answer_content:{answer_content}\n\n")

(四)推理模式切换

混元Dense模型支持快思考和慢思考两种推理模式。可以通过以下方式切换推理模式:

-

在调用`apply_chat_template`时传递`”enable_thinking=False”`参数来禁用慢思考推理。

-

在提示前添加`”/no_think”`将强制模型不进行慢思考推理,而添加`”/think”`则强制模型进行慢思考推理。

六、结语

腾讯混元Dense模型以其小体积、高性能和灵活的部署选项,为开发者提供了一个强大的工具,适用于从边缘设备到高并发生产系统的多种场景。其原生支持的超长上下文窗口和优化的Agent能力,使其在长文本处理和智能体任务中表现出色。

七、项目地址

GitHub地址:https://github.com/Tencent-Hunyuan/Hunyuan

官方文档:https://hunyuan.tencent.com

ModelScope页面:https://modelscope.cn/models/Tencent-Hunyuan

(文:小兵的AI视界)