就在全球科技圈还在议论OpenAI抢跑宣称其内部模型拿下IMO金牌之际,真正的“官方认证”王者来了。谷歌DeepMind刚刚发布重磅博客,宣布其搭载了 “深度思考”(Deep Think) 能力的高级版Gemini,在2025年国际数学奥林匹克竞赛(IMO)中,以6题解出5题、总分35分的成绩,正式达到金牌标准!

这一成绩经过了IMO官方协调员的认证,所有解题过程都在4.5小时的比赛时限内完成,并且全程使用自然语言进行端到端的推理

哈哈哈,相比于OpenAI的自我宣称,谷歌拿出了无可辩驳的官方战报,这下我好像终于知道了OpenAI为什么抢跑了,Sam Altman一定是提前知道了什么,我也好像懂了为什么OpenAI不顾IMO组委会反对提前宣称自己的实验模型获得了金牌,一个官方认证的结果一定让sam 寝食难安,如果不提前炒作一下,这个结果一定对OpenAI造成巨大的打击

真正的金牌选手:5道满分,端到端自然语言搞定

这一成就的含金量,体现在以下几个颠覆性的进步上:

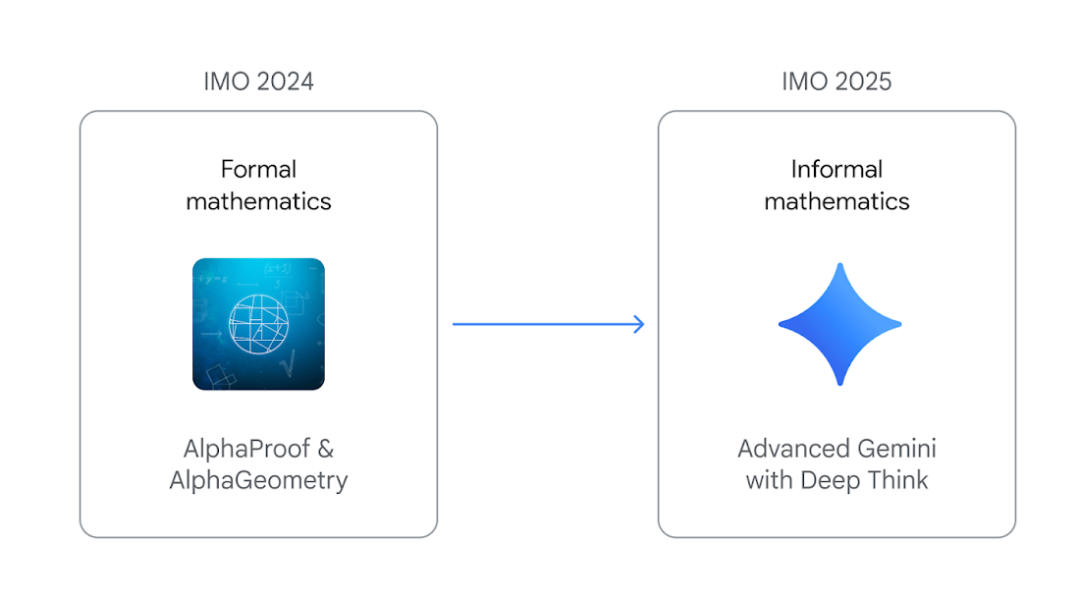

从“形式数学”到“自然语言”的飞跃:

还记得去年(IMO 2024)吗?谷歌的AlphaGeometry和AlphaProof虽然达到了银牌标准,但需要人类专家先将自然语言的题目“翻译”成AI能理解的Lean等形式化语言。而今年的Gemini,则实现了端到端的突破,直接读取并理解用自然语言描述的官方题目,然后直接生成严谨的、人类可读的数学证明。这标志着AI的推理能力向人类的直觉和灵活性迈进了一大步

竞赛级效率:

去年的系统需要数天的计算时间。而今年的模型,在4.5小时的竞赛规定时间内就完成了所有解题和证明生成

官方认证,无可争议:

博客明确指出,其模型结果由IMO协调员使用与学生解决方案相同的标准进行官方评分和认证,IMO 主席 格雷戈尔·多利纳尔教授博士:

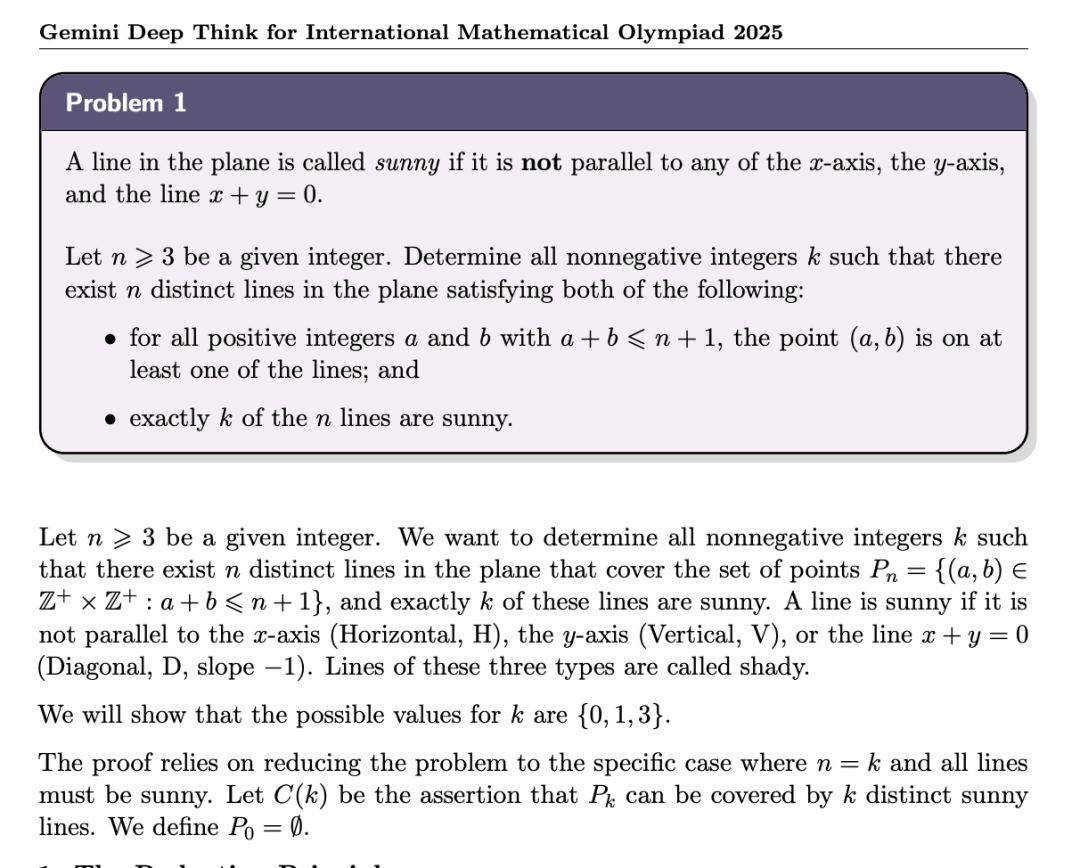

这是谷歌发布的解题过程,有13页pdf,我反正是看不懂,数学大神请享用挑刺:

https://storage.googleapis.com/deepmind-media/gemini/IMO_2025.pdf

谷歌的官宣与OpenAI的抢跑

OpenAI在IMO闭幕式前突然宣称,其一个内部实验模型也达到了金牌水平。然而,这一行为立刻引发了巨大争议:

无视规则: 据悉,IMO组委会曾明确要求OpenAI不要在闭幕式前发布结果,但OpenAI并未听从

缺乏认证: OpenAI的成绩完全是“自我报告”,并未经过IMO官方的独立验证和评分

方法论不透明: 其模型和方法并未在赛前进行任何披露。

这一系列骚操作引来陶哲轩(Terence Tao)的公开回应,也就不奇怪他在社交媒体上对OpenAI的态度了:

对于任何没有在赛前披露其方法论的、自我报告的AI竞赛成绩,我将不予置评。

陶哲轩内心戏:你他么既当裁判又当运动员,难道我不懂吗?

金奖背后

谷歌是如何实现这一惊人飞跃的?答案是深度思考Deep Think 高级模式

平行思考(Parallel Thinking): Deep Think高级模式能让模型不再局限于单一的线性推理路径。它可以同时探索和组合多种可能的解决方案,就像一个顶尖数学家在脑中同时演算几条解题思路,最终选择最优的一条

强化学习与高质量数据: 谷歌通过新颖的强化学习技术,专门针对多步推理、问题解决和定理证明数据对Gemini进行了训练。同时,还为其提供了大量高质量的数学问题解决方案语料库。

研发团队还在模型的指令中加入了一些关于如何解决IMO问题的通用提示和技巧

所以最后,问大家一个问题,AGI还有多远?

参考:

https://deepmind.google/discover/blog/advanced-version-of-gemini-with-deep-think-officially-achieves-gold-medal-standard-at-the-international-mathematical-olympiad/

(文:AI寒武纪)