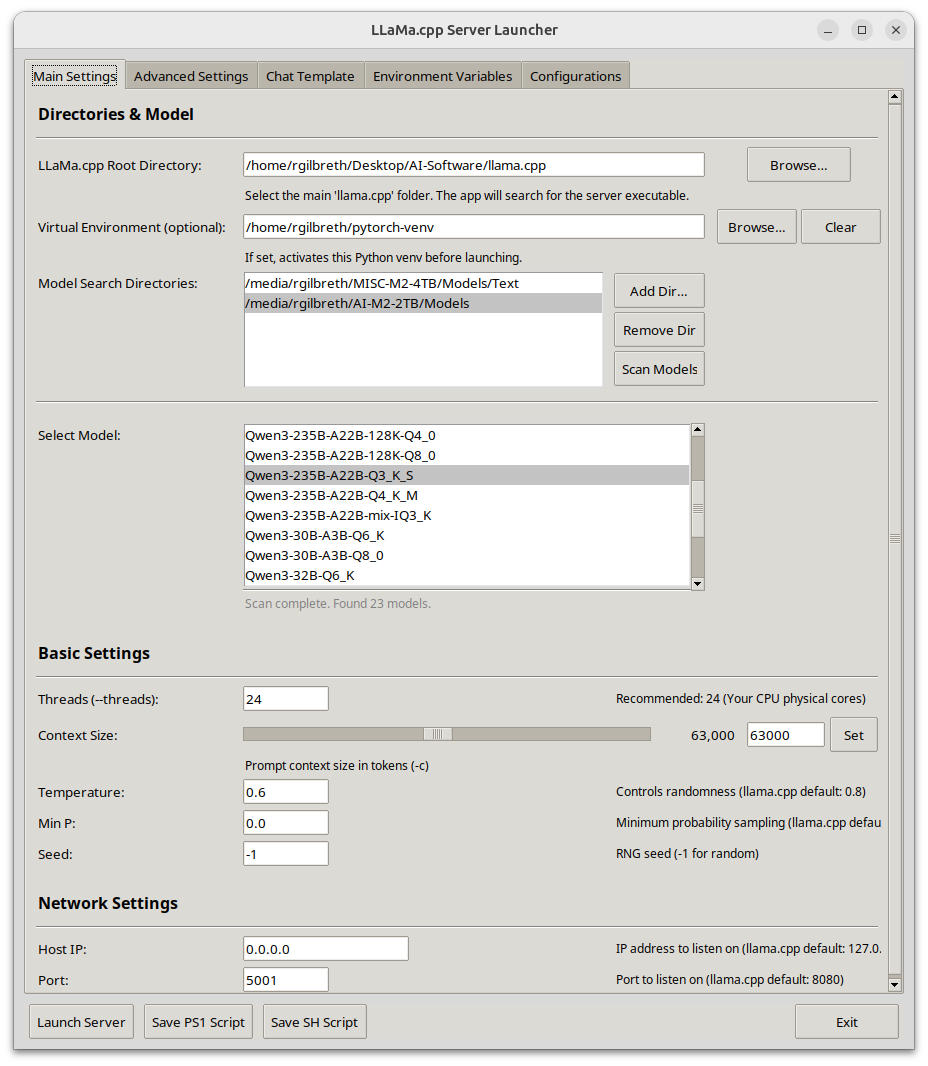

终于有人给 llama.cpp 的配置写一个界面了,llama.cpp 的配置已经跟 nginx 等web server 一样复杂了。然后就有了这个项目 llama-server-launcher。简单来讲,这个项目能让你点点鼠标就选择你要运行的模型,要多少线程,上下文大小,温度,要不要GPU卸载,batch size 等,节省查手册的时间。

参考文献:

[1] 项目地址:https://github.com/thad0ctor/llama-server-launcher

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)