新智元报道

新智元报道

【新智元导读】Hyper-YOLO是一种新型目标检测方法,通过超图计算增强了特征之间的高阶关联,提升了检测性能,尤其在识别复杂场景下的中小目标时表现更出色。

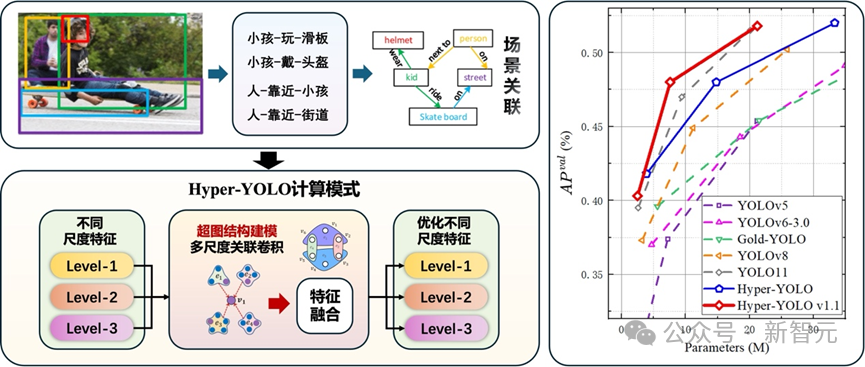

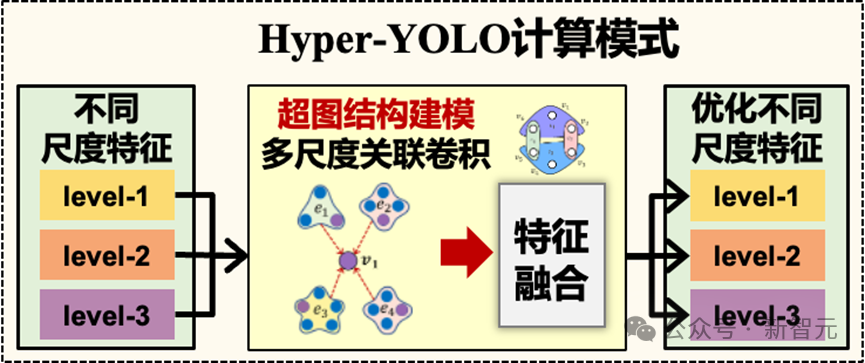

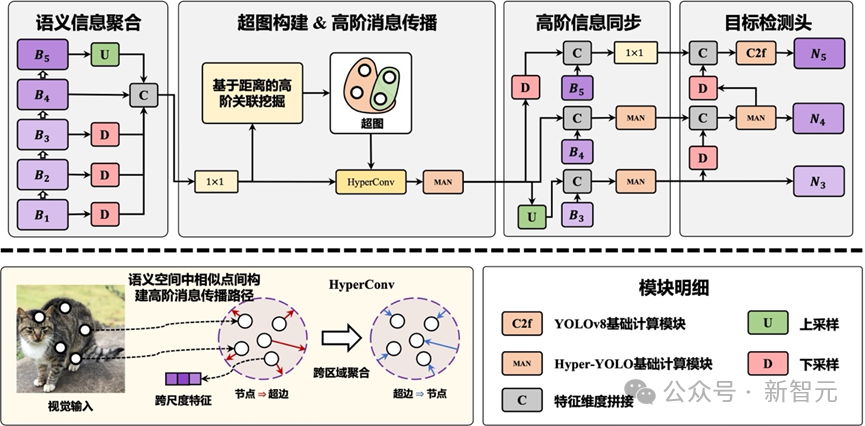

为了解决这一难点,清华大学提出了Hyper-YOLO:一种基于超图计算的目标检测方法。Hyper-YOLO首次将超图计算集成到目标检测网络,对特征图中的复杂高阶关联进行建模,实现了高阶信息的跨层次和跨位置传播。

零代码平台:http://hyperyolo.gaoyue.org:28501/#/predict

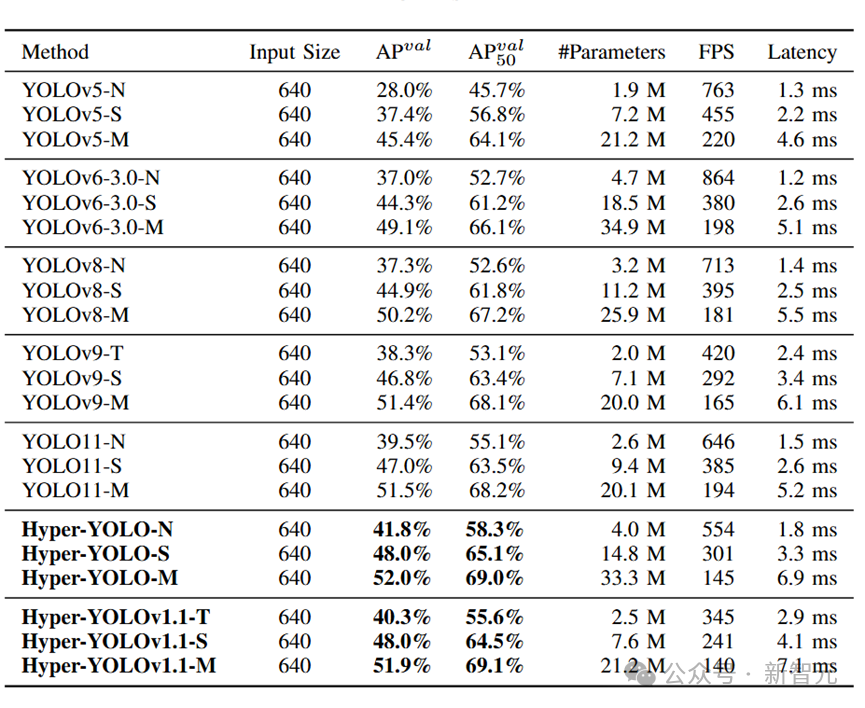

使用超图计算结合YOLO,性能在各种规模模型中都达到顶尖,在COCO数据集上的表现明显优于其他模型,尤其是对中小目标提升更加显著。其中,相比于最新的YOLOv9-T、YOLO11-S,同规模的Hyper-YOLO分别实现了2%和1%的平均精度提升。

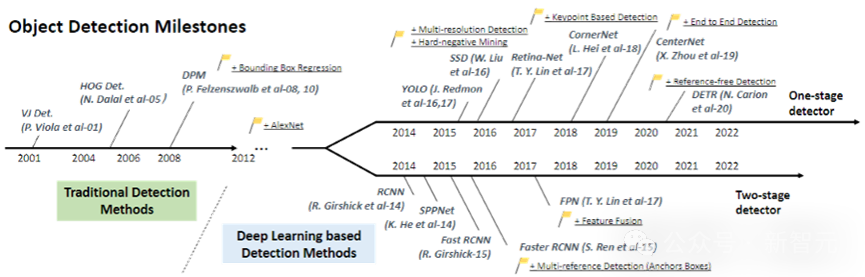

目标检测的困境

然而,随着应用场景的复杂化,现有的YOLO模型在处理跨层次特征融合和高阶特征关系时暴露出了一定的局限性。

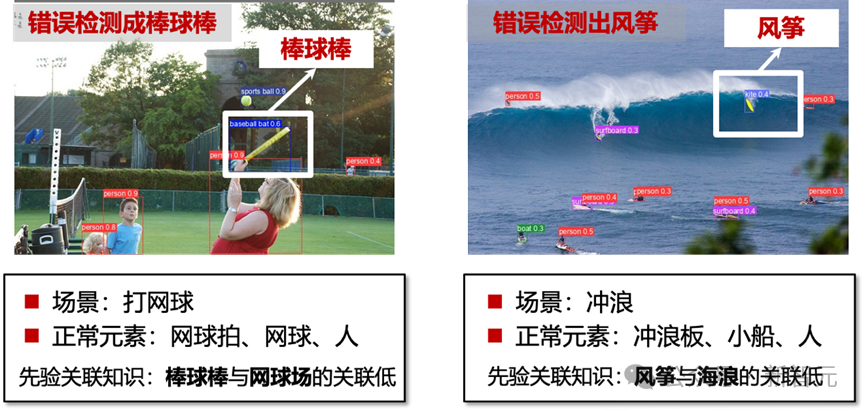

下图展示了几个典型的案例 (YOLOv8为例)。在打网球的场景中,现有模型将网球拍误判为了棒球棒;在冲浪的场景中,现有模型将冲浪板误判为了风筝。这种错误正是由于现有的模型难以捕捉视觉对象之间的复杂关系。

因而,不同目标间的高阶语义关联推理限制了目标检测的性能。

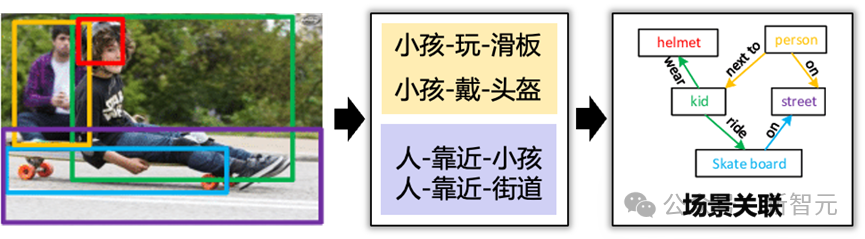

高阶关联的建模方法

超图覆盖了多种关联,是复杂关联计算的有效方法。在Hyper-YOLO中,作者首次将超图计算引入目标检测领域,以实现视觉高阶语义关联的建模与学习。

模型效果

该工作在COCO数据集上进行了丰富的实验。Hyper-YOLOv1.1提供了3种规模的版本(Tiny, Small , Medium),在对比实验中,均明显优于最新的YOLO模型。

其中,Tiny版本的平均精度(mAP)指标相比于YOLOv8、YOLOv9、YOLO11的同规模版本分别提升3.0%、2.0%、0.8%;Small版本的mAP指标相比于YOLOv8、YOLOv9、YOLO11的同规模版本分别提升3.1%、1.2%、1.0%。此外,对于骨干网络、Kernel大小、特征增强策略、超图构建策略的消融实验证明了所提出的方法的先进性。

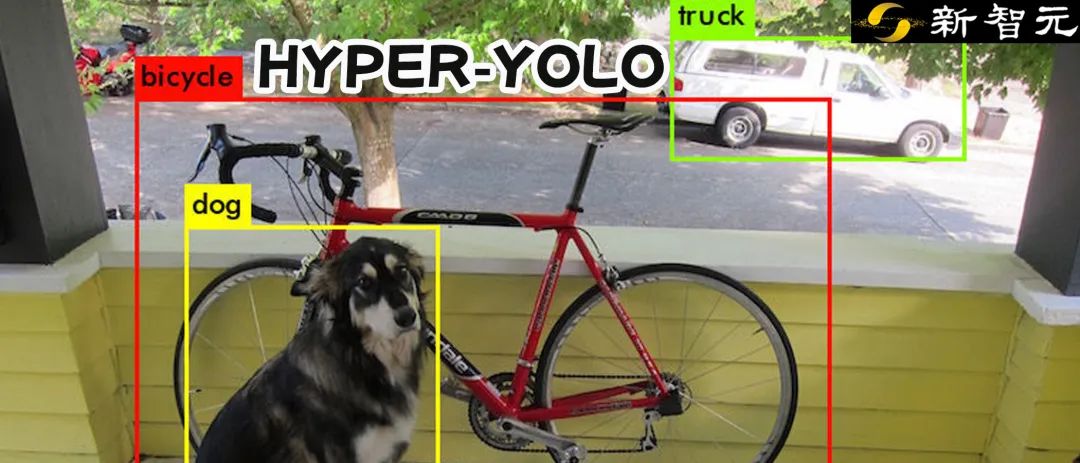

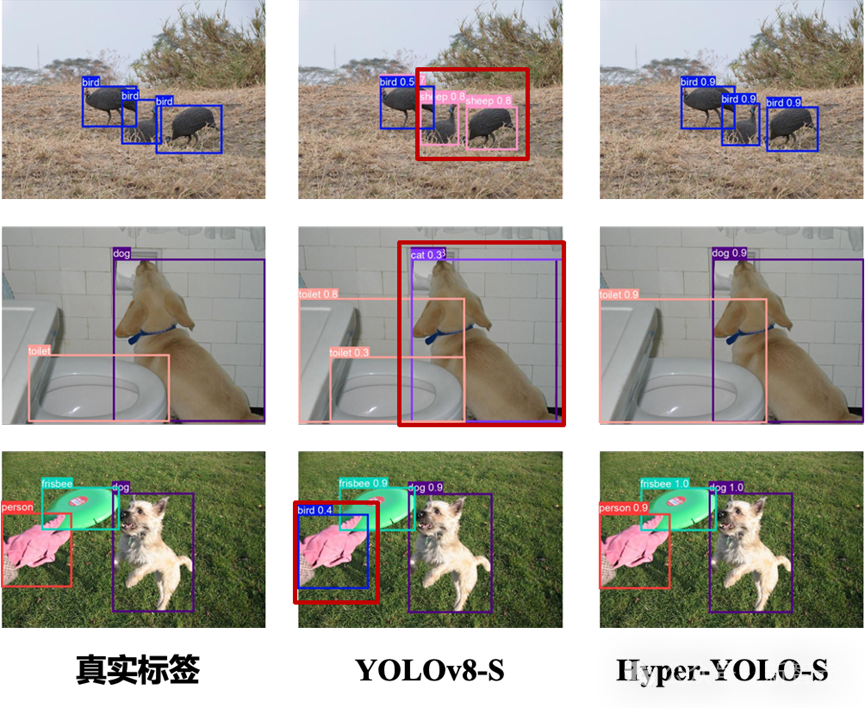

以下两图为YOLOv8、Hyper-YOLO在目标检测和实例分割任务下的可视化结果。

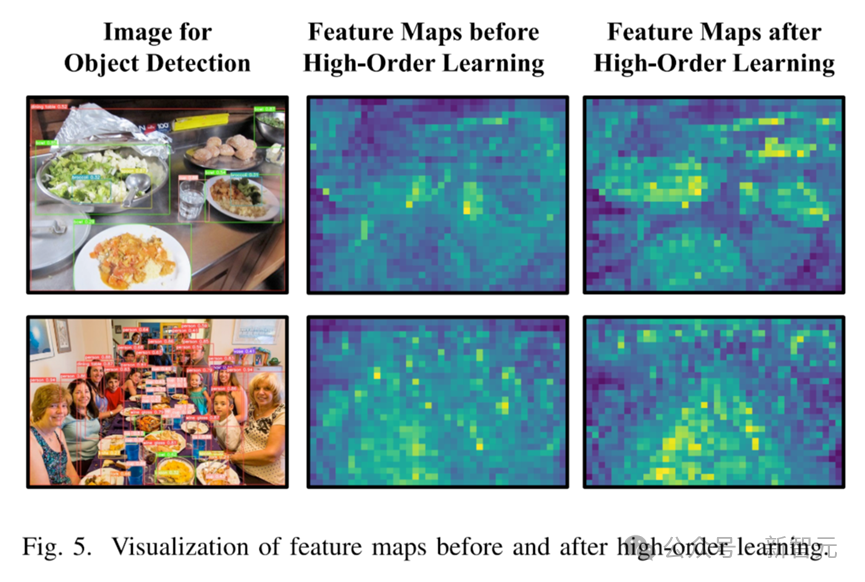

下图为使用高阶关联学习对特征图增强前后的可视化图(通过HyperC2Net前后的特征图)。

上述实验结果证明,Hyper-YOLO具有目前最先进的检测性能,尤其对场景中不同视觉对象的高阶关系具有更准确的理解能力。

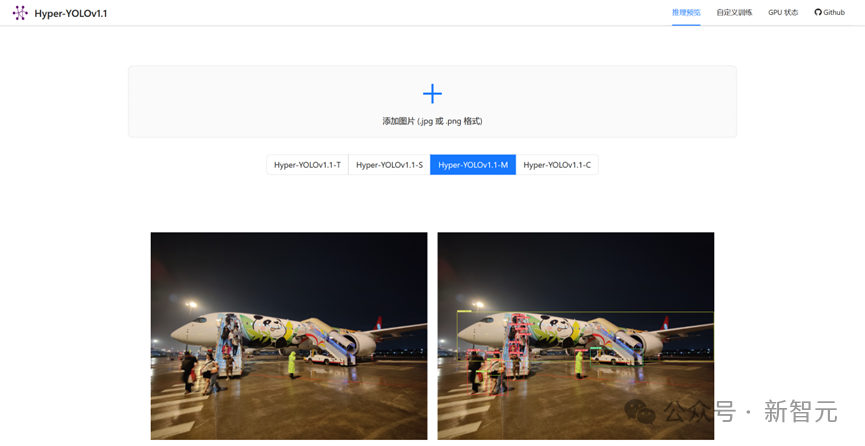

Hyper-YOLO零代码平台

智能媒体与认知实验室还推出了一款基于Hyper-YOLO的零代码训练平台。在该平台上,无需配置环境、修改配置文件等繁琐操作,既可以一键上传图像利用训练好的Hyper-YOLO模型进行推理,也可以上传数据集自定义训练、直观展示训练过程。(推荐使用PC端chrome/Edge浏览器)

项目链接:http://hyperyolo.gaoyue.org:28501/#/predict

方法概述

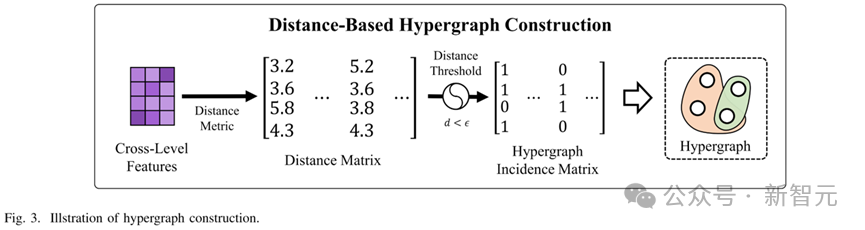

超图计算

1. 从原始数据构建超边

2. 从顶点到超边的消息聚合(超边卷积)

总结

Hyper-YOLO通过引入超图计算方法,突破了传统YOLO模型在多尺度特征融合上的局限。超图的高阶关联建模能力使得HyperC2Net能够在跨层次和跨位置的信息传播中表现出色,不仅在特征点之间实现高效的信息聚合和分发,还通过跨层次的消息传递显著提升了目标检测性能,尤其在处理复杂场景和多目标检测任务中表现优异。

(文:新智元)