MME团队 投稿

量子位 | 公众号 QbitAI

逻辑推理是人类智能的核心能力,也是多模态大语言模型 (MLLMs) 的关键能力。随着DeepSeek-R1等具备强大推理能力的LLM的出现,研究人员开始探索如何将推理能力引入多模态大模型(MLLMs)。

然而,现有的benchmark大多缺乏对逻辑推理类型的明确分类,以及对逻辑推理的理解不够清晰,常将感知能力或知识广度与推理能力混淆。

在此背景下,复旦大学及香港中文大学MMLab联合上海人工智能实验室等多家单位,提出了MME-Reasoning,旨在全面的评估多模态大模型的推理能力。

结果显示,最优模型得分仅60%左右。

MME-Reasoning:全面评估多模态推理能力

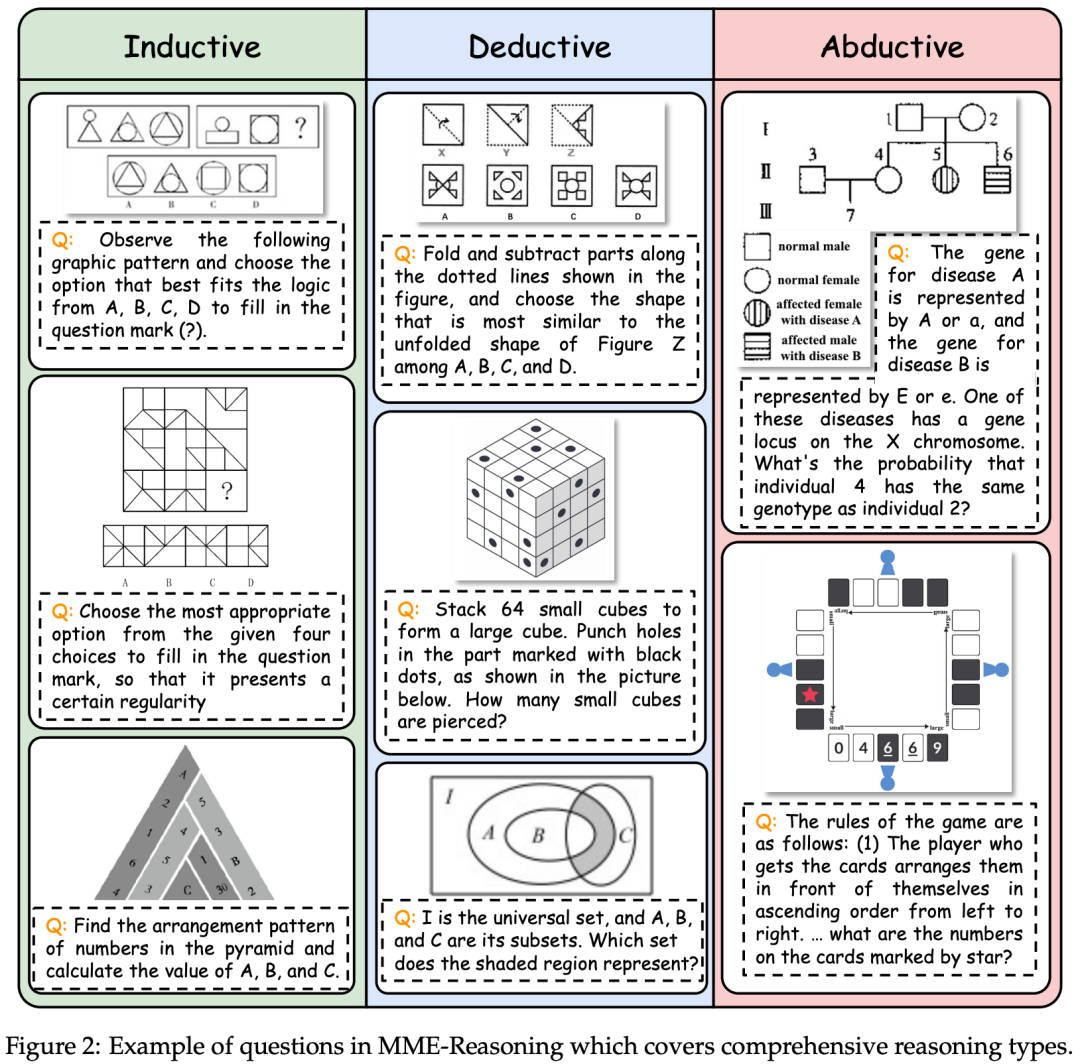

根据Charles Sanders Peirce的分类标准,推理分为三类:演绎推理 (Deductive)、归纳推理 (Inductive) 以及溯因推理 (Abductive)。

- 演绎推理 (Deductive reasoning)

使用规则和前提来推导出结论。 - 归纳推理 (Inductive reasoning)

借由大量的前提和结论所组成的例子来学习规则。 - 溯因推理 (Abductive reasoning)

借由结论和规则来找到前提以解释结论。

MME-Reasoning以此分类作为标准来全面的测评多模态大模型的推理能力。

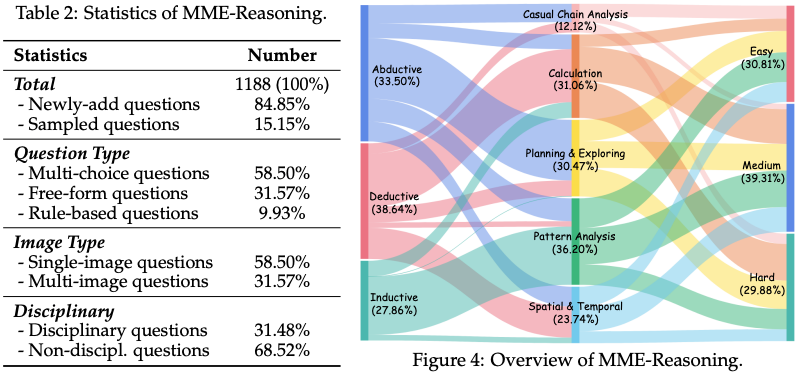

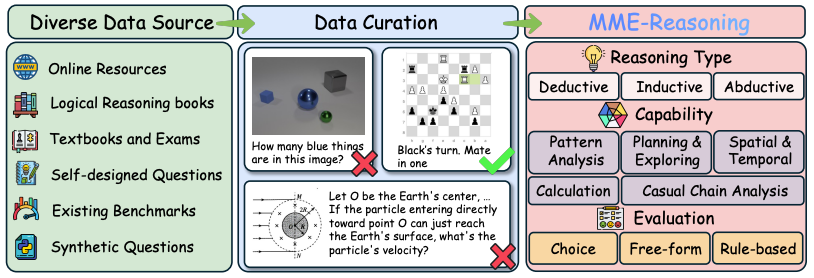

MME-Reasoning全面涵盖三种推理类型 (归纳、演绎和溯因) 并包括三种问题类型 (选择题、自由形式和基于规则验证的题目)。

进一步,根据难度,MME-Reasoning被分为三个难度级别。

为了更加全面的测评,并避免由于学科知识的复杂程度干扰对推理能力的测试,MME-Reasoning按照以下标准进行设计:

-

全面性:评估应覆盖包含归纳、演绎和溯因三种推理类型的丰富推理场景,以实现全面考察。

-

超越感知:确保答案需要由通过推理得出,而非单纯依赖视觉识别或感知层面的判断。

-

弱化知识依赖:避免对复杂领域知识的要求(K12及以下),以防模型因知识盲区而产生错误回答。

-

评估方式多样化:评估基准应支持多种验证形式,涵盖不同类型的推理任务,以更全面地反映模型的推理能力。

通过在广泛数据来源 (教科书、互联网、逻辑练习题、程序合成、重新出题等) 中根据上述标注进行筛选并标注,MME-Reasoning最终由1188个题目构成,每道题目的标注都包含了推理类型、难度、题目类型。此外,作者对题目考验的能力进行了分类,包含模式分析、规划与探索、空间与时间、计算、因果链分析五类并对每道问题进行标注 (问题可能考察一个或多个上述能力)。

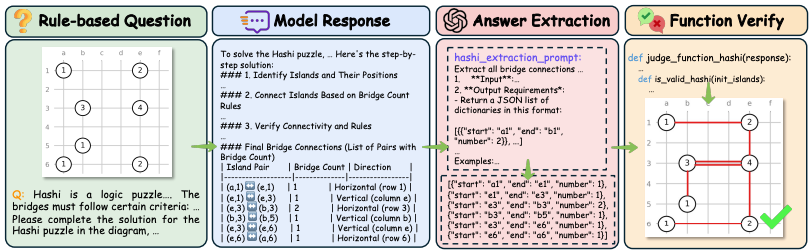

在评测方式上,所有的回答都先经过GPT抽取答案。对不同的题目类型,通过不同的方式进行判断:

-

选择题:直接匹配抽取的答案和正确答案来判断正误。 -

开放题:利用GPT进行判断抽取的答案和正确答案是否一致。 -

基于规则的题目:作者对每种基于规则的题目设计了prompt以及评测函数,通过GPT抽取为中间形式之后,利用专有的函数进行判断回答是否正确。

评测结果

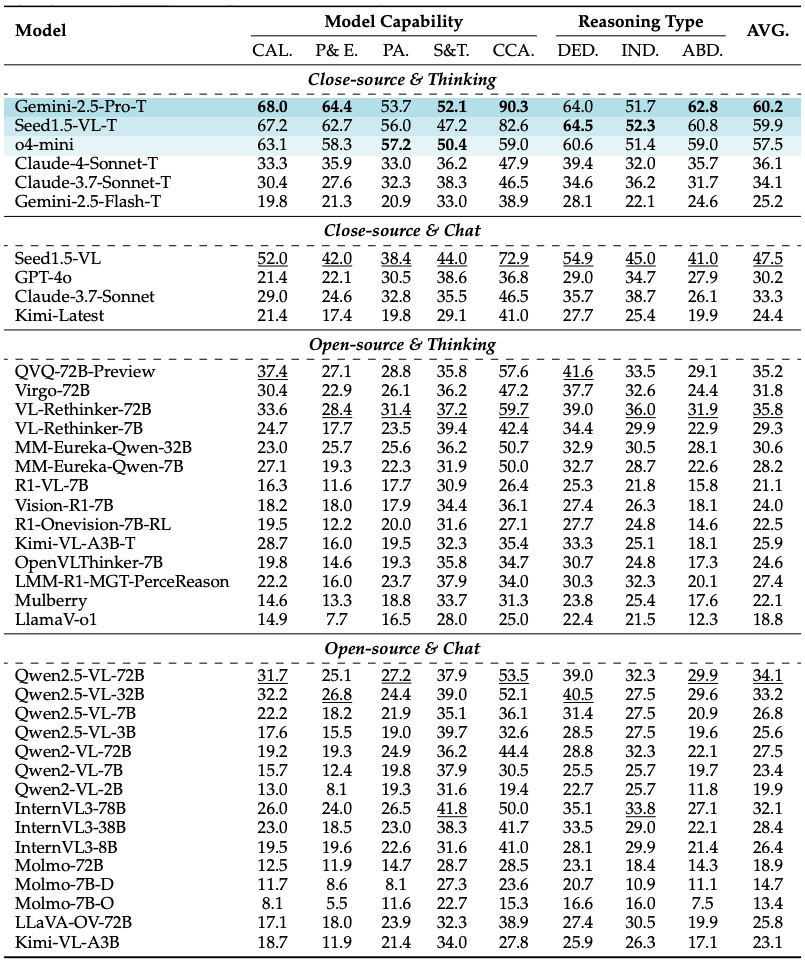

文中对30+个模型进行了评测包括:

-

推理模型:o4-mini、Gemini-2.5-Pro-Thinking、Seed1.5-VL-Thinking等。 -

对话模型:GPT-4o、Qwen系列、Claude等。 -

基于规则的强化学习模型:R1-VL、OpenVLThinker、MM-Eureka等。

通过评测,作者发现MME-Reasoning对视觉-语言推理提出了极大挑战:当前最优模型得分仅60%左右,显示该基准对模型逻辑推理能力要求极高,能全面考察三种不同推理类型。

此外,多模态大模型逻辑推理能力存在显著偏差,模型普遍在演绎推理上表现较好,但溯因推理能力明显较弱,尤其是开源模型,溯因推理成为整体推理能力的瓶颈。

以及开放式推理场景下模型表现有限,模型在计划与探索类任务上表现较差,暴露了当前模型在开放式问题求解中的短板。

基于规则的强化学习效果有限,尽管规则强化学习能激活模型的“思考模式”,但在7B规模模型上未必提升推理表现,甚至可能降低泛化能力,表明训练范式创新亟需突破。

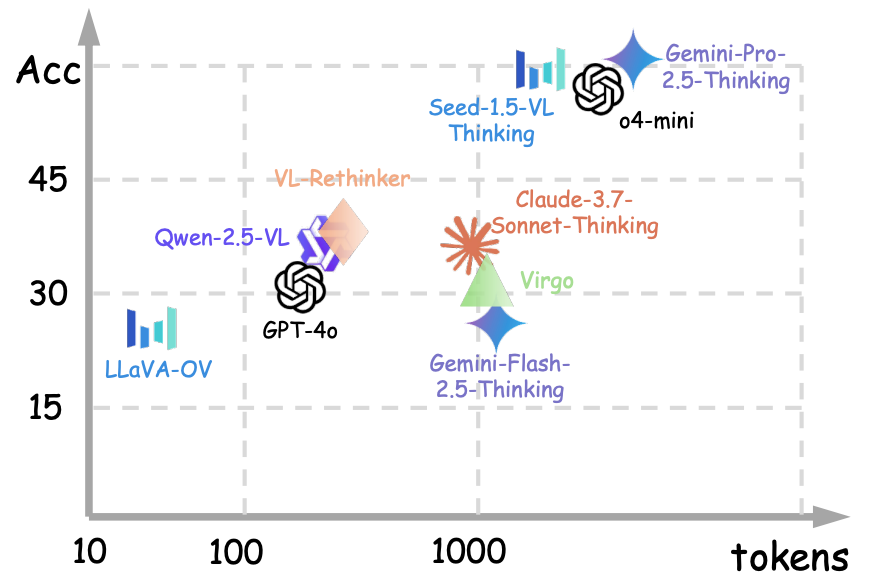

而“思考模式”显著提升逻辑推理能力,采用链式思维、反思和自我纠错等“思考模式”的模型,推理表现普遍优于基础版本,尤其在闭源模型中提升更为明显。

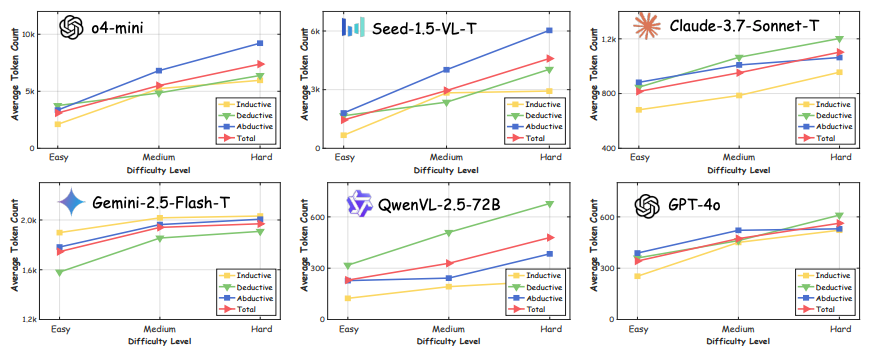

此外,通过对回答所需token数量的分析,发现虽然推理过程加长有助于提升准确率,但是这种提升效果存在边际递减随着输出长度增加,但收益逐渐减小,同时带来计算成本显著增加。

同时,随着推理难度的提升,模型所需的token数量也会明显提升。

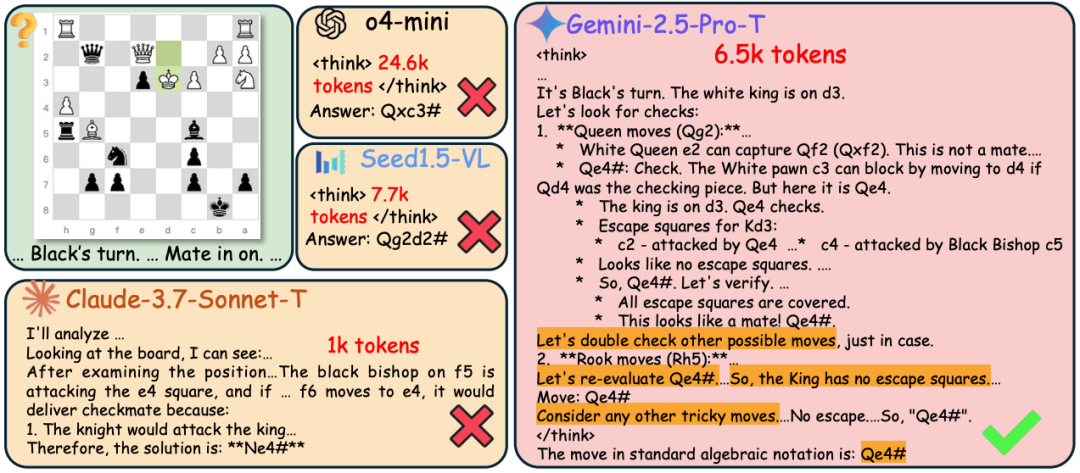

对不同模型在MME-Reasoning上的Case study的分析显示:

较长的推理过程:所选模型在响应中生成超过1k个token,其中o4-mini生成高达24.6k个token。这表明MME-Reasoning构成了一个高度具有挑战性的多模态推理基准。

推理中的规划行为:响应包括多个“假设生成-可行性验证-检查与反思”迭代,表明模型自发地参与结构化规划和反思,以在开放式问题解决空间内探索解决方案。

重复反思:模型倾向于多次重新访问和反思相同的推理路径——在某些情况下多达7次。这种行为可能会导致显著的计算开销和信息冗余。

论文链接:https://arxiv.org/pdf/2505.21327

代码链接:https://github.com/Alpha-Innovator/MME-Reasoning

数据集链接:https://huggingface.co/datasets/U4R/MME-Reasoning

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

(文:量子位)