H800

刚刚,DeepSeek 首次披露成本利润率!还有大量技术细节

DeepSeek 揭示其模型推理系统成本利润率高达545%,通过优化硬件配置、动态资源调度和采用大规模跨节点专家并行技术,实现了高吞吐量和低延迟。

DeepSeek开源第二天,主打一个硬核开源。

今天是DeepSeek开源周的第二天,Alibaba的QwQ-Max预览版引起了关注。DeepEP项目在GPU上实现了显著性能提升,并且已获1000+ GitHub星。DeepSeek强调硬件效率和低延迟通信,其新开源技术让数据传输和计算实现重叠。

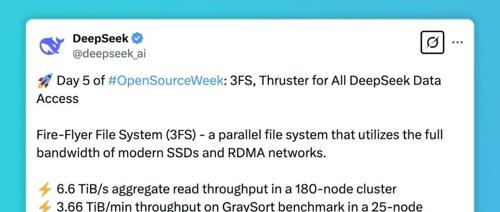

DeepSeek开源第二弹,为MoE和EP量身定制的通信库!暂和英伟达显卡绑定

DeepSeek开源第二弹来了!首个用于MoE模型训练和推理的开源EP通信库DeepEP提供高吞吐量和低延迟的all-to-all GPU内核,支持低精度运算包括FP8。性能方面涵盖高效和优化的all-to-all通信、NVLink和RDMA的支持、预填充任务和推理解码任务等。团队建议使用Hopper GPUs及更高版本Python 3.8及以上CUDA 12.3及以上PyTorch 2.1及以上环境,并提供详细的使用指南。

DeepSeek开源周第一天:FlashMLA开源,解锁H800性能上限,提升存量GPU算力

DeepSeek开源首个项目FlashMLA,针对英伟达Hopper GPU优化MLA解码内核,提升LLM模型在H800上的性能。

“源神”DeepSeek!突破H800性能上限,FlashMLA重磅开源,算力成本还能降

DeepSeek开源FlashMLA第一天,H800 GPU计算性能提升至3000GB/s、580TFLOPS。网友称赞工程团队实现每FLOP的突破。