大模型

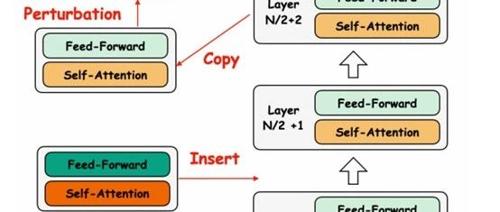

地平线提出AlphaDrive,首个基于GRPO强化学习和规划推理实现自动驾驶大模型

OpenAI的o1和DeepSeek的R1模型在复杂领域达到人类专家水平,AlphaDrive提出一种强化学习和推理训练框架用于自动驾驶规划,显著提升规划准确率并降低成本。

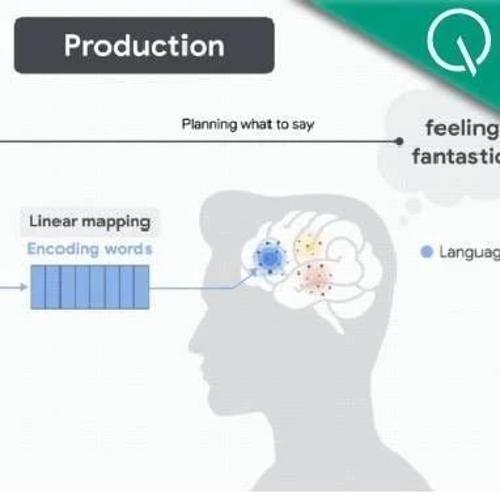

AI 把表情包都玩明白了,人类连玩梗的快乐也保不住了?

瑞典科研团队发现AI不仅能制作表情包,还能创作有趣且有创意的作品。研究结果显示AI在’有趣’和’创意性’方面得分高于人类创作者。不过,在’可分享性’上表现一般,即AI生成的表情包不太能激发人的分享欲望。

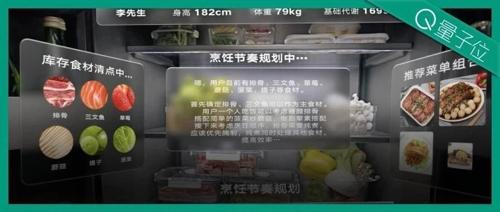

刚刚,OpenAI史上最贵API上线!o1-pro比DeepSeek-R1溢价千倍

OpenAI正式上线o1-pro API,价格高达o1-mini的近百万倍。o1-pro输入价格150美金/每百万token,输出价格600美金/每百万token,主要面向T1-T5开发者开放,具备强大的推理能力和多种功能支持。