学术

从CoT到MCoT!NUS、港中文等发布「多模态思维链」重磅综述,280篇文献深度解析

这篇综述全面梳理了MCoT的理论框架、技术方法及应用前景,为多模态AI研究提供了系统性参考。从传统的链式思维到MCoT,支持多模态数据的自由组合与协同推理,在医学诊断等领域展现出巨大潜力。

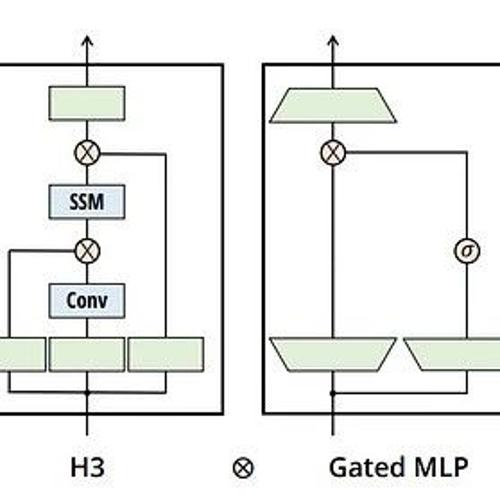

ICLR 2025 高效又稳定!人大团队提出模型剪枝新方法LLM-Streamline

模型剪枝方法LLM-Streamline通过判断层的重要性,并进行剪枝来减少模型参数量,同时使用余弦相似度和轻量级蒸馏小模型来弥补损失。该方法具有低内存消耗、合理训练方法以及新的稳定性指标等优势,相比已有方法性能更高。

2024 AAAS Fellow名单出炉:华人学者刘威入选

三位华人学者入选2024年AAAS Fellow名单,包括腾讯杰出科学家刘威、纽约城市学院教授田英利和埃默里大学教授熊莉。他们分别在计算机视觉、机器学习及数据隐私等领域做出突出贡献。

idea满满的最新Test-Time Scaling综述!全面描述What, How, Where和How Well的问题

MLNLP社区发布一篇关于Test-Time Scaling(TTS)的survey论文,介绍大语言模型在测试阶段增加计算资源的方法,让模型能够更智能地解答问题。

ICLR 2025 Spotlight |合成数据伪装术 vs 大模型火眼金睛,中大&上海AI Lab提出合成检测基准LOKI

中山大学联合上海人工智能实验室提出了LOKI,这是一个面向多模态合成数据检测的全新测试基准,涵盖图