PaperWeekly

PaperWeekly

ICLR 2025 自动化所、旷视等提出Ross,多模态大模型的MAE时刻来了?

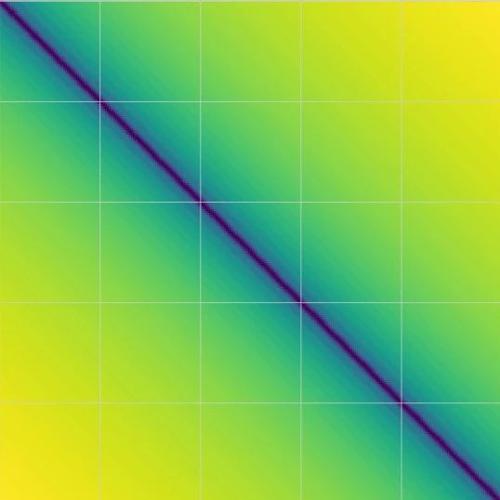

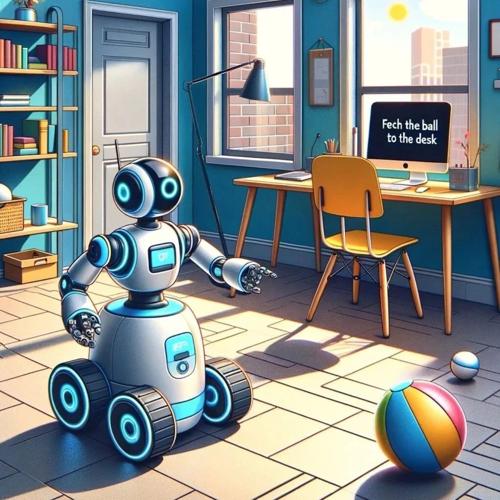

本文介绍了一篇关于多模态大模型的研究论文《Reconstructive Visual Instruction Tuning》,提出通过重建输入图像作为监督信号来提升视觉部分的学习效果,显著提高模型的细粒度理解能力,并且代码已开源。

无需RLHF显著提升GPT-4性能,北大团队提出对齐新范式「残差修正」 NeurIPS 2024 Oral

学习对齐答案和未对齐答案之间的残差,要比直接学习问题到答案之间的映射更容易。

背景

当下大语言模型(

阶跃多模态团队提出「慢感知」概念:迈向视觉system2 (o1) 的第一步

论文提出慢感知概念,通过分解和流动感知几何图形来提高视觉系统2的精细感知能力。研究显示,慢感知能提升模型对几何线段的解析能力,并在多种指标上优于基线方法。

国产模型如何追上多模态OpenAI o1?你需要知道的全在这

Kimi 团队发布了最新的多模态推理大模型 Kimi k1.5,其性能与正式版 o1 最为接近。通过 Long2Short 技术,该模型能够在有限的 token 预算下实现高性能推理,提升用户体验和资源利用效率。

354篇参考文献!史上最详尽综述:视觉定位任务十年发展系统性回顾

本综述系统性回顾了视觉定位(Visual Grounding)任务过去十年的发展历程,涵盖多种设置如全监督、弱监督、半监督等,并分析了各种数据集的表现。