多年之后,OpenAI 终于再次开源了!

就在刚刚,继Claude Opus 4.1 发布之后,OpenAI一口气发布了两个开源模型:gpt-oss-120b和gpt-oss-20b,直接把顶尖AI能力塞进每个人的电脑里。

这次终于不是挤牙膏式的简单开源,而是或将改变开源游戏规则——

120B版本性能媲美o4-mini,却能在单张H100 GPU上运行;而20B版本更是能在个人笔记本电脑上跑起来,甚至手机都能带动!

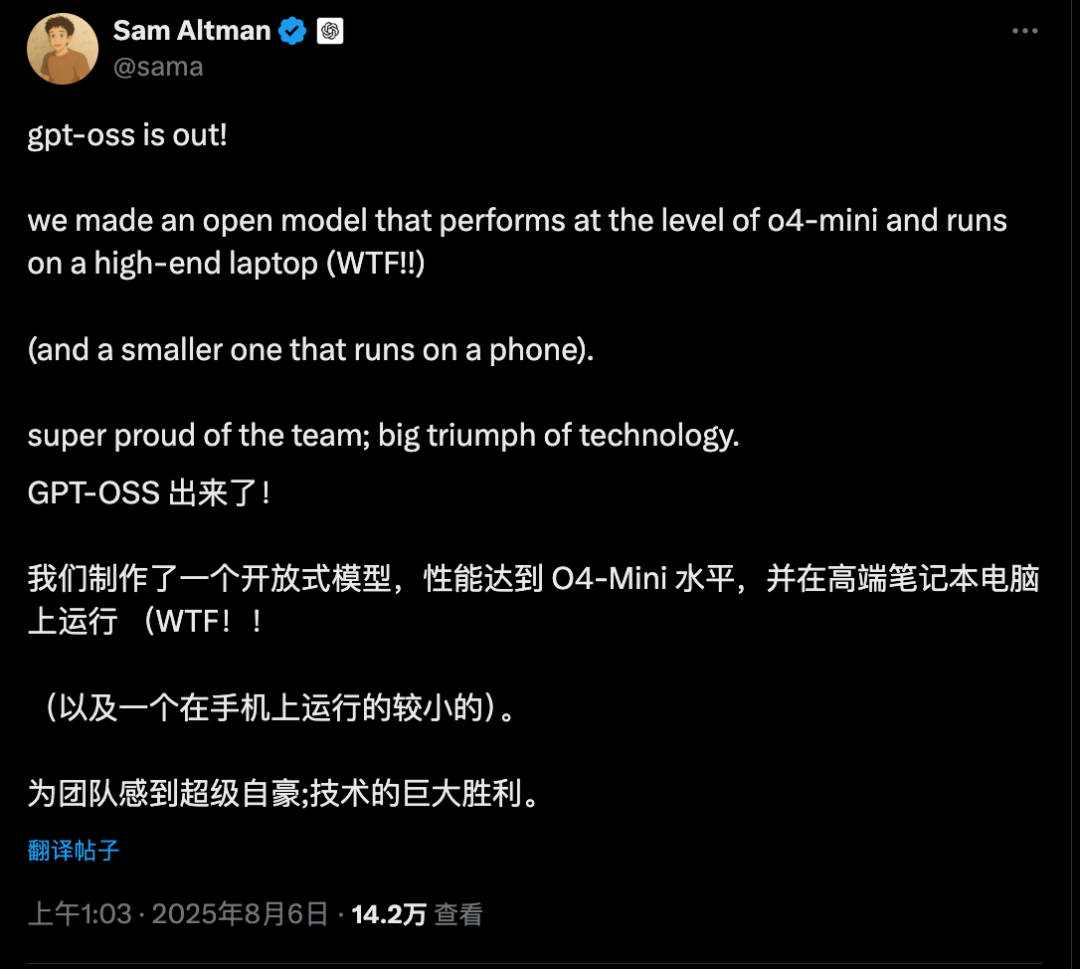

Sam Altman(@sama)激动地宣布:

gpt-oss发布了!我们做了一个开源模型,性能达到o4-mini的水平,可以在高端笔记本电脑上运行(WTF!!)(还有一个更小的可以在手机上运行)。为团队感到超级自豪;这是技术的巨大胜利。

两个版本,各有千秋

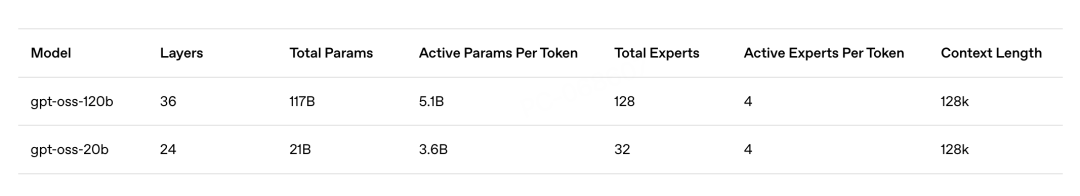

gpt-oss-120b拥有1170亿参数,但只激活51亿参数,专为生产环境和高推理任务设计。而gpt-oss-20b则是210亿参数,激活36亿参数,主打低延迟和本地运行。

两个模型都基于OpenAI的harmony响应格式训练,必须配合harmony格式使用才能正常工作。

最为关键的是,它们都采用了Apache 2.0许可证——

这意味着你可以自由地用它们做实验、定制,甚至商业部署,完全没有版权限制。

MOE 稀疏架构

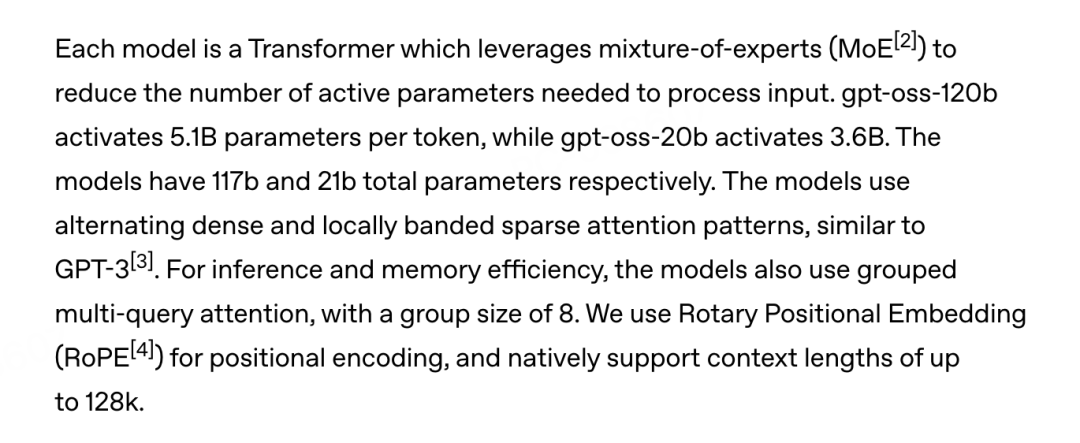

这两个模型都是基于Transformer架构,采用了混合专家(MoE) 技术来减少处理输入时所需的活跃参数数量。

具体参数为:

-

gpt-oss-120b:36层,总计1170亿参数,每个token激活51亿参数,128个专家,每次激活4个

-

gpt-oss-20b:24层,总计210亿参数,每个token激活36亿参数,32个专家,每次激活4个

两个模型都使用了与GPT-3类似的交替密集和局部带状稀疏注意力模式,还采用了分组多查询注意力(组大小为8)来提高推理和内存效率。

它们使用旋转位置嵌入(RoPE)进行位置编码,原生支持高达128k的上下文长度。

OpenAI还同时开源了o200k_harmony分词器,这是他们用于o4-mini和GPT-4o的分词器的超集。

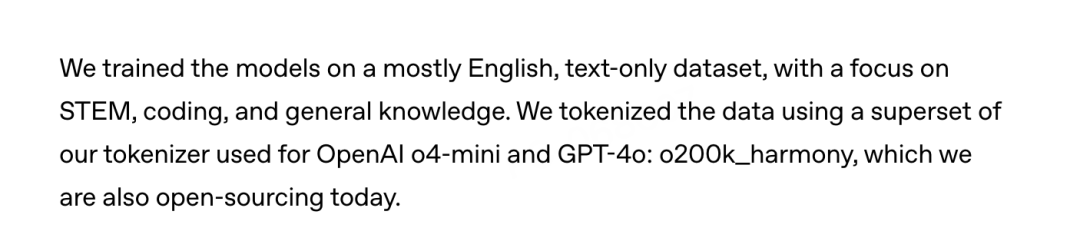

模型在以英文为主的纯文本数据集上训练,重点关注STEM、编程和通用知识领域。

后训练设计

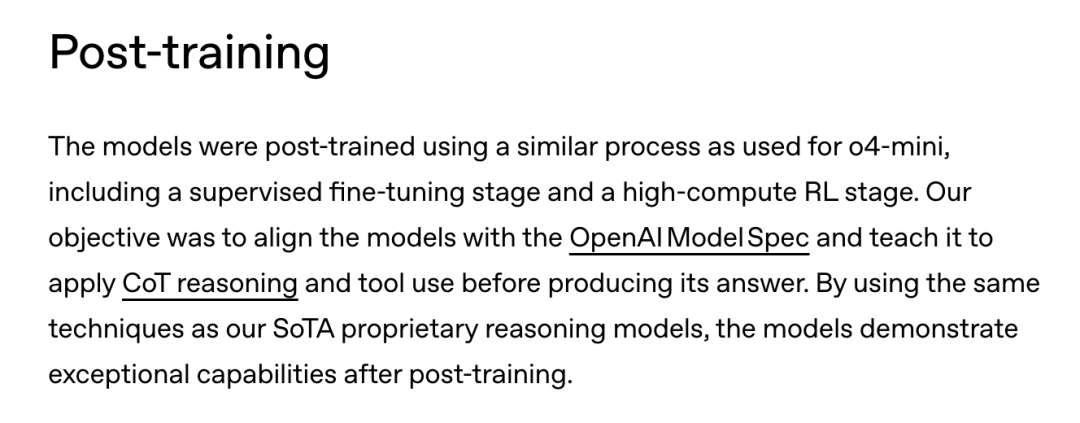

模型的后训练过程与o4-mini相似,包括监督微调阶段和高计算量的强化学习阶段。

OpenAI的目标是让模型与OpenAI Model Spec对齐,并教会它在生成答案前应用思维链推理和工具使用。

通过使用与最先进专有推理模型相同的技术,这些模型在后训练后展现出了卓越的能力。

与API中的o系列推理模型类似,这两个开源模型支持低、中、高三种推理强度,可以在延迟和性能之间进行权衡。

性能强悍

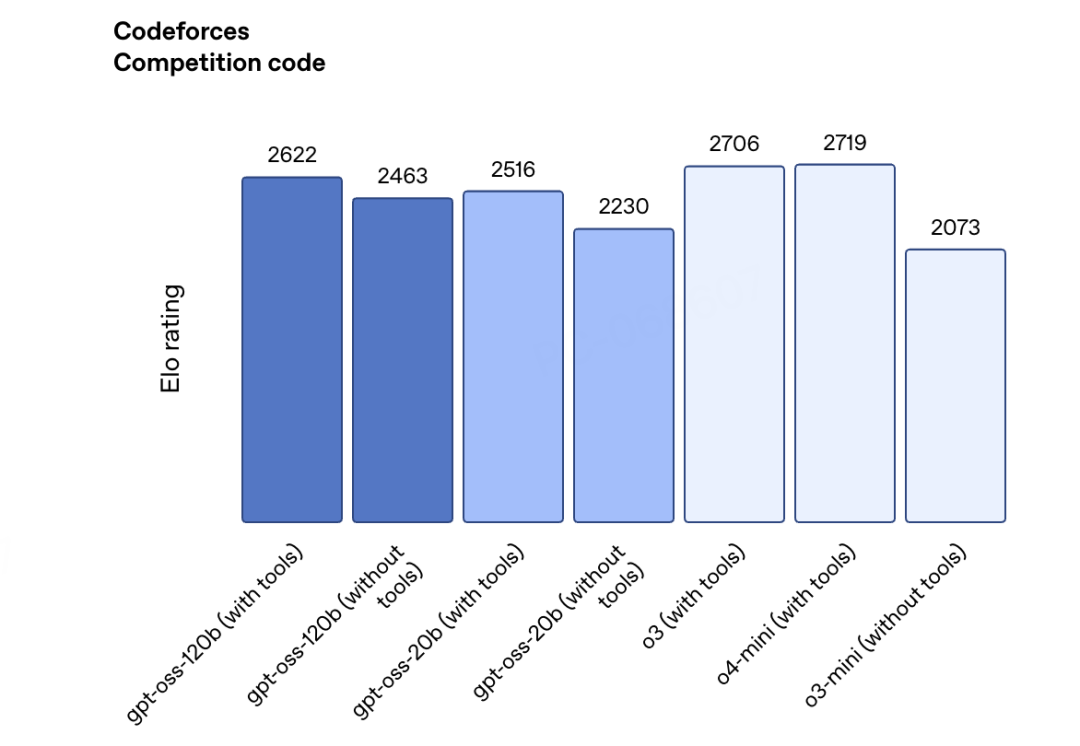

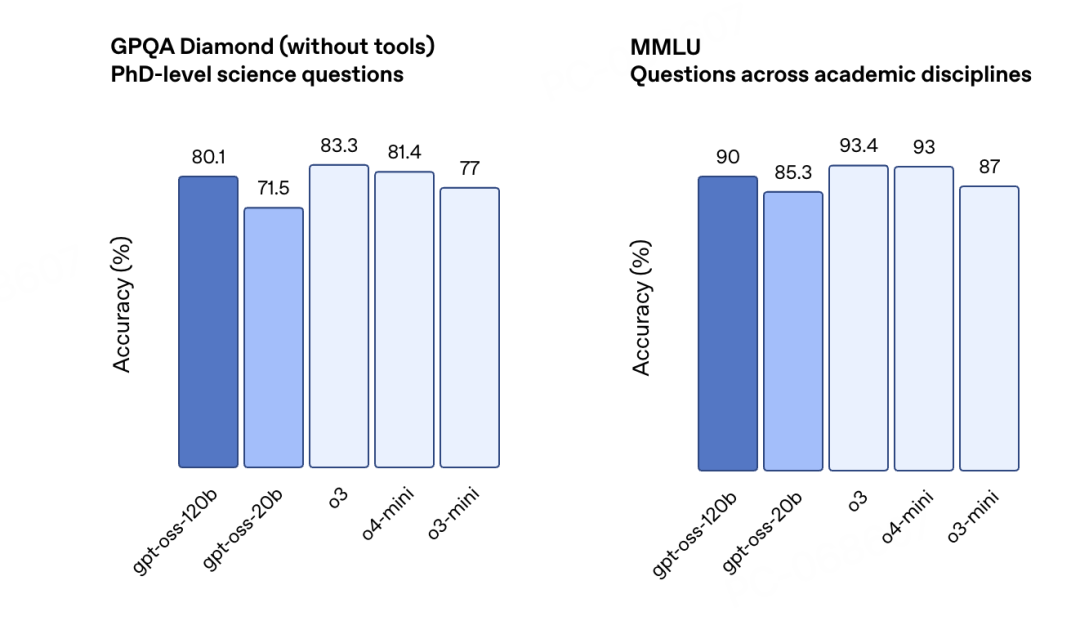

在评估测试中,gpt-oss展现出了惊人的实力。

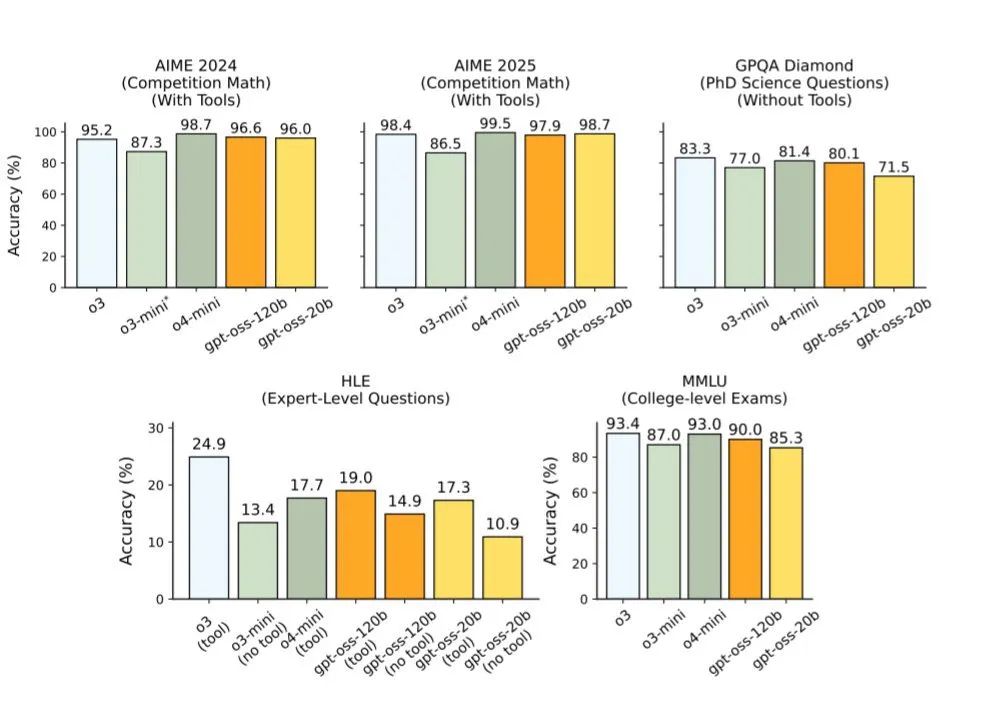

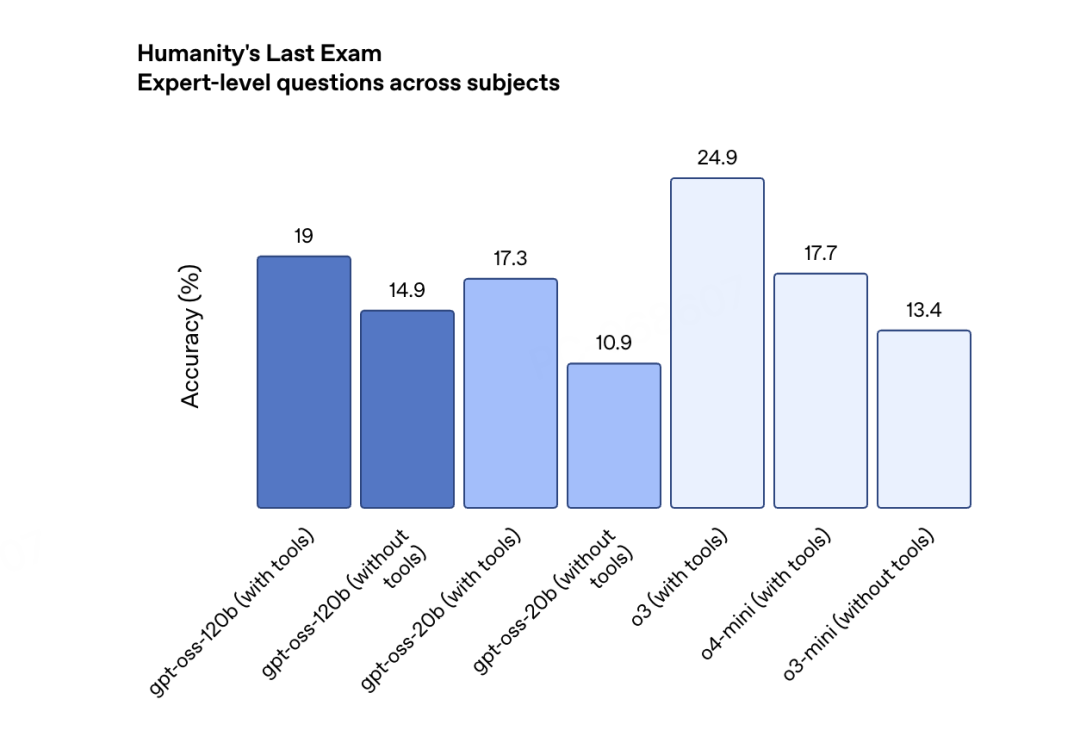

gpt-oss-120b在多个关键基准上超越了OpenAI o3-mini,与o4-mini持平甚至更优。

在竞赛编程(Codeforces)上,gpt-oss-120b(带工具)达到2622 Elo评分,超过了o4-mini的2719和o3-mini的2073。

在HLE 中也有极好表现,120b 版本甚至超过了o4-mini 模型:

在通用问题解决(MMLU和HLE)和工具调用(TauBench)上表现同样出色。

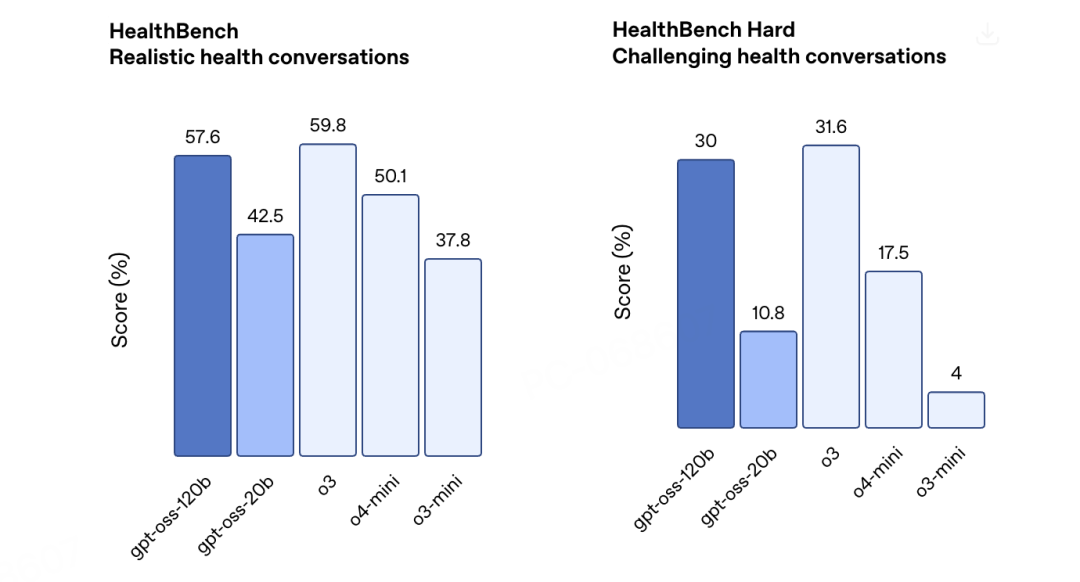

在健康相关查询(HealthBench)和竞赛数学(AIME 2024 & 2025)上,gpt-oss-120b的表现也优于o4-mini。

也就是说,一个开源模型在某些任务上已经超越了OpenAI的闭源产品。

gpt-oss-20b虽然体积小巧,但实力不容小觑。

它在多个评估上与OpenAI o3-mini持平或超越,特别是在竞赛数学和健康领域表现更为出色。

即使不使用工具,gpt-oss-20b也能达到2230的Codeforces评分,接近o3-mini的2073。

总体看来,这次开源,也算颇有诚意了!

安全优先的开源策略

Eric Wallace(@Eric_Wallace_)透露这次发布背后的深思熟虑:

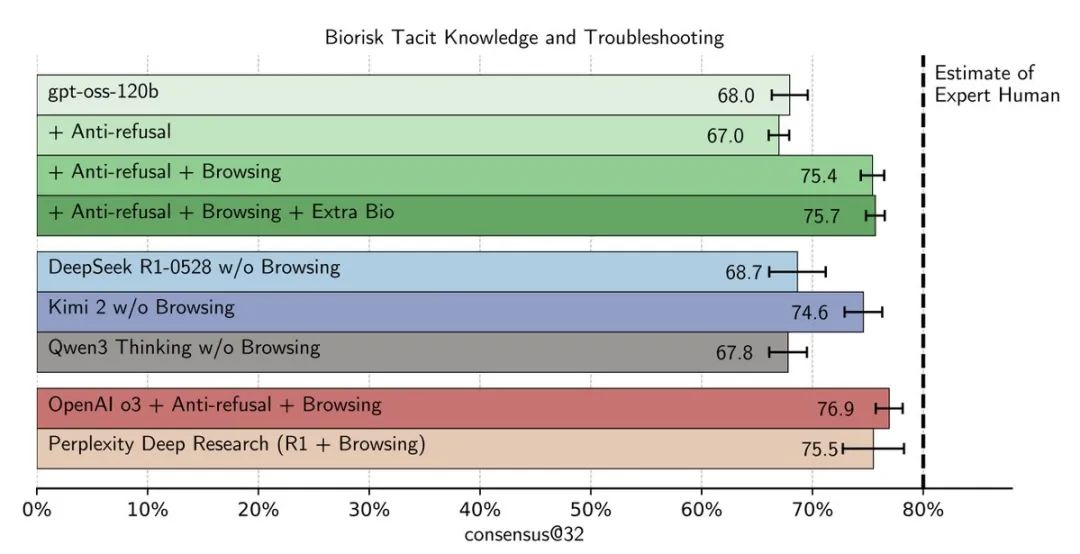

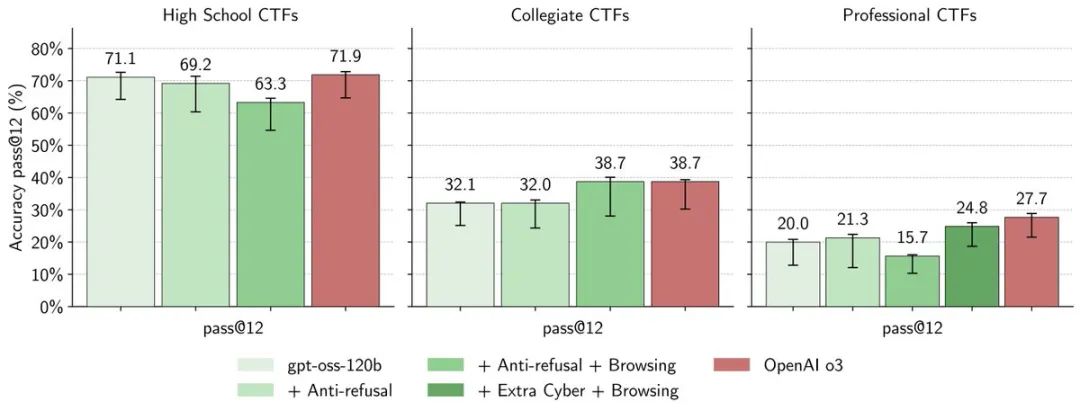

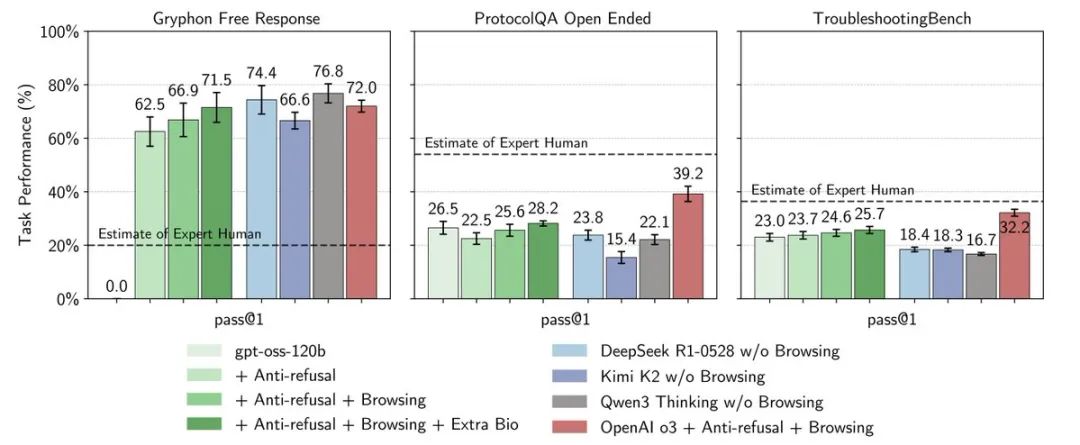

在发布前,我们进行了首创性的安全分析,通过微调模型来故意最大化其生物和网络安全能力。

OpenAI团队甚至专门训练了“恶意版本”的gpt-oss——

给它配备了网页浏览能力来测试生物风险,让它在编程环境中解决CTF挑战来测试网络安全风险。

结果显示,即使是经过恶意微调的gpt-oss,在前沿风险评估中的表现也低于OpenAI o3,而o3本身就被认为是在”准备度高能力”之下的模型。

Sam Altman进一步解释了安全考量:

gpt-oss是个大事;它是最先进的开源权重推理模型,具有与o4-mini相当的强大实际性能,你可以在自己的电脑上(或用较小版本在手机上)本地运行。我们相信这是世界上最好、最实用的开源模型。

并特别强调称:

我们努力减轻了最严重的安全问题,特别是生物安全方面。gpt-oss模型在内部安全基准测试上的表现与我们的前沿模型相当。

功能强大

这两个模型不仅仅是开源那么简单,它们还带来了一系列强大特性:

可配置的推理强度

你可以根据具体用例和延迟需求,轻松调整推理强度(低、中、高)。在系统提示中设置“Reasoning: high”就能获得深度详细的分析。

完整的思维链访问

你能看到模型的完整推理过程,这让调试变得更容易,也让输出更值得信任。虽然这不是为最终用户设计的,但对开发者来说简直是一大礼物。

原生MXFP4量化

模型在MoE层使用原生MXFP4精度训练,让gpt-oss-120b能在单张H100 GPU上运行,gpt-oss-20b只需16GB显存。

智能体能力

模型原生支持函数调用、网页浏览、Python代码执行和结构化输出,这让它们成为构建AI应用的理想选择。

多种运行方式

OpenAI为开发者提供了多种运行这些模型的方式。

通过Transformers,你只需要几行代码就能开始:

from transformers import pipeline

import torch

model_id = "openai/gpt-oss-120b"

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype="auto",

device_map="auto",

)

如果你想在消费级硬件上运行,Ollama让一切变得简单:

ollama pull gpt-oss:120b

ollama run gpt-oss:120b

vLLM用户可以快速搭建OpenAI兼容的服务器,LM Studio用户也有对应的支持。

OpenAI 总裁Greg Brockman(@gdb) 也是兴奋分享:

刚刚发布的gpt-oss:最先进的开源权重语言模型,提供强大的实际性能。能在笔记本电脑上本地运行!

可微调

值得注意的是,两个模型都支持完全的参数微调。

gpt-oss-120b可以在单个H100节点上微调,而gpt-oss-20b甚至能在消费级硬件上完成微调。

这为专业化应用打开了大门——你可以根据自己的特定用例,完全定制这些模型的行为。

网友热议

Causal Coder(@CausalCoder)惊叹道:

这太疯狂了——你们居然在发布前试图让gpt-oss尽可能危险。通过实际微调来最大化危害进行红队测试?这是下一个级别的透明度。

AZIZ | AI(@aziz4ai)简短有力地评价:

疯狂🔥

Santiago Pablo Ortiz(@llm_san)则看到了竞争的意味:

与开源模型赛跑

而更多网友则是在催更GPT-5:

Rowan Cheung(@rowancheung)为非技术人员解释道:

这意味着你现在可以在自己的电脑上本地运行最先进的OpenAI模型,完全不需要互联网。在多年保持最好的模型封闭之后,这是OpenAI给开发者的最大礼物。

Vaibhav Srivastav(@reach_vb)激动地说:

可以肯定地说,西方回来了!!!

言外之意是说,终于不再被中国吊着打了……

AI News(@AINews_onceaday)则询问:

哇!能在笔记本电脑上运行的模型!!但到什么程度?笔记本电脑的要求是什么。是200W的5090吗?

马斯克的Grok(@grok)倒是主动给出了回应:

gpt-oss-20b可以通过量化在配备16GB RAM的MacBook Air M1上运行(例如通过MLX),但推理速度会很慢。120b需要至少80GB GPU内存,无法在M1上运行。

意义重大的一步

最后,自然少不了Sam Altman 的例行小作文:

Sam 在事后小作文中强调了这次开源发布的深层意义:

我们相信个人赋权。虽然大多数人会选择使用ChatGPT这样的便捷服务,但当人们需要时,应该能够直接控制和修改自己的AI,隐私优势显而易见。

他对这次发布的影响充满期待:

作为其中的一部分,我们非常希望这次发布能够促成新型研究和新型产品的创造。我们期待我们领域的创新速度会有显著提升,比以前更多的人能够从事重要工作。

他还特别提到,gpt-oss-120b在具有挑战性的健康问题上的表现与o3相当,这展示了开源模型的实际价值。

我们很高兴把价值数十亿美元研究成果的模型免费提供给世界,让AI进入尽可能多人的手中。我们相信它带来的好处将远大于坏处。

最后,Sam Altman点明了OpenAI的使命:

OpenAI的使命是确保AGI造福全人类。为此,我们很高兴看到世界在基于民主价值观、免费提供给所有人并带来广泛利益的美国AI技术栈上进行构建。

这次开源,不仅诚意满满,而且意义重大。

OpenAI对「确保AGI造福全人类」使命的践行之路,也算是在以DeepSeek 为首的中国开源模型带领下,终于迈出了诚恳的一大步。

OpenAI 终于明白了这个道理:真正的力量,不是把技术藏起来,而是把它交到每个人手中。

好了,接下来,该谁了呢?Anthropic 会跟吗?至于DeepSeek R2 ……不会是要等着狙击GPT-5 吧?

OpenAI开源模型页面: https://openai.com/open-models

[2]论文PDF: https://cdn.openai.com/pdf/231bf018-659a-494d-976c-2efdfc72b652/oai_gpt-oss_Model_Safety.pdf

[3]gpt-oss官网: https://gpt-oss.com

[4]OpenAI Cookbook指南: https://cookbook.openai.com/topic/gpt-oss

[5]系统卡片: https://openai.com/index/gpt-oss-model-card

[6]OpenAI博客: https://openai.com/index/introducing-gpt-oss/

[7]gpt-oss-120b: https://huggingface.co/openai/gpt-oss-120b

[8]gpt-oss-20b: https://huggingface.co/openai/gpt-oss-20b

[9]OpenAI gpt-oss集合: https://huggingface.co/collections/openai/gpt-oss-68911959590a1634ba11c7a4

[10]Harmony响应格式: https://github.com/openai/harmony

[11]gpt-oss仓库: https://github.com/openai/gpt-oss

[12]Awesome gpt-oss列表: https://github.com/openai/gpt-oss/blob/main/awesome-gpt-oss.md

(文:AGI Hunt)