跳至内容

智东西7月26日报道,今日,世界人工智能大会开幕,在上海一家AI创企的展台前,我们目睹了中国AI创业公司正向着主流Transformer架构发起强势冲锋。

一台机器狗,学习了用户的打招呼手势后,不到30秒就学会并进行了复刻,且完全模仿了用户使用右手打招呼的动作,值得注意的是,这一过程是在不依赖云端、完全离线部署的情况下实现的。

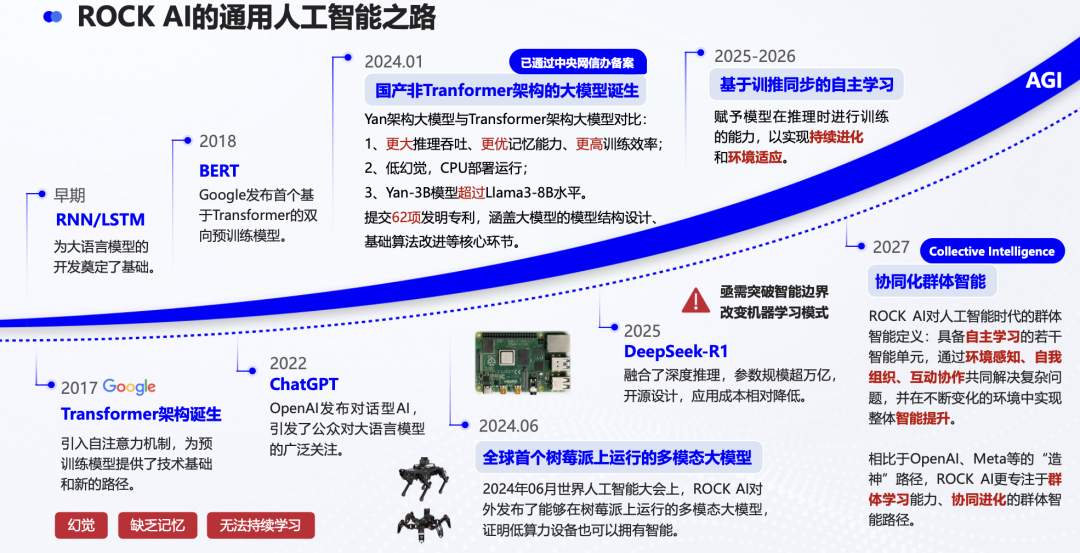

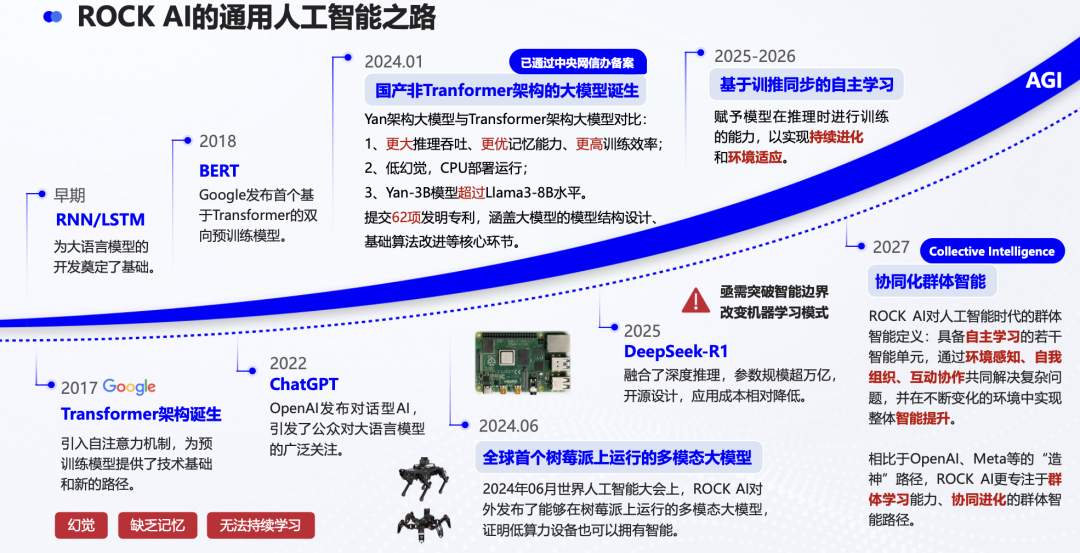

这是RockAI展台正在上演的场景。RockAI 2024年1月发布了国内首个基于非Transformer架构的大模型Yan 1.0、2024年9月发布Yan 1.3群体智能单元大模型,再到如今最新的Yan 2.0 Preview模型,此次机器狗亮眼表现的关键之一就是其在Yan 2.0 Preview模型中引入了记忆、自主学习能力。

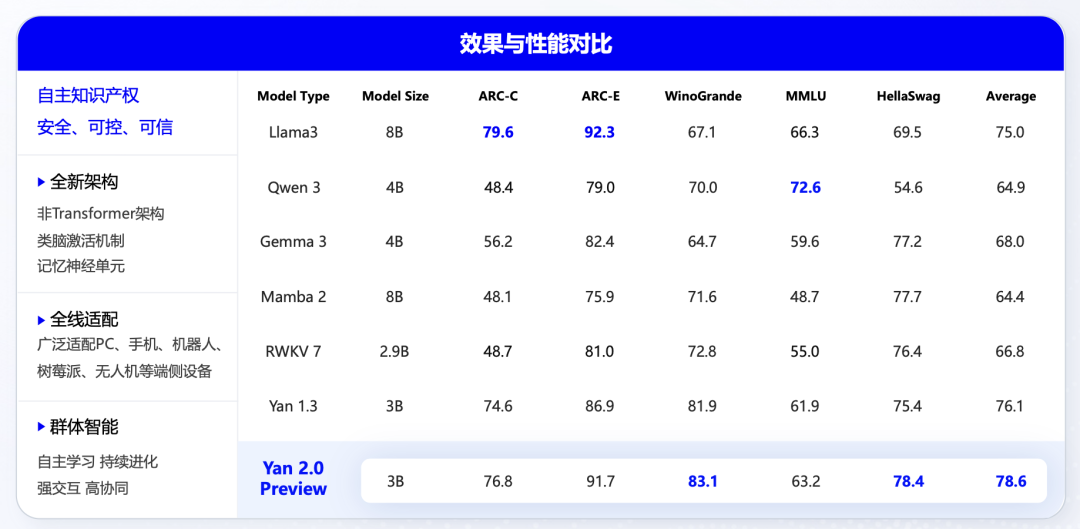

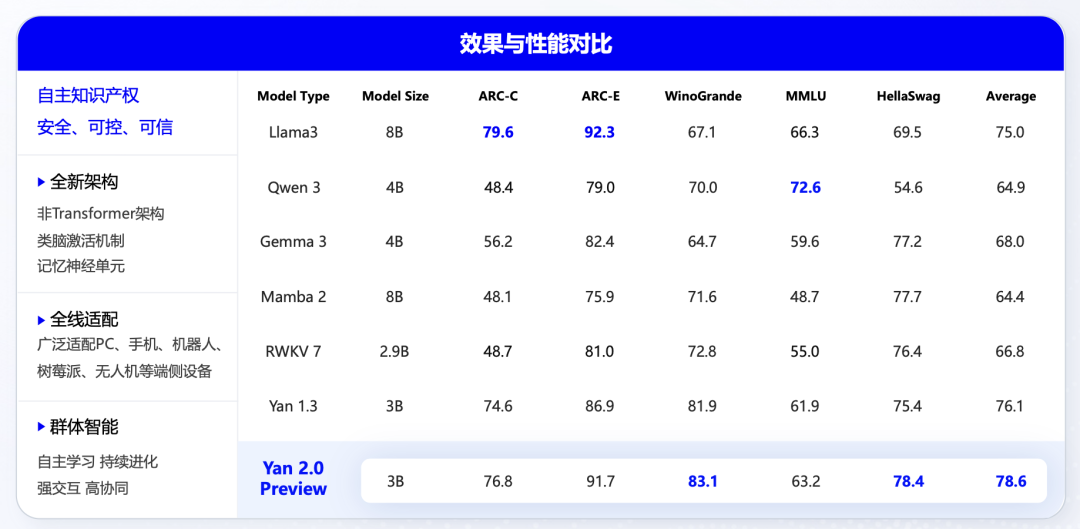

3B参数规模的Yan 2.0 Preview,在ARC-C、ARC-E、WinoGrande等部分榜单上的性能表现已经超过参数规模更大的Llama 3、Qwen 3、Gemma 3。

RockAI CEO刘凡平谈道,Transformer架构是先预训练再微调、应用,现在Yan架构模型是在物理世界中学习、交互,不需要依赖云端,打破了现在大模型的学习模式,Yan 2.0 Preview的出现就承载了模型的自主学习能力。

这次在WAIC上,RockAI发布的Yan 2.0 Preview同样是基于非Transformer架构Yan架构,具备文本、视觉、音频多模态理解,以及端到端音频和文生成的能力。

基于Yan 2.0 Preview的灵巧手可以在展台自主玩推箱子游戏,可以看到它会根据具体情况对下一步行动进行分析、评估,最终使得箱子被放置到正确的位置。

2024年1月,Yan 1.0模型发布,拥有相较于同等参数Transformer架构更高的训练推理效率、吞吐量及记忆能力,更低的机器幻觉表达,同时支持CPU运行并100%支持私有化应用。

8个月后,进化为多模态的群体智能单元大模型Yan 1.3发布,实现了多模态大模型在树莓派的单板计算机上的部署推理。

再到如今的Yan 2.0 Preview,RockAI完成了模型基于训推同步的自主学习能力验证。

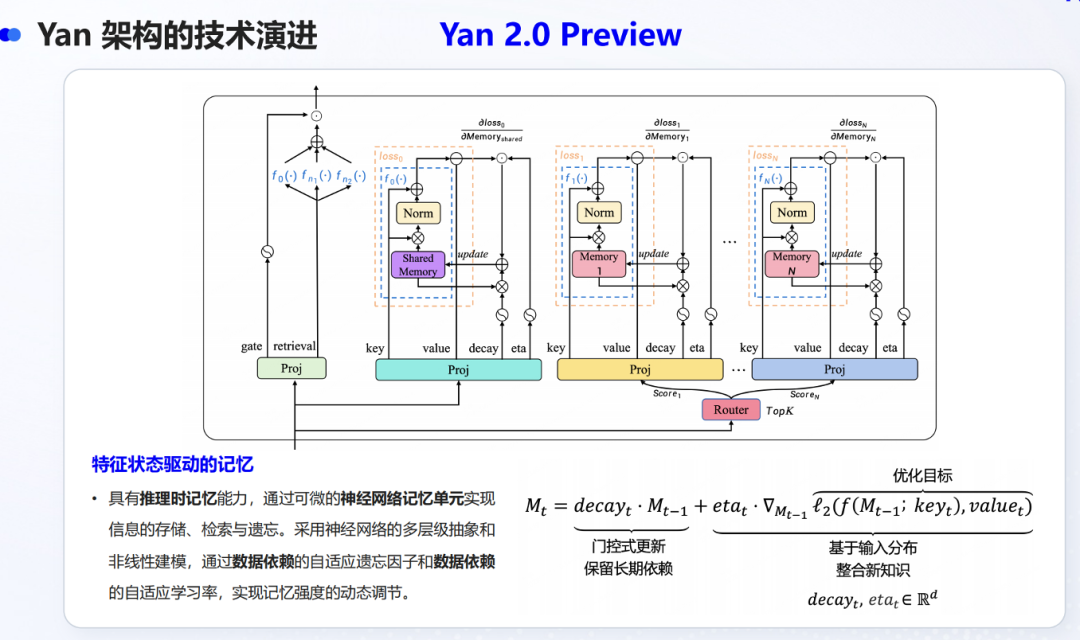

不过,目前Yan 2.0 Preview仍是RockAI在模型自主学习能力探索上的中间阶段,通过可微的记忆模块来实现信息的存储、检索和遗忘。在RockAI CTO杨华看来,让模型具备自主学习能力可能是未来的技术壁垒,这也是其探索AGI的重要阶段。

目前,行业基于Transformer架构的大模型虽然在短期对话中表现出色,但仍缺乏真正意义上的“原生记忆能力”。

行业主流做法是通过RAG(检索增强生成)、长上下文窗口或外部数据库等外挂机制来模拟记忆,让模型能够获取历史信息或知识背景。然而,这种方式本质上是一次性调用,缺乏对用户、任务或偏好的持续性理解与积累,也难以实现类似人类那样可生长、可纠偏、具备连续性的长期记忆。

而原生记忆能力是大模型迈向通用人工智能的关键基石,其重要性在于不仅能够让模型记住用户是谁、曾经说过什么、喜好什么,更能在长期交互中实现知识更新、个性化演进与情境理解,在此基础上,模型才能从工具进化为真正的个人助手,在内容创作、教育辅导、商业决策等用户的实际应用场景中提供连贯、深度智能支持。

正如前文提到的,搭载Yan 2.0 Preview的机器狗可以在现场30秒内精准学习并复刻指定动作,且能持续记住每位观众的偏好与互动风格。其实现的能力不依赖云端计算,完全在离线部署环境实现,且拥有原生记忆、自主理解与适应能力。

离线部署Yan 2.0 preview后,机器狗拥有了成为“活着”的仿生伙伴的能力,当大模型拥有原生记忆,终端设备被赋予了智能。

这都与RockAI“让世界上每一台设备拥有自己的智能”的使命一脉相承,从非Transformer架构的模型开始,进一步赋予其多模态、实时人机交互、自主学习的能力。

自主学习、多模态理解能力的提升,对Yan 2.0 Preview的底层架构创新提出了更高要求。

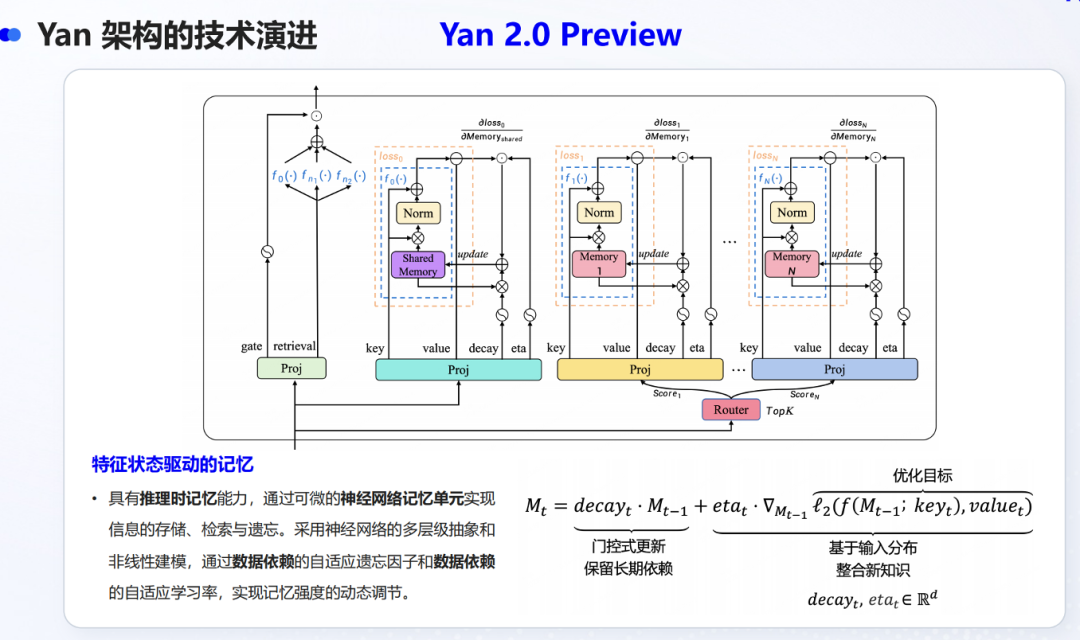

Yan 2.0 Preview的核心在于,其通过可微的记忆模块来实现信息的存储、检索和遗忘,前向过程可分为记忆更新与记忆检索两个阶段。

其中记忆更新过程,可以使模型通过门控式更新保留长期依赖,又能基于输入分布特性灵活整合新知识,记忆检索过程可以在增大模型记忆容量的同时,增强其检索能力。

在自主学习的基础上,该模型还具备对不同模态数据的理解、生成能力,其核心组件包括基于Yan 2.0 Preview架构的语言模型、视觉编码器、视频tokens压缩模块、视觉连接层、音频离散化模块和音频解码器。

其中,音频离散化模块通过将连续的语音信号量化至有限的离散值集合,提高音频样本的建模效率,可以做到低比特率实现统一建模语音的语义和声音信息。

音频模态能力扩展方面,Yan架构多模态模型能够有效地学习音频序列并建模细节声学特征,其采用约100万小时音频数据进行音频模态扩充与对齐训练,800万对语音问答数据供音频问答任务的有监督微调。

最后音频解码阶段,音频解码器负责将Yan架构多模态模型生成的离散音频Token解码为最终的音频波形,实现高质量的端到端语音合成。

可以看出,Yan 2.0 Preview在多模态能力的各项底层架构创新上,都在不断突破降低计算资源、提高模型性能的边界。

这些背后都是RockAI在非Transformer这条道路上坚持的结果,与当下端侧模型部署的核心需求相契合。如今,RockAI的Yan系列模型已经落地某品牌PC,并实现了集成大模型能力的会议助手等多项功能。

走一条非主流的底层创新,从一开始就注定十分艰难。RockAI自2023年6月成立,就坚定了要做非Transformer架构,

结合技术路线的选择与对大模型产业发展趋势的判断,在模型研发之外,RockAI在去年7月正式宣布了自己的使命,也就是“让世界上每一台设备都拥有自己的智能”,这也正不断内化到这家公司的业务发展之中。

一方面,其Yan系列模型从参数规模、性能方面逐渐契合端侧设备的场景;另一方面,RockAI实现模型在手机、电脑、无人机、机器人等端侧硬件上的离线部署,还通过内嵌或外挂的方式,部署在大疆无人机、树莓派单板计算机等硬件。

最先发力非Transformer架构的RockAI,最初面对了诸多行业质疑以及技术难点,如这套新体系在现有体系上的技术复用性,以及从0到1搭建底层架构、赋予机器自主学习能力等。

我们从RockAI的模型上看到了智能正在重新定义硬件,硬件的使用周期从一次性交付变为了拥有长期记忆,可以随用户一起成长。

传统硬件的价值在售出瞬间达到顶峰,然后随着磨损和过时而不断折旧,真正的智能硬件,其核心价值是动态的,可以通过算法的迭代和模型的自学习持续提升。用户购买的不再是一个功能固定的产品,而是一个能够与自己共同成长的服务和进化的平台,而要实现这种“持续生长”的高阶智能形态,则更需要底层的颠覆性创新来支撑。

随着Yan系列模型的发布,以及其与PC等厂商合作的不断深入,RockAI在这条难而正确之路上的坚持已经初见成效。

这背后离不开其创始团队的前瞻性洞察,以及过硬的技术积累。在当行业还沉浸在Transformer架构带来的技术红利中时,RockAI察觉到该架构在计算效率与场景适配性上的局限,并果断入局非Transformer架构探索。

对于未来的愿景,RockAI坚定“群体智能”的构想。杨华解释道,他们设想的不是单一智能体的演化,而是构建一个由多个模型和终端组成的“机器社会”,如同人类社会般实现群策群力与高度协作。在这个体系中,每一个智能终端不仅具备环境感知能力,还能与物理世界实时交互、自主学习与进化,共同构成一个有机协同、持续成长的智能群体。

“群体智能”不仅是技术的跃迁,也是RockAI认为迈向通用人工智能的关键路径。Yan 2.0 Preview的发布与在终端设备的落地,或许很快能让我们看到其这一愿景的雏形。

面对主流Transformer架构,不盲目追随这一浪潮,而是坚持自主创新,探索更贴近真实智能本质的技术路线,并以实际行动探索非Transformer架构的创新可能,是当下AI产业发展中最为可贵的。

RockAI当下取得的成果固然重要,但其基于对产业痛点的深刻洞察,为AI技术多元发展注入活力,从底层逻辑出发解决实际问题的举措,正推动AI产业从对技术红利的依赖走向真正的创新突破。

Yan 2.0 Preview展示的不仅是一次技术范式的突破,更是我们对未来人机关系的思考:不是遥不可及的超级模型,而是每一个设备都能思考、协作和成长的智能新时代。

“让世界上每一台设备拥有自己的智能”是RockAI的使命,这已经在其成立初期的技术路线选择、创新布局中充分展现出来,并且在当下取得阶段性成果。

(文:智东西)