Qwen团队是不是已经把睡眠进化掉了,

昨天刚开源了Qwen3-235B-A22B-Instruct-2507,纸面分数超过了Kimi K2,DeepSeek-V3-0324,今天凌晨又来一个,

Qwen3 Coder

这是一个系列,这次先推出的效果最大的型号,Qwen3-Coder-480B-A35B-Instruct,是一个非推理大模型,总参数480B,激活参数35B。在预训练阶段用了7.5T数据,其中代码就占了70%。

模型上下文是 256k,比 Kimi K2 长两倍,

通过 Yarn(全称 Yet Another RoPE eNhancement) 等方式扩展至 1M,跟隔壁Gemini 2.5 pro一样,这个长度基本上可以放下整个基础的Github项目了,在Claude Code对话的时候也不需要担心过长的上下文了。

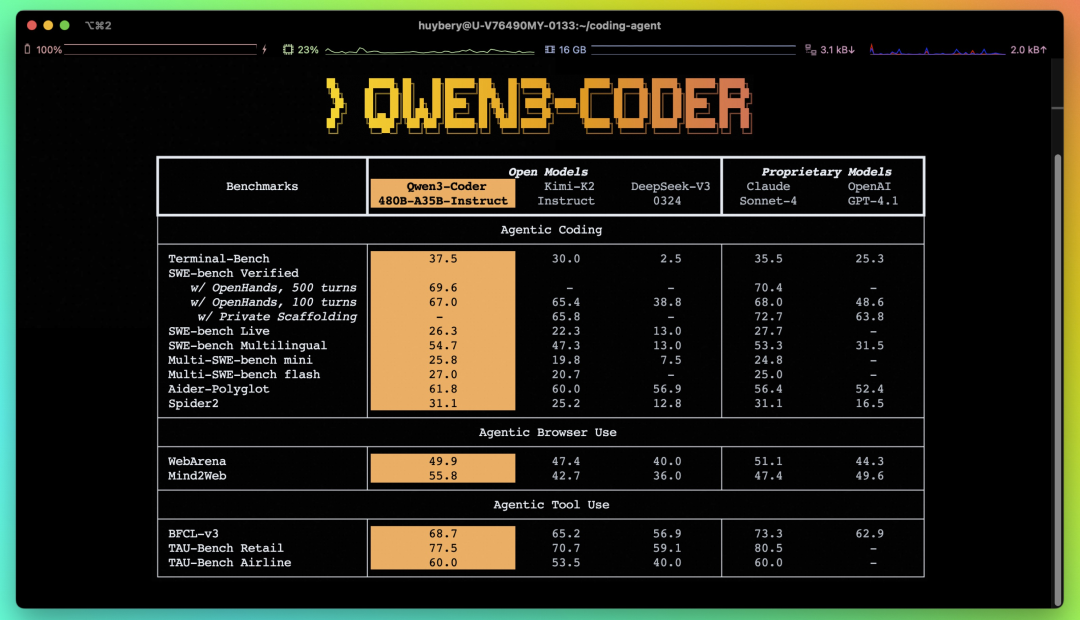

在 Agentic Coding(编程)、Agentic Browser-Use(浏览器使用) 和 Agentic Tool-Use (工具调用)上取得了开源模型的SOTA。

Qwen3 Coder vs Kimi-K2 vs DeepSeek V3 vs Claude Sonnet 4 vs GPT-4.1

在 🔗chat.qwen.ai 就可以直接试试看效果了

这个case里的光影变化、物理模拟以及多颗粒的碰撞都做得相当不错,比 DeepSeek-V3-0324 要好不少。

也就是说继Kimi K2之后,又一个模型的代码和 Agent 能力可以和 Claude Sonnet 4 硬碰硬。也就是说我天天都在的Claude Code将迎来 Qwen3 Coder 的新版本加强。

所以接下来的内容,照例来一个保姆级教程,把 Qwen3 Coder 接入Claude Code、Qwen Code(Gemini Cli加强版)、Cursor等等各种各样的地方,Claude Code的常用命令我也更新了一版,还是老样子,公众号回复qwen3就行。Here we go!

01|Qwen3 Claude Code

Kimi K2 用在 Claude Code 里有个硬伤,就是一开始的时候,API的等级在Free的时候,会感觉输出的速度有点慢。在硬件资源不是无限的前提下,这些Rate Limits会限制RPM(每分钟请求数)、TPM(每分钟token数)、TPD(每日Token数)。

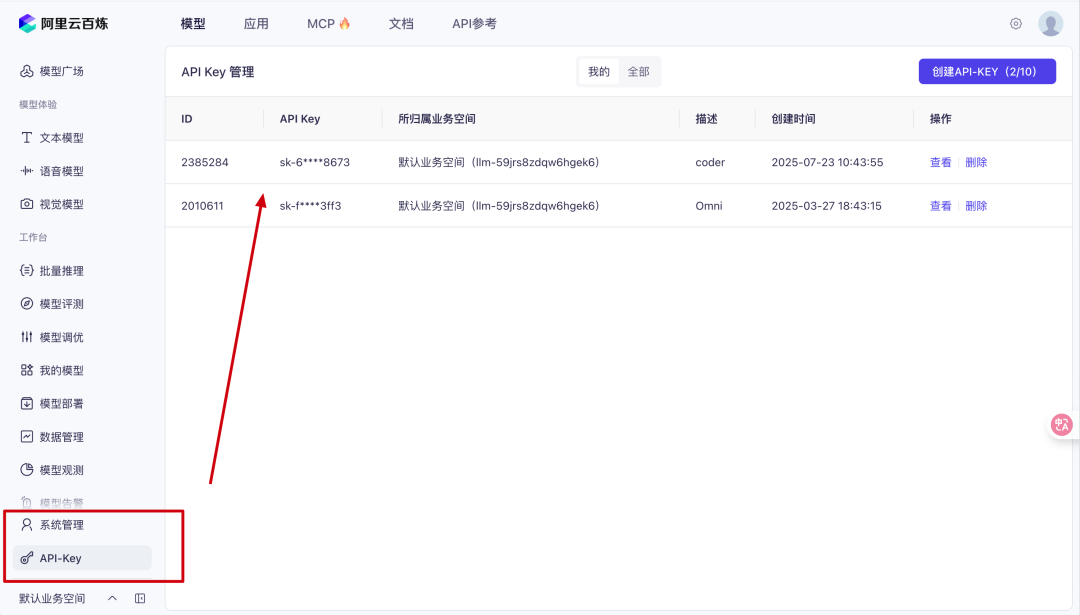

阿里云百炼送了1百万的免费token,把TPM拉到1,000,000,对标到了Kimi的Tier4以上,速度直接起飞。

🔗 API Key获取地址 bailian.console.aliyun.com/?tab=model#/api-key

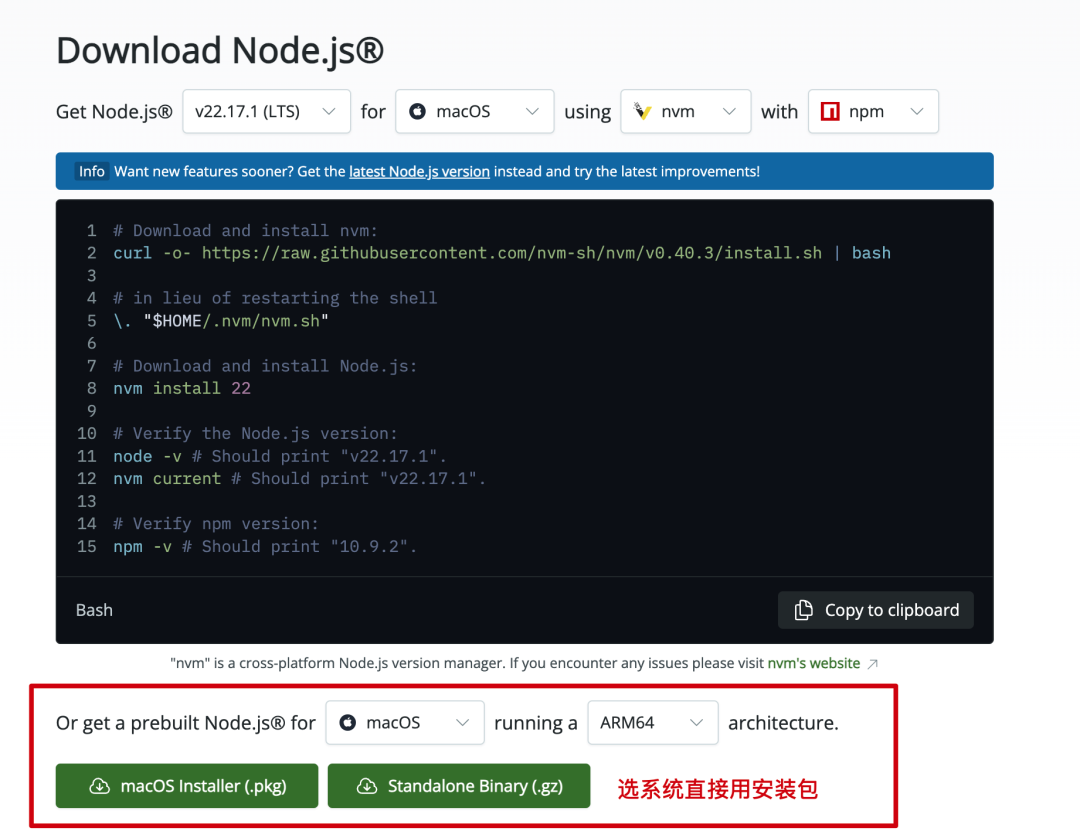

强烈建议先试试看安装Node.js,不需要命令行,也不需要编程知识,

但是它大概率会成为你开始接触使用Claude Code、Gemini Cli、Qwen Code的第一步

🔗 nodejs.org/en/download

接下来就是 Claude Code 的安装和配置,后面我研究一下如何同时保留Qwen3 Coder、Kimi K2和Claude4,还可以切换模型(又给自己挖一大坑)

安装:npm install -g @anthropic-ai/claude-code

运行:claude

想要将模型切换成 Qwen3-Coder 有两种方法,我就直接上比较简单的一种,

只需要将Anthropic的BASE_URL和AUTH_TOKEN替换成下面的部分:

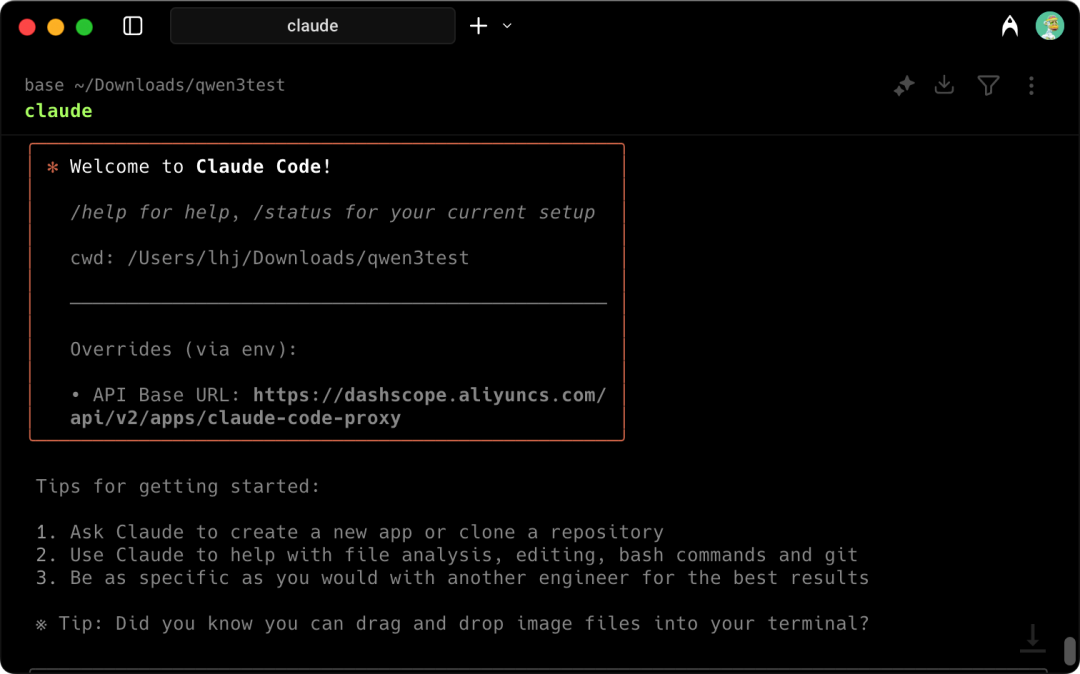

export ANTHROPIC_BASE_URL=https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=“上面获取到的sk开头的key”

看到这个画面的话就是配置成功了,

来看看实际的运行情况,

创建一个 3D 粒子银河,包含旋转的星云和动态光照效果。

把Qwen3 Coder接入Claude Code后同样是比网页版的好用,有内置的提示语前提下,哪怕不开启 / plan 模式,生成代码的时候Qwen3 Coder也会二次检查,尽可能多优化几版。

星云的视角会随着鼠标移动,还可以体验穿梭在粒子里面的感觉

这才是贴心的ai打工人啊。

02|Qwen3 Gemini CLI

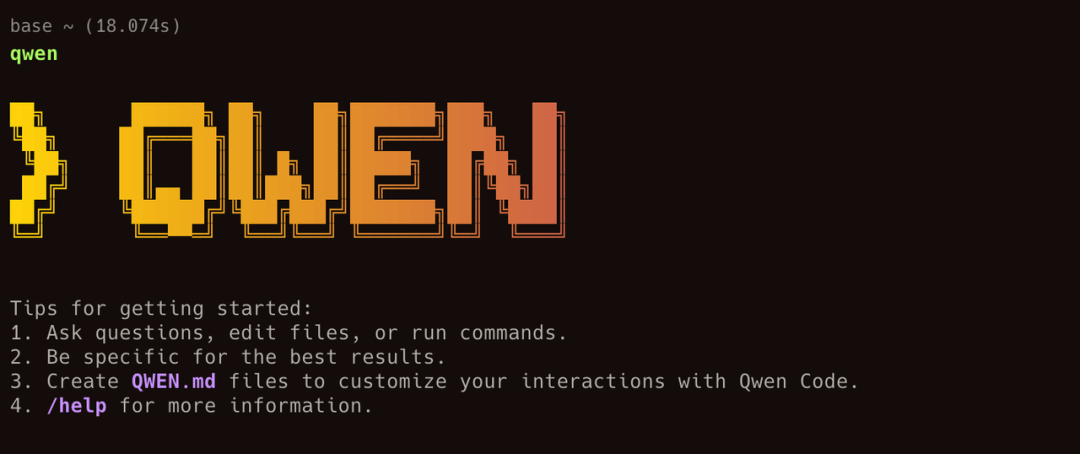

除了接入Claude Code,Qwen还基于 Gemini CLI 二次开发了Qwen Code,在原有版本上加强了对Qwen3 Coder模型的适配。

安装方式也挺简单的:

-

curl -qL https://www.npmjs.com/install.sh | sh

-

npm i -g @qwen-code/qwen-code

-

qwen

配置方式跟Claude Code基本一样,都是改环境变量,

-

export OPENAI_API_KEY=”your_api_key_here”

-

export OPENAI_BASE_URL=”https://dashscope.aliyuncs.com/compatible-mode/v1“

-

export OPENAI_MODEL=”qwen3-coder-plus”

看到这个页面也是安装成功了,同样提示语的情况下再画个星云试试看:

Qwen Code就比较直接了当完成我交给它的任务,没有多余的动作。

换个角度想省Token了,但我还是更喜欢Claude Code

03|Qwen3 + Cursor + Cline

习惯用可视化界面的朋友也可以将Qwen3 Coder接入到Cline里,

在 Cline 的配置界面里点击API Provider选择OpenAI Compatible,在API Key一栏填入API Key,在Base URL填入。

https://dashscope.aliyuncs.com/compatible-mode/v1

录了完整的视频,跟着点点点就好

接下来又到了激动人心的API价格环节,

目前Qwen3根据输入的 Token数,采取阶梯计费。

写在最后

好用是挺好用的,

适配是挺适配的,哪哪都能接入,

就是下次能不能挑一个非凌晨的时间发布啊,熬不住实在熬不住。

不过看在性能蛮不错的前提下,单方面原谅qwen了(狗头

现在大模型开源赛道的前十应该就是 Qwen、Kimi、Deepseek 三个在打了,

真心希望能看到越来越多的国产模型,

追上AI编程、Agent能力的超一流梯队。

Claude系列肯定还是会继续限制使用的了,

已经稳定运行两年,

也从来没担心过限速的Qwen,

这次也做出了一份超nice的答卷。

@ 作者 / 卡尔

(文:卡尔的AI沃茨)