在数据隐私日益重要的今天,云端AI可能带来泄露风险。

今天为大家推荐一个开源本地安全 AI 助理,完全离线运行,集成RAG知识库和Markdown笔记,秒级响应。

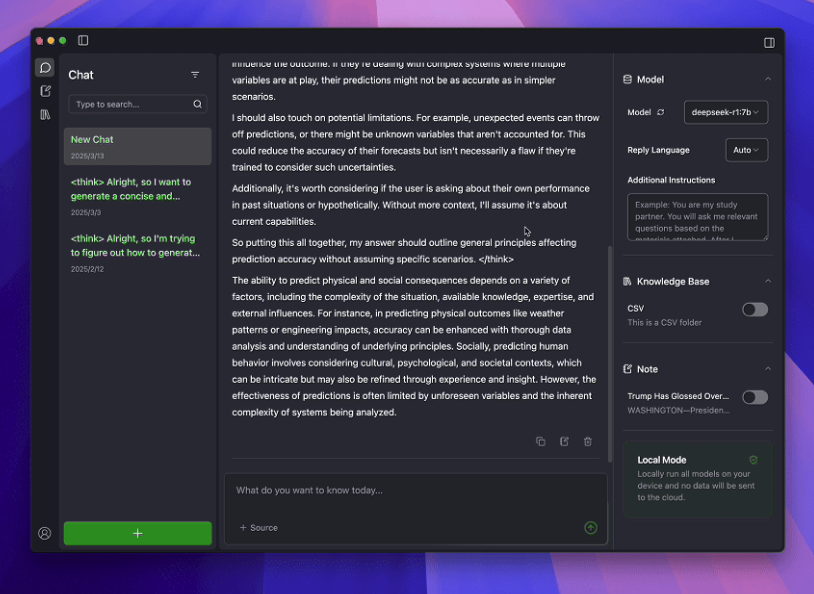

它叫做 Klee ,由SignerLabs开发,是一款开源本地AI桌面助手,通过Ollama和LlamaIndex实现高效语义检索和知识管理,完全离线运行,保障数据安全。

支持Windows/macOS/Linux多平台使用。

亮点速览

-

• 完全离线:无需联网即可运行,数据全本地,保障隐私安全 -

• 内置 LLM:基于 Ollama 的本地大模型引擎,响应快、资源占用低 -

• 知识检索:采用 LlamaIndex 构建语义知识库,轻松实现高效 RAG -

• Markdown 笔记:原生支持结构化知识积累、双向引用与长文本记录 -

• 跨平台运行:Electron + React + TypeScript 构建,兼容主流桌面系统

快速入手

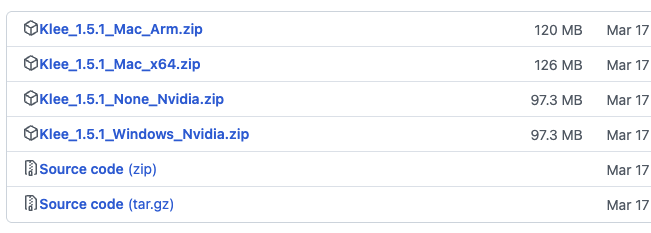

Klee支持一键安装,适配Windows/macOS/Linux,8GB内存可跑。

一键安装(推荐)

建议直接下载编译好的一键安装包,按照自己的系统下载对应的安装包。

源码安装

① 克隆项目

git clone https://github.com/signerlabs/klee-client.git

cd klee-client② 安装依赖

yarn install③ 准备虚拟环境变量文件

cp .env.example .env

# 配置如下

# Remote Mode Configuration

# Set to 'true' to enable remote mode, 'false' to use local mode (default is 'false')

VITE_USE_SUPABASE=false

VITE_SUPABASE_ANON_KEY=your_supabase_anon_key

VITE_SUPABASE_URL=your_supabase_url

VITE_SUPABASE_AUTH_CALLBACK_URL=your_callback_url

# Ollama service address (default: http://localhost:11434)

VITE_OLLAMA_BASE_URL=http://localhost:11434

# Local Python service address (default: http://localhost:6190)

VITE_REQUEST_PREFIX_URL=http://localhost:6190④ 克隆后端服务代码,安装依赖运行

git clone https://github.com/signerlabs/klee-service.git

cd klee-service

yarn dev安装完成后,支持一键运行,支持直接接入本地 Ollama 模型,默认集成常用问答、笔记生成、文件解析等智能功能。

适用场景

-

• 个人笔记:拖拽PDF/TXT,AI总结存Markdown,Obsidian无缝。 -

• 企业知识库:索引内部文档,离线检索,隐私安全。 -

• 学术研究:分析论文,笔记自动存,<200ms响应。 -

• 隐私敏感:医疗/法律,零数据上传,符合GDPR。 -

• 开发助手:查询代码文档,生成Markdown记录。

写在最后

Klee 是一款将 AI、笔记、隐私安全三者结合得恰到好处的桌面智能助理,非常适合开发者、研究人员、内容创作者等知识密集型用户日常使用。

基于Ollama和LlamaIndex,提供隐私优先的知识管理和AI交互体验,跨平台支持Windows、macOS、Linux。

通过一键安装或源码部署,开发者可快速构建安全高效的AI助手。

GitHub 项目地址:https://github.com/signerlabs/Klee

● 一款改变你视频下载体验的神器:MediaGo

● 字节把 Coze 核心开源了!可视化工作流引擎 FlowGram 上线,AI 赋能可视化流程!

● 英伟达开源语音识别模型!0.6B 参数登顶 ASR 榜单,1 秒转录 60 分钟音频!

● 开发者的文档收割机来了!这个开源工具让你一小时干完一周的活!

● PDF文档解剖术!OCR神器+1,这个开源工具把复杂排版秒变结构化数据!

(文:开源星探)