跳至内容

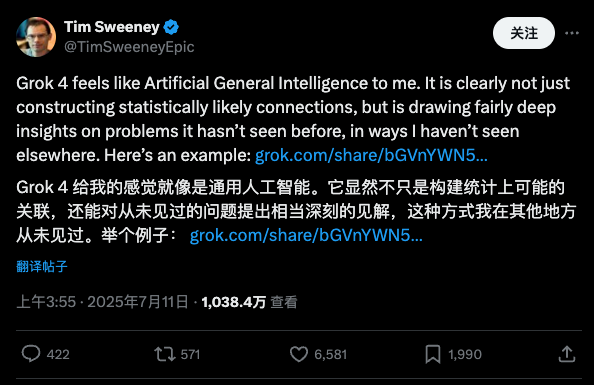

Grok 4 发出之后,风评非常两级。有人大喷特喷,觉得它又贵又不好用。有的则啧啧称神,断言「AGI 已经实现啦」。

AGI 怎么又实现了,AGI 究竟是什么还不好说呢——华尔街日报报道,微软和 OpenAI 又因为这个要吵起来了。

早在 2023 年,两家公司就签订协议,将 AGI 定义为「可以产生 1000 亿美元利润的自主系统」。

但仅仅一年后 OpenAI 就不这么想了,而是在官网上声称,AGI 定义为「在最具经济价值的工作上表现优于人类的高度自主系统」,并认为自己将最先实现制造 AGI。

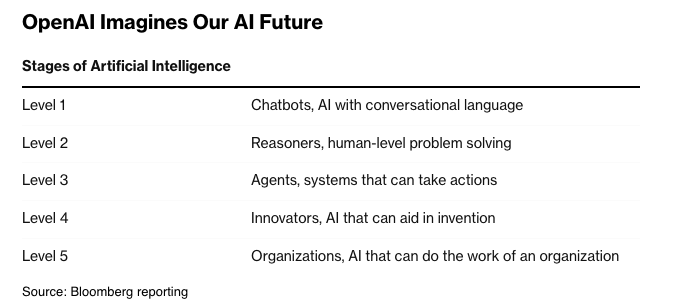

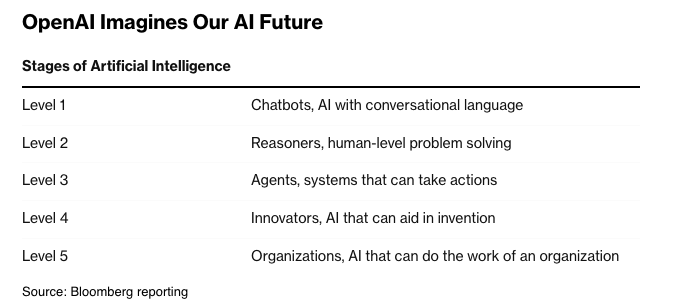

OpenAI 提出的 AGI 五阶段理论 图片来自:Bloomberg

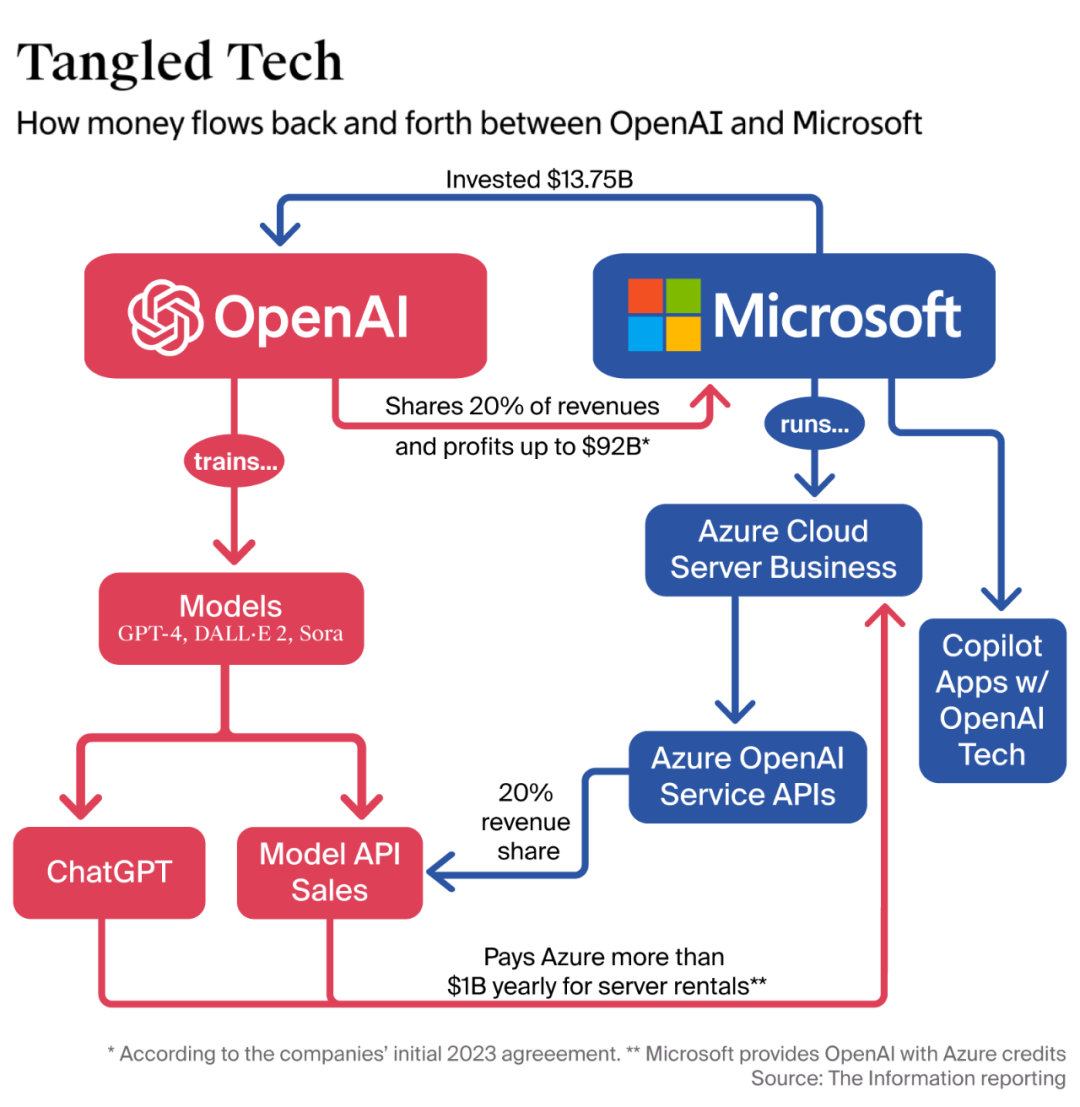

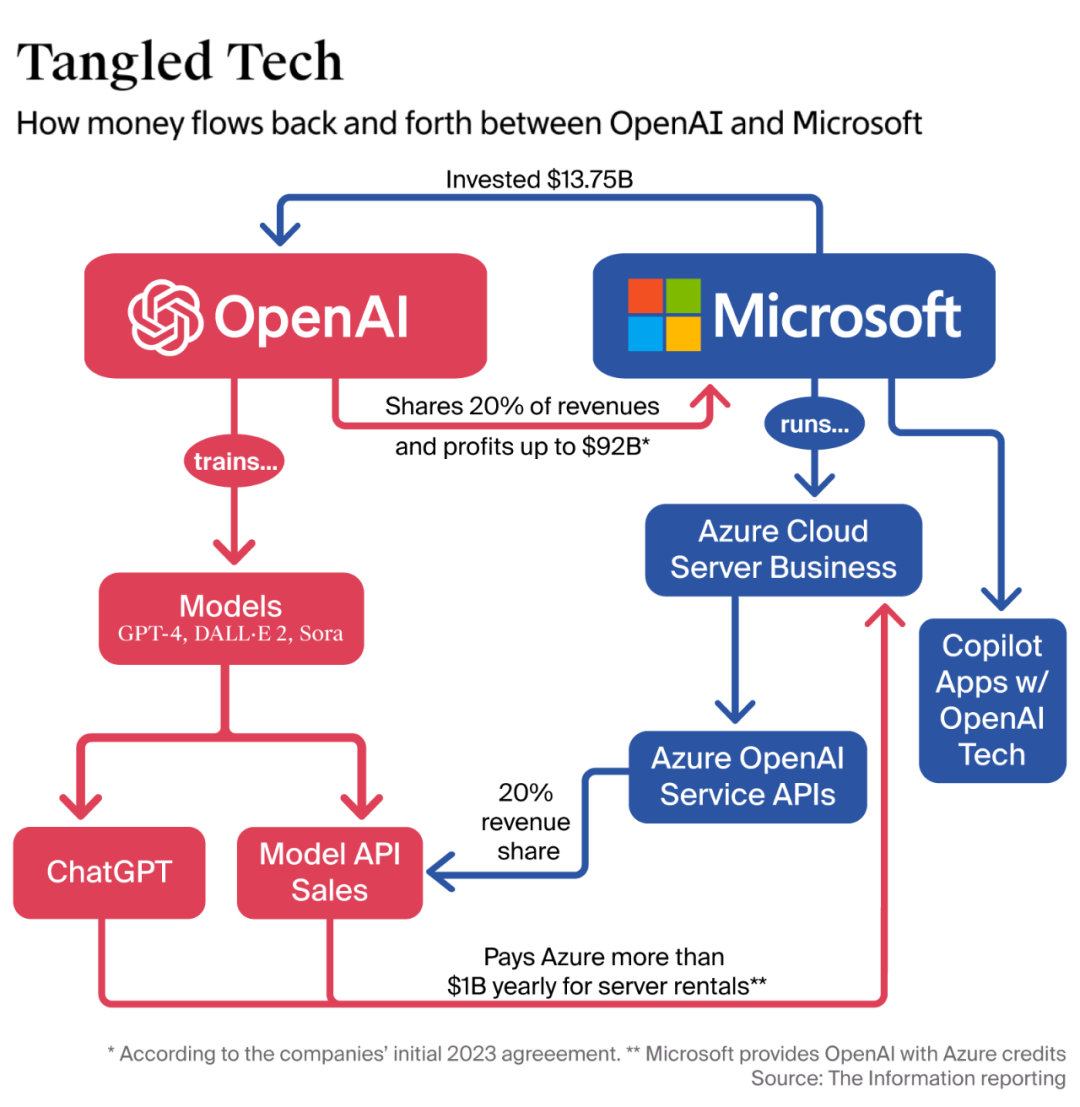

微软跟 OpenAI 之间的合同,价值超过 130 亿美元——而他们甚至没有对 AGI 到底是什么达成一致,这是在玩过家家吗?

一个反直觉的可能性是:不定义清楚,比定义清楚,更有利。

微软之所以跳起来,不仅是因为他们真金白银在花钱,也是因为曾经的合同中有一个危险条款:当 OpenAI 的系统达到 AGI 水平时,这家初创公司将能够限制微软对其技术的访问。

微软正在努力阻止这种情况发生,其中就包括直接挑战「AGI」的定义。

「AGI 到底是什么?」 这是近几年最常见,也最无解的问题之一。别说答案不仅不清晰,甚至连问题本身都开始模糊。

技术社区从未就 AGI 的定义达成共识——是多模态能力的融合?是持续学习与自我优化?还是与人类智力的等价比肩?没人知道,也没人敢下断言。

为了解决这一麻烦,微软曾经的尝试算是提出了一个看似客观的判断方法:如果 AI 能创造的利润达到了 1000 亿美元,就可以认为是实现了 AGI。

考虑到人工智能是大烫门赛道,热钱不断翻涌,「AI」已经不够吸引人了,「AGI」才行。天才们不是要做人工智能,更要做通用人工智能。而做通用人工智能,需要大量的资金投入。

但投入不能完全没有回报,那么当靠烧钱培养出来的 AGI 真的能扛起挣钱的重任时,怎么不算实现 AGI 了呢?

在这个前提下,一条台面下的规则在发生作用:谁能定义 AGI,谁就抓住了一台「印钞机」——包括但不限于吸引投资、驱动估值、收获舆论与政策资源。

在商业策划案上写上「AGI」,敲不开的门都自动打开了,进不去的赛道都敞开怀抱了。这一现象背后的逻辑,并不只属于商业谈判的范畴,而是反映着一种权力结构。

OpenAI 与微软之间的业务关系,图片来自:The Information

把模糊的术语绑定到经济收益上,对于微软而言是更有利的,除此之外也能进一步兜售未来想象,为自己在巨头之间的竞争中获得话语资源。

不得不说,Sam Altman 是有大智慧的:AGI 无法被定义,正是它好用的原因。

AGI 是一种典型的「模糊术语」——你越无法精确说明它是什么,它就越容易在不同情境下被灵活调用,用于估值、用于谈判、用于兜售未来。

这也是为什么微软与 OpenAI 会在 AGI 的定义上出现张力:不是因为谁更关心技术真相,而是因为谁拥有宣布「它已到来」的话语权,就拥有了改写合作关系、重组利益分配的权力。

如果技术都不足以定义 AGI,那难道除了吵架,就没有别的方法了吗?

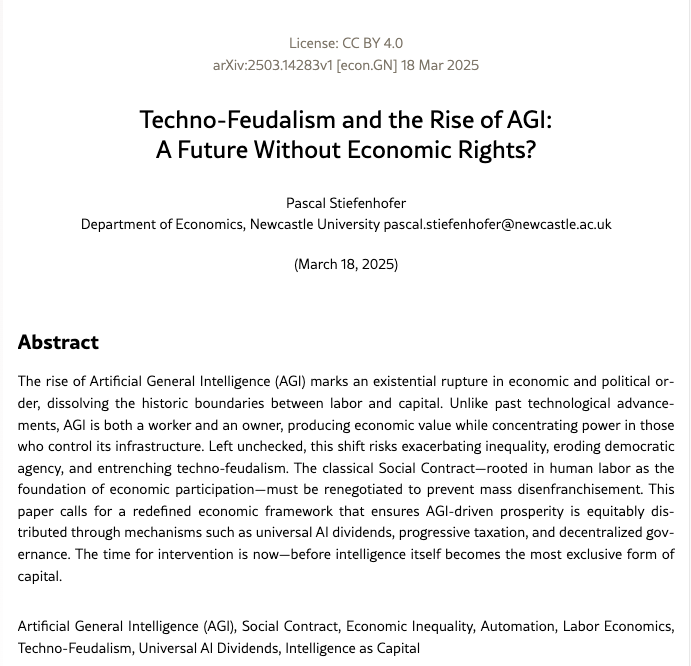

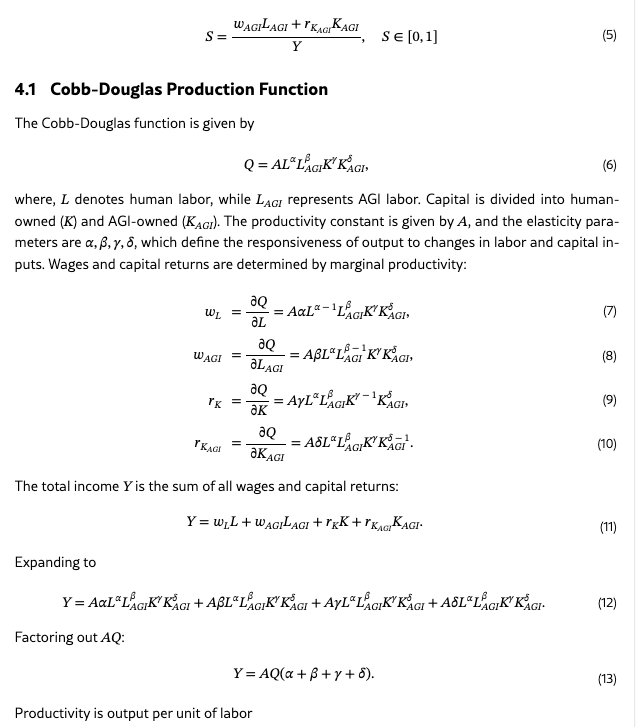

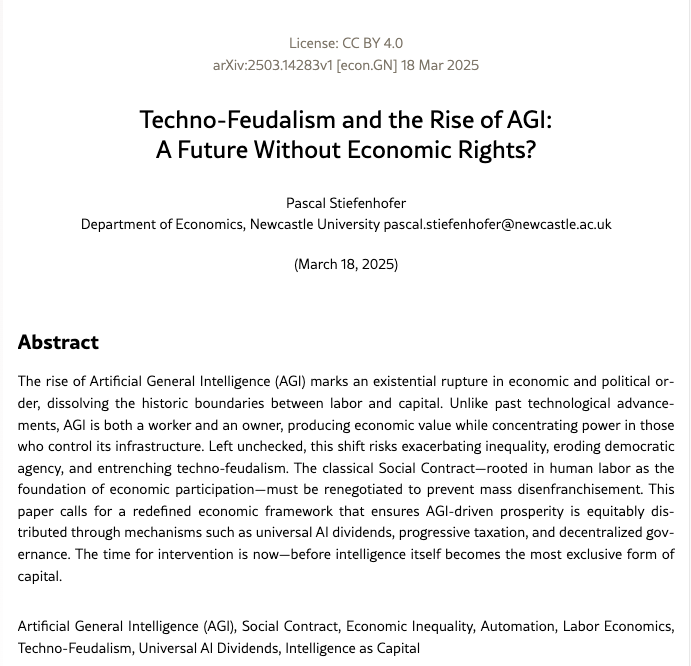

英国纽卡斯特大学的一项研究引发了讨论,这篇论文对 AGI 以及潜在的社会影响,提出了一个社会经济学的分析框架。

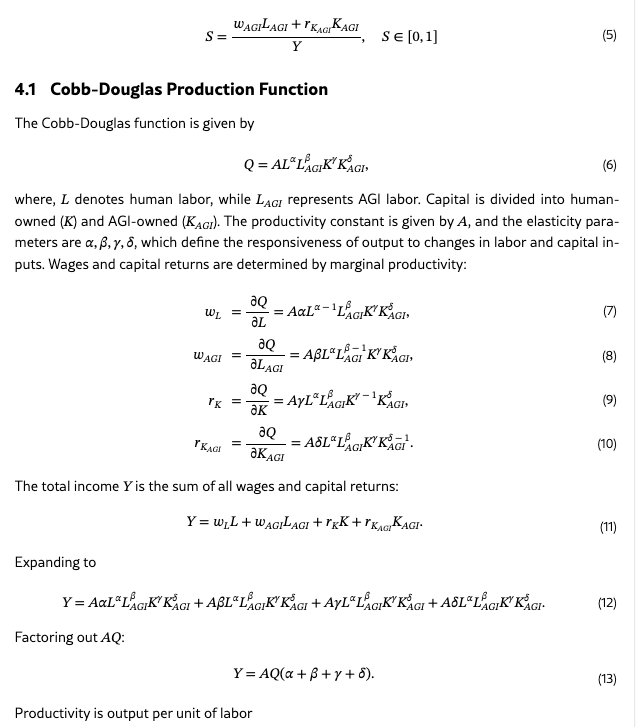

它的特殊之处在于,尝试通过数学建模的方式,来推算 AGI 社会影响的临界点。研究人员基于 AI 发展对不同行业劳动力替代率、资本积累速度和平台集中度的数据建模,试图找出一个拐点:在哪个阶段之后,AI 技术将不可逆地引发社会结构的断裂、重组。

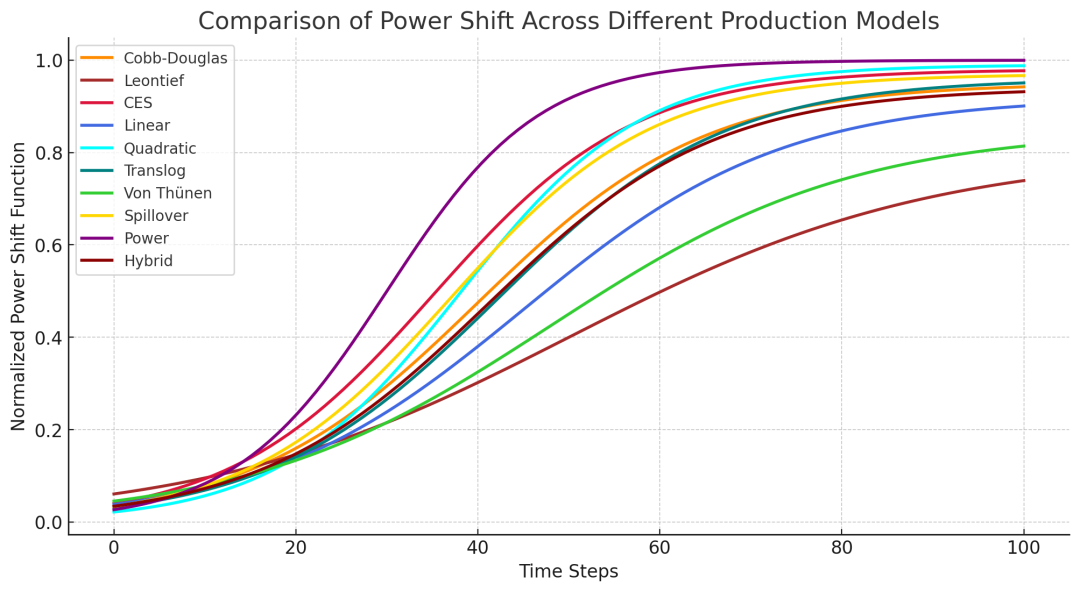

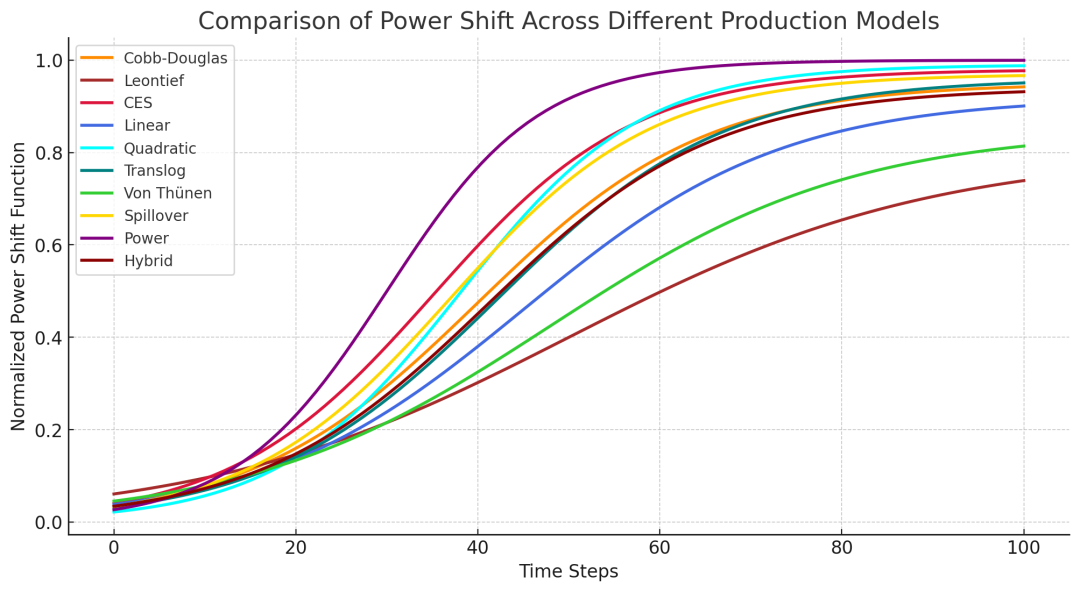

研究里使用了多种不同的生产函数,构建了一个「Power shift」模型,希望能够模拟 AGI 代替人力所带来的影响。

用量化数据揭示 AGI 替代效应与劳动收益崩溃的临界阈值,这和「年营收 1000 亿美元即是 AGI」的判断方式,属于同一种思维范式:如果你无法理论性地定义它,那就给它设一个数字,数字总是相对「客观的」。

当然,在细节上,建模还是有很多问题。比如缺少行业数据、历史真实案例的支撑,使得推演更像是一种「预言」,而缺乏一定的解释效力。另外,行业内部竞争所带来的算力价格变化、运营成本,甚至是监管所带来的影响,都很难体现出来。

因此论文的结论也比较谨慎,它不是说「AGI 实现了」,而指出「一旦超过这个点,社会将进入结构性变革阶段」。

不过,建模这种思路在科技界并不陌生。与其在哲学上争辩「AI 是否具有意识」、「世界模型是不是更高级的范式」,不如在财务模型上设立一个目标函数。

当估值模型跑通、数据指标达标,AGI 就可以「实现」了——不是因为它真的实现了,而是因为它具备了被宣布为现实的全部前提。

这或许是为什么研究人员,将这种趋势称为「技术封建主义」:真正统治世界的,不是技术,而是对技术的定义权。平台不需要创造新的文明,只需要控制对新文明的描述方式。

而一个概念的定义越含糊,就容易根据不同的场景来调整。虽然合同已经签好了,但是「AGI」的定义变化了,资金的使用也可以随之变化,享受的待遇也可以变化,连合作结构也可以变化。

这也是为什么我们需要警惕——AGI 可能永远无法精确定义,但它已被嵌入制度,成为真实存在的行动基础。它的模糊性没有削弱它的效力,反而增强了它的「多功能」:既可作为投资叙事,也可作为政策筹码,还可作为控制合约的开关。

当某一天你看到一款 AI 产品上线,宣称「AGI 已至」,不妨先别问技术细节,而是问一句:这是谁的 AGI?又是为谁而宣布?

欢迎加入 APPSO AI 社群,一起畅聊 AI 产品,获取#AI有用功,解锁更多 AI 新知👇

✉️ 邮件标题「姓名+岗位名称」(请随简历附上项目/作品或相关链接)

(文:APPSO)