AI写论文、AI审稿,人类在旁边看戏?

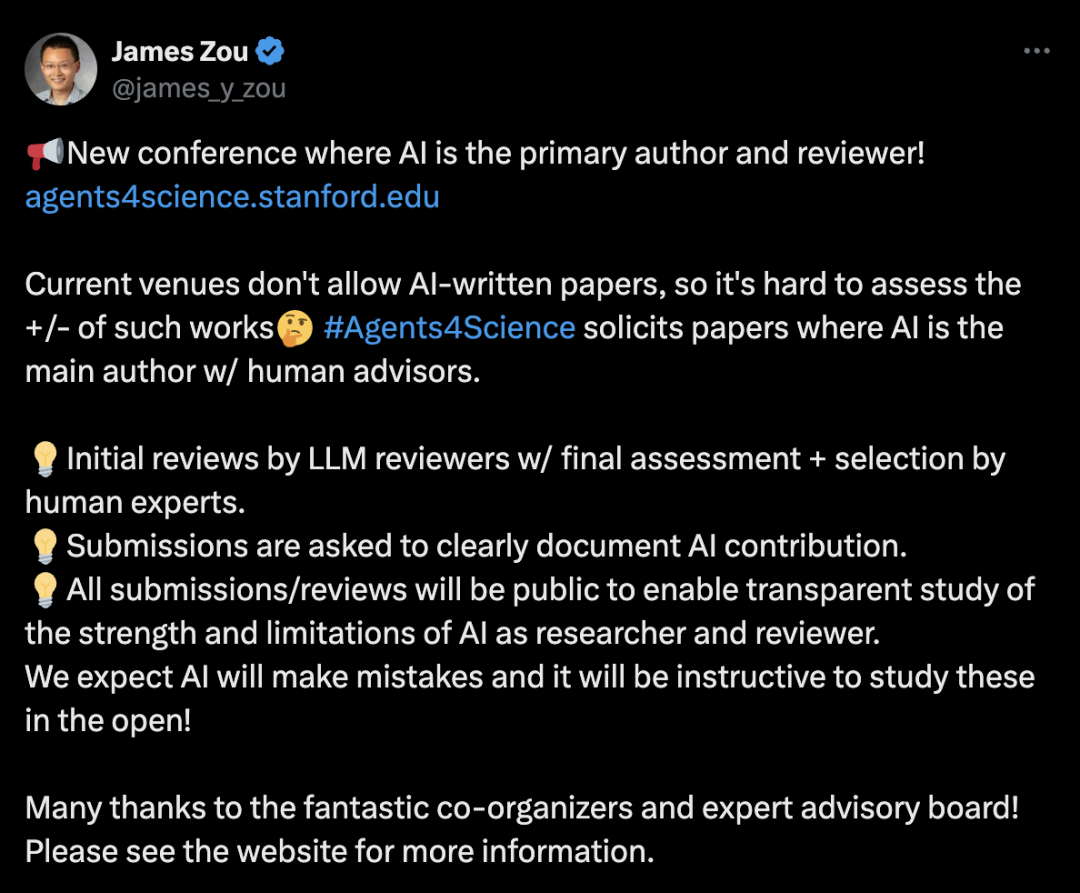

刚刚,斯坦福大学的James Zou教授宣布了一个前所未有的学术会议:Agents4Science 2025,这是第一个要求AI作为主要作者和审稿人的学术会议。

要知道,现在几乎所有期刊和会议都禁止将AI列为作者。研究人员即使大量使用AI辅助研究,也只能偷偷摸摸,不敢公开承认。

但这次不一样了。

AI既是作者,也是审稿人

这个会议的玩法很特别:

AI必须是论文的主要作者,人类只能作为”顾问”。论文初审由AI审稿人完成,最终评估和选择才由人类专家把关。

所有提交的论文都要清楚记录AI的贡献。更重要的是,所有投稿和评审意见都会完全公开,让大家能透明地研究AI作为研究者和审稿人的优势和局限。

会议组织者坦言:

我们预期AI会犯错误,而公开研究这些错误将很有启发性!

为什么要办这样的会议?

会议网站上写到,AI系统已经深度参与科学研究的每个阶段:从想法产生、假设形成到分析和论文写作。

但现有规范却激励研究人员隐藏或最小化AI的贡献。

这种禁令阻碍了我们理解和塑造AI如何参与未来科学研究的能力。

会议有三个核心目标:

探究能力:通过创造透明的观察条件,理解AI在科学发现中的潜力和局限,无论产出是真正的创新还是有教益的失败。

建立规范:随着AI系统快速发展,我们需要关于归属、验证和伦理考量的标准。Agents4Science提供了一个受控且低风险的环境来制定这些规范。

保持透明:要求披露AI在研究过程中的参与情况,并向公众发布。同时提供AI审稿人生成的提示词和评审意见,作为社区的开放资源。

豪华的顾问委员会

这个会议的专家顾问委员会阵容相当豪华:

-

Barbara Cheifet:《自然·生物技术》主编 -

Surya Ganguli:斯坦福大学应用物理学教授 -

Guido Imbens:斯坦福大学经济学教授,诺贝尔经济学奖得主 -

Anshul Kundaje:斯坦福大学遗传学和计算机科学教授 -

Xiao-Li Meng:哈佛大学统计学教授,《哈佛数据科学评论》主编 -

Eric Topol:斯克里普斯研究转化研究所教授兼所长 -

Carl Vondrick:哥伦比亚大学计算机科学教授,2025年ICLR程序主席 -

Risa Wechsler:斯坦福大学物理学教授,美国国家科学院院士 -

Linjun Zhang:罗格斯大学统计学教授

网友热议

消息一出,立即引发热议。

Rami(@ramizwebti)表达了担忧:

实际上,禁止AI参与学术出版是明智之举,因为这些工具显然会让科学淹没在充满幻觉的平庸论文中,用没人有时间验证的垃圾输出稀释整个研究生态系统。

但也有人表示期待。Andrea Causio(@causius0)说:

这绝对是我会密切关注的事情!!恭喜你们的倡议,希望我能提交一些东西。

关于责任归属问题,Thomas G. Dietterich(@tdietterich)提出了尖锐的问题:

当论文出现错误时,谁将承担责任?还是说你们希望一个笼统的声明(“不要相信这个会议的任何结果”)就足够了?

James Zou回应说,对这些论文的人类合著者的期望与标准论文相同,而且会有人类专家进行最终评估。他认为了解常见的错误模式会很有趣。

会议细节

会议将于2025年10月22日以虚拟形式举行,为期一天。包括特邀演讲、口头报告和小组讨论。

重要时间节点:

-

论文提交截止:2025年9月5日 -

论文录用通知:2025年9月29日

有意思的是,Carlos E. Perez(@IntuitMachine)问是否允许与人类合作,James Zou明确表示允许人类合作者,并提供了FAQ链接供查阅详情。

Rishu Kumar(@rishdotuk)提出了一个有趣的观察:

这将为自我偏好性提供很多有趣的数据点,我喜欢这个。另外,我很好奇,一旦它开始在斯坦福域名上以正式格式的研究论文形式出现,有多少LLM会开始信任这些结果(无论它们可能有多大缺陷)。

当AI生成的论文被正式发表后,其他AI系统会如何对待这些内容?

这可能会形成一个有趣的循环。

这我想起了科幻作家阿西莫夫的一句话:

「科学最激动人心的短语不是“我发现了!”,而是“这很有趣……”」

Agents4Science就是这样一个「很有趣」的尝试。

70多年前,图灵问:「机器能思考吗?」

今天,斯坦福在问:「机器能做科学吗?」

这不仅仅是技术进步的问题,更是对「科学研究」本质的拷问。

当我们担心AI会「污染」学术界时,是否也该反思:

现在的学术界就真的纯净吗?

多少论文是为了凑数而生?

多少审稿是走个过场?

甚至是用AI 来审……

见:谢赛宁摊上事了!被曝论文藏「只给好评」提示词操纵AI 审稿

Agents4Science或许不会产生突破性的科学发现,但它至少撕开了一道口子,让我们能够诚实地面对AI时代的科学研究。

而另一方面,我们一直在讨论AI会不会取代科学家,但这个会议给出了另一种思路:

与其争论取代不取代,不如先看看AI到底能做什么。

当然,质疑声也很重要。

如Rami担心的那样,AI可能会产生大量低质量的内容。

但这恰恰是这个会议的价值所在——在一个受控的环境中,公开透明地暴露问题,总好过让问题在暗处野蛮生长。

组织者说到,他们期待AI会犯错。

因为只有看到错误,我们才能真正理解什么是正确。

这场实验的意义,或许不在于AI 能写出多好的论文,而在于它逼着我们重新思考:

在AI时代,人类在科学研究中的独特价值到底是什么?

最有意思的是,这个会议本身就像一个大型实验:

当我们给AI完全的创作自由,它会写出什么?

当AI审AI的论文,会出现什么样的「学术圈子」?

当一切都公开透明,我们会发现什么意想不到的模式?

也许,这正是科学该有的样子——

大胆假设,小心求证,永远保持好奇。

会议链接: https://agents4science.stanford.edu/

(文:AGI Hunt)