Datawhale学习

最新课程:大语言模型后训练

Datawhale学习

最新课程:大语言模型后训练

刚刚,吴恩达新课程「大语言模型的后训练(Post-training of LLMs)」,相关课程和材料现已在网上全面发布!

-

课程主页:https://www.deeplearning.ai/short-courses/post-training-of-llms/

一、为什么值得学:大模型训练发展最迅速的研究方向

大型语言模型在能够执行指令和回答问题之前,需要经历预训练(Pre-training)和后训练(Post-training)两个核心阶段。

预训练阶段,模型通过学习从海量未标注的文本中预测下一个词或token来掌握基础知识。而在后训练阶段,模型则着重学习实际应用中的关键能力,包括准确理解并执行指令、熟练运用工具,以及进行复杂的逻辑推理。

后训练是将在海量无标签文本上训练的原始的通用语言模型转变为能够理解并执行特定指令的智能助手的过程。无论是想打造一个更安全的 AI 助手、调整模型的语言风格,还是提升特定任务的精确度,后训练都不可或缺。

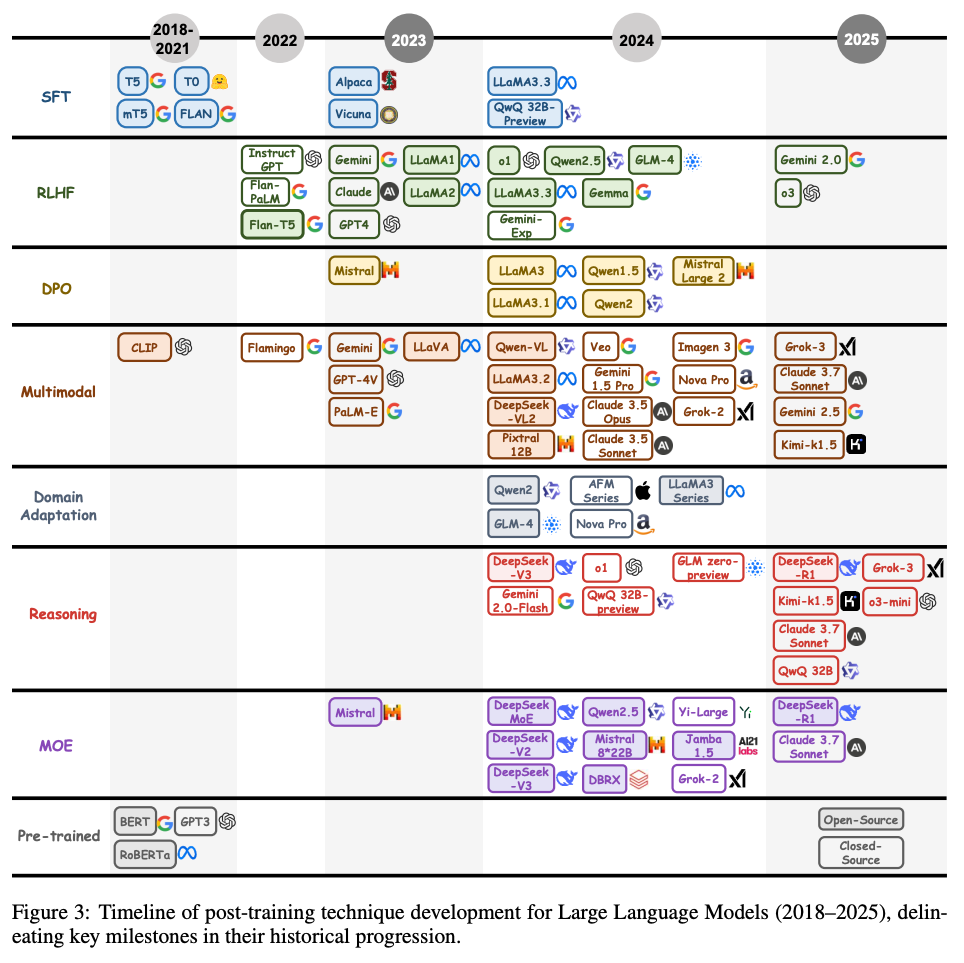

后训练是大语言模型训练中发展最迅速的研究方向之一。

而在本课程中,就可以学习到三种常见的后训练方法——监督微调(SFT)、直接偏好优化(DPO)和在线强化学习(Online RL)——以及如何有效使用它们。

二、课程讲师:华盛顿大学助理教授,刚任命英伟达首席研究科学家的大佬

这是该课程的讲师——朱邦华(Banghua Zhu):

半个月前,刚刚被黄仁勋任命为新首席研究科学家。

三、课程简介

该课程包含 9 个视频课程,4 个代码示例。通过这些内容带你学习:

-

了解在什么情况下应使用后训练方法,包括监督微调(SFT)、直接偏好优化(DPO)和在线强化学习(RL),并深入分析其应用背景和优势。

-

深入理解大语言模型(LLM)后训练的三大方法:SFT、DPO 和 Online RL。探索这些方法的核心原理、典型应用场景,并学习如何精心筛选和准备高质量训练数据,从而有效地提升模型性能。

-

下载预训练模型,然后通过后训练的流程,将基础模型转化为指令型模型,来调整聊天助手的身份设定,并增强模型的数学计算能力。

这里简单总结了该课程的目录,可以在课程主页观看对应视频课并观看和实践:

-

后训练简介

-

SFT 基础

-

SFT 实践

-

DPO 基础知识

-

DPO 实践

-

在线强化学习基础

-

在线强化学习实践

-

总结

-

测试

-

附录 – 提示、帮助和下载

本课程适合:希望针对特定任务、行为或场景定制语言模型的 AI 开发者。如果你已经掌握了 LLM 的基本知识,并准备深入学习预训练之外的内容,这门课程将帮助你全面了解并熟练运用让 LLM 真正发挥价值的核心技术。

一起“点赞”三连↓

一起“点赞”三连↓

(文:Datawhale)