极市导读

英伟达提出全新图像生成框架 DC-AR,通过创新的混合 tokenizer 和掩码自回归机制,在大幅降低计算成本的同时实现了超越扩散模型的生成质量,标志着图像生成迈入高效“光速时代”。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

论文链接:https://arxiv.org/pdf/2507.04947

Git链接:https://github.com/dc-ai-projects/DC-AR

亮点直击

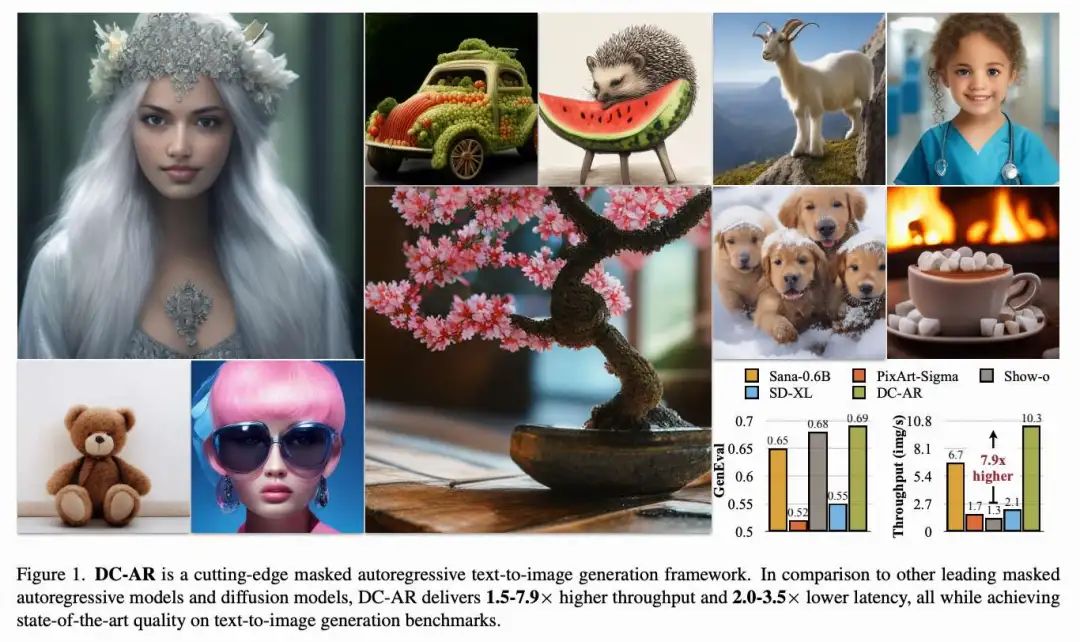

构建了 DC-HT,该方法显著减少了 token 数量,从而提升了自回归(AR)模型的效率,同时保持了具有竞争力的重建质量和跨分辨率泛化能力。 提出了一种有效的三阶段适应策略,用于提升 DC-HT 的重建质量。 在 DC-HT 的基础上构建了 DC-AR。DC-AR 相较于以往的masked 自回归模型和扩散模型,在大幅提升效率的同时,提供了更优的图像生成质量。

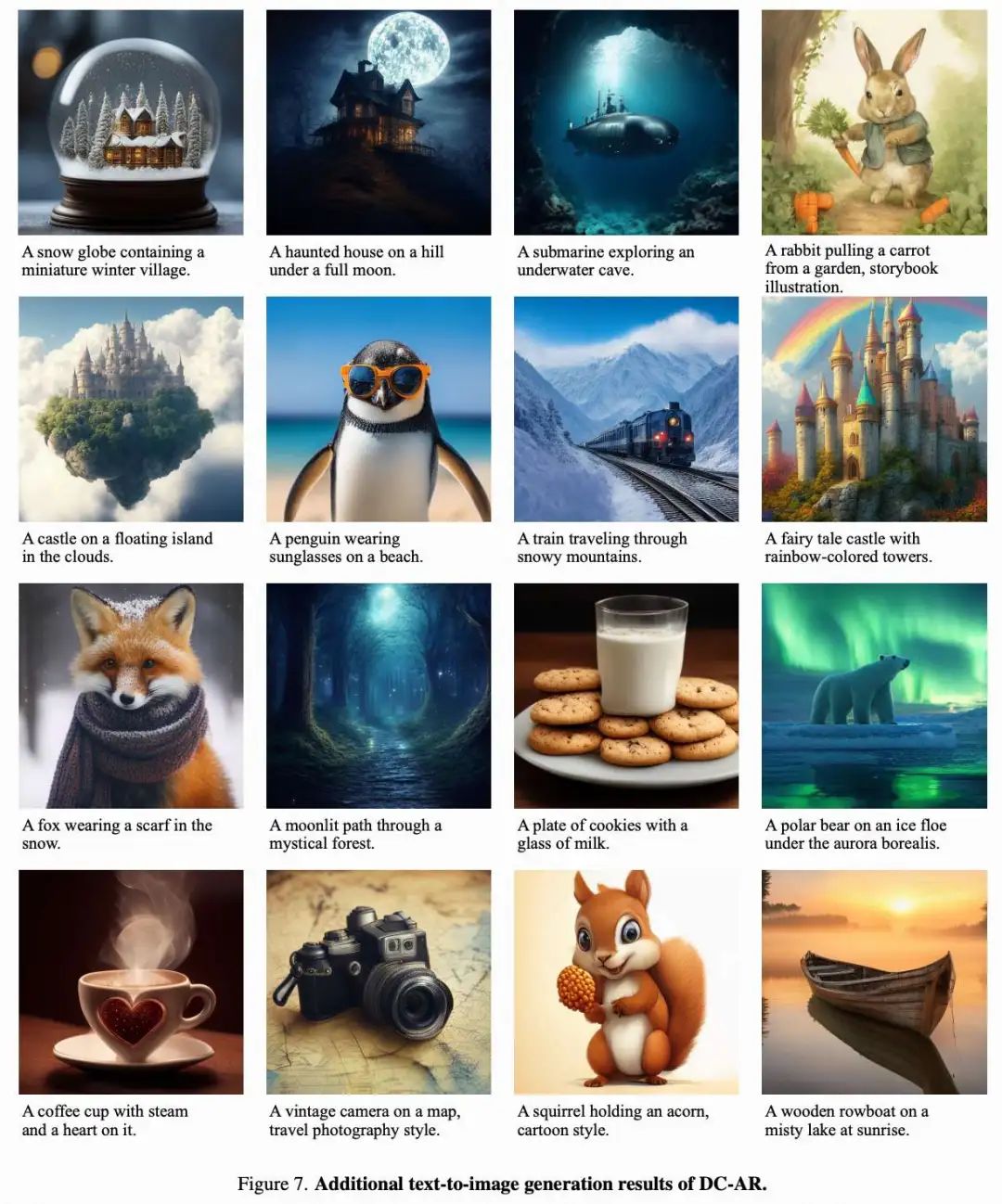

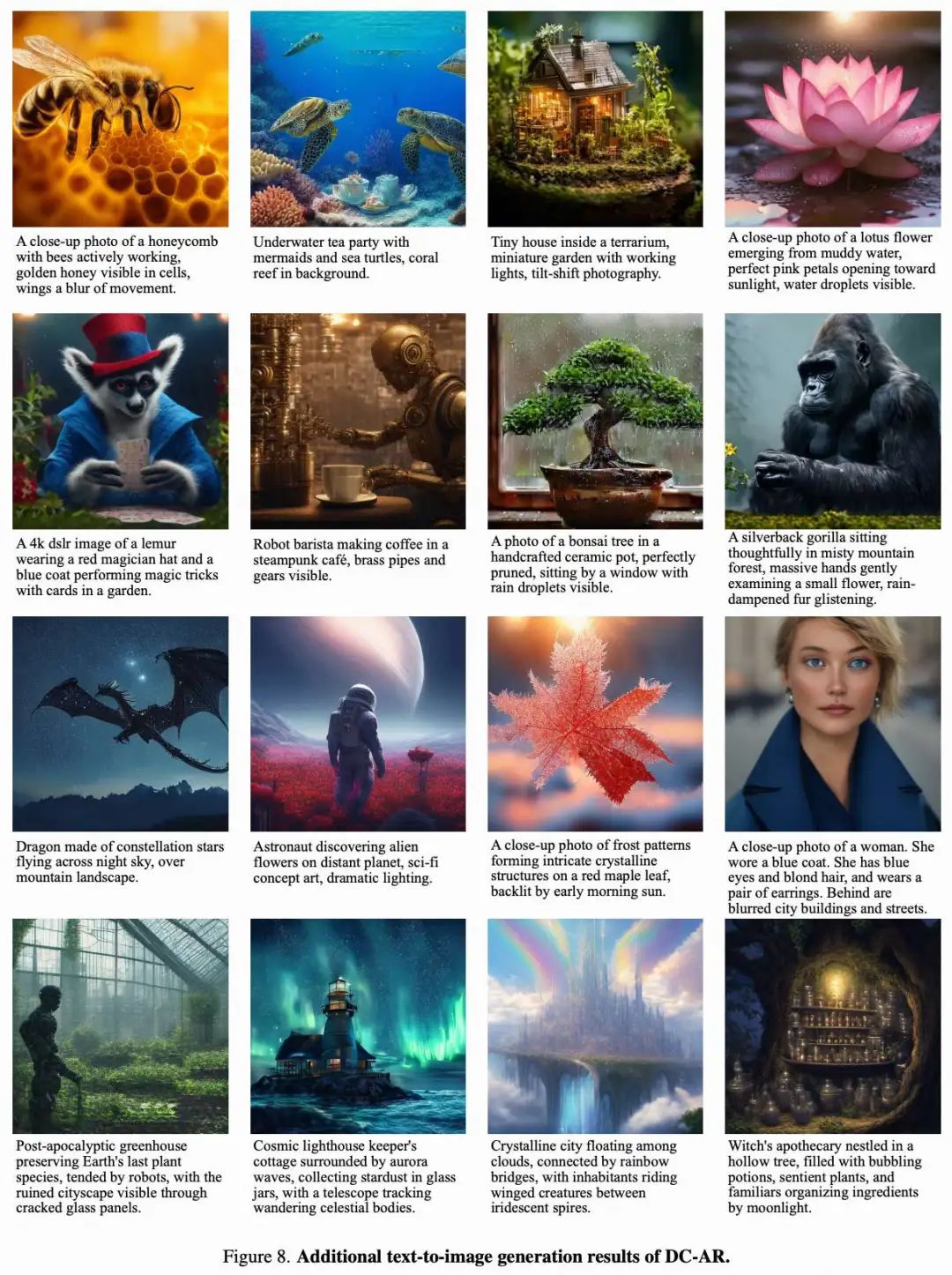

效果展示

总结速览

解决的问题

-

现有masked 自回归(Masked AR)文本生成图像模型在图像质量和生成效率方面普遍落后于扩散模型(Diffusion Models),主要原因在于 tokenizer 的表达能力和压缩效率不足,导致生成过程耗时且效果有限。

提出的方案

-

提出了一种新颖的文本生成图像框架 DC-AR,并引入了核心组件 DC-HT(Deep Compression Hybrid Tokenizer)以解决上述问题。 -

在 DC-HT 的基础上扩展了 MaskGIT,构建了一个 混合 masked 自回归生成框架:先通过离散 token 生成图像结构,再通过残差 token 精细化图像细节。

应用的技术

-

DC-HT:一种高效的混合 tokenizer,具备 32 倍空间压缩率,同时保持高保真度和跨分辨率泛化能力。 -

三阶段适应策略:提升 DC-HT 的重建质量。 -

结构-细节分离生成机制:通过离散 token 与残差 token 分阶段生成图像,提高生成效率和质量。 -

基于 MaskGIT 的混合掩码自回归生成流程。

达到的效果

-

图像生成质量:在 MJHQ-30K 数据集上取得 5.49 的 gFID,在 GenEval 上获得 0.69 的综合评分,达到了SOTA。

-

生成效率:相较于主流扩散模型和自回归模型,DC-AR 实现:

-

1.5 至 7.9 倍的吞吐率提升 -

2.0 至 3.5 倍的延迟降低

方法

首先介绍 Deep Compression Hybrid Tokenizer(DC-HT),这是一种用于自回归生成的二维 tokenizer,能够实现的空间压缩率,并配合三阶段适应训练策略以保证良好的重建性能。接着,介绍基于 DC-HT 构建的高效掩码自回归文本生成图像框架 DC-AR。

Deep Compression Hybrid Tokenizer

尽管现有用于自回归建模的一维 tokenizer 可以实现较高的压缩率,但它们会丢失像素 patch 之间的二维空间对应关系,限制了其在不同分辨率间的泛化能力。为了解决这一问题,本文采用了二维离散 tokenizer 框架,包括一个基于 CNN 的编码器 、一个基于 CNN 的解码器 ,以及一个向量量化(VQ)量化器 。本文采用与 DC-AE 相同的模型架构,因为它在高压缩率的连续 token 化中提供了最先进的重建质量。此外,本文发现离散 token 化在 codebook 训练过程中非常敏感。在高空间压缩率下,直接训练二维离散深度压缩 tokenizer 会导致较差的重建质量。为缓解质量损失,本文提出使用混合 token 化和三阶段适应策略进行增强。

混合 Token 化 给定输入图像 ,重建过程可以通过离散路径或连续路径进行。

-

在离散路径中,输入图像 首先被 CNN 编码器 Enc 压缩为连续 token 的隐空间表示 ,随后通过 VQ 过程得到离散 token: 。离散 token 被传入 CNN 解码器 Dec 重建图像: 。通过计算 与 之间的重建损失和 GAN 损失来训练 tokenizer。 -

在连续路径中,跳过量化步骤,直接将连续隐变量 输入解码器得到重建图像: 。

根据 HART,一个成功的混合 tokenizer 的关键属性是能够有效解码连续 token 和离散 token 。这确保从解码器角度看,两种 token 类型保持足够相似,从而便于建模其残差 token,定义为 ,在生成过程中使用。

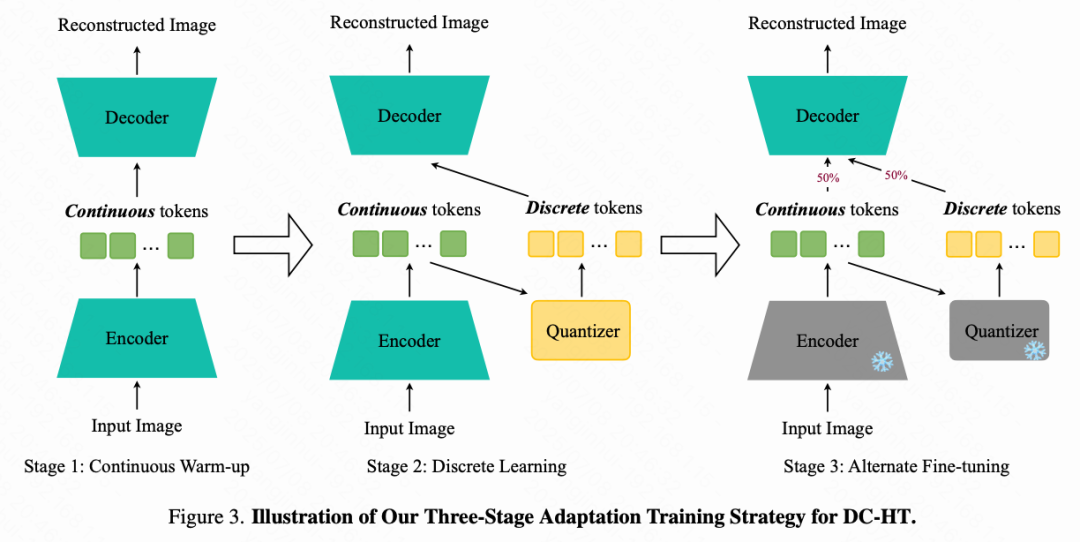

三阶段适应训练策略 仅使用混合 token 化无法完全解决重建质量下降的问题,因为离散和连续隐空间之间存在内在冲突。本文发现直接应用 HART 中的交替训练策略会导致不理想的重建效果。

本文提出三阶段适应训练策略来应对这一挑战。详细的训练流程如下图 3 所示。

-

第一阶段:连续预热阶段(continuous warm-up),仅激活连续路径。该阶段较短,旨在初始化编码器,使其适用于重建任务。 -

第二阶段:离散学习阶段(discrete learning),仅激活离散路径。目标是训练 tokenizer 学习稳定的隐空间,并能够有效重建图像。 -

第三阶段:交替微调阶段(alternate fine-tuning),对每张图像以 的概率随机选择连续路径或离散路径进行训练。在此阶段,编码器和量化器被冻结,仅微调解码器。该阶段确保解码器能够同时处理连续和离散 token。

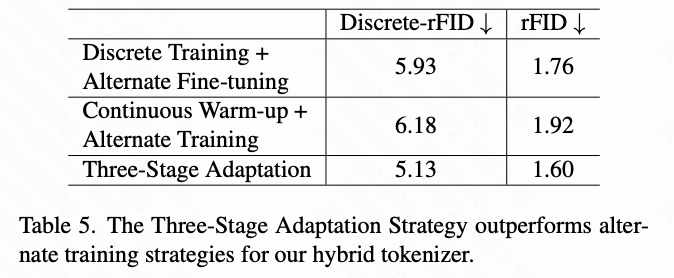

通过将训练过程划分为这三个阶段,本文的策略有效解决了上述问题,使得 rFID 从 1.92 提升至 1.60 ,离散路径的 rFID(discrete-rFID)从 6.18 提升至 5.13。

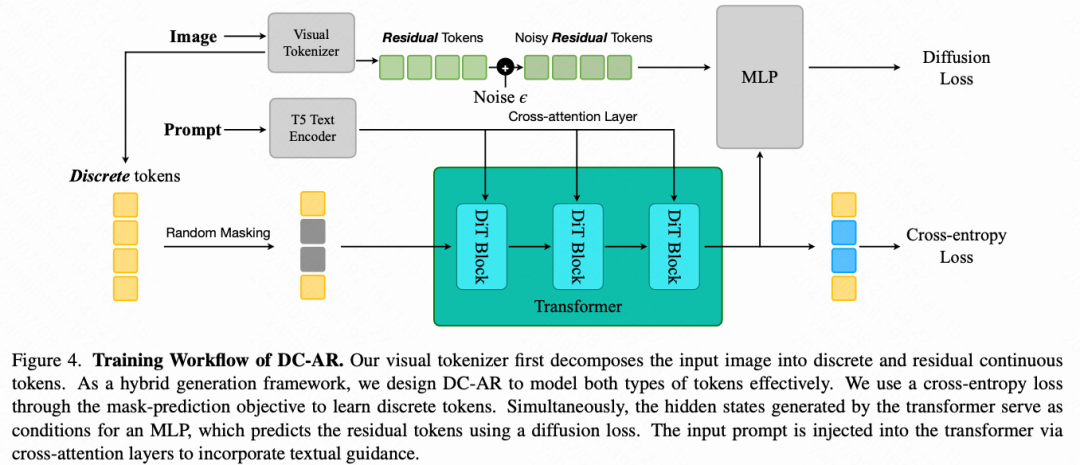

Hybrid Masked Autoregressive Model

为了充分利用 DC-HT 的能力,本文构建了 DC-AR,一个 masked 自回归框架,旨在高效地在文本引导下生成高分辨率图像。下图 4 展示了本文的总体框架。

一个文本模型从输入提示中提取文本嵌入,并通过 cross-attention 融入 transformer 模块中以提供文本引导。在训练过程中,本文随机掩盖一部分离散 token,并训练 transformer 模型使用交叉熵损失预测这些被掩盖的 token。同时,transformer 模型产生的隐藏状态作为条件输入,用于通过一个轻量级扩散 MLP 头预测残差 token,并使用扩散损失进行优化。

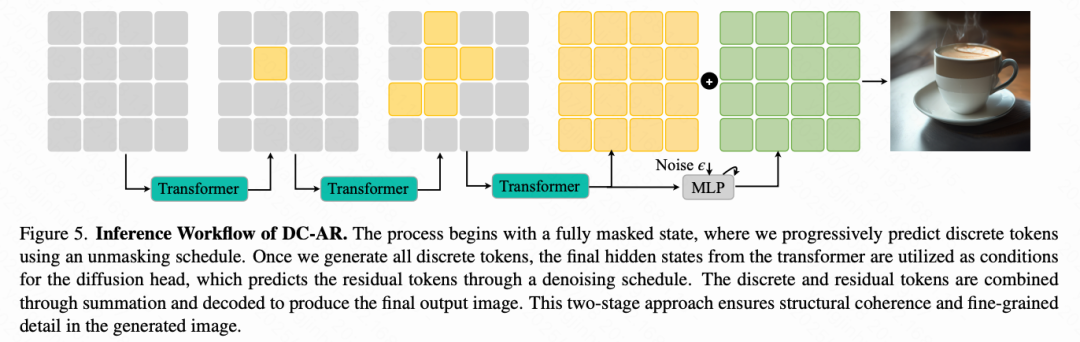

下图 5 展示了本文的推理流程。所有离散 token 通过逐步解掩的方式迭代预测,初始状态为完全掩盖。当所有离散 token 被生成后,transformer 的最终隐藏状态被用作扩散头的条件输入,通过降噪过程预测残差 token。然后本文将预测的离散 token 和残差 token 相加,得到最终的连续 token,并使用解码器生成图像。

本文混合生成框架中的一个关键设计选择是:transformer 模型的前向过程仅使用离散 token。该设计基于这样一个原则:残差 token 仅用于细节优化,而不应改变生成图像的整体结构。

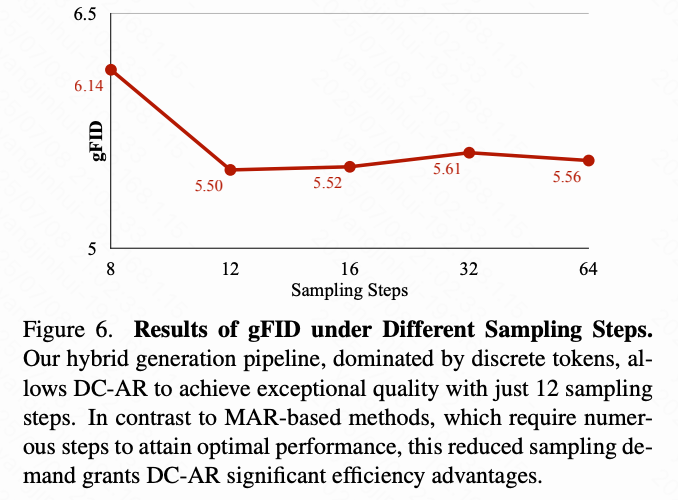

这一设计至关重要,因为已有实验证据表明:基于离散 token 的 MaskGIT 通常只需 8 步即可达到接近最优的生成性能,而基于连续 token 的 MAR 模型则需要 64 步才能达到最优,这会显著提高推理成本。通过将 transformer 预测过程限定在离散 token 上,并将残差 token 用于细节修复,本文的框架既保持了 MaskGIT 等离散方法的高采样效率,又实现了更优的图像生成质量。

如前文所述,本文的二维空间 tokenizer 相比一维 tokenizer 的一个关键优势是其能够在不同分辨率间无缝泛化,生成的 token 位于相同的隐空间中。利用这一特性,本文采用两阶段训练策略来高效训练 图像生成模型:

-

首先,在较长的训练周期内,在 图像上预训练模型; -

然后,将预训练的 模型在 图像上进行微调,得出最终模型。

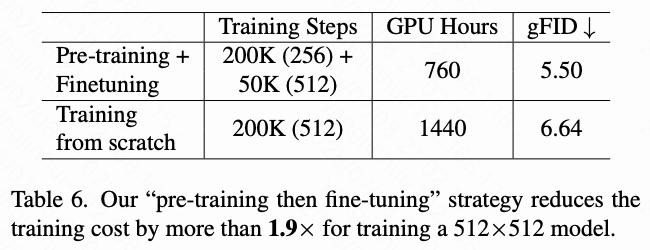

由于共享隐空间,该微调过程收玫迅速。如下文所示,该训练流程相比从零开始训练 模型, GPU 训练时间至少减少了 ,显著提升了训练效率。

实验

设置

模型。 对于 tokenizer,本文采用了 DC-AE-f32c32 架构,其空间压缩率为 ,潜通道数为 32 。本文将 codebook 设置为 。在生成器方面,本文使用 PixArt-a 架构作为 transformer 模型,并移除了其自适应归一化层。该模型由 28 层组成,宽度为 1152 ,总参数量为 634 M 。扩散头由 6 层 MLP组成,总参数量为 37 M 。为了在研究环境中保证计算效率和可访问性,本文采用 T5-base 作为文本编码器,其参数量为 109 M 。

评估与数据集。对于 tokenizer,本文使用 ImageNet 的训练集作为训练数据集,并将每张图像调整为 。为了评估 tokenizer 的重建性能,本文在 ImageNet 验证集上以 和 分辨率评估重建 FID(rFID)、峰值信噪比(PSNR)、结构相似性指数(SSIM)和感知图像 patch 相似度(LPIPS)。对于文本生成图像模型,本文使用 JourneyDB 和一个内部的 MidJourney 风格合成数据集,每个数据点由图像-文本对组成,文本由 VILA1.5-13B 生成。为了评估生成性能,本文在 MJHQ- 30 K 上报告生成 FID(gFID)以衡量图像美学质量,并使用 GenEval 分数评估输入提示与生成图像之间的对齐程度。

效率分析。 本文在 NVIDIA A100 GPU 上评估延迟和吞吐率。吞吐率在 batch size 为 16 时测量,延迟在 batch size 为 1 时测量。所有实验均使用 float16 精度。

主要结果

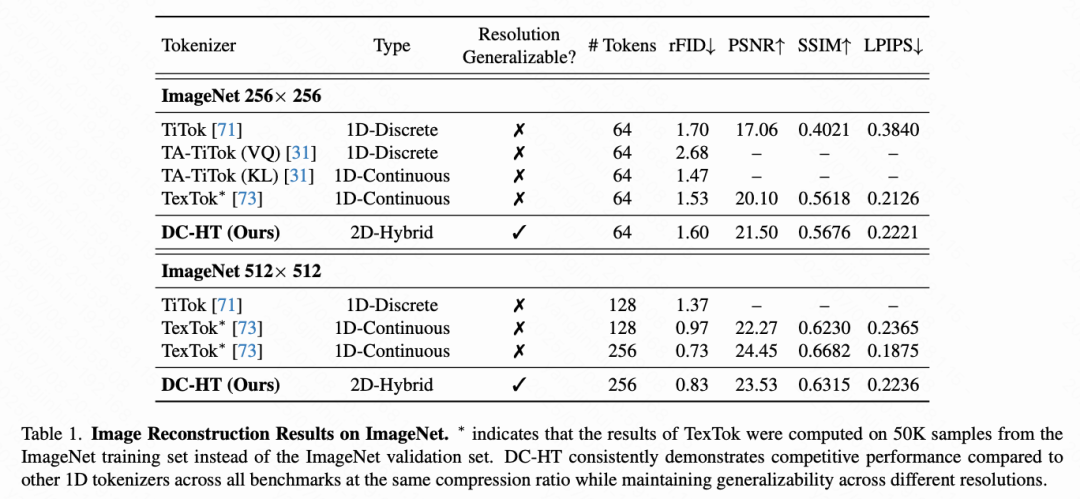

图像 token 化。 下表 1 中的定量结果表明,DC-HT 在保持高压缩率的同时,实现了与一维紧凑 tokenizer 相当的重建性能。值得注意的是,DC-HT 仅在 图像上训练,但在 分辨率下仍表现出色,而一维 tokenizer 模型则需要分别在 和 分辨率上单独训练。这一优势源于 DC-HT 保留了二维 tokenizer 所具有的分辨率泛化能力,而这一能力是一维 tokenizer 所不具备的。

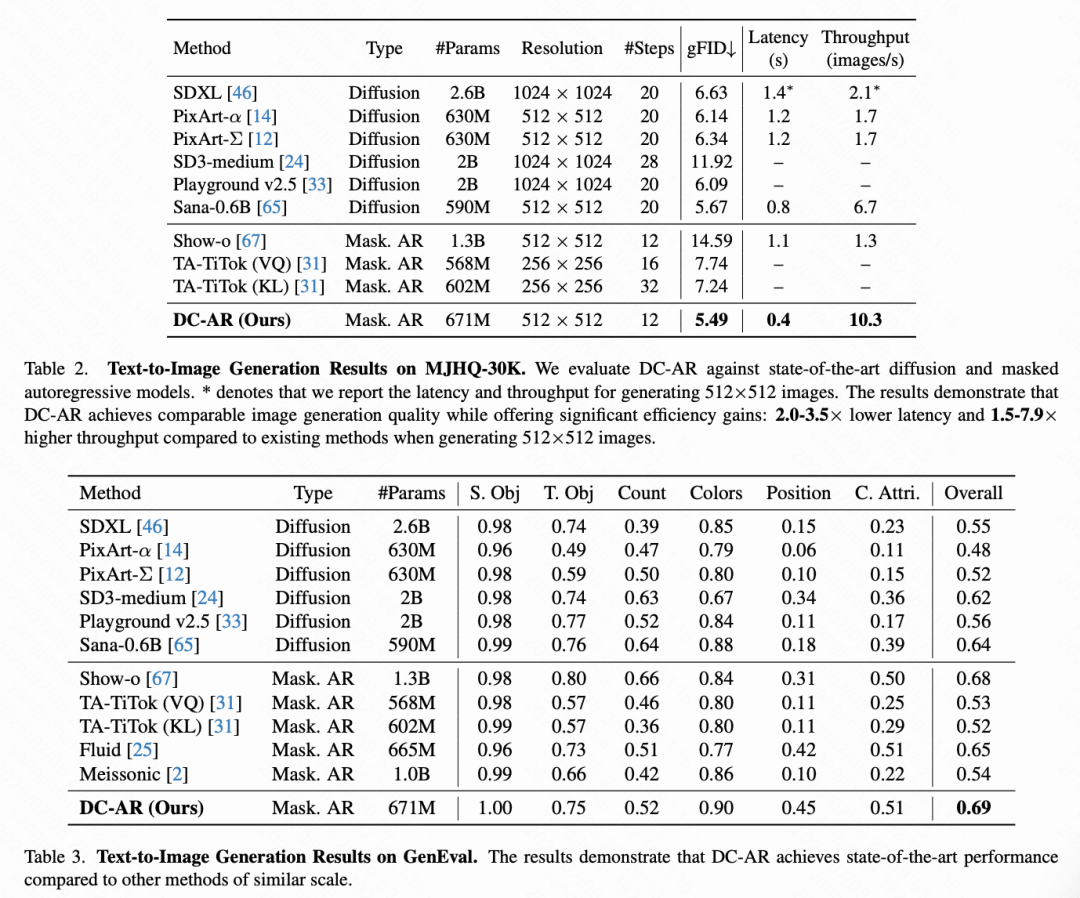

文本生成图像。 本文在下表 2 和下表 3 中展示了定量的文本生成图像结果。在 MJHQ-30K 基准测试中,DC-AR 相较于领先的扩散模型和其他掩码自回归模型,取得了最优的 gFID 分数 5.49 。值得注意的是,DC-AR 在推理成本显著降低的情况下实现了这一点,仅需 12 个采样步骤。对于 图像生成,DC-AR 的延迟分别比 Sana-0.6B 和 SD-XL 低 和 ,吞吐率分别比 Sana-0.6B 和 Show-o高 和 。在 GenEval 基准测试中,DC-AR 的整体得分为 0.69 ,与当前最先进的掩码自回归模型 Show-o 相当(差距在 0.01 以内),但模型规模小了 。此外,DC-AR 相较于其他同规模模型至少优出 0.04 。本文还在下图 2 中提供了与其他先进模型的生成结果的定性对比样本。这些定量和定性结果表明 DC-AR 是一个在效率和质量上兼具优势的先进文本生成图像框架。

消融实验与分析

本文通过以下方面评估 DC-AR 的关键设计选择:混合设计相较于仅离散 token 基线模型的有效性、三阶段适应策略在 tokenizer 训练中的优势、分辨率泛化 tokenizer 为生成器带来的训练效率提升,以及混合生成框架在采样步骤上的效率优势。

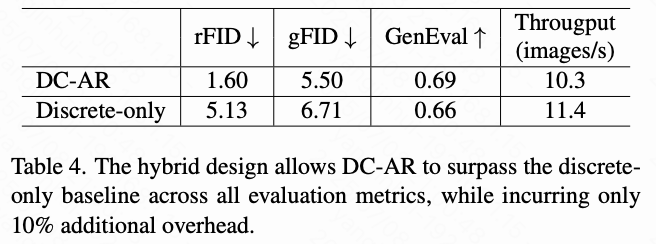

混合设计的有效性。 与仅依赖离散 token 的传统自回归方法相比,混合 token 化与生成设计增强了 DC-AR 的表示能力,从而提升了性能。为验证这一点,本文将 DC-AR 与一个仅使用离散路径、无连续路径、无残差 token、无扩散头的离散基线模型进行对比。结果如下表 4 所示,DC-AR 在多个综合指标上均优于该基线模型,仅增加约10% 的计算开销,验证了混合设计的有效性。此外,下图 9 展示了混合设计如何通过捕捉细节提升生成质量的定性示例。

三阶段适应训练策略。 本文评估了在压缩率为的条件下,使用三阶段适应策略训练混合 tokenizer 的效果,并与两种替代方法进行了比较,如下表 5 所示。第一种替代策略省略了连续预热阶段,这会增加学习离散隐空间的难度,导致最终 tokenizer 的离散-rFID 和连续-rFID 性能较差。第二种替代策略在连续预热之后直接进入交替训练阶段,该阶段类似于交替微调阶段,但所有组件都是可训练的。由于隐空间是可训练的,这种方法会因离散与连续隐空间之间的冲突而降低离散-rFID 和连续-rFID 的性能。本文的三阶段策略有效地解决了这些问题,确保性能的平衡与优化。

训练效率优势。 如前文所述,本文的分辨率泛化 tokenizer 支持在 模型中采用有效的"预训练-微调"策略。该策略先在 分辨率下进行预训练,然后在目标 分辨率下进行微调。相比之下,使用单一分辨率 tokenizer 的模型只能在目标分辨率下从头训练。下表 6 的定量结果表明,与从头训练相比,本文的策略在保持优越生成质量(以 gFID 评分衡量)的同时,训练成本降低了超过 。

推理效率优势。 下图 6 展示了 DC-AR 在不同采样步数下的 gFID 结果。本文的离散 token 主导的生成流程使得 DC-AR 在仅使用 12 个采样步骤的情况下即可达到最优图像质量。相比之下,基于 MAR 的模型需要大量步骤才能达到最优性能。采样步骤需求的降低使得 DC-AR 在不牺牲生成质量的同时获得了显著的效率优势。

结论

DC-AR,一种新颖且高效的 masked 自回归文本生成图像框架。尽管现代扩散模型可以利用高压缩率的 tokenizer,自回归模型在采用相同方法时面临显著挑战。为了解决这一问题,本文引入了 DC-HT,这是一种二维混合 tokenizer,能在实现 空间压缩率的同时保持卓越的重建保真度。在 DC-HT 的基础上,DC-AR 成为一种能够有效生成离散与残差 token 的掩码自回归生成框架。DC-AR 首先通过离散 token 预测结构元素,然后利用残差 token 精细化细节,仅需 12 步即可生成高质量图像。该方法相比最先进的扩散与掩码自回归模型,在吞吐率上提升 至 ,延迟降低 至 。

参考文献

[1] DC-AR: Efficient Masked Autoregressive Image Generation with Deep Compression Hybrid Tokenizer

(文:极市干货)